【ICML2020】持续图神经网络,Continuous Graph Neural Networks

摘要

介绍

-

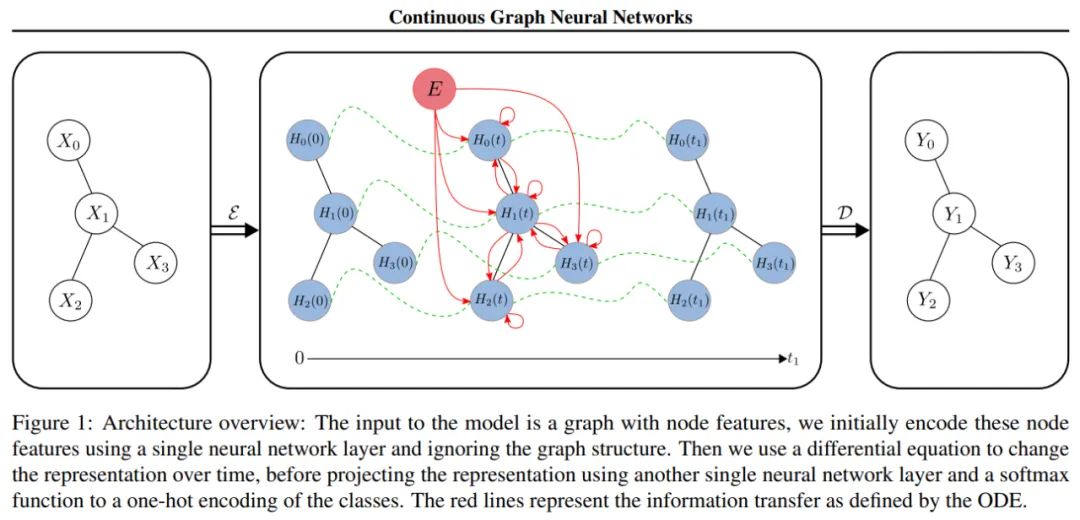

基于PageRank和扩散方法,提出了两个连续递增模型容量的ODEs; -

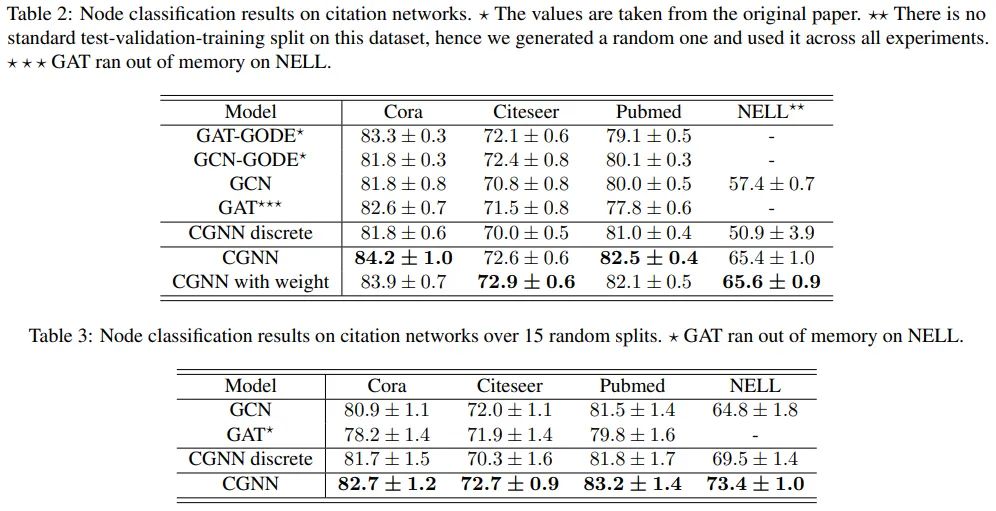

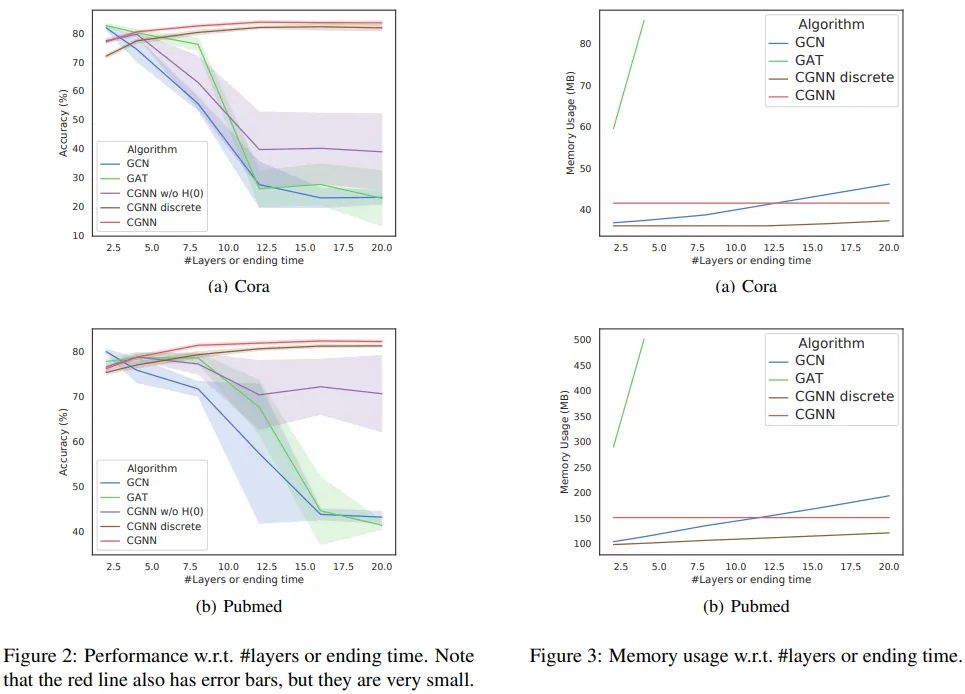

我们从理论上分析了我们的层学习的表示,并表明当t → ∞我们的方法接近一个稳定的不动点,它捕获图结构和原始的节点特征。因为我们在t→∞时是稳定的,我们的网络可以有无限多个“层”,并且能够学习远程依赖关系; -

我们证明了我们的模型的记忆是高效的,并且对t的选择是具有鲁棒性的。除此之外,我们进一步证明了在节点分类任务上,我们的模型能够比许多现有的最先进的方法表现更好。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CGCN2020” 可以获取《【ICML2020】持续图神经网络,Continuous Graph Neural Networks》专知下载链接索引

登录查看更多

相关内容

专知会员服务

44+阅读 · 2020年6月29日