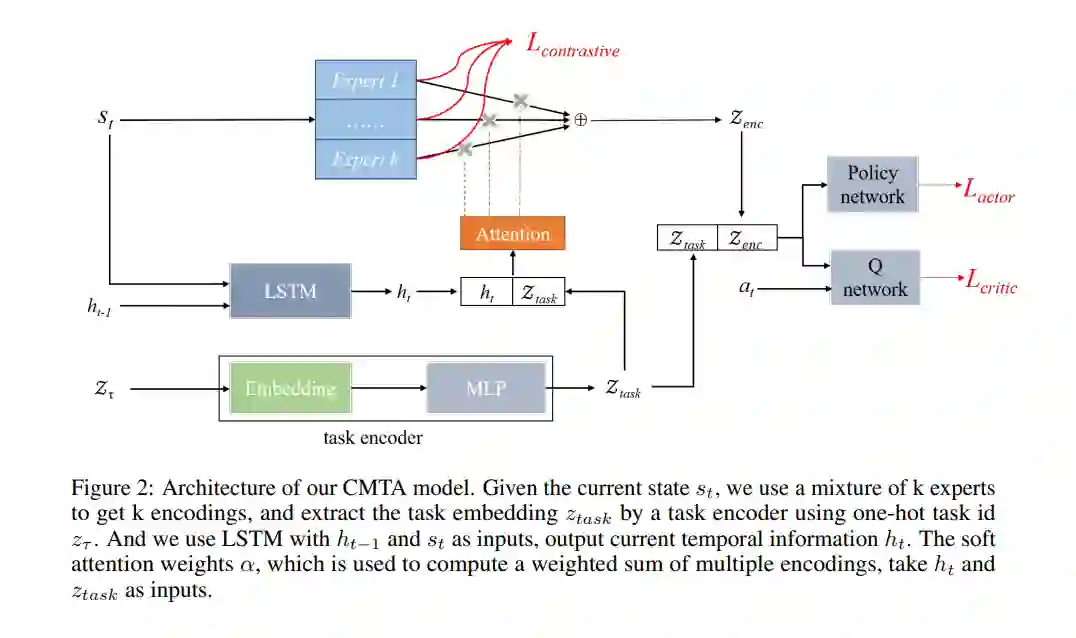

在多任务强化学习领域,模块化原则已被广泛采纳,该原则涉及将功能专业化到不同的模块中,并适当地组合它们,作为预防由于任务间冲突导致的性能降低的有希望的方法。但是,现有的多任务RL方法大多只在任务层面组合共享模块,忽略了任务内部可能存在的冲突。此外,这些方法没有考虑到,如果没有约束,某些模块可能会学到相似的功能,从而限制了模块化方法的表达能力和泛化能力。在这篇论文中,我们提出了具有时间注意力的对比模块(CMTA)方法来解决这些限制。CMTA通过对比学习使模块之间保持差异,并使用时间注意力在比任务层面更细的粒度上组合共享模块,从而减轻了任务内的负面转移,并提高了多任务RL的泛化能力和性能。我们在Meta-World上进行了实验,这是一个包含各种机器人操纵任务的多任务RL基准。实验结果显示,CMTA首次超越了单独学习每个任务,并在基线上取得了大幅的性能提升。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日