安全性一直是计算机系统从硬件到软件再到网络的核心。通过近期的进步,机器学习和人工智能已在这一软件堆栈中找到了它们必不可少的空间。这个闪亮的新成员将计算机程序的边界推向了人类难以想象的地方,从多媒体编辑到智能个人助理。不幸的是,它也成为了这一堆栈中最薄弱的安全环节。对于这些ML系统,特别是深度学习系统,最令人警觉的问题之一是缺乏鲁棒性,这一现象被称为对抗性样本。这篇博士论文提出了对深度学习系统对抗性鲁棒性的深入研究,目标是构建对这些攻击的实用防御。它由三个主要部分组成。第一部分专注于通过高质量数据和监督改进最先进的防御方法,对抗性训练。我们展示了在训练中进行细粒度监督可以提高神经网络在对象分类任务上的鲁棒性。在第二部分,我们从更广泛和更实用的防御视角出发。我们认为,仅仅在模型级别上构建更具对抗性鲁棒性的模型是必要的,但不足以在实践中实现安全系统。相反,我们提出了一种新的模型级防御方法,当与现有的系统级防御结合时,可以提供对一种重要且现实的攻击类型的实用解决方案。虽然我们的方法不能完全阻止所有对抗性攻击,但它表明,构建一个“合理”安全的ML系统可能比社区普遍认为的更接近。在这篇论文的最后部分,我们展示了一种针对实际大型语言模型API的新型实用攻击算法,这种算法成本低且不需要人工干预。识别漏洞是解决它们的第一步。我们希望这篇论文中开发的见解能为研究社区提供新的视角,并在构建针对对抗性样本的安全系统中发挥重要作用。

https://www2.eecs.berkeley.edu/Pubs/TechRpts/2024/EECS-2024-10.html

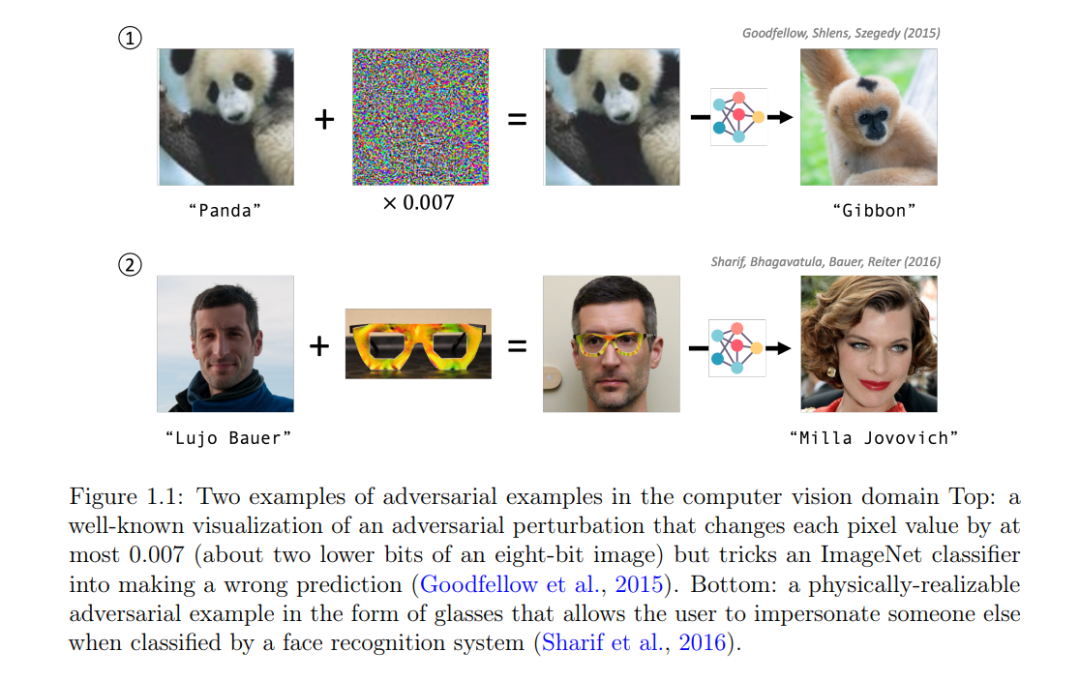

充满新的可能性和承诺,人工智能(AI)和机器学习(ML)系统无疑是过去十年开发的最令人兴奋的技术之一。它们以某种形式成为我们日常生活中不可或缺的一部分。它们存在于我们的手机、家庭、汽车以及大多数企业系统中;它们替代了传统系统的部分内容,同时开启了曾经超出我们想象的新自动化。ML和AI系统的广泛使用由于它们的能力而得到了充分的理由,但它们并非没有缺陷。 特别是,人们知道ML模型缺乏鲁棒性。这些模型的输入的微小变化甚至可以在对人类来说不可察觉或无意义时,极大地影响它们的输出。过去十年随着ML变得更加普遍并整合到更大的系统中,对其鲁棒性的要求也变得更加明显。研究社区一直试图理解并提高深度神经网络在各个领域的鲁棒性。本篇论文聚焦于一种特定的鲁棒性方面,即针对敌手的所谓的对抗性鲁棒性(Biggio et al., 2013; Szegedy et al., 2014; Goodfellow et al., 2015)。 具体来说,科学家们专注于对抗性样本的现象,这些输入几乎与自然输入“无法区分”,但是由敌手精心设计,以导致模型出错或做出任何随意的预测(见图1.1)。这种安全威胁的存在意味着任何集成ML的系统都面临着被恶意用户操纵并造成财产和生命损失的风险(例如,自动驾驶车辆/机器、网络威胁检测、生物识别认证、个人AI助手)。这种脆弱性也对它们对未见或罕见输入的泛化能力以及ML系统的可靠性提出了质疑。这种担忧,或许出于充分的理由,阻碍了ML系统在某些领域如医疗保健和金融的采用,其中失败的成本很高。然而,对于视觉识别或AI助手等其他集成ML的应用,进展显示没有放缓的迹象。这种快速采用需要在对抗性鲁棒性研究领域更快的进步,以保持这些系统的安全和可靠。 为提高ML模型的鲁棒性,已经做出了无数努力。其中最值得注意的是对抗性训练算法的发展(Goodfellow et al., 2015; Madry et al., 2018),它已成为训练鲁棒模型的事实标准。多年来,社区已经精炼了这项技术,并将基准数字推得远远超出了十年前的起点。然而,对抗性样本的问题远未解决。这种防御在工业界很少部署,原因有二:(1)鲁棒模型往往不如它们的非鲁棒对应物准确,(2)对抗性训练在计算上昂贵。这两个原因密切相关;扩大模型大小和训练数据可以同时提高准确性和鲁棒性,但被计算成本所阻碍。不良的规模法则使得对抗性训练成为许多实际应用的不切实际解决方案(Debenedetti et al., 2023; Peng et al., 2023; Wang et al., 2024)。特别是,将训练FLOPs从10^5增加到10^7只能将鲁棒性提高2.6个百分点(Debenedetti et al., 2023)! 过去十年的证据表明,提到的局限性是固有的,可能永远无法克服。受到这些挑战的激励,本论文探索了缓解对抗性样本问题的不同视角,并为解决方案添加了更实际的触感。本论文分为三个主要部分。前两章提供了针对对抗性样本防御的新视角,而最后一章探讨了针对大型语言模型应用的新实际威胁。现在我们将提供一个简要概述,并突出每部分的一个关键信息。 1. 更高质量的监督能提高对抗性鲁棒性吗? 首先,第二章专注于一种改善对抗性训练性能的新方法。我们相信,以相同的计算量,更有效的监督模型将达到更好的性能。我们寻求通过对象部分监督在计算机视觉领域回答上述问题。作为概念验证,我们介绍了一个基于部分的模型,除了主要的分类任务外,还训练了一个部分级别的语义分割的辅助任务。我们的初步结果显示,我们的基于部分的模型对对抗性样本更鲁棒,对常见腐败更鲁棒,受“伪特征”的影响更小。随着大型基础模型的帮助,高质量标签更容易获得(Bommasani et al., 2021),这种方法将在未来变得更加实用。

我们主张在未来的对抗性鲁棒性研究中同时发展“模型级”防御和“系统级”防御。 虽然我们刚提出的技术很有希望,但它本身不足以保障ML系统的安全。我们认为,对大多数ML应用来说,针对特定现实世界威胁的防御是既必要又足够的,而不是仅仅专注于不现实的白盒攻击。换句话说,应该在特定应用背景和明确的威胁模型下研究对抗性防御。模型级防御指的是让模型对给定攻击集更鲁棒的训练过程(例如,对抗性训练)。另一方面,系统级防御指的是保护实际场景中ML集成服务的系统设计。我们相信,这两者都是走向更安全ML系统的必要步骤,通过模型级和系统级防御的联合共设计,我们可以达到最佳结果。遵循这一原则,第三章提出了一种新的现实威胁模型,公共模型的转移攻击,以及将模型级防御与现有系统级防御相结合的实际防御。我们提供了证据,表明在这种设置下,几乎可以实现完美的鲁棒性,而准确性的损失可以忽略不计。

为了量化针对LLM服务的威胁,我们提出了针对真实世界API的第一个黑盒基于查询的攻击。 在最后一章(第四章)中,我们转向针对大型语言模型(LLM)的新兴实际威胁。与计算机视觉领域相比,自然语言处理领域,特别是新兴的LLM范式,在对抗性鲁棒性方面相对较少探索。直到最近,社区开始意识到这一领域中对抗性样本的潜在威胁(Maus et al., 2023; Jones et al., 2023; Zou et al., 2023)。为了更好地在实践中理解这一威胁,我们提出了一种针对真实LLM API的基于查询的攻击。与大多数先前工作不同,我们的攻击不需要对目标LLM的白盒访问,并且可以以最小的成本实现超过80%的成功率。从对手的角度理解可能的情况是设计实际防御的必要步骤。

本论文旨在提供针对对抗性样本的实际防御的新视角,这些防御通常适用于任何领域。我们希望我们的洞察将激发与这些模型在现实世界中的部署更加一致的新研究方向,并帮助从业者设计更安全的ML系统。