本文总结了我们在 DARPA LwLL(少标签学习)项目中的研究和技术贡献,该项目旨在减少训练和调整机器学习模型所需的标签数据。基于迁移学习,我们的方法利用了从数据集、知识资源、模型和架构、现有任务和训练算法等各种来源获得的归纳偏差。它将上述方法整合到一个连贯的框架中,并与 LwLL 评估协议保持一致,以便在各种学习条件下,在有限的监督下进行学习。利用生成式人工智能的最新进展,这项工作研究了注入适当归纳偏差的新颖而有效的方法,以推动图像分类、物体检测、视频分类和机器翻译领域的技术发展。研究成果包括在顶级人工智能刊物上发表大量论文、组织研讨会以及培训博士后和博士生。该团队还在 LwLL 评估中表现出色,其对象检测系统入选 NGA 过渡任务。此外,从 LwLL 项目中获得的知识和技能还被应用到我们团队参与的 DARPA CCU 项目中,该项目中只有 20% 的数据是有标签的。

人类和许多动物都能通过少量实例学习新概念,从而快速适应新环境。然而,最先进的深度神经网络过去往往需要大量标注数据才能学习感兴趣的目标概念,这主要是由于这些模型的学习能力较强。不过,最近在生成式人工智能和指令跟随大型语言模型(LLMs)方面取得的进展为机器学习系统在标记数据稀缺的情况下快速学习和适应开辟了新的可能性。在本项目中,我们的方法是学习如何通过将知识从某些任务转移到其他任务(又称转移学习),从而在标签较少的情况下有效地学习和适应。

从标签较少的数据中学习的方法的一个必要条件是,它不应该专门针对为学习概念而制定的特定任务。粗略地说,一个任务包括一个数据集和一个学习特定概念的评估指标,例如 ImageNet 挑战赛。从较少的标签中学习的临时和启发式方法并不可取,因为它们无法在不同的数据和任务分布中始终如一地发挥良好作用。在本项目中,我们设计了有效的策略,通过利用泛化所需的归纳偏差来学习和/或适应新概念。在迁移学习的大框架下,利用不同的机制将这些归纳偏差 "迁移 "到感兴趣的目标任务中。我们研究了多种深度神经网络的泛化,包括图像分类、物体检测、视频分类和机器翻译等领域最先进的模型。

如前所述,我们通过注入归纳偏差实现了少标签学习(LwLL)的样本效率。本报告中使用的学习机 "归纳偏差 "概念值得澄清。"学习 "涉及从过去的经验中归纳出新情况的能力,这种新情况与过去的经验 "相关"。处理新情况所需的归纳飞跃似乎只有在选择一种情况概括而非另一种情况概括的某些偏差下才有可能实现"[1]。

在本报告中,我们对 "偏差 "的工作定义是:"指除与观察到的训练实例严格一致之外,选择一种概括[或假设]而非另一种概括的任何依据"[1]。我们使用的 "迁移学习 "是广义的、通用的,包括最近的一些进展,如 (i) 预训练--然后--再调整范式,以及 (ii) 使用指令跟随大型语言模型(LLM)的零/少镜头学习。前者包括通过使用具有不同分布的海量无标记自然出现的网络规模数据进行自我监督学习,从而提炼知识和归纳偏差。从根本上说,人们可能会问,这种归纳偏差的转移是如何发生的?我们提供了一种基于压缩论证的直觉[2]。在大型神经网络定义的函数空间中,使用基于梯度搜索的压缩算法对大量数据进行 "压缩",从而捕捉到规律性,然后在感兴趣的目标监督学习任务中加以利用,例如,通过自动制作的信息性和预测性特征。

后者依赖于 "调动 "大型神经网络在预训练阶段所学到的提炼知识和归纳偏差,使目标任务受益。实现 "指令跟随 "的方法是,让经过预训练的大型 LLM 接触各种指令集,使网络能够理解并跟随人类的新指令,从而获取网络中提炼出的大量知识。例如,这些指令可以是对如何生成分类任务标签的描述,类似于在策划标签数据集时给人类注释者的指令。这实际上将 LLM 变成了 "噪声注释器",或者换句话说,变成了 "零镜头 "方式的分类器。

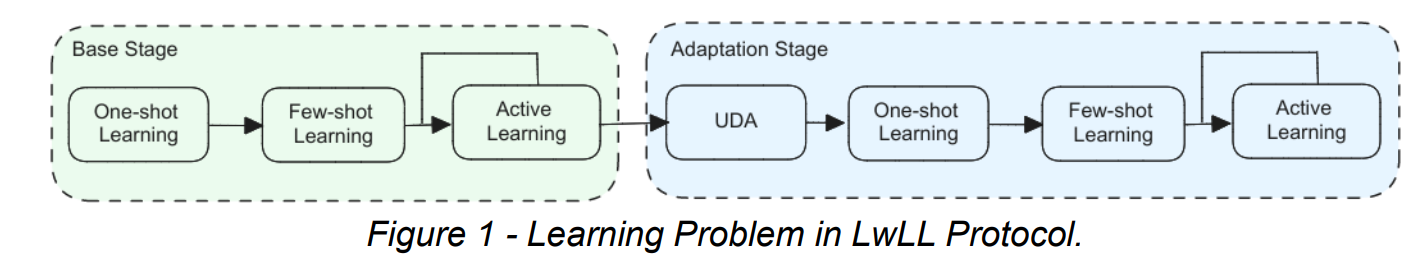

利用这些进展,在 DARPA LwLL 的整个工作过程中,我们研究并探索了在各种学习环境中进一步注入适当的归纳偏差,以推动图像分类、物体检测、视频分类和机器翻译领域的技术发展。我们的目标是针对通用智能体在部署阶段遇到的感兴趣的学习环境,"自动专业化 "通用预训练模型。这需要对各种挑战和学习条件进行整体处理,包括采用适当的骨干预训练架构(模型选择)、识别智能体的知识差距并从人类注释者那里查询适当的未标注数据点的标签(主动学习)、从已标注和未标注数据的组合中学习的算法(半监督学习),以及适应数据分布发生变化的新领域(领域适应)。我们要强调的是,在已发表的作品中,研究界通常只关注上述机器学习设置中的 "一种"。然而,自主智能体应该能够处理系统部署过程中出现的所有这些设置,而这正是我们的工作所要解决的核心问题,与 LwLL 计划的评估协议相一致。此外,我们在视觉和语言问题上始终使用 Transformer 架构[3],对这些不同的模式进行了统一处理,实现了对各种想法的无缝探索。

本报告的组织结构如下。首先,我们介绍了 DARPA LwLL 计划的评估协议,并描述了我们应对使用较少标签学习所面临挑战的主要框架。随后是方法论部分,描述了我们的框架如何适应 LwLL 评估中考虑的四个问题:图像分类、物体检测、视频分类和机器翻译。然后,我们在 "结果与讨论 "部分报告了评估结果和发现。最后,我们总结了我们的贡献以及对未来少标签学习的思考,以此结束本报告。