机器学习已经被应用于越来越多影响我们日常生活的社交相关场景,从社交媒体和电子商务到自动驾驶汽车和刑事司法。因此,开发可信、可靠的机器学习方法至关重要,以避免对个人和社会产生负面影响。本文致力于理解和提升图机器学习的可信性,由于图数据的复杂关系结构,这提出了独特的挑战。

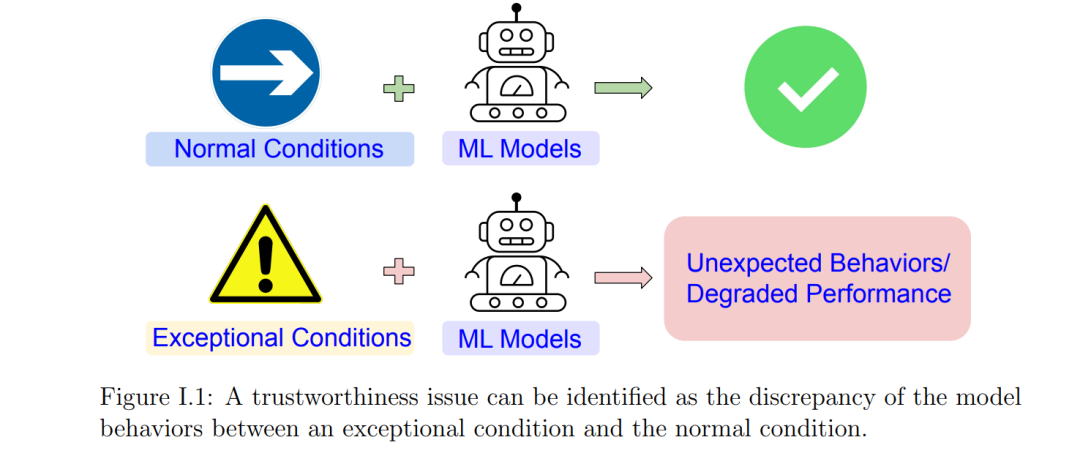

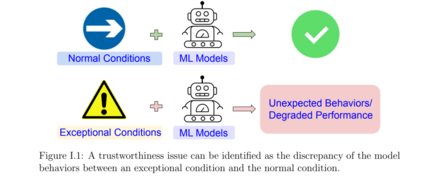

特别地,我们认为机器学习模型的可信性在异常情况下是可靠的。例如,机器学习模型在对抗攻击下或在子种群上的性能不应严重退化,分别对应对抗鲁棒性或公平性问题。值得信任的图机器学习的独特挑战是,在图数据的上下文中有许多更复杂的,有时是隐式的异常条件。本文识别了未充分挖掘的异常情况,理解了识别出的异常情况下的预期模型行为,并改进了现有模型在此类异常情况下的行为。

重点关注图神经网络(GNN),这是一类流行的图机器学习模型,利用了深度学习的最新进展。**本文确定了图神经网络的三种异常情况。**首先,受社交网络应用场景启发,通过一个新的实际威胁模型研究了GNN的对抗鲁棒性,并研究了GNN何时以及为什么会遭受对抗攻击。发现现有的GNN对许多现实世界的图数据可能会被错误指定,并开发了一个新的框架来改进现有的模型。发现了一种与节点结构位置相关的测试节点子种群之间的GNN预测的不公平性。本文还提出了一种主动学习框架来缓解不公平问题。

人工智能(AI),特别是机器学习(ML),已经作为一种通用技术融入人类社会1,有望在许多方面重塑我们的日常生活,从社交媒体和电子商务,到自动驾驶汽车和刑事司法。然而,尽管AI和ML带来了巨大的经验成功和商业价值,但要更广泛地部署这些技术,需要更好地理解ML模型对社会的影响。因此,可信的ML成为了一个越来越受欢迎的研究方向。Trustworthy ML是一个概括性的概念,包括关于ML可靠性和透明度的各种主题,如公平性、鲁棒性、可解释性等。

例如,机器学习模型可能在特定子种群上的系统表现较差,这导致了公平性问题。因此,对机器学习公平性的研究兴趣迅速增加。也有现实世界的ML应用程序证明了偏见和不公平:亚马逊的人工智能招聘工具被发现具有性别偏见[37];一种曾经广泛使用的犯罪预测工具,矫正罪犯管理分析替代制裁(COMPAS),被发现具有种族偏见[4]。另一个例子是,ML模型已被证明对添加到数据中的小的对抗性扰动很敏感,因此容易受到对抗性攻击[136]。例如,最先进的计算机视觉模型可能通过停车标志[45]上看似随机的涂鸦,将停车标志识别为限速标志。

由于相关主题的多样性和我们对可信机器学习的科学理解的文献历史,社区自然发展出了一套相对被广泛接受的可信性问题的概念类别,包括但不限于公平性、鲁棒性、安全性、隐私、可问责性、可解释性和因果性。虽然这种概念分类,像任何分类系统一样,有助于简化对该领域的理解,但有时也会产生误导。

首先,这种分类可以使可信机器学习的不同问题被视为孤立的主题。然而,这些不同的可信性问题可能相互冲突或相关。例如,在某些隐私和公平概念之间存在固有的冲突[32,24]。另一方面,公平性也可以与域外泛化相关[99]。此外,可解释的ML[41]和因果推理[113]可以成为一些公平性或鲁棒性问题的候选解决方案。一个扁平的概念类别分类方法无法捕捉不同主题之间丰富的相互关系。

其次,这种分类倾向于为每个主题寻找过度通用的解决方案,这可能不是解决可信机器学习问题的最佳方法。由于主题的概念性质,通常有各种直观合理的方法来将可信性概念(例如,公平性或鲁棒性)形式化为定量概念,而同时实现所有概念的可信性是不现实的。例如,Kleinberg等人[78]证明,通常不可能有一种算法同时满足三个常见的公平标准。因此,没有一个通用的解决方案是所有应用的万能药。此外,不同的可信性问题的重要性和恰当表述是高度特定于应用程序的。就可信性不同方面的重要性而言,例如,自动驾驶汽车可能会遭受对抗性攻击,因为它在野生[45]中接受数据输入;相比之下,对电子健康记录(EHR)数据进行对抗性攻击实际上要困难得多,因为这些数据由授权的医疗专家生成,并且在封闭的系统中循环。另一方面,EHR数据的隐私标准远高于驾驶数据。在可信性的正确制定方面,研究表明,制定的选择应该利用利益相关者在具体应用[28]中的感知。总的来说,应该将可信性作为位于特定类型的应用程序场景中的ML技术的属性来研究,而不是作为通用ML技术的属性。

许多现有的可信性概念可以按照这个程序重新制定。例如,机器学习模型的不公平性问题往往是由于它们在特定少数子种群上的性能下降,而与它们在多数子种群上的性能相比。机器学习的对抗漏洞是指与在干净数据上的性能相比,它们在对抗攻击下的性能下降。另一方面,其他一些可信性概念,如可解释性或因果关系,不能通过上述过程直接表述。在某种程度上,不公平或不鲁棒的模型将产生直接后果,而可解释性或因果关系可以被视为缓解问题的候选解决方案(例如,不公平或不鲁棒)。上述过程关注的是作为问题而不是解决方案的可信性概念。这个过程还强调应用场景的可信性问题。

为约束特定应用场景下的可信范围,本文对图机器学习(GML)的可信性进行了研究。现实世界的数据中存在大量的关系结构,通常以图的形式表示。例如,社交媒体上的用户或物联网系统中的传感器通过图结构进行连接。如果在预测任务中使用得当,这种关系图结构可以提供显著的预测能力。GML是一个流行的机器学习技术家族,它将图结构用于预测模型。近年来,GML在许多影响人们日常生活的应用中表现出了优异的性能。举个常见的例子,GML在Uber Eats[65]、亚马逊[162]和Pinterest[157]的工业推荐系统中发挥着重要作用;GML还被广泛用于在谷歌Map[38]中的ETA预测或房地产价格估计等任务中对地理数据进行建模[114]。此外,由于关系结构的普遍性,GML方法已经应用于或准备应用于高利害攸关的决策问题,如社会正义。例如犯罪预测和数据驱动的起诉[68,156],警察不当行为预测[22],假释决定的风险评估[132],公共安全监视[95],以及许多其他社会公正和安全问题[111]。

鉴于GML的众多社会相关应用场景,这类ML系统的可信性问题变得至关重要。此外,与传统的ML相比,由于GML复杂的关系结构,在理解和改进GML的可信性问题方面存在独特的挑战。特别是,在GML的上下文中,有许多更复杂,有时甚至是隐式的异常条件。以对抗性攻击为例,在传统的机器学习设置中,攻击者大多通过向输入特征添加对抗性扰动来进行攻击。对于GML,在实际应用中存在着更复杂的威胁:攻击者不仅可以扰动GML节点属性,还可以扰动图结构;攻击者还可以通过扰动邻居节点来间接影响节点的预测结果。在子种群之间的机器学习公平性方面,大多数传统文献研究的是有关某些敏感属性的子种群,如性别或种族。在图数据中,人们可以根据图结构来调查子群体,例如节点中心性[12,13]或社区结构[51,47]。社会科学理论认为,社会网络中人们的结构特征往往与其社会经济地位相关[53,16]。图数据中独特的对抗性威胁和基于结构的子群呈现出在传统ML文献中没有充分探索的例外情况,使可信的GML更具挑战性。

本文旨在解决这些对理解和提高GML可信性的独特挑战。具体而言,本文旨在回答以下3类研究问题,并在3种应用场景下展示研究方法。

- GML模型在实际应用场景中可能遇到的潜在异常情况是什么?2. 在确定的异常条件下,GML模型的预期行为是什么?3.在识别出的异常情况下,如何缓解GML模型的性能差异? 在GML方法中,我们关注图神经网络(GNN)[52,124,77],这是一个大的趋势GML模型家族,将深度学习[83]的最新进展利用到GML中,并在许多真实世界的应用程序中显示出卓越的性能。