图神经网络

·

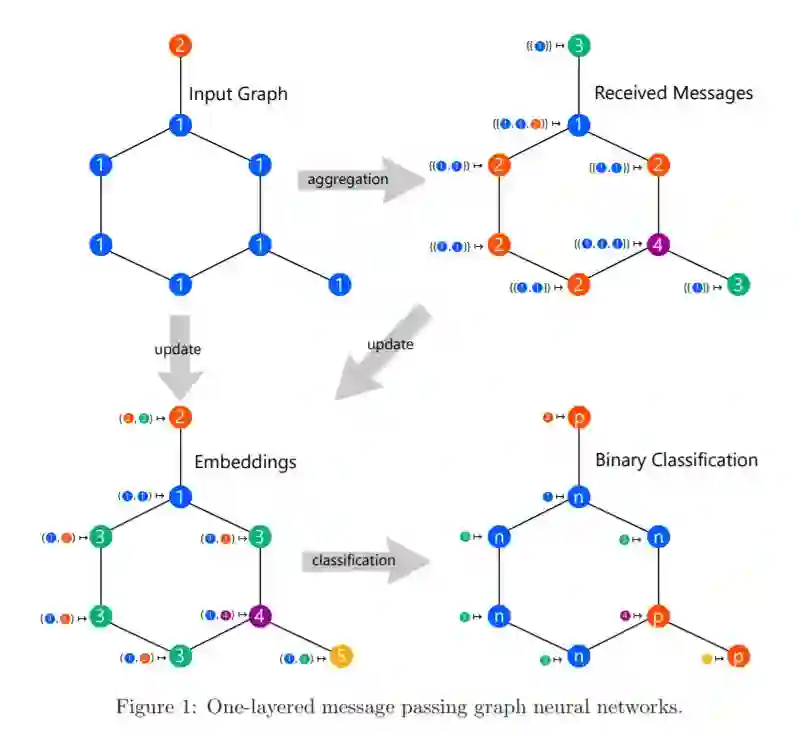

图神经网络是解决各种图学习问题的有效的机器学习模型。尽管它们取得了经验上的成功,但是GNNs的理论局限性最近已经被揭示出来。因此,人们提出了许多GNN模型来克服这些限制。在这次调查中,我们全面概述了GNNs的表达能力和可证明的强大的GNNs变体。

成为VIP会员查看完整内容

图神经网络是解决各种图学习问题的有效的机器学习模型。尽管它们取得了经验上的成功,但是GNNs的理论局限性最近已经被揭示出来。因此,人们提出了许多GNN模型来克服这些限制。在这次调查中,我们全面概述了GNNs的表达能力和可证明的强大的GNNs变体。