大型语言模型(LLMs)在自然语言处理方面展示了令人印象深刻的能力。然而,它们的内部机制仍然不清楚,这种不透明性对下游应用带来了不希望的风险。因此,理解和解释这些模型对于阐明它们的行为、局限性和社会影响至关重要。在本文中,我们引入了可解释性技术的分类体系,并提供了关于解释基于Transformer的语言模型方法的结构化概述。我们根据LLMs的训练范式对技术进行分类:传统的微调范式和基于提示的范式。对于每个范式,我们总结了生成个体预测的局部解释和总体模型知识的全局解释的目标和主要方法。我们还讨论了用于评估生成解释的度量标准,并讨论了如何利用解释来调试模型和提高性能。最后,我们比较了LLMs时代解释技术面临的关键挑战和新兴机会与传统机器学习模型。

大型语言模型(LLMs),如BERT(Devlin等,2019a)、GPT-3(Brown等,2020)、GPT-4(Bubeck等,2023)、LLaMA-2(Touvron等,2023b)和Claude(AnthropicAI,2023),在各种自然语言处理(NLP)任务中展示出了令人印象深刻的性能。主要科技公司,如微软、谷歌和百度,已在其商业产品和服务中部署了LLMs以增强功能。例如,微软利用GPT-3.5来改善新Bing的搜索相关性排名(Mehdi,2023)。由于LLMs通常是复杂的“黑盒子”系统,其内部工作机制是不透明的,高复杂性使模型解释变得更加具有挑战性。这种模型不透明性的缺乏有时会导致生成有害内容或幻觉的产生(Weidinger等,2021)。因此,开发解释能力以揭示这些强大模型的工作方式至关重要。

可解释性指的是以人类可理解的方式解释或呈现模型行为的能力(Doshi-Velez和Kim,2017;Du等,2019a)。提高LLMs的可解释性至关重要,有两个关键原因。首先,对于一般终端用户,可解释性通过以可理解的方式阐明模型预测背后的推理机制来建立适当的信任,无需技术专业知识。通过这种方式,终端用户能够理解LLMs的能力、局限性和潜在缺陷。其次,对于研究人员和开发人员,解释模型行为提供了洞察力,以识别意外偏见、风险和性能改进的领域。换句话说,可解释性充当了一个调试辅助工具,可以快速提高下游任务上的模型性能(Strobelt等,2018;Bastings等,2022;Yuksekgonul等,2023)。它有助于追踪模型能力随时间的变化,进行不同模型之间的比较,并开发可靠、道德和安全的模型,以供实际部署使用。 由于LLMs的独特属性,其可解释性技术与传统机器学习(ML)模型的技术有所不同。LLMs和传统ML模型之间的差异可以归因于多个方面。从数据的角度来看,ML模型以监督方式依赖人工构建的特征,而LLMs旨在自动从原始输入数据中学习特征(Chai和Li,2019)。解释LLMs捕捉了哪些特征以及这些特征中包含了什么知识是重要的。从模型的角度来看,传统ML模型通常是针对具体任务设计的,具有不同的模型架构(Liu和Sun,2023)。相比之下,经过广泛数据集的预训练的LLMs可以通过微调泛化到各种下游任务(Yang等,2023)。此外,LLMs的注意力机制已被广泛用于通过为输入的相关部分分配更高的值来确定输入的重要性(Hu,2020)。由于注意力权重中编码的知识和模式可能提示了模型的理解,注意力权重可以被认为是精细调校模型的另一个重要解释标准。此外,由于LLMs的性能更好,还应进一步研究transformer的组件,包括神经元、层和模块,学到了什么以及它们是否有不同的功能。从应用的角度来看,传统ML模型专注于低级模式识别任务,如解析和形态分析,而LLMs可以处理高级推理任务,如回答问题和常识推理(Lauriola等,2022)。特别是,理解LLMs在上下文学习和思维链提示以及幻觉现象方面的独特能力对于解释和改进模型至关重要。为了更好地理解和改进LLMs,有必要回顾和总结专为LLMs定制的解释技术。 在本文中,我们提供了一种解释基于Transformer的语言模型的方法的全面概述。在第2节中,我们介绍了应用LLMs的两个主要范式:1)传统的下游微调范式和2)提示范式。基于这一分类,我们在第3节中回顾了适用于微调LLMs的解释方法,并在第4节中回顾了适用于提示LLMs的解释方法。在第5节中,我们讨论了解释方法的评估。最后,在第6节中,我们进一步讨论了与传统机器学习模型相比解释LLMs所面临的研究挑战,并提供了有关潜在未来研究方向的见解。本文旨在全面整理关于解释复杂语言模型的最新研究进展。 LLMs的训练范式

LLMs的训练可以基本分为两个范式,传统微调和提示,根据它们如何用于适应下游任务。由于这两个范式之间存在重大区别,因此分别提出了各种类型的解释(如图1所示)。 传统微调范式

在这个范式中,首先对语言模型进行了大规模无标签文本数据的预训练,然后在特定下游领域的一组标记数据上进行微调,例如GLUE基准测试中的SST-2、MNLI和QQP(Wang等人,2019)。在微调过程中,很容易在语言模型的最终编码器层上方添加完全连接的层,使其适应各种下游任务(Rogers等人,2021)。这个范式已经在包含多达十亿参数的中型语言模型上取得了成功。例如,包括BERT(Devlin等人,2019a)、RoBERTa(Liu等人,2019)、ELECTRA(Clark等人,2020)、DeBERTa(He等人,2021)等。对于这个范式的解释重点在于两个关键领域:1)理解自监督预训练如何使模型获得语言的基础理解(例如句法、语义和上下文关系);以及2)分析微调过程如何赋予这些预训练模型有效解决下游任务的能力。

**提示范式 **

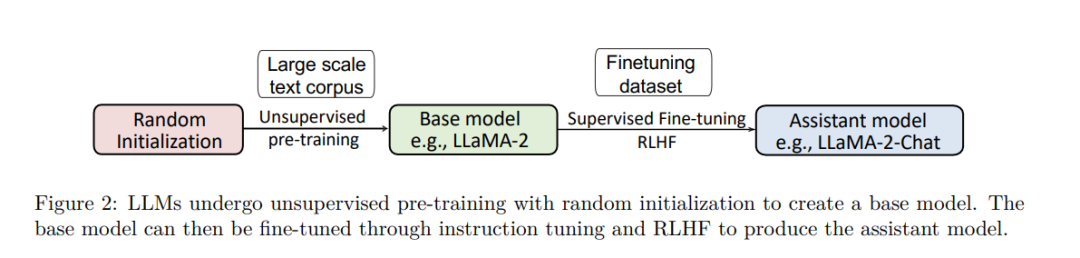

提示范式涉及使用提示,例如自然语言句子中的空白,以便模型填充,实现零样本学习或少样本学习,而无需额外的训练数据。根据其开发阶段,这个范式下的模型可以分为两种类型: 基础模型:随着LLMs的规模和训练数据的增加,它们展示了令人印象深刻的新能力,无需额外的训练数据。其中一种能力是通过提示实现少样本学习。这种类型的范式通常适用于大规模语言模型(拥有数十亿参数)(例如GPT-3(Brown等人,2020)、OPT(Zhang等人,2022b)、LLaMA-1(Touvron等人,2023a)、LLaMA-2(Touvron等人,2023b)、Falcon(Almazrouei等人,2023))。这些模型被称为基础模型或基础模型,它们可以与用户进行对话,无需进一步与人类喜好对齐。大规模模型通常适用于这种范式,规模超过10亿。例如,LLaMA-2(Touvron等人,2023b)拥有高达700亿个参数。基础模型的解释旨在理解模型如何学习在回应提示时利用其预训练知识。 助手模型:基础模型存在两个主要限制:1)它们不能按照用户的指令进行操作,因为预训练数据包含少量指令-响应示例,2)它们倾向于生成有偏见和有毒的内容(Carlini等人,2023)。为了解决这些限制,基础模型通过监督微调进一步进行微调(见图2),以实现人类级别的能力,例如开放域对话。关键思想是通过将模型的响应与人类反馈和喜好对齐来实现。这个过程最典型的方式是通过(提示,响应)演示对和来自人类反馈的强化学习(RLHF)进行指导调整。模型通过自然语言反馈进行训练,以进行复杂的多轮对话。属于这一类别的模型包括OpenAI的GPT-3.5和GPT4(Bubeck等人,2023)、Anthropic的Claude(AnthropicAI,2023)以及一些开源模型,如Meta的LLaMA-2-Chat(Touvron等人,2023b)、Alpaca(Taori等人,2023)和Vicuna(Chiang等人,2023)。这些模型也可以称为助手模型、聊天助手或对话模型。助手模型的解释重点在于理解模型如何从对话中学习开放式互动行为。

**传统微调范式的解释 **

在本节中,我们回顾了针对采用预训练和下游微调范式训练的LLMs的解释技术。首先,我们介绍了提供局部解释(第3.1节)和全局解释(第3.2节)的方法。在这里,局部解释旨在提供对语言模型如何对特定输入实例进行预测的理解,而全局解释旨在提供对LLM整体工作方式的广泛理解。接下来,我们讨论了如何利用解释来调试和改进模型(第3.3节)。

局部解释

解释的第一类别涉及解释LLMs生成的预测。让我们考虑这样一种情景,我们有一个语言模型,并将特定文本输入模型。模型随后产生分类输出,例如情感分类或下一个标记的预测。在这种情景下,解释的作用是阐明模型生成特定分类或标记预测的过程。由于目标是解释LLM如何为特定输入做出预测,我们将其称为局部解释。这个类别包括四个主要方法流,包括基于特征归因的解释、基于注意力的解释、基于示例的解释和自然语言解释。

**全局解释 **

不同于旨在解释模型的个体预测的局部解释,全局解释有助于从模型的角度理解LLMs的工作方式。全局解释旨在理解个体组件(神经元、隐藏层和较大模块)编码了什么,以及解释了个体组件所学习的知识/语言属性。我们考察了三种主要的全局解释方法:探测方法,用于分析模型表示和参数;神经元激活分析,用于确定模型对输入的响应性;以及基于概念的方法。

**提示范式的解释 **

在本节中,我们介绍了解释属于提示范式的模型的技术,包括1)解释基础模型,如LLaMA-2(第4.1节),2)解释助手模型,如LLaMA-2-Chat(第4.2节),以及3)如何利用LLMs的推理和解释能力生成用户友好的解释(第4.3节)。

基础模型解释

随着语言模型的规模增大,它们展示出了新的能力,如少样本学习,即仅从少量示例中学习概念的能力。它们还展示了一种思维链(CoT)提示能力。鉴于这些新兴属性,解释性研究有三个主要目标:1)研究提供解释是否实际有助于模型自身更快地从仅有少量示例中“理解”新任务,2)理解这些大型语言模型如何能够迅速从有限示例中掌握新任务,从而帮助终端用户解释模型的推理,以及3)解释思维链提示。

**助手模型解释 **

由于大规模无监督预训练和有监督对齐微调,属于这一范式的LLMs具有强大的推理能力。然而,它们的巨大规模也使它们容易生成问题输出,如幻觉。解释性研究旨在:1)阐明对齐微调的作用,2)分析幻觉产生的原因。

结论

在本文中,我们提供了对LLMs的可解释性技术的全面概述。我们总结了基于模型训练范式的局部和全局解释方法。我们还讨论了如何利用解释来改进模型、评估以及主要挑战。未来的重要发展选项包括开发针对不同LLMs的解释方法、评估解释的忠实性,以及提高人类可解释性。随着LLMs的不断进步,可解释性将变得极其重要,以确保这些模型具有透明性、公平性和益处。我们希望这份调查为这一新兴研究领域提供了有用的组织,同时突显了未来工作的开放性问题。