**本文回顾了在扩散模型在广泛的生成任务中流行的背景下的文本到图像的扩散模型。作为一项独立的工作,本综述首先简要介绍基本扩散模型如何用于图像合成,然后介绍条件或指导如何改善学习。**在此基础上,综述了文本条件图像合成(即文本到图像)的最新方法。本文进一步总结了文本到图像生成之外的应用:文本指导的创意生成和文本指导的图像编辑。除了迄今取得的进展,本文还讨论了现有的挑战和有希望的未来方向。

https://www.zhuanzhi.ai/paper/8a64d962c13c8857d5c06bcdc0c43c0a

1. 引言

一幅画胜过千言万语。正如一句老话所说,图像比纯文本更能讲述故事。当人们阅读文本故事时,他们可以通过想象在脑海中画出相关的图像,这有助于他们理解和享受更多。因此,设计一个从纹理描述生成视觉逼真图像的自动系统,即文本到图像任务,是一项非平凡任务,因此可以被视为类人或通用人工智能的一个重要里程碑[1],[2],[3],[4]。随着深度学习[5]的发展,文本到图像任务已经成为计算机视觉中最令人印象深刻的应用之一[6]、[7]、[8]、[9]、[10]、[11]、[12]、[13]、[14]、[15]、[16]、[17]、[18]。我们在图1中总结了文本到图像生成的代表性工作的时间轴。如图1所示,AlignDRAW[6]是一项从自然语言生成图像的开创性工作,但受到了不现实的结果的影响。文本条件GAN[7]是第一个从字符级到像素级的端到端差分架构。不同于基于GAN的方法[7]、[8]、[9]、[10]主要在小规模数据环境下进行,自回归方法[11]、[12]、[13]、[14]利用大规模数据进行文本到图像生成,代表性方法包括OpenAI的DALL-E[11]和谷歌的Parti[14]。然而,自回归特性使得这些方法[11],[12],[13],[14]存在较高的计算成本和序列误差累积。

最近,扩散模型(DM)出现了成为文本到图像生成中最先进的新模型的趋势[15],[16],[17],[18]。基于扩散的文本到图像合成也在社交媒体上引起了广泛关注。在过去的一年里,大量关于文本到图像扩散模型的工作已经出现,但更多的工作预计将在不久的将来出现。相关著作的数量使读者在没有全面调研的情况下,了解文本-图像扩散模型的最新发展越来越具有挑战性。然而,据我们所知,目前还没有关于基于扩散的文本到图像生成的最新进展的综述工作。相关综述的一个分支[19],[20],[21],[22]综述了扩散模型在所有领域的进展,使其局限于对测试到图像合成任务的有限覆盖。另一个综述流[21],[23],[24]专注于文本到图像任务,但仅限于基于GAN的方法,考虑到扩散模型取代GAN的最近趋势,这些方法有些过时。本文通过全面介绍基于扩散模型的文本到图像任务的最新进展,并对其未来方向进行了展望,填补了上述两个流之间的空白。 **该综述首先回顾了基于扩散模型的文本到图像任务的最新进展,因此处于扩散模型和文本到图像合成的交叉点。**因此,我们将本文的其余部分组织如下。第二节介绍了扩散模型的背景,包括对文本到图像合成很重要的指导方法。第三部分讨论了基于扩散模型的文本生成图像任务的开创性工作,包括GLIDE[15]、Imagen[16]、Stable diffusion[17]和DALL-E2[18]。第四部分从各个方面进一步论述了后续研究对第三部分开拓性工作的完善。通过总结最近的基准和分析,在第5节中从技术和道德角度进一步评估这些文本到图像的方法。除了文本到图像的生成外,还介绍了第六节中的相关任务,包括文本指导的创意生成(如文本到视频)和文本指导的图像编辑。回顾了文本到图像生成之外的各种应用,并讨论了挑战和未来的机会。 2. 开创性的文本到图像扩散模型

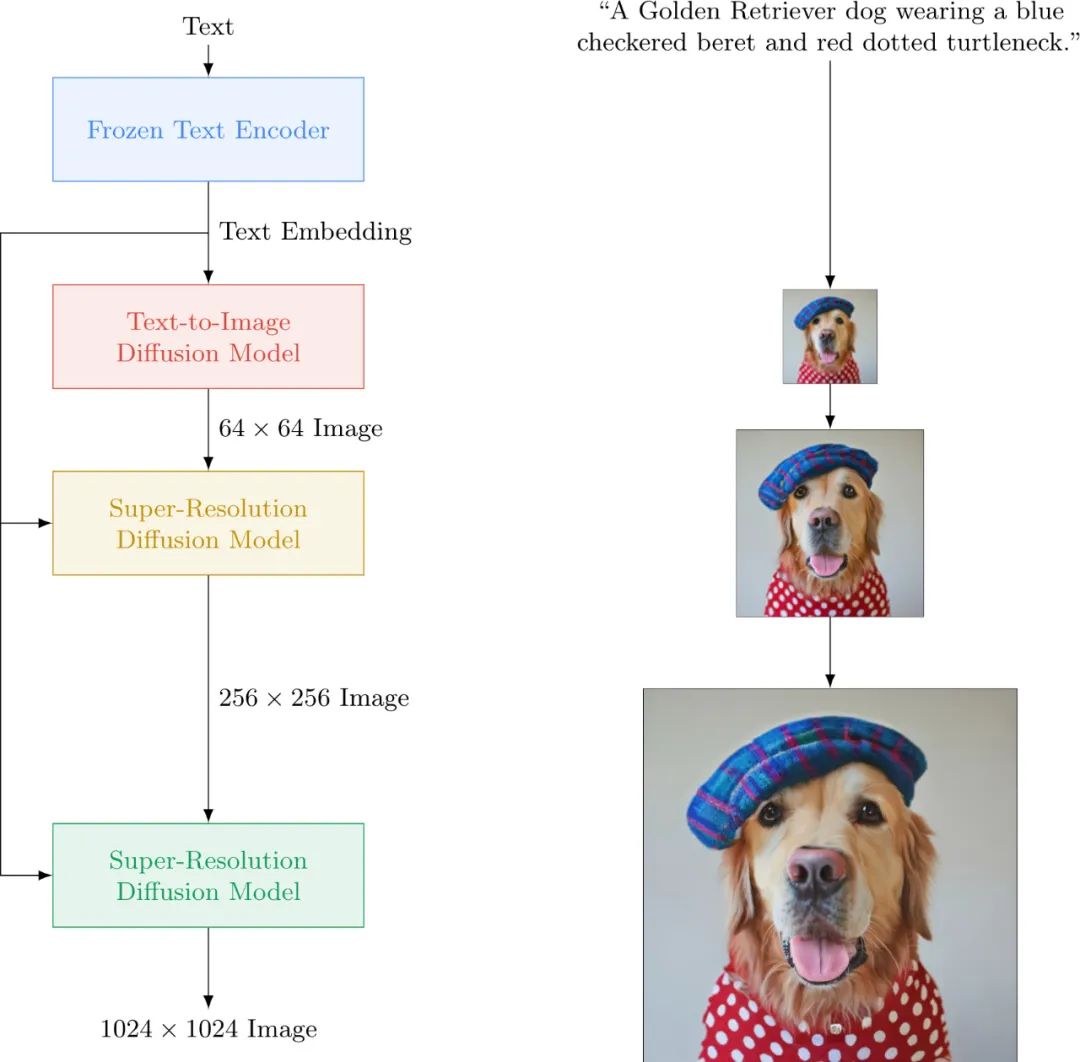

本节介绍基于扩散模型的文本到图像的前沿框架,根据扩散先验在哪里进行,可以大致分类,即像素空间或潜空间。第一类方法直接从高维像素级生成图像,包括GLIDE[15]和Imagen[16]。另一组工作建议首先将图像压缩到一个低维空间,然后在这个潜空间上训练扩散模型。潜空间类的代表性方法有Stable Diffusion[17]、VQ-diffusion[39]和DALL-E 2[18]。 像素空间中的框架

GLIDE:关于DM的第一个T2I工作。本质上,文本到图像是以文本为条件的图像合成。因此,将类条件DM中的标签替换为文本,使采样生成以文本为条件是很直观的。正如在2.3节中讨论的,引导扩散提高了条件DM中样本[37]的真实感,其无分类器变体[38]有助于处理自由形式的提示。受此启发,GLIDE[15]在T2I中采用无分类器指导,将原始类别标签替换为文本。GLIDE[15]还调查了剪辑指导,但与无分类器指导相比,人类评估人员不太喜欢样本的照片真实感和标题相似性。作为其框架中的一个重要组件,文本编码器被设置为一个transformer[40],具有24个残差块,宽度为2048(大约1.2B参数)。实验结果表明,GLIDE[15]在FID和人工评价指标上均优于DALL-E [11]。

Imagen:用预训练语言模型编码文本。

继GLIDE[15]之后,Imagen[16]采用无分类器指导的图像生成。GLIDE和Imagen的核心区别在于它们对文本编码器的选择。具体来说,GLIDE使用成对的图像-文本数据与扩散先验一起训练文本编码器,而Imagen[16]采用预训练和冻结的大型语言模型作为文本编码器。冻结预训练编码器的权重有助于离线文本嵌入,这为文本到图像扩散先验的在线训练减少了可忽略不计的计算负担。此外,文本编码器可以在图像-文本数据(如CLIP[41])或纯文本语料库(如BERT [42], GPT[43],[44],[45]和T5[46])上进行预训练。纯文本语料库明显大于成对的图像-文本数据,使这些大型语言模型接触到分布丰富而广泛的文本。例如,BERT[42]中使用的纯文本语料库约为20GB, T5[46]中使用的纯文本语料库约为800GB。以不同的T5[46]变体作为文本编码器,[16]揭示了在Imagen中增加语言模型的大小比扩大扩散模型的大小更能提高图像保真度和图文对齐。

隐空间框架

稳定扩散:潜空间的里程碑式研究。在隐空间上训练扩散模型的代表性框架是稳定扩散,它是隐扩散模型(LDM)[17]的扩展版本。继Dall-E[11]采用VQ-VAE学习视觉码本之后,稳定扩散在第一阶段使用VQ-GAN[47]进行潜表示。值得注意的是,VQ-GAN通过添加对抗性目标来改进VQ-VAE,以增加合成图像的自然度。使用预训练的VAE,稳定扩散逆转了用噪声扰动潜空间的前向扩散过程。稳定扩散还引入了交叉注意力,作为各种条件信号(如文本)的通用调节。在[17]上的实验结果表明,在隐空间上进行扩散建模在降低复杂度和保持细节方面明显优于在像素空间上进行扩散建模。在VQ-diffusion[39]中,采用先掩码再替换的扩散策略,也实现了类似的扩散算法。与像素空间方法的发现类似,无分类器指导也显著改善了隐空间[17]、[48]中的文本到图像扩散模型。

3. 文本到图像扩散模型的改进

3.1改进模型架构

关于指导的选择。在无分类器指导的基础上,[15]、[57]、[58]等工作也利用CLIP[41]探索了跨模态指导。具体来说,GLIDE[15]发现CLIP-guidance的表现低于无分类器指导的变体。相比之下,另一项修复[59]的工作指出,缺乏大规模的transformer语言模型,使得这些具有CLIP指导的模型难以编码文本提示和生成具有细节的复杂场景。通过结合大型语言模型和跨模态匹配模型,修复[59]显著提高了生成图像的样本保真度和图像-文本对齐。通用的图像合成能力使修复[59]可以在简单和复杂的场景中生成图像。 3.2 空间控制示意图

尽管它们具有前所未有的高图像保真度和标题相似性,但大多数文本到图像的DMs,如Imagen[16]和DALL-E2[18],并不提供对空间布局的细粒度控制。为此,SpaText[62]引入了空间文本(ST)表示,可以通过调整SOTA DM的解码器对其进行微调。具体来说,新的编码器同时满足局部ST和现有的全局文本。因此,SpaText[62]的核心在于ST,其中的扩散先验单独训练,以将CLIP中的图像嵌入转换为其文本嵌入。在训练过程中,通过使用CLIP图像编码器将分割后的图像对象作为输入直接生成ST。并发工作[63]提出通过简单的草图图像实现细粒度的局部控制。他们的方法的核心是一个潜在引导预测器(LGP),这是一个像素级MLP,将噪声图像的潜在特征映射到相应的草图输入。经过训练后(请参阅[63]了解更多训练细节),LGP可以部署到预训练的文本到图像DM,而不需要进行微调。

3.3 面向概念控制的文本反转

文本到图像生成的先驱工作[15],[16],[17],[18]依靠自然语言来描述生成图像的内容和风格。然而,在某些情况下,文本不能准确地描述用户想要的语义,例如生成一个新的主题。为了合成具有特定概念或主题的新场景,[64],[65]引入了一些具有所需概念的参考图像,然后将参考图像翻转为文本描述。具体来说,[64]将几个参考图像中的共享概念翻转到文本(嵌入)空间,即“伪词”。生成的“伪词”可用于个性化生成。DreamBooth[65]采用了类似的技术,主要区别在于对预训练DM模型进行微调(而不是冻结),以保留主题身份的关键视觉特征。

3.4 分布外检索

SOTA文本到图像模型令人印象深刻的性能是基于这样的假设:该模型很好地暴露了以训练风格描述公共实体的文本。然而,当实体很少见,或者期望的风格与训练风格有很大不同时,这种假设就不成立了。为了缓解分布外性能的显著下降,多个工作[66]、[67]、[68]、[69]都使用了将外部数据库作为内存进行检索的技术。这种技术首先在NLP[70],[71],[72],[73],[74]和最近在基于GAN的图像合成[75]中获得了关注,通过将全参数模型转换为半参数模型。受此启发,[66]增强了具有检索的扩散模型。检索增强扩散模型(RDM)[66]由条件DM和图像数据库组成,图像数据库被解释为模型的显式部分。通过在CLIP中测量距离,为每个查询查询k近邻,即训练样本,在外部数据库中,扩散先验由具有固定CLIP图像编码器的KNN近邻的更有信息的嵌入来指导,而不是文本嵌入。KNN-diffusion[67]采用了一种基本相似的方法,主要不同之处在于使扩散先验地附加在文本嵌入上,以提高生成的样本质量。后续的Re-Imagen[69]也采用了这种做法。与两阶段框架的RDM[66]和KNN-diffusion[67]相比,Re-Imagen[69]采用单阶段框架,选择与潜空间距离不相关的K-NN近邻。此外,Re-Imagen还允许检索到的邻居既是图像又是文本。如[69]所述,Re-Imagen在基准COCO数据集上的性能比KNN-diffusion有很大的优势。