![]()

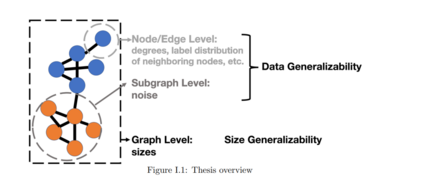

基于图的深度学习已经在各种工业环境和应用中取得了成功。然而,由于来自不同领域的图可能表现出不同的属性,并且可能具有显著的噪声,深度模型很难实现泛化。这些挑战限制了图模型在各个领域的使用。**在本文中,我对图的可泛化神经网络提出了各种理论和经验分析。我考虑了图神经网络(GNNs)的两种类型的泛化能力:(1)数据泛化能力,其中图模型具有有效处理具有不同属性的各种图的表达能力;(2)规模泛化性,图模型可以从小规模的图中学习并泛化到更大的图。**论文的第一部分分别从节点和子图两个层面研究了数据的泛化问题。在节点层面,我分析了具有不同属性的节点(如度、相邻节点的标签分布)时GNNs的性能是否会退化,并提出了有效的理论基础设计,以缓解这种退化。在子图层面,我考虑了数据有限和有噪声的情况,并提出使用聚类使GNN克服这些问题并找到有意义的模式。在论文的第二部分中,研究了图层次上的规模泛化问题。具体来说,我考虑了不同规模的图,并研究如何将知识从小型图迁移到大型图。我首先说明了基于谱特性的GNN可能会受到谱和图大小的相关性的影响,这限制了它们对大小的泛化能力。提出了一种学会消除与尺寸相关的分量的技术,提高了gnn的尺寸泛化能力。此外,我研究了transformer模型,它与gnn相关,但不依赖于图谱。在这种情况下,我发现普通的transformer模型无法泛化到更大的序列和图,因为它的注意力掩码随着输入的增加逐渐失去保真度。基于我的发现,我引入了一个学习的条件掩蔽机制,它能够在模型的训练范围之外实现强泛化。

https://ai.engin.umich.edu/event/towards-generalizable-neural-networks-for-graph-applications

![]()

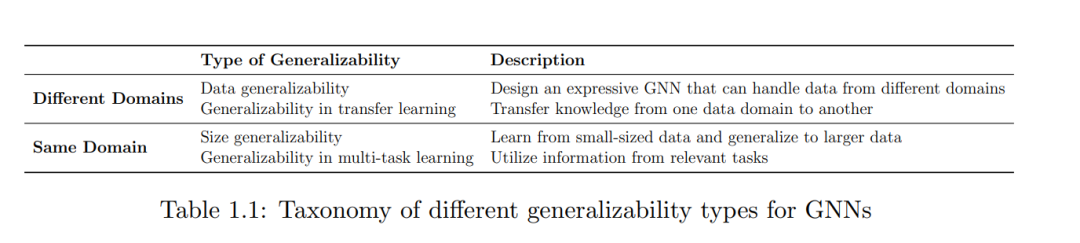

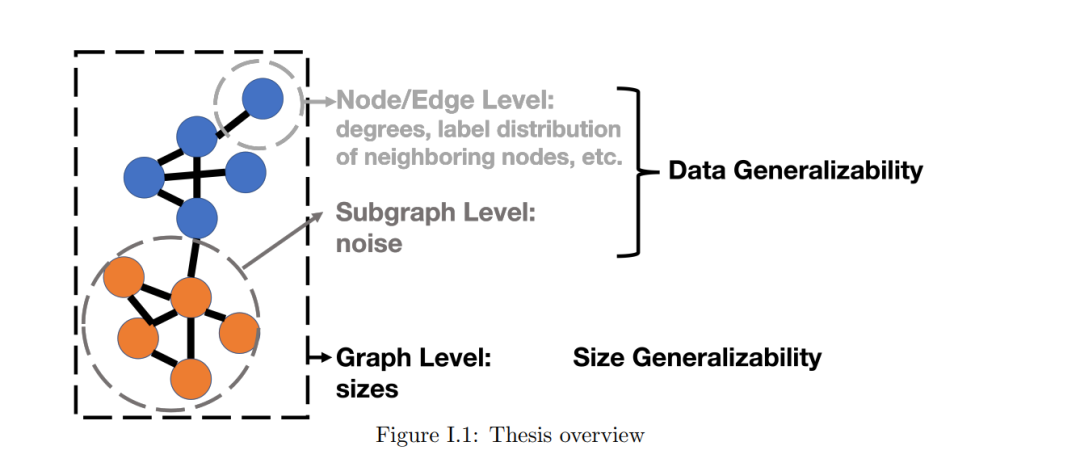

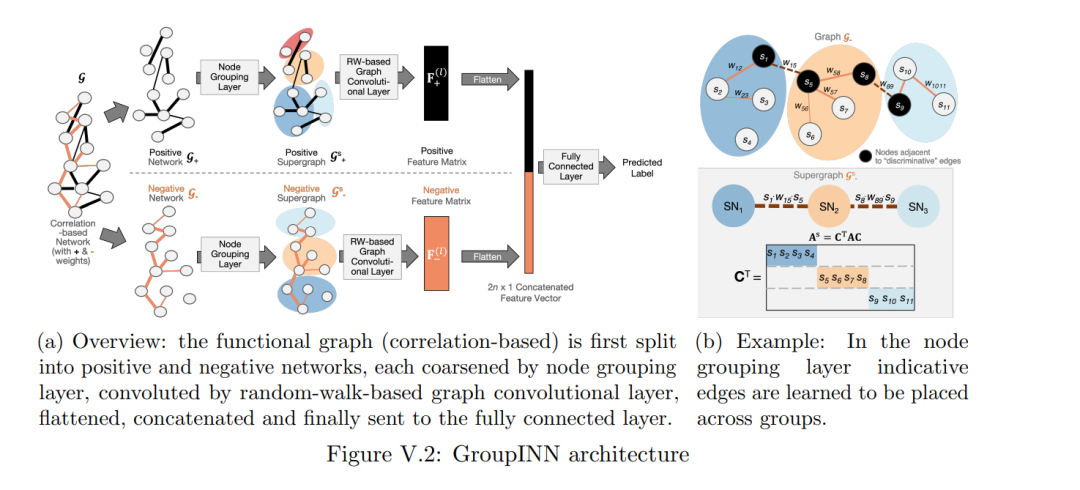

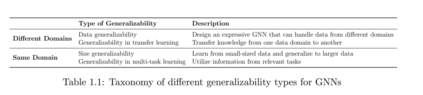

近年来,深度学习在各个领域得到了越来越多的关注,例如计算机视觉[52],自然语言处理[155]和机器人[49]。与传统方法相比,深度神经网络模型通过从海量数据中学习获得了高表达能力。在某些领域,深度模型甚至可以超越人类[137],这为通用智能带来了希望[139]。尽管深度学习在各个领域都显示了其优势,但它主要在规则结构数据上取得了成功,如序列和图像。然而,并非所有数据都具有规则结构,图数据就是一个值得注意的例子。图被广泛用于表示实体之间的交互[62,136,175]。例如,在社交网络(Facebook, LinkedIn)中,用户是节点,他们的友谊或职业关系是边[174];在脑科学中,大脑中的感兴趣区域(ROI)是节点,它们的活动相关性是边[175];在程序合成中,寄存器是节点,它们的依赖关系是边[136]。图可以在不同的粒度上进行分析:节点或边缘级别、子图级别和图级别。不同层次的分析已被用于几个高影响的应用中,例如推断电子邮件网络中的专业角色63,发现社会网络中的社区结构107,以及预测生物网络中的图属性168。 ![]() 受语言和图像深度学习成功的启发,研究人员对使神经网络适应图数据产生了极大的兴趣[73,156,176,186]。在GNN的设计目标中,本文主要关注GNN的泛化能力,并考虑两种类型的泛化能力:(1)数据泛化能力,图模型具有有效处理具有不同属性的各种图的表达能力;(2)规模泛化性,图模型可以从小规模的图中学习并泛化到更大的图。除了本文涵盖的这两种泛化类型外,GNN还存在其他类型的泛化。例如,在迁移学习中,泛化能力表征了GNN将知识从一个领域迁移到另一个领域的能力(例如,通过微调一些层[54,85]);在多任务学习中,泛化能力表示GNN利用其他任务中编码的信息的程度。在表1 - 1中,我简要概述了GNN的不同泛化类型。尽管所有这些都对构建通用GNN很重要,但数据的泛化能力和大小的泛化能力相对被忽视和探索不足。数据的泛化能力决定了一个模型是否可以有效地应用于各种应用。图在不同的域中可能不同。例如,在大多数社交网络中,度分布遵循幂律[87],而在分子图中,度并不存在偏斜。在引文网络中,具有相似属性的节点倾向于相互连接,而在在线交易网络中,具有不同属性的节点(欺诈者和共犯)倾向于形成链接[114]。在蛋白质网络中,可以清楚地观察到图形,而在大脑网络中,感兴趣区域(ROIs)之间的连接是推断的和嘈杂的[175]。尽管图数据具有多变性,但大多数GNN[42, 51, 73, 156, 169]没有考虑不同的图属性。他们持有图数据的“同质性假设”,即有链接的节点通常属于同一类或具有相似的特征(“物以类聚”)[99],而忽略了违反该假设的图的存在;他们忽略了图具有不同的度分布,GNN对不同度的节点的反应不同的事实[177];它们没有考虑图结构和特征中的噪声。为了设计更通用的GNN模型,需要考虑各种图属性。因此,本文的第一个问题是: **如何通过考虑不同的图属性来增强GNN的数据泛化能力?除了数据的泛化性,我研究的另一个关键属性是大小的泛化性。与常规结构化数据不同,很难获得相同大小的图。例如,在生物学中,分子图的大小从几个节点到数百个节点[167];在算法推理中,图可以小到几个节点,也可以大到数千个节点[136,176]。随着我们从各种来源收集越来越多的数据,训练图和测试图的大小不可避免地不同[167]。此外,大多数gnn是不可扩展的,更大的图通常需要更多的训练时间和计算资源[40]。这些原因促使一系列研究寻求将知识从较小的图转换为较大的图的方法[159,176,181]。GNN的大小泛化能力仍然有待探索。一方面,一些经验工作报告了GNN在特定应用中的良好规模泛化性能[91,97,127]。另一方面,一些实证工作认为GNN在大小泛化方面有困难[66,71,159]。大多数现有工作专注于架构设计,没有提供对GNN大小通用性的基本理解。因此,我在本文中要回答的第二个问题是: 是什么限制了GNN的大小泛化能力,以及有什么有效的设计可以提高它们泛化到更大图的能力?**为了回答上述两个问题,在本文中,我通过研究不同粒度的图来研究数据的泛化性和大小泛化性(图I.1)。论文的第一部分分别从节点和子图两个层面研究了数据的泛化问题。在节点层面,我分析了具有不同属性的节点(如度、相邻节点的标签分布)时GNNs的性能是否会退化,并提出了有效的理论基础设计,以缓解这种退化。在子图层面,我考虑了数据有限和有噪声的情况,并提出使用聚类使GNN克服这些问题,并找到有意义的模式。在论文的第二部分中,研究了图层次上的规模泛化问题。具体来说,我考虑了不同规模的图,并研究如何将知识从小型图迁移到大型图。我首先表明,基于谱特性的GNN模型可能会受到谱和图大小的相关性的影响,这限制了它们对过大尺寸的泛化能力。提出了一种学会消除与尺寸相关的分量的技术,提高了GNN的尺寸泛化能力。此外,我研究了transformer模型,它与GNN相关,但不依赖于图谱。在这种情况下,我发现普通的transformer模型无法泛化到更大的序列和图,因为它的注意力掩码随着输入的增加逐渐失去保真度。基于我的发现,我引入了一种习得的条件掩码机制,它能在远远超出模型训练范围的地方实现强大的泛化。

受语言和图像深度学习成功的启发,研究人员对使神经网络适应图数据产生了极大的兴趣[73,156,176,186]。在GNN的设计目标中,本文主要关注GNN的泛化能力,并考虑两种类型的泛化能力:(1)数据泛化能力,图模型具有有效处理具有不同属性的各种图的表达能力;(2)规模泛化性,图模型可以从小规模的图中学习并泛化到更大的图。除了本文涵盖的这两种泛化类型外,GNN还存在其他类型的泛化。例如,在迁移学习中,泛化能力表征了GNN将知识从一个领域迁移到另一个领域的能力(例如,通过微调一些层[54,85]);在多任务学习中,泛化能力表示GNN利用其他任务中编码的信息的程度。在表1 - 1中,我简要概述了GNN的不同泛化类型。尽管所有这些都对构建通用GNN很重要,但数据的泛化能力和大小的泛化能力相对被忽视和探索不足。数据的泛化能力决定了一个模型是否可以有效地应用于各种应用。图在不同的域中可能不同。例如,在大多数社交网络中,度分布遵循幂律[87],而在分子图中,度并不存在偏斜。在引文网络中,具有相似属性的节点倾向于相互连接,而在在线交易网络中,具有不同属性的节点(欺诈者和共犯)倾向于形成链接[114]。在蛋白质网络中,可以清楚地观察到图形,而在大脑网络中,感兴趣区域(ROIs)之间的连接是推断的和嘈杂的[175]。尽管图数据具有多变性,但大多数GNN[42, 51, 73, 156, 169]没有考虑不同的图属性。他们持有图数据的“同质性假设”,即有链接的节点通常属于同一类或具有相似的特征(“物以类聚”)[99],而忽略了违反该假设的图的存在;他们忽略了图具有不同的度分布,GNN对不同度的节点的反应不同的事实[177];它们没有考虑图结构和特征中的噪声。为了设计更通用的GNN模型,需要考虑各种图属性。因此,本文的第一个问题是: **如何通过考虑不同的图属性来增强GNN的数据泛化能力?除了数据的泛化性,我研究的另一个关键属性是大小的泛化性。与常规结构化数据不同,很难获得相同大小的图。例如,在生物学中,分子图的大小从几个节点到数百个节点[167];在算法推理中,图可以小到几个节点,也可以大到数千个节点[136,176]。随着我们从各种来源收集越来越多的数据,训练图和测试图的大小不可避免地不同[167]。此外,大多数gnn是不可扩展的,更大的图通常需要更多的训练时间和计算资源[40]。这些原因促使一系列研究寻求将知识从较小的图转换为较大的图的方法[159,176,181]。GNN的大小泛化能力仍然有待探索。一方面,一些经验工作报告了GNN在特定应用中的良好规模泛化性能[91,97,127]。另一方面,一些实证工作认为GNN在大小泛化方面有困难[66,71,159]。大多数现有工作专注于架构设计,没有提供对GNN大小通用性的基本理解。因此,我在本文中要回答的第二个问题是: 是什么限制了GNN的大小泛化能力,以及有什么有效的设计可以提高它们泛化到更大图的能力?**为了回答上述两个问题,在本文中,我通过研究不同粒度的图来研究数据的泛化性和大小泛化性(图I.1)。论文的第一部分分别从节点和子图两个层面研究了数据的泛化问题。在节点层面,我分析了具有不同属性的节点(如度、相邻节点的标签分布)时GNNs的性能是否会退化,并提出了有效的理论基础设计,以缓解这种退化。在子图层面,我考虑了数据有限和有噪声的情况,并提出使用聚类使GNN克服这些问题,并找到有意义的模式。在论文的第二部分中,研究了图层次上的规模泛化问题。具体来说,我考虑了不同规模的图,并研究如何将知识从小型图迁移到大型图。我首先表明,基于谱特性的GNN模型可能会受到谱和图大小的相关性的影响,这限制了它们对过大尺寸的泛化能力。提出了一种学会消除与尺寸相关的分量的技术,提高了GNN的尺寸泛化能力。此外,我研究了transformer模型,它与GNN相关,但不依赖于图谱。在这种情况下,我发现普通的transformer模型无法泛化到更大的序列和图,因为它的注意力掩码随着输入的增加逐渐失去保真度。基于我的发现,我引入了一种习得的条件掩码机制,它能在远远超出模型训练范围的地方实现强大的泛化。

![]()