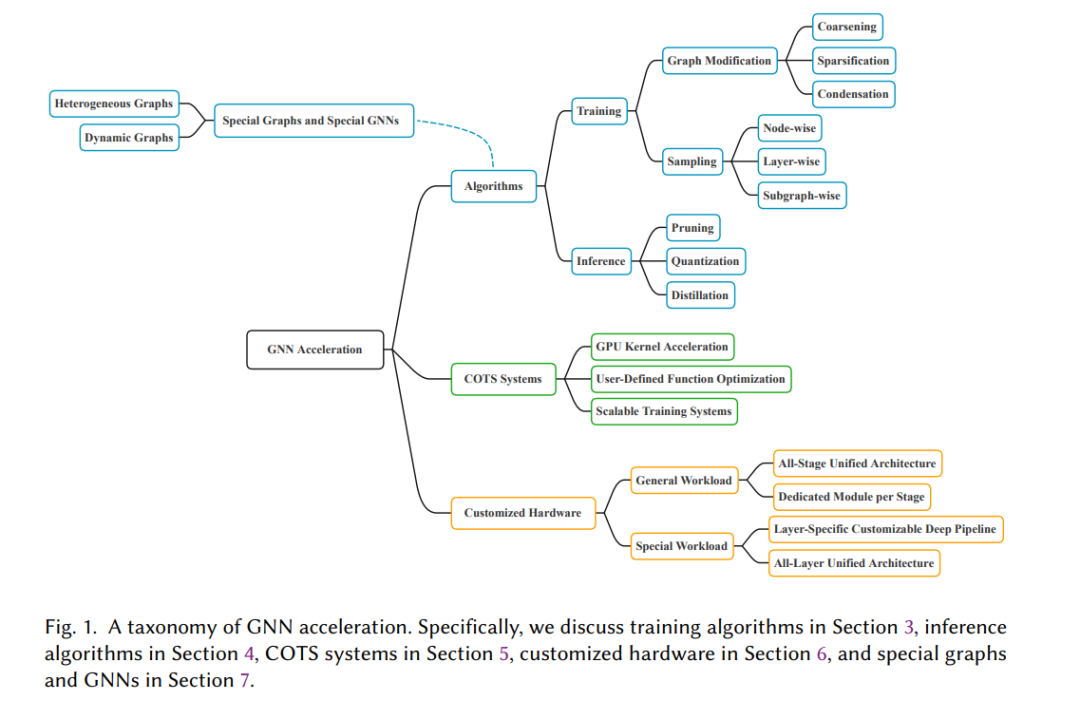

图神经网络(GNNs)正逐渐应用于对图结构数据的机器学习研究。GNNs在许多任务上实现了最先进的性能,但是当面对具有大量数据和严格延迟要求的实际应用时,它们面临可扩展性挑战。已经进行了许多研究,探讨如何加速GNNs以应对这些挑战。这些加速技术涉及GNN流程的各个方面,从智能训练和推理算法到高效系统和定制硬件。由于GNN加速的研究数量迅速增长,缺乏一个系统的处理方法来提供一个统一的视角并解决相关工作的复杂性。在这篇综述中,我们提供了一个GNN加速的分类法,回顾了现有的方法,并提出了未来的研究方向。我们对GNN加速的分类处理联系了现有的工作,并为该领域的进一步发展奠定了基础。

https://www.zhuanzhi.ai/paper/11b46b32709a0e2f1cd166faf7418f7d

1. 引言

图是一种自然而强大的数据结构,用于表示实体及其关系。许多真实世界的数据可以表示为图,其中节点表示一组实体,边表示它们之间的成对关系,例如社交网络中的个人,公司和银行之间的金融交易,分子中的原子和键,以及交通系统中的车辆。图神经网络(GNNs)[45, 71, 125] 最近已经成为学习图数据知识并进行预测的最广泛使用的图机器学习(ML)模型。GNNs在许多图ML应用中取得了最先进的性能。例如,它们用于社交图上的推荐[89, 136, 165],金融图上的欺诈账户检测[31],分子图上的药物发现[64],交通图上的交通预测[65]等。GNNs在图上的优越性能主要归因于它们能够结合实体信息(表示为节点特征)和关系(表示为图结构)。

GNNs以节点特征和图结构作为输入,并输出节点表示,这些表示可用于各种图ML任务,如节点分类,边预测和图分类。对于图中的每个节点,GNN通过信息传递来学习其表示,它聚合来自节点邻居的消息(特征),并通过使用神经网络转换聚合的消息来更新表示。每个聚合和更新操作称为一个GNN层,它允许节点表示结合来自节点的直接邻居的信息。堆叠多个GNN层将递归应用这种操作,因此节点表示可以从多跳邻居获得信息。因此,表示可以捕获本地邻域的上下文信息,并用于回答图上的复杂ML问题。对于目标节点,在其上应用𝐿层GNN,其𝐿跳内的所有邻居形成目标节点的接收场。以目标节点为根,以每个节点的邻居为其子节点的递归构造的𝐿层树图称为目标节点的计算图。

随着图机器学习(ML)领域的快速发展,图数据变得庞大,单个图中含有众多节点和边。例如,截至2015年3月,Twitter用户图有2.88亿月活跃用户(节点)以及每用户估计有208个关注关系(边);截至2014年12月,Facebook用户图有13.9亿活跃用户和超过4000亿总边[22]。这些数字已经增长得更大,并且变得难以估算。常用的学术基准也从数千个节点(例如,Cora [108])增加到最近的Open Graph Benchmark (OGB) [50]中的多达2.4亿个节点。大图为GNN训练和推理带来了可扩展性挑战。尽管当DNN参数数量变大时,其他数据类型的深度神经网络(DNNs)也面临可扩展性挑战,但GNNs的挑战是独特的,更强调大图数据[63, 163],而不是模型参数的大量。

在对图像或文本训练DNNs时,即使数据量很大,也可以通过随机抽样小批量来处理数据,因为假定所有数据实例都是独立同分布的(iid)。DNN推理也可以独立地为每个实例完成。然而,对于图上的GNNs,节点彼此依赖,这带来了好处也带来了挑战。GNNs利用节点依赖性来学习信息丰富的表示并进行预测,但节点依赖性也意味着每个节点的GNN计算都涉及多跳邻居。因此,考虑到节点依赖性,将图节点划分为GNN训练的小批量非常重要。此外,节点依赖性意味着计算图的大小在GNN层数的数量上呈指数增长[2]。在大图上,通常需要更深的GNNs以获得更好的性能[14, 73],这不仅需要处理巨大的计算图来进行小批量训练,而且在单个节点上的推理也需要这样做。以Twitter用户图为例,每个节点有208个邻居,三层GNN的计算图涉及节点三步内的所有邻居,可能包含数百万个节点(即,大致208的3次方减去重叠的节点)。这个节点依赖性问题使得在大图上应用GNNs非常具有挑战性。对于大数据集的另一种情况是具有许多图的图数据库,例如化学分子。