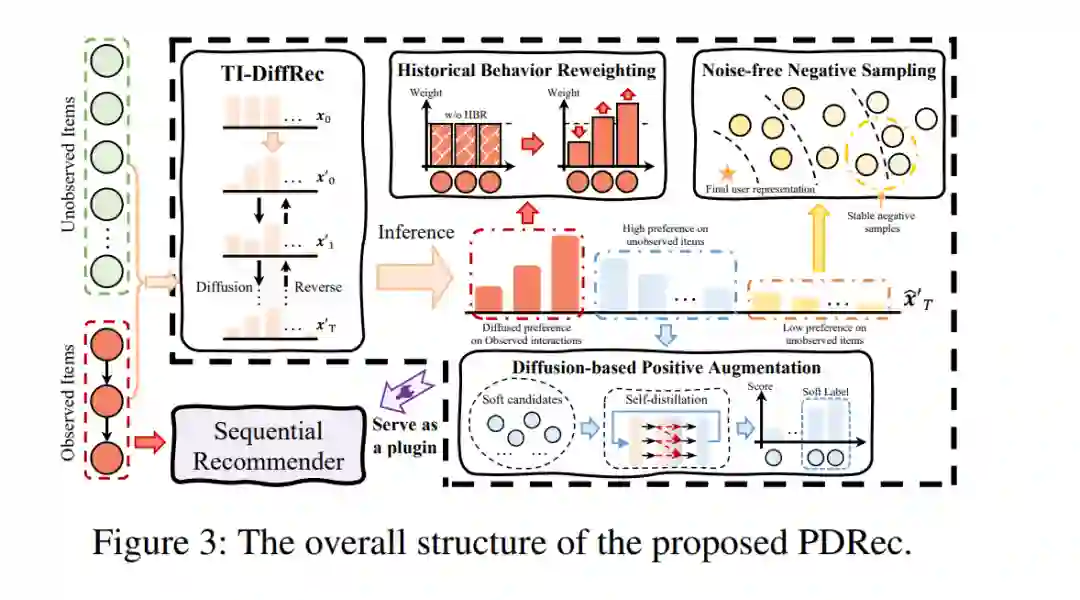

开创性的工作已经验证了扩散模型在探索推荐系统中信息不确定性方面的有效性。考虑到推荐任务与图像合成任务之间的差异,现有方法对扩散和逆过程进行了针对性的改进。然而,这些方法通常使用语料库中得分最高的项目来预测用户兴趣,导致忽视了用户在其他项目中包含的泛化偏好,从而仍受限于数据稀疏问题。为了解决这个问题,本文提出了一种新颖的推荐用插件扩散模型(PDRec)框架,该框架将扩散模型作为一个灵活的插件,共同充分利用在所有项目上扩散生成用户偏好的优势。具体而言,PDRec首先通过时间间隔扩散模型推断用户在所有项目上的动态偏好,并提出了历史行为重新加权(HBR)机制,以识别高质量行为并抑制噪声行为。除了观察到的项目,PDRec提出了基于扩散的正向增强(DPA)策略,利用排名靠前的未观察项目作为潜在正样本,引入信息丰富且多样化的软信号来缓解数据稀疏。为了缓解假阴性采样问题,PDRec采用无噪声负采样(NNS)来选择稳定的负样本,以确保有效的模型优化。在四个数据集上的广泛实验和分析验证了所提出的PDRec相较于最先进的基准模型的优越性,并展示了PDRec作为常用顺序编码器的灵活插件在不同推荐场景下的普遍性。代码可在https://github.com/hulkima/PDRec获得。

https://www.zhuanzhi.ai/paper/bb736441f0199d6b7e23e536a18d55fe

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2024年2月21日

Arxiv

224+阅读 · 2023年4月7日