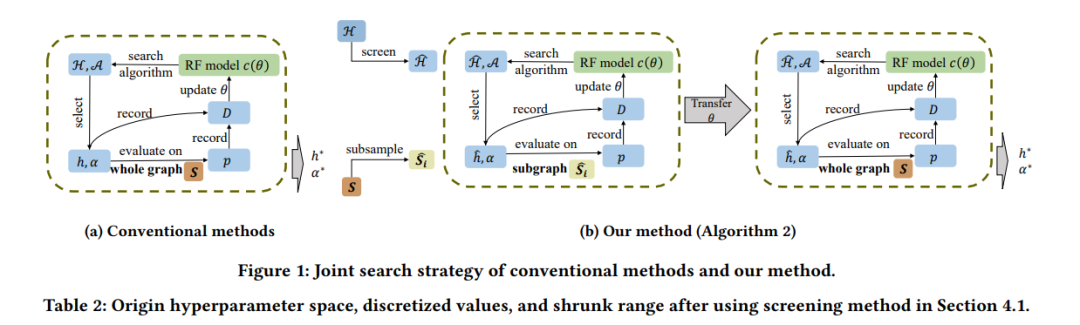

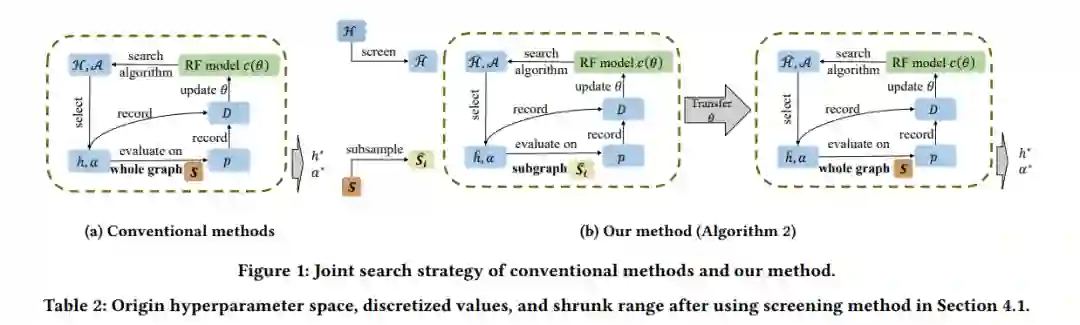

近期,自动化机器学习(AutoML)技术被引入,用以根据数据特定方式设计协同过滤(CF)模型。然而,现有的工作或是搜索架构,或是搜索超参数,而忽略了它们之间的内在关系,应该一同考虑。这激发了我们考虑一种结合超参数和架构搜索的方法来设计CF模型。但由于搜索空间巨大和评估成本高昂,这并不容易。为解决这些挑战,我们通过对单个超参数的全面了解,筛选出有用的超参数选择来减少搜索空间。接下来,我们提出了一个两阶段搜索算法,从减少的空间中找到合适的配置。在第一阶段,我们利用从子样本数据集中获取的知识来减少评估成本;在第二阶段,我们高效地在整个数据集上对顶级候选模型进行微调。在真实世界数据集上的大量实验表明,与手工设计的和以前搜索的模型相比,我们的模型可以达到更好的性能。此外,消融和案例研究都证明了我们搜索框架的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日