背景:

人工智能和机器学习算法处于当前研究的最前沿,以帮助军事分析人员处理源自传感器的越来越多的数据。这些自动化方法将越来越多地嵌入到军事决策过程中,这使得了解这些算法如何产生输出以及它们对训练或分类期间的扰动有多敏感变得至关重要。换句话说,人类必须对这些套路有一个 "心智理论",以便开始充分信任它们,做出生死攸关的决定。这一领域的研究被称为人工智能/机器学习的对抗样本。

这个领域以前的工作主要是针对新数据中添加的噪音而降低分类性能。其中一些作品通过巧妙地增加噪声在图像数据上取得了明显的效果,这样的图像在人眼看来没有改变,但却大大影响了性能(Athalye等人,2017)。Povolny和Trivedi(2020)取得了类似的结果,但做了一个视觉上明显的小改变,以诱发性能的下降。值得注意的一项研究工作是对被感知环境的物理尺度进行增加(如遥感平台记录的大面积)对对抗性扰动的影响(Czaja等人,2018)。

本技术说明(TN)描述了对理解军用车辆外观的物理变化如何导致卷积神经网络(CNN)性能下降的初步尝试。选择的军用车辆是M2布雷德利步兵战车和M1064迫击炮载具。作为实际车辆的替身,使用了塑料比例模型,每个模型都是1/35的复制品。这项研究的结果产生了一个与M2和M1064有关图像的训练和测试数据集,基于Keras项目的ResNet/Inception组合实现训练模型,以及使用比例模型和智能手机拍摄的图像模拟出来对抗性样本。

数据和方法:

本TN中提出的研究集中在可见光谱内的扰动和图像。这种传感方法可能是用于进行车辆分类的集合方法之一。其他传感器模式,如红外线,也可以进行研究,但在最初研究的有限时间内很难获得。此外,以前的工作中所描述的许多技术和方法都是在这些类型的图像上演示的。

训练、测试和评估数据集的样本图片是通过谷歌图片搜索获得的,使用的是'm2 bradley'和'm1064 mortar carrier'。然后复制图片的URL,作为wget命令的参数,将所有图片下载到一个目录中。非相关的图片被从目录中剔除,其余的则使用LabelImg开源软件包进行手工处理。LabelImg允许用户在图像文件中感兴趣的主题周围画出边界框,并生成一个单独的XML文件来保存注释。注释文件中包含的信息包括边界框的位置和边界框中主体的相关类别标签。使用LabelImg处理图像的一个例子如图1所示。

图1. LabelImg软件。

以这种方式处理图像数据提供了灵活性,因为原始图像未被触动。在模型训练、测试和评估过程中的准确性可能会提高,因为边界框可以用来有效地裁剪内存中的图像。这个处理过的数据集随后被分割成独立的训练、测试和评估数据集。图2中显示了训练数据集的一个截图。

图2. 训练数据集中的图像样本。

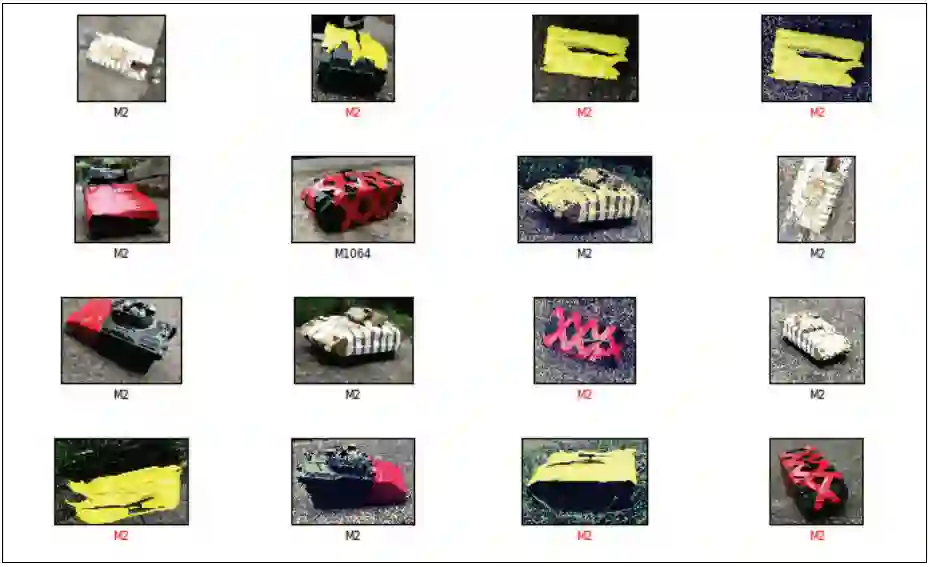

通过使用彩色塑料带修改比例模型的外观来获得对抗性样本。使用了三种颜色--黄色、红色和白色--并在整个身体上以不同的模式粘贴。智能手机被用来拍摄不同方向和环境下的修改后的模型。由此产生的图像集合也使用LabelImg进行处理,以确定特定图像中的兴趣区域。此外,为了进一步衡量这些扰动对性能的影响,还对图像施加了过滤器,增加了噪音或模糊。图3显示了这些对抗性样本的实例。

图3. 对抗性样本。

卷积神经网络因其在此类任务上的鲁棒性而被选作图像分类的评估对象(Raghu和Schmidt 2020)。这种方法的基本理论是将输入的图像分解成瓦片。然后,这些瓦片可以在网络的不同层中以不同的排列组合(例如,3 x 3或2 x 2)组合起来。随着不同层的输出被结合起来,网络最终学会了哪些瓦片或瓦片的分组对某一类图像的预测性最高。实验使用了两个不同的CNN。一个是来自TensorFlow模型Zoo1的Faster R-CNN ResNet 101(FRCNN)的实现,在Common Objects in Context(COCO)数据集上进行了预训练2。请注意,COCO数据集的创建是为了测试一个类似于本TN中概述的任务--自定义物体检测,尽管它似乎并不包含军用车辆的图像。该模型在训练数据集上进一步训练,试图了解迁移学习对训练时间和准确性的影响。第二个模型是结合了两个CNN的实现--来自Keras项目(Lee 2020)的ResNet和Inception V2(RIV2)。这个模型只在这个训练数据上训练。

TensorFlow被选为训练、测试和评估模型的基础架构。TensorFlow的主要优势是它在文档方面的广泛支持,易于安装,以及可用的模型实现。此外,TensorFlow能够利用图形处理单元(GPU)的优势,以大大减少训练时间,这在训练RIV2模型时很有用。

结果:

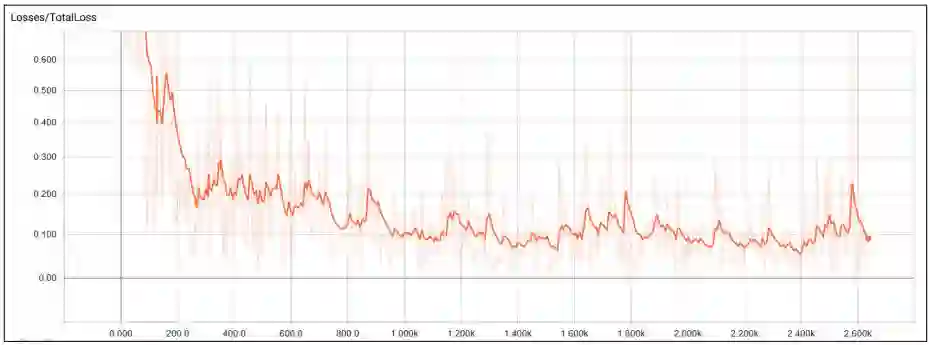

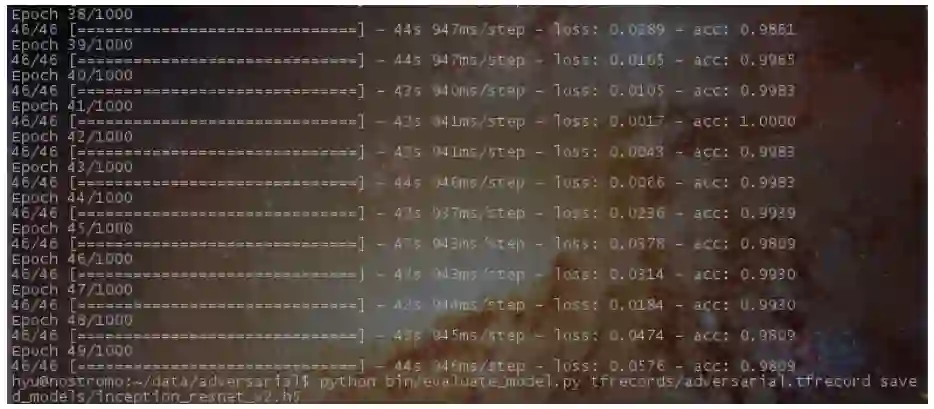

FRCNN的训练在历时2,629时停止,以绘制损失函数 "噪音"。而且,一旦损失函数在8个历时后开始增加,RIV2的训练就在49个历时后停止--这是一个用户定义的设置,对于防止模型对训练数据的过度拟合很有用。图4和图5分别显示了FRCNN的损失与训练历时的关系以及RIV2的训练结果。

图4. 损失与训练历时的关系,FRCNN。

训练完成后,为了保存模型的状态,我们创建了检查点文件。这些文件使用h5py Python软件包以层次数据格式第五版(HDF5)的格式存储。然后,这些检查点文件可以在任何时候用于测试或评估。

图5. 训练结果RIV2。

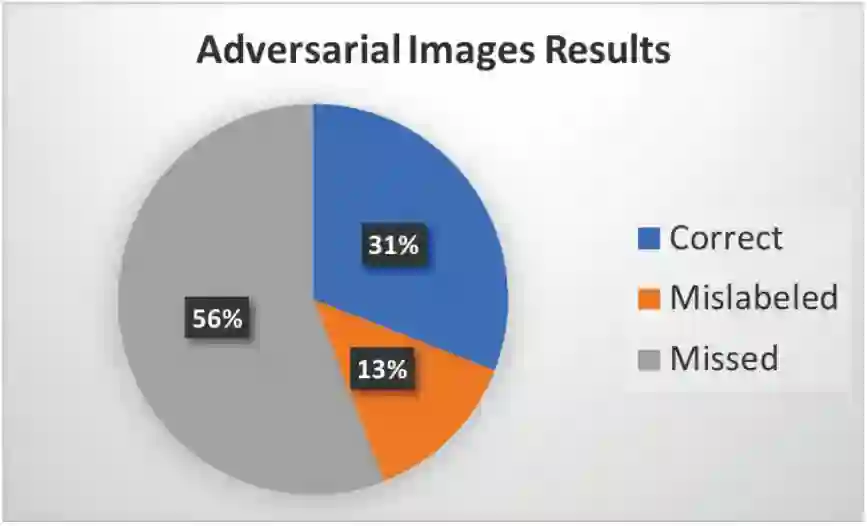

在对抗性数据集上测试,FRCNN和RIV2模型都表现出明显的性能下降。对于FRCNN来说,总准确率降低到36%,而RIV2则达到了约50%。图6显示了FRCNN性能的细分,图7显示了RIV2的性能。请注意,对于图6中的图表,"误标 "类别意味着模型提供了错误的车辆标签(无论是M2还是M1064)。遗漏 "类别意味着模型根本没有将图像分类为 "M2 "或 "M1064"。这是因为该模型是在COCO数据集上训练的,用于更一般的分类任务。对RIV2的定性要简单得多,因为只有两个标签是可能的,要么是'M2'要么是'M1064'。

图6. 分类性能分解,FRCNN。

图7. 评估结果,RIV2。

我们还进一步检查了RIV2的性能,看它在对抗性数据集中对哪些图像进行了错误分类。图8显示了该输出的一个样本。

图8. 分类结果样本,RIV2。

令人惊讶的是RIV2对一些扰动的鲁棒性。请注意沙漠迷彩M2布雷德利的图像,其上有散落的白色胶带,而林地迷彩M2布雷德利的正面有红色胶带。然而,对于沙漠迷彩的对抗性样本类,一个特定的相机角度设法迫使分类器每次都失误,这可以在图9中看到。使用RIV2试图对对抗性实例进行分类时,总体准确率为50%。

图9. 错误分类的相机视角。

结论

卷积神经网络在有限的情况下对目标的公开扰动可以相当稳健。然而,整体性能会下降到随机猜测在图像分类任务中同样有效的地步。在对完整的对抗性样本数据集进行评估时,FRCNN和RIV2都达到了这一点。

未来的工作应该包括尝试分析模型的激活图谱(Carter等人,2019),这可以为哪些特征是最有预测性的提供线索。可解释人工智能领域内的其他方法也可能在这方面被证明是有用的。此外,还应该探索确定发生错误分类所需的车辆外观的最小数量的工作。

事实证明,TensorFlow是一个稳定且性能良好的系统,可以训练、测试和评估深度学习模型。本TN中描述的所有模型都使用了1.x的API,但较新的API已经发布。未来的工作应该尽可能尝试使用较新的2.x API,尽管届时这些算法可能会被更多最新和更强大的版本所取代。

显然,人工智能在军事应用中的使用显示出巨大的前景,但也可能存在意想不到的隐患。如果不仔细考虑训练、测试或评估数据和过程所产生的隐性偏见或盲点,这些算法是否可以被信任来帮助指导决策者,还有待观察。