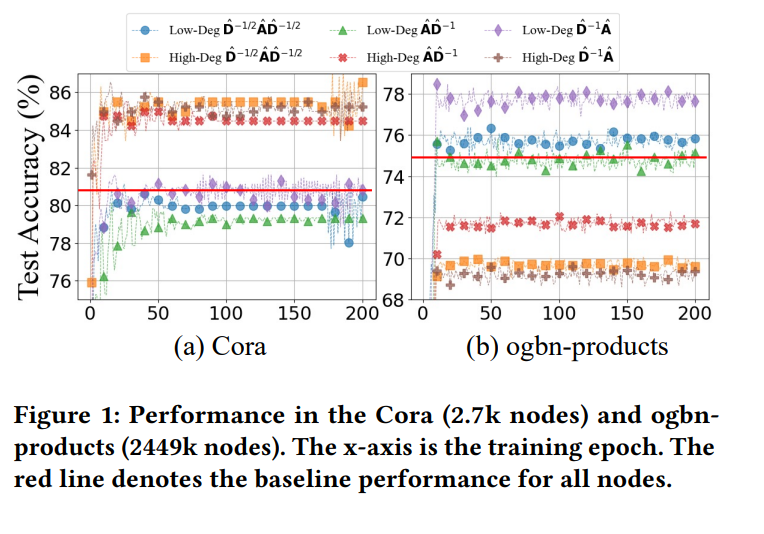

可扩展的图神经网络(GNNs)已经成为一种有前途的技术,它在许多大规模基于图的网络应用中展现出了卓越的预测性能和高运行效率。然而,(i)大多数可扩展的GNNs倾向于使用相同的传播规则处理所有节点,忽略了它们的拓扑独特性;(ii)现有的节点式传播优化策略在具有复杂拓扑结构的网络规模图上不足够,这类图要求全面描述节点的局部属性。直观地说,网络规模图中的不同节点拥有不同的拓扑角色,因此不加区分地传播它们或忽略局部上下文可能会损害节点表示的质量。为了解决上述问题,我们提出了自适应拓扑感知传播(ATP),它减少了潜在的高偏差传播,并以可扩展的方式提取每个节点的结构模式,以提高运行效率和预测性能。值得注意的是,ATP被设计为一种即插即用的节点式传播优化策略,允许离线执行,独立于图学习过程,提供了一个新的视角。因此,这种方法可以无缝集成到大多数可扩展的GNNs中,同时与现有的节点式传播优化策略保持正交。在12个数据集上的广泛实验已经证明了ATP的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2024年3月22日

Arxiv

42+阅读 · 2023年4月19日

Arxiv

219+阅读 · 2023年4月7日