检索增强生成

·

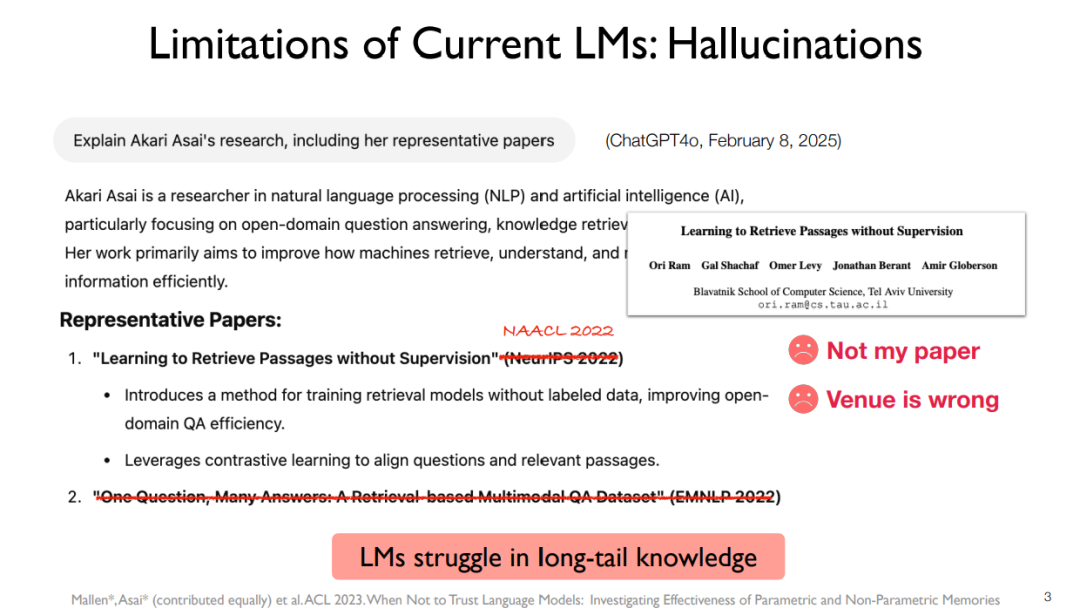

这份讲义系统性地阐述了检索增强生成(RAG)技术,其核心思想是通过为语言模型(LM)检索外部知识库中的相关信息来增强其生成能力,从而解决传统参数化LM的“幻觉”、知识更新滞后和长尾知识匮乏等局限性。RAG系统包含三个关键部分:数据存储(海量文档的收集与处理)、检索器(包括稀疏、密集和重排器等类型,用于查找相关文档)以及语言模型(利用检索到的文档生成最终答案)。讲义详细介绍了从经典的输入增强方法(如RAG)到更先进的中间融合(如RETRO)和自省式检索(如Self-RAG)等多种架构,并强调了RAG在提升答案准确性、可验证性和降低幻觉方面的显著效果,是当前将大语言模型与外部知识连接起来的关键技术。

成为VIP会员查看完整内容