主题: Locally Masked Convolution for Autoregressive Models

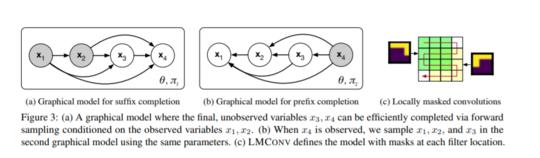

摘要: 高维生成模型具有许多应用程序,包括图像压缩,多媒体生成,异常检测和数据完成。自然图像的最新估算器是自回归的,可将像素上的联合分布分解为由深度神经网络(例如,神经网络)参数化的条件乘积。卷积神经网络,例如PixelCNN。但是,PixelCNN仅对关节的单个分解建模,并且只有单个生成顺序是有效的。对于诸如图像完成的任务,这些模型无法使用很多观察到的上下文。为了以任意顺序生成数据,我们引入了LMConv:对标准2D卷积的简单修改,允许将任意蒙版应用于图像中每个位置的权重。使用LMConv,我们可以学习分布估计器的集合,这些估计器共享参数但生成顺序有所不同,从而提高了全图像密度估计的性能(无条件CIFAR10为2.89 bpd),以及全局一致的图像完成度。

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

专知会员服务

16+阅读 · 2020年3月27日

专知会员服务

37+阅读 · 2020年2月27日

Arxiv

8+阅读 · 2019年2月8日

Arxiv

4+阅读 · 2018年2月19日