AAAI 是由国际人工智能促进协会主办的年会,是人工智能领域中历史最悠久、涵盖内容最广泛的国际顶级学术会议之一,也是中国计算机学会(CCF)推荐的 A 类国际学术会议,在人工智能领域享有较高的学术声誉。2024年,AAAI主办地为加拿大温哥华,录用文章2342篇,录用率为23.75%。

图神经网络(GNNs)在图相关任务中已被证明高度有效,包括交通建模、学习物理模拟、蛋白质建模和大规模推荐系统。焦点已转向提供准确结果并为其预测提供可理解和可操作见解的模型。反事实解释作为满足这些挑战和赋能用户的关键工具已经浮现。基于上述原因,在本教程中,我们提供生成GNNs反事实解释的基本理论基础,为观众提供资源以更深入地理解他们的系统产生的结果,并使用户能够有效地解释预测。首先,我们介绍GNNs的洞察力,它们的底层消息传递架构,以及在不同领域为其预测提供事后解释的挑战。然后,我们提供图反事实可解释性(GCE)的正式定义及其为用户提供补救措施的潜力。此外,我们提出现有GCE方法的分类,并提供每种方法的主要思想、优点和限制的见解。最后,我们介绍最常用的基准数据集、评估指标和协议,以分析该领域未来的挑战。

AAAI社区对图神经网络和可解释AI表现出了相当大的兴趣,这一点从以往版本的教程中可以看出。图反事实可解释性(GCE)因图的普遍性和GCE方法提供对复杂非线性预测系统深刻洞察的固有能力,有潜力吸引广泛的研究者和实践者。基于最近发布的综述[1],这个教程将涵盖与图神经网络、事后解释方法和反事实解释相关的基本概念。此外,观众将被提供现有GCE方法的详细分类、它们的作用机制的深入分析、定性比较,以及它们在合成和真实数据集上的性能基准测试,包括大脑网络和分子结构。

这个教程面向有兴趣应用机器学习技术分析图数据的学术界和工业界的从业者。拥有数据挖掘背景的参与者将获得解释方法向最终用户提供信息的理解。拥有机器学习(ML)专业知识的参与者将更深入地探讨最先进的反事实解释器,批判性地分析它们的优点和缺点。

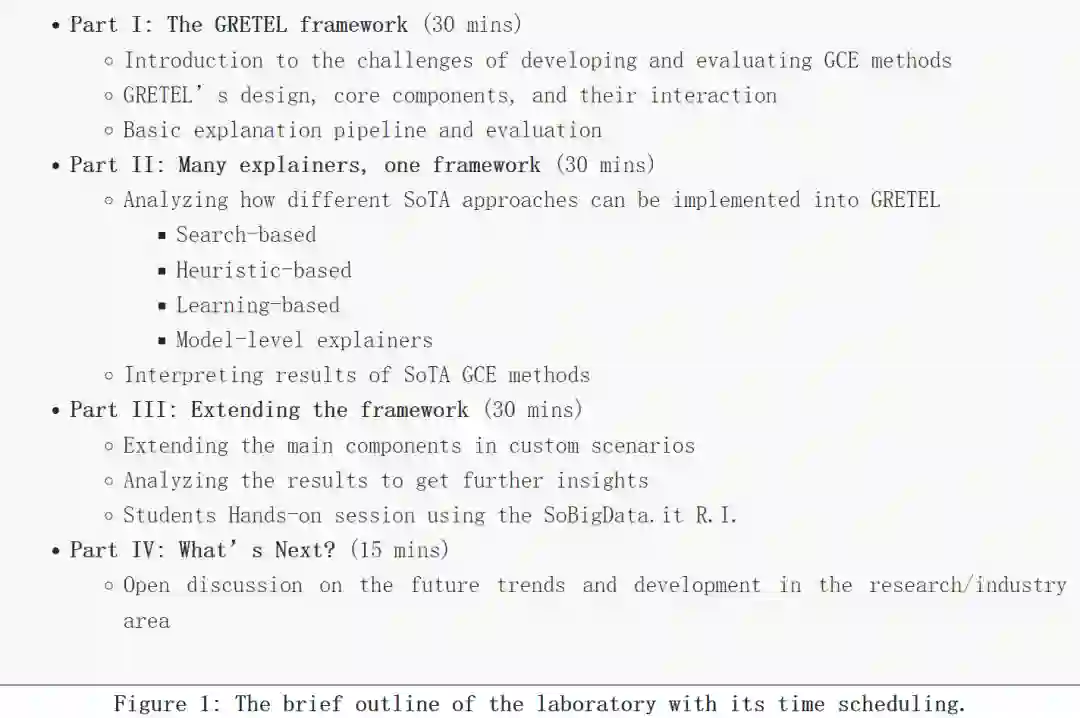

反事实解释阐明了决策机制,并提供了导致不同结果的替代情景,为最终用户提供了补救措施——这些独特的特性使反事实可解释性成为基于图的背景中一种高效的方法。我们采用多方面的方法,从不同的角度组织和审视GCE,如方法分类、沿各种维度的分类、个别作品的详细描述(包括它们的评估过程)、关于评估指标的讨论和常用的基准数据集。我们在图1中提供了教程的简要概述。在这里,我们全面回顾了图中的反事实可解释性及其与其他(事实)可解释性方法的重要性。

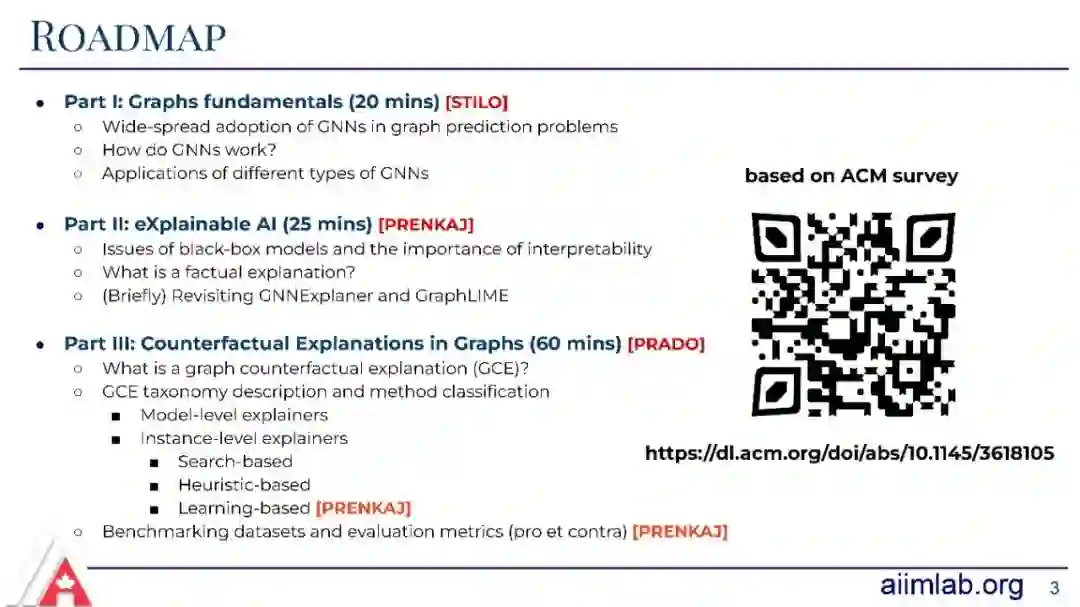

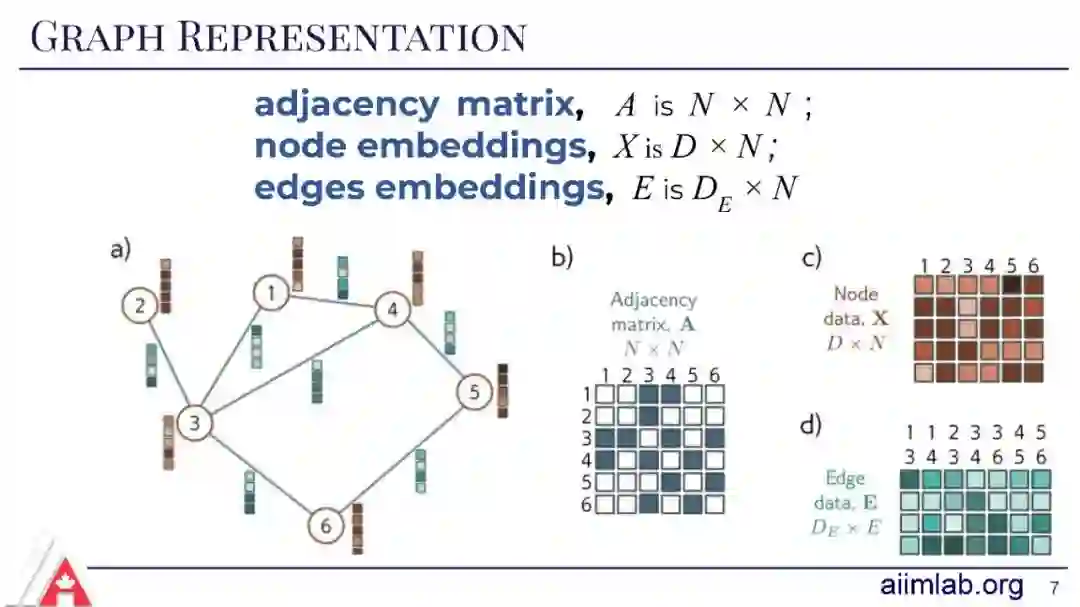

在教程的第一部分,我们介绍了GNNs [2]及其底层的消息传递机制来解决图预测问题。我们将深入探讨不同类型的GNNs及其在实际问题中的应用[3],如蛋白质-蛋白质相互作用、药物-靶点亲和力预测和社交网络中的异常检测。

在第二部分,我们为读者提供了在关键场景中部署黑盒模型的挑战以及事后可解释性如何帮助揭示“引擎盖下发生了什么”。在这里,我们介绍了事实解释[4],并简要回顾了这一类别中最有趣的方法,即GNNExplainer [5]和GraphLIME [6]。

在第三部分,我们正式定义了图反事实解释(GCE)。我们提出了最重要的参考文献[1]的分类,如表1所示,包括基于搜索的解释器[7]、基于启发式的解释器[8,9,10]、基于学习的解释器[9,11,12,13,14,15,16,17,18]和全局级别的解释方法[19]。此外,我们列出了最常见的基准数据集和一套评估指标[4,20],这些指标对于评估文献中每个反事实解释器的(不)优势是必要的。此外,我们提交了一个实验室会话提案,通过提供动手体验来补充这个教程。

[1] Mario Alfonso Prado-Romero and Giovanni Stilo. 2022. GRETEL: Graph Counterfactual Explanation Evaluation Framework. In Proceedings of the 31st ACM International Conference on Information & Knowledge Management (CIKM ‘22). Association for Computing Machinery, New York, NY, USA, 4389–4393. https://doi.org/10.1145/3511808.3557608 [2] Y. Liu, C. Chen, Y. Liu, X. Zhang and S. Xie, Multi-objective Explanations of GNN Predictions, 2021 IEEE International Conference on Data Mining (ICDM), Auckland, New Zealand, 2021, pp. 409-418, https://doi.org/10.1109/ICDM51629.2021.00052 [3] Carlo Abrate and Francesco Bonchi. 2021. Counterfactual Graphs for Explainable Classification of Brain Networks. In Proceedings of the 27th ACM SIGKDD Conference on Knowledge Discovery & Data Mining (KDD ‘21). Association for Computing Machinery, New York, NY, USA, 2495–2504. https://doi.org/10.1145/3447548.3467154 [4] Bajaj, M., Chu, L., Xue, Z., Pei, J., Wang, L., Lam, P.,and Zhang, Y. Robust counterfactual explanations on graph neural networks. Advances in neural information processing systems, 34.