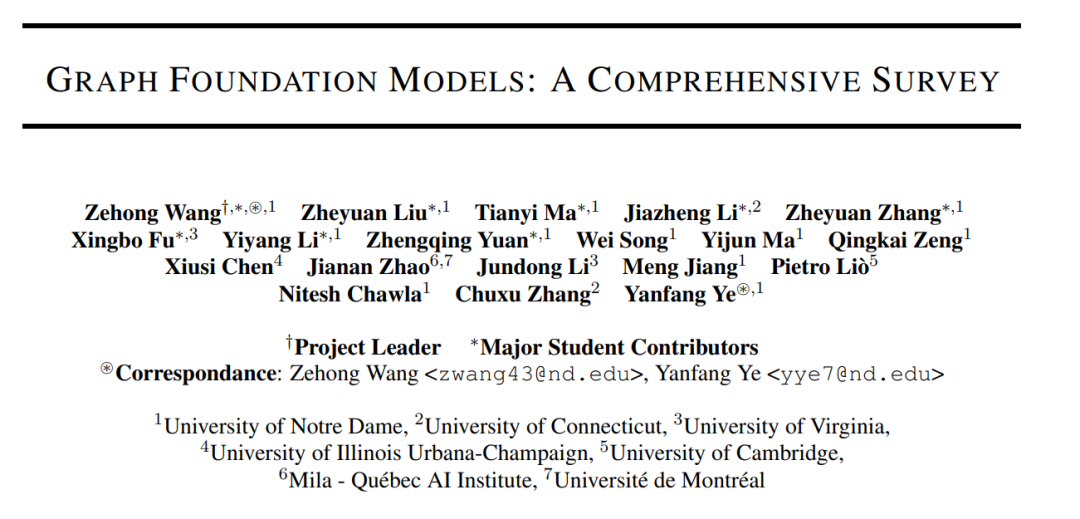

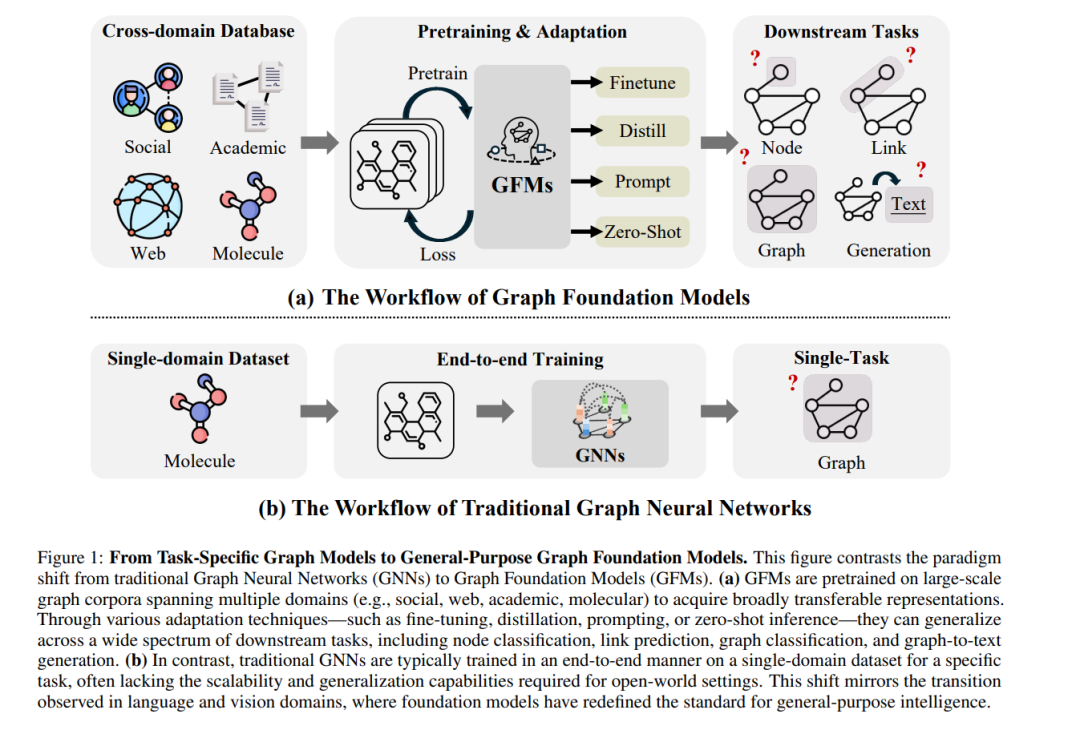

图结构数据广泛存在于社交网络、生物系统、知识图谱和推荐系统等领域。尽管基础模型已通过大规模预训练和强泛化能力在自然语言处理、计算机视觉和多模态学习中取得了革命性进展,但将这些能力扩展到图数据上——该数据具有非欧几里得结构和复杂的关系语义——仍面临独特挑战,同时也带来了新的机遇。为此,图基础模型(Graph Foundation Models, GFMs)旨在为结构化数据赋予可扩展的通用智能,从而支持跨图任务和跨领域的广泛迁移。 本综述系统地回顾了GFMs的发展现状,并提出一个统一的模块化框架,将现有多种研究工作归纳为三个核心组成部分:主干架构、预训练策略和适配机制。我们依据GFMs的泛化范围将其分类为通用型、任务特定型和领域特定型三大类,并在每一类别下回顾具有代表性的方法、关键创新与理论洞察。 除了方法论,我们还探讨了GFMs的理论基础,包括可迁移性和涌现能力,并指出当前面临的核心挑战,如结构对齐、异质性处理、可扩展性和评估机制。GFMs位于图学习与通用人工智能的交汇点,有望成为在结构化数据上进行开放式推理的基础性基础设施。 本综述汇总了当前的研究进展,并展望了未来的发展方向,旨在为该快速演进的研究领域提供有价值的参考与指导。相关资源可访问:https://github.com/Zehong-Wang/Awesome-Foundation-Models-on-Graphs。 在机器学习领域,实现“一模型通用”(one-model-fits-all)的范式一直被视为最具雄心和变革性的目标之一。该愿景旨在构建高度可泛化的模型,能够在无需大量任务特定架构设计或训练的情况下,胜任多个领域的广泛任务。历史上,机器学习一直以针对特定数据模态和任务目标的专用模型为主导[1],通常依赖手工设计的特征[2]和依赖领域的优化策略[3]。从早期的基于规则的系统和线性分类器,到深度学习的崛起,机器学习的发展体现了在表示学习、可扩展性和任务性能方面的持续提升[4, 5]。 传统模型如决策树、支持向量机(SVM)和k近邻(KNN)在低维度、结构化环境中表现良好,但在处理高维、非结构化或多模态数据时面临挑战。深度学习模型的出现——如用于视觉的卷积神经网络(CNN)[6]和用于序列数据的循环神经网络(RNN)[7, 8]——显著提升了感知任务的表现。然而,这些模型仍需进行任务特定的微调、架构调整,并依赖大规模标注数据以实现稳健的泛化能力。 随着迁移学习[9]和自监督学习[10]的发展,模型可以从大规模未标注数据中学习具有广泛可迁移性的表示,标志着范式的重大转变。这些进展为**基础模型(foundation models)**的出现奠定了基础,后者通过在海量数据上训练以获取通用知识,能够快速适配各种下游任务。 基础模型的核心特征包括其规模性、通用性以及跨异构数据源的预训练能力。它们被设计为捕捉可迁移的归纳偏置,使得在极少的任务监督下也能实现强大的性能表现。扩展法则(scaling laws)[12, 13]与数据驱动的学习范式推动了基础模型在自然语言处理、计算机视觉、机器人等多个领域的成功。例如,大型语言模型(LLMs)[14, 15]通过将文本分词处理,并将翻译、摘要、推理等任务建模为自回归的下一个token预测问题。同样地,大型视觉模型(LVMs)[16, 17, 18]将视觉输入视为token序列,使用基于Transformer的架构处理图像问答、图像描述或图像生成任务。这些模型展现出惊人的零样本(zero-shot)与小样本(few-shot)泛化能力,能够在无需大规模微调的情况下快速适应新任务。 在这一背景下,**图基础模型(Graph Foundation Models, GFMs)**的兴起(见图1)旨在将上述能力拓展至图结构数据——这一具有关系依赖、排列不变性和非欧几里得几何特征的关键但本质上不同的数据模态[19, 20, 21]。GFMs致力于为各种基于图的应用场景提供统一、可预训练、可适配的解决方案,涵盖从分子性质预测、知识图谱推理到社交网络分析和推荐系统等任务。

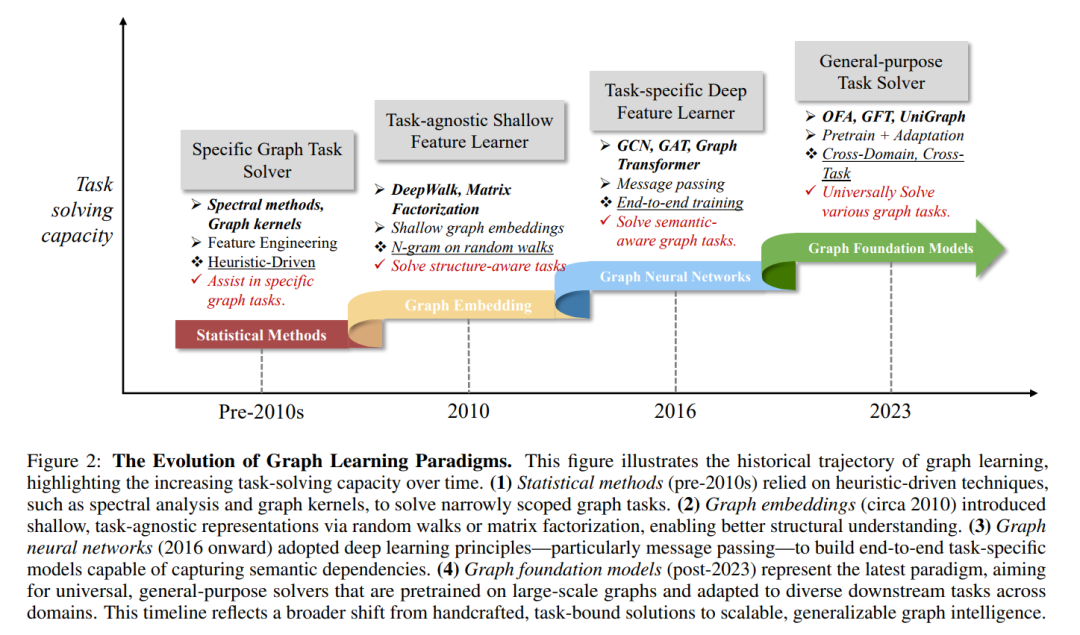

例如,OFA[22]在包含文本属性的八个图(TAGs)上运行,这些图涵盖引文网络、Wikipedia网络、知识图谱和分子图等,每个节点都附带文本描述。通过共享的文本编码器,OFA将节点描述映射至统一的嵌入空间,实现跨图节点特征的对齐。为了弥合预训练与下游任务之间的鸿沟,它引入了提示图机制(prompt graph mechanism)以增强任务适配能力。类似地,GFT[23]通过将图数据建模为计算树来识别可迁移模式,借助树结构重建任务对齐跨图的节点表示,从而捕捉跨领域的泛化能力。GFT的一项关键创新是构建可迁移的树结构词表,编码在不同图域中共享的结构模式。 除了这些通用模型,还存在许多为特定任务(如节点分类[24, 25]、异常检测[26]、推荐系统[27])或特定领域(如知识图谱[28, 29]、分子图[30, 31]、计算图[32, 33])而设计的GFMs。 已有综述。 尽管GFMs研究迅速发展,且受到了越来越多的关注,但当前文献中仍缺乏一部全面、系统的综述,以覆盖该新兴领域的广度与深度。现有综述通常聚焦于GFMs的某一方面,提供的是零散视角,尚未全面揭示其基础技术、设计挑战与研究方向。例如,Liu等[34]基于主干架构将GFMs分类为基于GNN、基于LLM和GNN+LLM混合模型,但其讨论局限于方法层面,未涉及应用与理论理解。Zhao等[35]则围绕预训练目标进行分析,尽管提出了有价值的学习范式观点,但未涵盖系统设计与理论深度。Mao等[36]从转移性视角出发,聚焦于泛化能力的理论解释,但未对方法创新与实证研究进行系统整理。Wang等[37]也强调可迁移性与涌现能力,但未能涵盖GFMs的完整架构、算法和应用维度。另有如Zhao等[38]关注跨领域图学习,这虽是GFMs设计的一个重要维度,却难以涵盖跨任务泛化与结构对齐等核心问题。其他如Wu等[39]探讨GFMs在推荐系统中的应用,而近期综述[40, 41, 42, 43]聚焦于GNN与LLM的集成,更多地视为一个子领域而非整体GFMs框架的一部分。 我们的立场。 本综述旨在填补上述空白,系统化地回顾图基础模型的发展。我们首先介绍GFMs的历史演进与基本挑战,随后提出一个统一的模块化框架,将GFMs分解为三大核心组件:主干架构、预训练策略与适配机制。我们引入一个系统的分类体系,将GFMs划分为通用型、领域特定型与任务特定型,并在每一类中进行详尽的文献回顾,涵盖其设计理念与代表性模型。 此外,我们还分析GFMs的理论基础(如扩展法则、可迁移性理论与涌现能力),并整理相关基准资源与当前局限。最后,我们总结该领域的关键开放问题与未来研究方向,以指导后续研究。 我们的主要贡献如下: * GFMs设计挑战(第3节):我们将构建图基础模型所面临的核心挑战归纳为三个维度:特征异质性、结构异质性与任务异质性,突出图结构数据在大规模学习中的复杂性。 * 统一框架(第4节):提出一个统一的模块化框架,将GFMs拆解为主干架构、预训练策略与适配机制三个关键组成部分,为理解不同设计方案提供系统化视角,并支持方法的可组合性。 * 分类体系与全面综述(第5、6、7节):提出基于泛化能力范围的三分类体系:通用GFMs、领域特定GFMs与任务特定GFMs,并在每类下展开系统文献综述,介绍其设计理念与代表性模型。 * 理论基础(第8节):探讨GFMs的理论支撑,包括扩展法则、可迁移性理论,以及关于图预训练泛化能力的新兴理解,为其实证成功提供理论基础。 * 资源与GitHub仓库(第9节):为促进可复现性和研究加速,我们整理并发布了一个资源库,涵盖基准数据集、开源实现、预训练模型以及动态更新的GitHub项目:https://github.com/Zehong-Wang/Awesome-Foundation-Models-on-Graphs * 开放问题(第10节):总结GFMs发展中尚待解决的关键问题,包括:异构图对齐的有效机制、可扩展与高效的适配方法、鲁棒的评估协议以及更深入的理论理解,这些问题为下一代通用图学习系统的发展指明方向。

图基础模型未来发展方向概述。 尽管GFMs取得了初步进展,其整体仍处于早期阶段,面临诸多挑战,如可扩展性、数据可用性、评估标准、模型利用以及理论理解等方面。首先,与已建立扩展法则的LLMs和VLMs不同,GFMs需开发更具扩展性的架构、高层次的生成目标及统一的学习实例以实现性能跃迁。其次,图数据的稀缺性亟需通过自动化采集、高保真合成生成和质量导向的数据集构建策略加以解决。第三,GFMs的评估需要反映真实世界任务的基准,以及能全面衡量泛化性、鲁棒性与可信度的指标。第四,GFMs的高效利用有赖于优化适配机制(如零样本学习与提示式学习)、拓展传统图任务之外的高影响应用场景,并融合多模态知识表示。最后,理论基础仍待深化,关键问题包括转移性的极限、跨域模式冲突的解决方案、分布偏移下的鲁棒性保障,以及泛化能力的理论保证。解决这些问题对于GFMs在多领域充分发挥潜力具有决定性意义。更多讨论详见第10节。