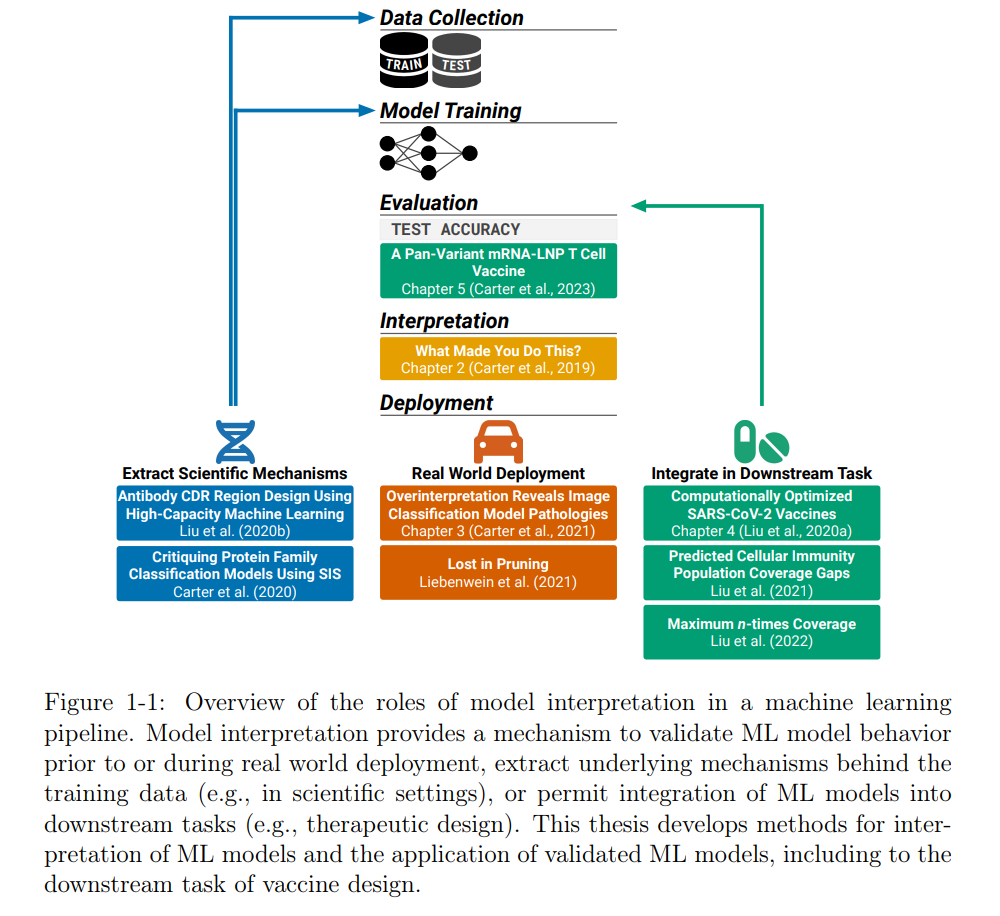

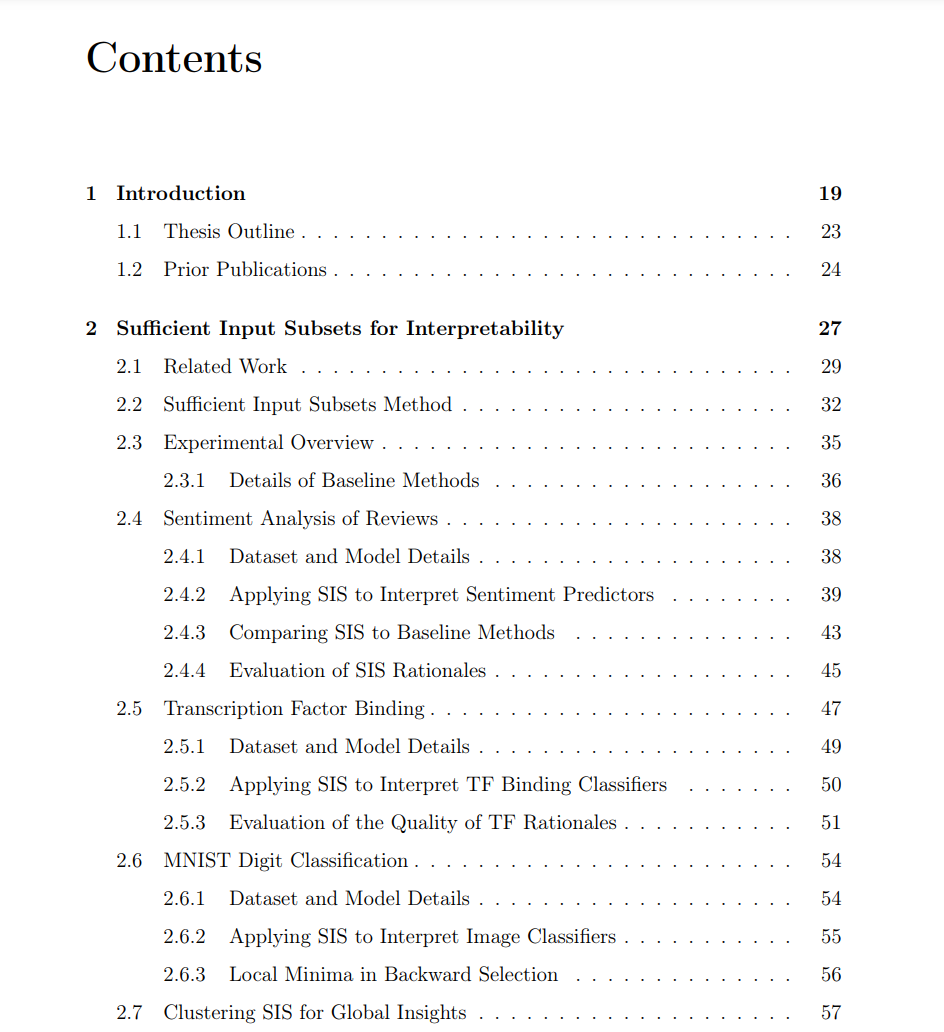

我们引入了一个解释黑盒机器学习(ML)模型的框架,发现深度神经网络的一个失败模式是过度解释,并讨论如何应用ML方法进行治疗设计,包括面向所有变种的COVID-19疫苗。尽管ML模型被广泛部署并经常获得比传统方法更高的准确性,但深度学习模型在功能上很复杂且难以解释,限制了它们在高风险环境中的应用。除了更安全的部署外,模型解释还有助于科学发现,经过验证的基于实验数据训练的ML模型可以用来揭示生物机制或通过生物上真实的目标函数设计治疗方法,如疫苗的人群覆盖。对于解释黑盒ML模型,我们引入了一个与模型无关、忠实于基础函数并且概念上直观的方法,称为“**足够的输入子集”(SIS)**方法。

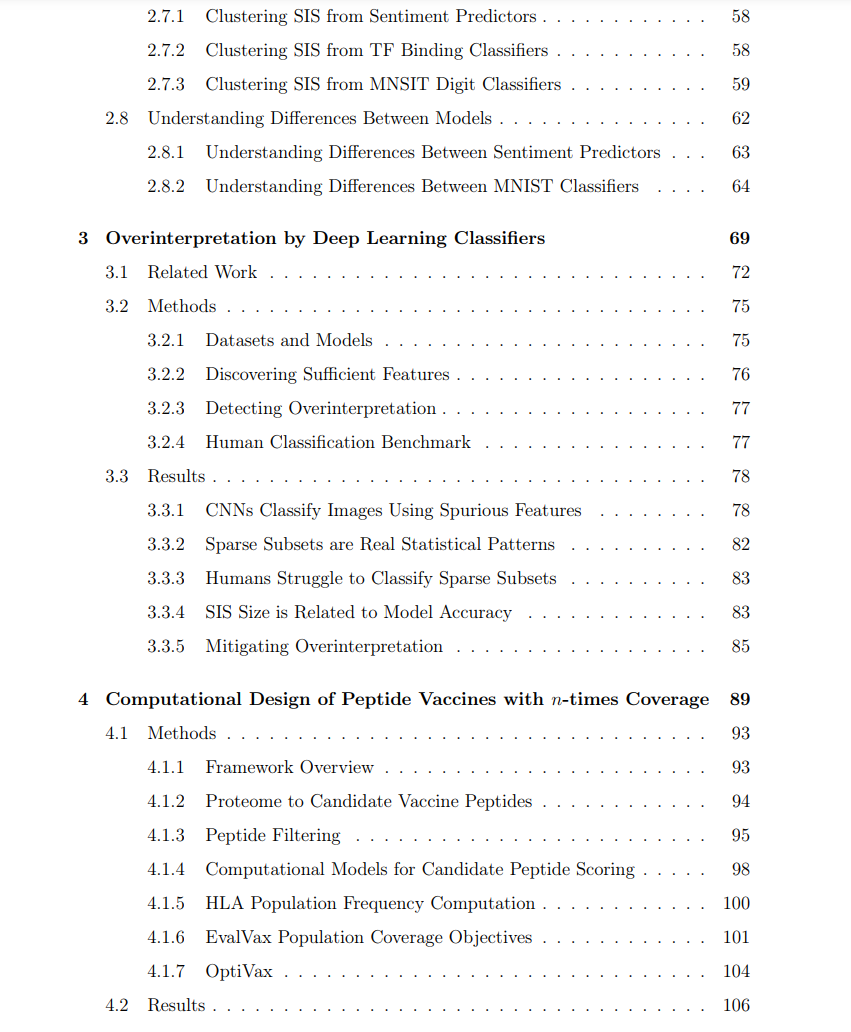

我们用SIS在自然语言、计算机视觉和计算生物学环境中演示了ML模型的解释。使用SIS框架,我们发现了深度神经网络的一个新的失败模式——过度解释,这可能会妨碍在实际环境中的泛化能力。我们认为过度解释是由于训练数据集中存在退化信号引起的。接下来,使用已与实验性免疫原性数据校准的ML模型,我们开发了一个用于计算设计稳健肽疫苗的灵活框架。我们的框架优化了每个人群中的𝑛次覆盖率,以激活更广泛的T细胞免疫反应,考虑到个体之间肽免疫原性的差异,并减少由突变导致的疫苗逃逸的机会。使用这个框架,我们设计了对SARS-CoV-2的疫苗,其人群覆盖率优于已发布的基线并在关注的变种中得到保留。我们通过我们的疫苗在体内对COVID-19进行的动物挑战研究验证了这种方法。这篇论文展示了模型解释如何使ML方法能够在生物环境中忠实部署的不同方式。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日

Arxiv

85+阅读 · 2023年3月21日