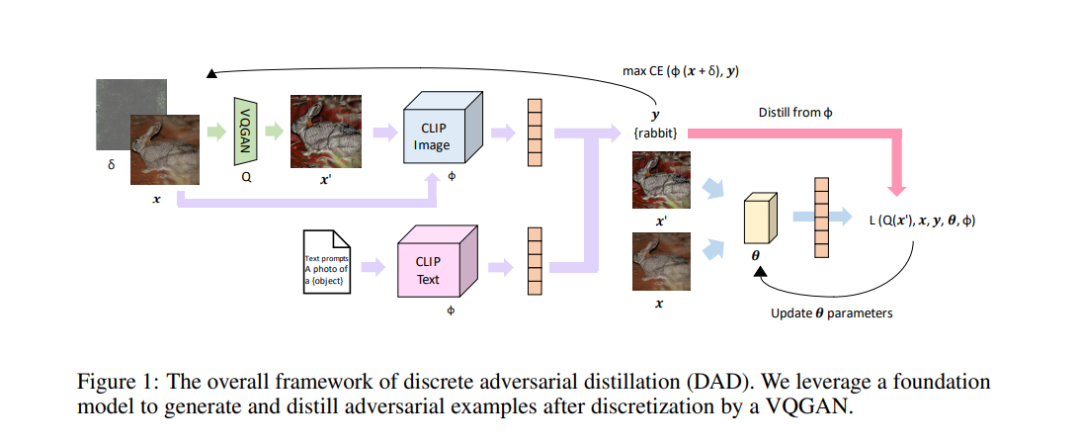

我们提出了一个概念上简单且轻量级的框架,通过结合知识蒸馏和数据增强来提高视觉模型的鲁棒性。我们解决了更大模型并不意味着更好的教师这一猜想,通过展示从预训练基础模型进行蒸馏时对于分布外鲁棒性的显著增益。基于这一发现,我们提出了离散对抗蒸馏 (DAD),它利用一个鲁棒的教师生成对抗样本,并使用VQGAN对它们进行离散化,从而创造出比标准数据增强技术更有信息量的样本。我们为在知识蒸馏与数据增强环境下使用鲁棒教师提供了一个理论框架,并展示了在不同学生架构上对于分布外鲁棒性和干净准确性的显著增益。值得注意的是,与类似技术相比,我们的方法只增加了微小的计算开销,并且可以轻松地与其他数据增强结合以进一步提高效果。

https://www.zhuanzhi.ai/paper/c7185589ae7c0b1f8eca923294cb1470

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

218+阅读 · 2023年4月7日

Arxiv

84+阅读 · 2023年4月4日

Arxiv

148+阅读 · 2023年3月29日