这项具有前瞻性的研究探索了大语言模型(LLM)生成式人工智能(GAI)在国土安全项目计划中的应用,调查了其在增强对复杂挑战的适应性和响应能力方面的潜力。本研究通过文献综述、专题分析以及在一个虚构的训练辖区内进行实际规划和演习开发实验,来评估 LLM 的有效性。根据标准和最佳实践制定的分级评分标准对 LLM 的产出效果进行了分类。结果表明,尽管 LLM 提供了支持,特别是在演习设计方面,但其应用取决于提示开发、训练数据和场景人力输入的质量。该研究提倡谨慎采用策略,强调伦理考虑、持续评估和分解复杂任务以优化 LLM 输出的重要性。建议包括利用人工智能执行数据密集型任务,定义人工智能协作以提高决策和创造力,并使用新开发的LLM人工智能审议实施框架来指导人工智能项目集成的政策复杂性。这项工作阐明了国土安全领域中人工智能与人类能力之间微妙的相互作用,为人工智能改造和增强计划的潜力提供了一个视角,同时告诫人们不要过度依赖技术而牺牲人类的判断力。

本研究探讨了 LLM 在加强国土安全行动方面的潜力。评估了生成式人工智能工具为国土安全从业人员提供支持、优化国土安全领域工作流程的能力。通过细致的研究设计(包括文献综述、专题分析和实际实验),本研究以国家战备系统的六个组成部分为基础,调查了将 LLM融入国土安全的情况。这些组成部分包括风险识别和评估、能力需求估计、建设和维持能力、计划提供能力、以及验证这些能力。LLM的先进能力提供了超越传统作战挑战的机会,促进建立一个适应性更强、反应更迅速、复原能力更强的备灾框架。

LLM有可能彻底改变国土安全,提高对复杂挑战的适应性和响应能力。然而,要最大限度地发挥这些优势,就必须克服人工智能(AI)集成在伦理、技术和财务方面的挑战。本研究主张采取谨慎的采用策略,强调在不断研究完善应用、提高透明度并确保在敏感环境中负责任地使用人工智能的同时,还需要制定模型训练指南和伦理考虑因素。生成式语言模型(GLM)领域,尤其是 ChatGPT,技术发展迅速,不断重新定义这些模型的能力和局限性。这种快速发展要求采用适应性强的研究方法,并对 GLM 在国土安全应用中的适用性进行持续评估。值得注意的是,从 GPT-3 到 GPT-4,通过改进语言理解能力和上下文意识,这些模型在复杂规划和演习场景中的功能得到了显著增强。

研究方法包括为 LLM创建有效提示,执行实验以衡量其在模拟国土安全场景中的实用性,以及分析结果以收集可操作的见解。这一探索是在“中央城”(Central City)这一虚构的训练辖区内进行的,它为实际评估提供了统一的操作环境。为应对这些挑战,介绍了一个强大的验证框架,强调了持续评估的必要性,以及整合专门特定场景数据集以增强 LLM 输出的必要性。设计有效提示对于利用 GPT 模型的能力至关重要,它直接影响到所生成输出的相关性、准确性和国土安全目的的可操作性。娴熟的提示开发对于最大限度地发挥 GLM 的优势,同时最大限度地降低相关风险和不准确性至关重要。因此,本研究使用了两个用户定制的 GPT,专门用于计划制定和演习设计。研究强调了在国土安全背景下,定制提示在从 ChatGPT 等 LLM中提取准确、相关的回答方面所起的关键作用。研究指出,LLM 的有效性在很大程度上取决于提示的质量,这就强调了最初人工监督的必要性。

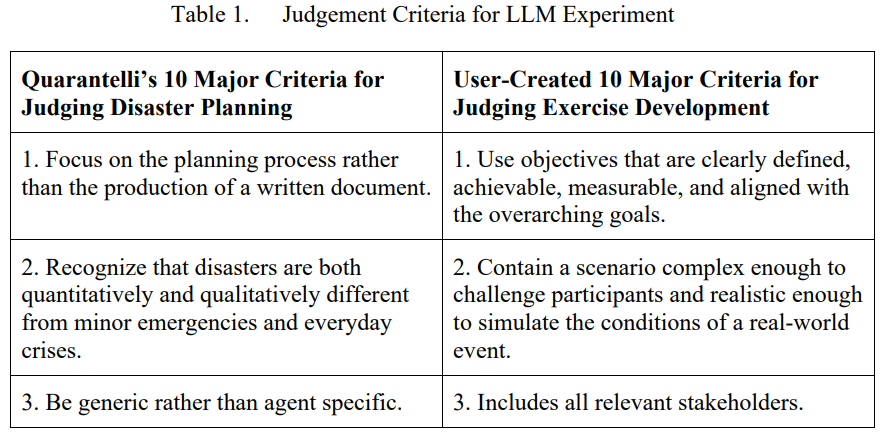

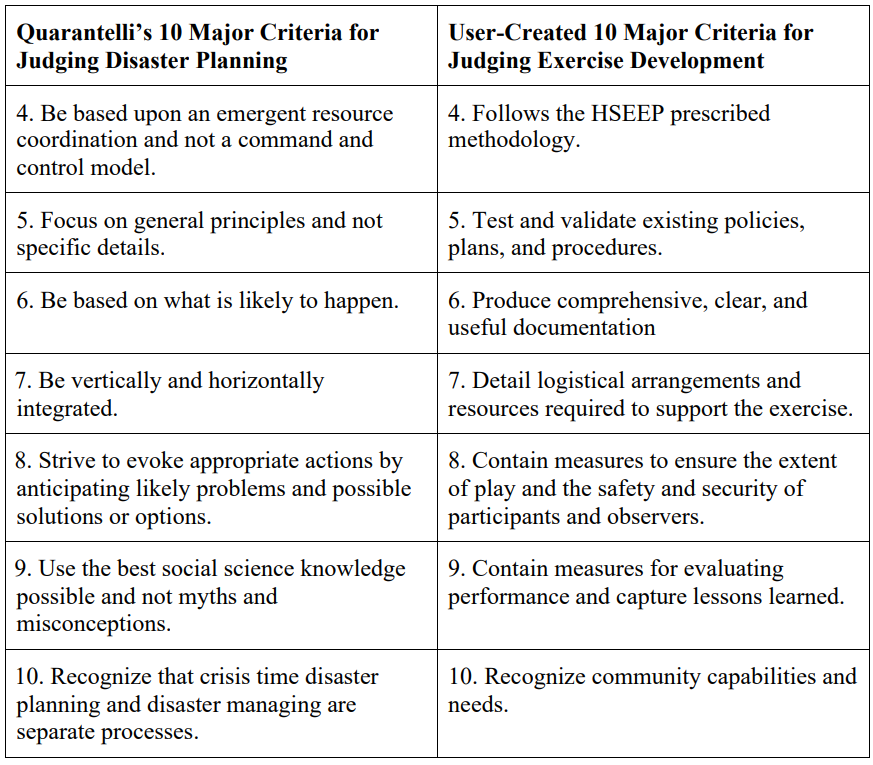

需要制定标准,将 LLM 生成的内容与公认的标准和最佳实践进行比较,以衡量研究结果的准确性、可靠性和实用性。研究选择了 Quarantelli的“判断灾难规划的 10 个主要标准”和一套新颖的“判断演习开发的 10 个主要标准”,这套标准源自国土安全演习和评估计划。研究表明,GPT 模型为国土安全规划和演习开发提供了宝贵的支持。在规划场景中,GPT 在一致性和缺乏局部细节方面面临重大挑战,即使提供了所需的背景信息也是如此。GPT 模型在演习设计中表现较好。在演习设计中,更多的通用场景输出是有价值的,而不是被严格审查的。如果引导得当,GPT 在创建“事件场景总清单”(MESL)方面表现出色,展示了其固有的创造力。建议采用的方法是将 GPT 的创新与国土安全专业人员的专业知识相结合,形成合力,改进规划流程,为应急场景制定切实可行的战略。由于 GPT 无法进行分级规划,研究建议将复杂的任务分解成较小的、相互关联的组成部分,由定制的 GPT 模型来解决,从而克服障碍。这种模块化方法完善了人工智能在国土安全功能方面的特殊性,提高了其产出的质量和相关性。

在正在进行的国土安全计划中采用GLM功能,有可能不断提高国土安全能力。通过对训练演习、真实场景和绩效评估的持续数据投喂,LLM可确定优势和需要改进的领域,确保对新信息和不断变化的情况的适应性和响应能力。采用 LLM 能力标志着国土安全计划管理将从目前的年度迭代流程转向更高效、实时、数据驱动的国土安全计划管理。从加强风险评估到优化能力开发,LLM 都有望成为通过即时趋势分析应对威胁的变革性方法。然而,人工智能幻觉和产生偏见或有害内容等固有风险必须谨慎管理。要降低这些风险,就必须完善训练数据,建立健全的验证流程,并在国土安全领域开发和部署这些技术时考虑伦理因素。要在国土安全领域有效使用生成式语言模型,平衡通用性和特殊性至关重要。实现这种平衡可确保模型在有效应用其广泛知识的同时,还能提供准确的、针对具体情况的响应,这对满足国土安全项目的细微要求至关重要。将生成语言模型纳入国土安全领域既是机遇也是挑战。这些模型有望为该领域带来革命性的操作效率,但同时也带来了有关不准确性、伦理考量和不断变化的技术能力等问题。

本研究设想了这样一个未来:人工智能驱动的流程与人类的专业知识协同合作,共同应对多方面的威胁和挑战。研究提出了两种将人工智能整合到国土安全领域的战术模式:在数据密集型任务中利用人工智能,同时将复杂的分析和战略功能留给人类专家;或者采用无缝的人类-人工智能合作模式,以增强决策和创造力。这两种战术策略并不相互排斥,旨在将人工智能的计算优势与人类宝贵的洞察力和适应性相结合。缺乏新颖的预见性和前瞻性是国土安全领域完全实现人工智能自动化的致命伤。神经网络是现代人工智能(包括生成语言模型)的关键,当遇到超出其训练范围的数据或情况时,神经网络就会受到限制,影响其在国土安全等不可预测领域的功效。许多国土安全威胁的快速出现凸显了人工智能系统在没有人工干预的情况下有效运行的不足,因为它们依赖于预先存在的数据进行决策。从数据模式中得出的输出结果,而不是对基本原理或逻辑的理解,不足以进行独立决策。

最后,这项工作为 LLM 人工智能提供了一个慎重的实施框架,以驾驭人工智能集成的复杂性。这一工具有助于评估人工智能应用的适宜性,同时考虑到使用范围和根本性的变革水平。该框架严格评估风险和机遇,确保人工智能在战略上符合伦理标准和业务目标。它倡导一种平衡的方法,利用人工智能提高具体效率和创新,同时保持人类专业知识在决策过程中的关键作用。这项工作阐明了国土安全领域中人工智能与人类能力之间微妙的相互作用。从平衡的角度阐述了人工智能改造和加强项目的潜力,同时告诫人们不要过度依赖技术而牺牲人的判断力。这项工作为将人工智能有效融入国土安全战略提供了路线图,确保技术成为人类专业知识的补充而非替代。