思维链(CoT)已经成为一种广泛采用的提示方法,激发了大型语言模型(LLMs)的印象深刻的推理能力。受CoT的连续思维结构的启发,已经开发了许多针对CoX(X链)的方法,以应对涉及LLMs的不同领域和任务中的各种挑战。在本文中,我们提供了一个全面的关于LLMs在不同情境下的CoX方法的综述。具体来说,我们根据节点的分类,即CoX中的X,以及应用任务对它们进行分类。我们还讨论了现有CoX方法的发现和含义,以及潜在的未来方向。我们的综述旨在为寻求将CoT理念应用于更广泛场景的研究人员提供一个详细且最新的资源。

大型语言模型(LLMs)在使用思维链(CoT)方法提示时表现出强大的推理能力(Wei et al., 2022; Yao et al., 2024; Besta et al., 2024a)。CoT的本质是将复杂问题分解为一系列中间子任务(Chu et al., 2023; Zhou et al., 2023)。通过逐步处理这些子任务,LLMs能够关注重要的细节和假设,这大大提高了它们在广泛推理任务中的表现(Huang and Chang, 2023; Chu et al., 2023)。此外,CoT的中间步骤提供了一个更透明的推理过程,便于对LLMs的解释和评估(Yu et al., 2023b)。随着CoT的成功,开发了许多X链(CoX)方法(Yu et al., 2023a)。这些方法不仅限于推理思维,最近的CoX方法还构建了包含各种组件的链,如反馈链(Lei et al., 2023; Dhuliawala et al., 2023)、指令链(Zhang et al., 2023d; Hayati et al., 2024)、历史链(Luo et al., 2024; Xia et al., 2024d)等。这些方法已被应用于解决涉及LLMs的多样化任务中的挑战,包括多模态交互(Xi et al., 2023a; Zhang et al., 2024a)、幻觉减少(Lei et al., 2023; Dhuliawala et al., 2023)、基于LLM的代理规划(Zhan and Zhang, 2023; Zhang et al., 2024c)等。

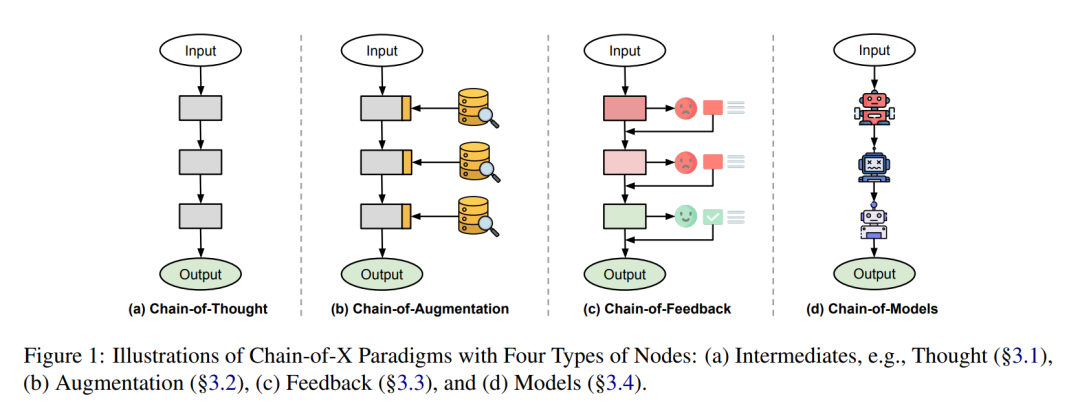

尽管这些CoX方法的普及度不断提高,但它们尚未被集体审查或分类,我们对它们的潜力和细微差别的理解还存在差距。为此,本综述旨在提供一个结构化概览,捕捉CoX方法的本质和多样性,以便进一步探索和创新。虽然几项综述已经探讨了CoT(Chu et al., 2023; Yu et al., 2023b; Besta et al., 2024b),它们主要关注不同结构的推理思维,例如图1(a)所示的思维链。与此相反,本文关注的是如图1所示,超越推理思维的多面向组件设计的X链,提供CoT概念在更广泛领域的见解。我们通过CoX中的X的分类和应用这些方法的任务来呈现一个全面的综述。综述概览首先提供思维链的背景信息并定义X链为其概括(§2)。接下来,我们根据用于构建链的组件类型对CoX方法进行分类(§3)。此外,根据这些CoX方法的应用领域,我们按任务对它们进行分类(§4)。然后,我们讨论现有CoX方法的见解并探索潜在的未来方向(§5)。综述的详细结构在图2中呈现。

什么是X链?

在本节中,我们首先介绍一些关于思维链(Chain-of-Thought,CoT)提示的背景信息,然后定义一个广义的X链(Chain-of-X,CoX)概念。

思维链(CoT)提示是一种方法论,能显著增强大型语言模型(LLMs)的推理能力。CoT由Wei等人(2022)引入,涉及以结构化的格式<input, thoughts, output>提示LLMs,其中“thoughts”包括通向最终答案的连贯的中间自然语言推理步骤。CoT在需要复杂推理的任务中效果最为显著。传统的少样本学习方法在这类场景中经常会失败,因为它们倾向于直接提供答案而不包括必要的中间步骤。Rae等人(2021)强调了这一局限性,指出这些方法随着模型大小的增加而显得不足。相比之下,CoT提示通过融入中间推理步骤而表现出色。这些步骤通过逻辑推进引导模型,增强其解决算术、常识和符号推理等复杂问题的能力(Wang等人,2023d;Lyu等人,2023)。CoT的本质在于通过将复杂问题分解为可管理的中间步骤来解决问题(Zhou等人,2023)。Kojima等人(2022)也展示了通过提示“让我们一步一步思考。”的零样本CoT的强大性能。明确的推理步骤还为模型的思考过程提供了一个透明的路径,允许进一步的评估和纠正(Yu等人,2023b)。 受CoT的顺序分解特性启发,最近开发了大量的X链(CoX)方法(Yu等人,2023a)。在这里,我们将CoX定义为CoT方法的一种广义形式,用于超越LLM推理的多样化任务。我们将CoX中的X称为链结构的“节点”。除了CoT提示中的思考外,CoX中的X可以采取针对特定任务定制的各种形式,包括中间件(§3.1)、增强(§3.2)、反馈(§3.3)甚至模型(§3.4),如图1所示。我们在图2中总结了现有CoX方法中的节点类型。CoX的想法是构建一个与问题相关的组件序列,这些组件要么组合贡献解决方案,要么迭代精炼复杂任务的输出。同样,我们为CoX定义了一个结构化格式<input, X1, ..., Xn, output>,其中n是链的长度。请注意,这种格式超越了像CoT这样的提示策略,可以适应多种算法框架或结构,用于涉及LLMs的多样化任务。例如,验证链(Chain-of-Verification,Dhuliawala等人,2023)是一个幻觉减少框架,使用LLM生成初始响应,构建一系列验证问题,并根据这些问题修订其先前的响应。除了减少幻觉外,CoX方法还被应用于多种任务,如图2所示,包括多模态互动(§4.1)、事实性与安全(§4.2)、多步骤推理(§4.3)、指令跟随(§4.4)、LLMs作为代理(§4.5)和评估工具(§4.6)。

结论

本综述探讨了基于思维链概念构建的X链方法。通过根据节点和任务对它们进行分类,我们提供了一个全面的概览,突出了CoX在增强大型语言模型(LLMs)能力方面的潜力,并为未来研究开辟了新的途径。通过这项综述,我们旨在激发对LLMs的X链范式进行更深入理解和更有创造性使用的进一步探索。