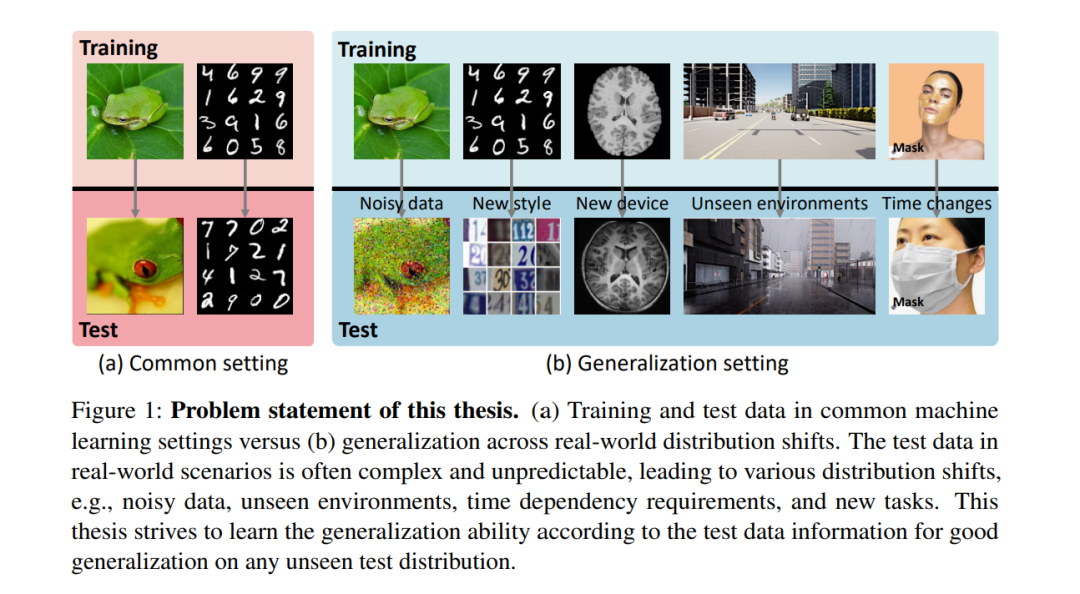

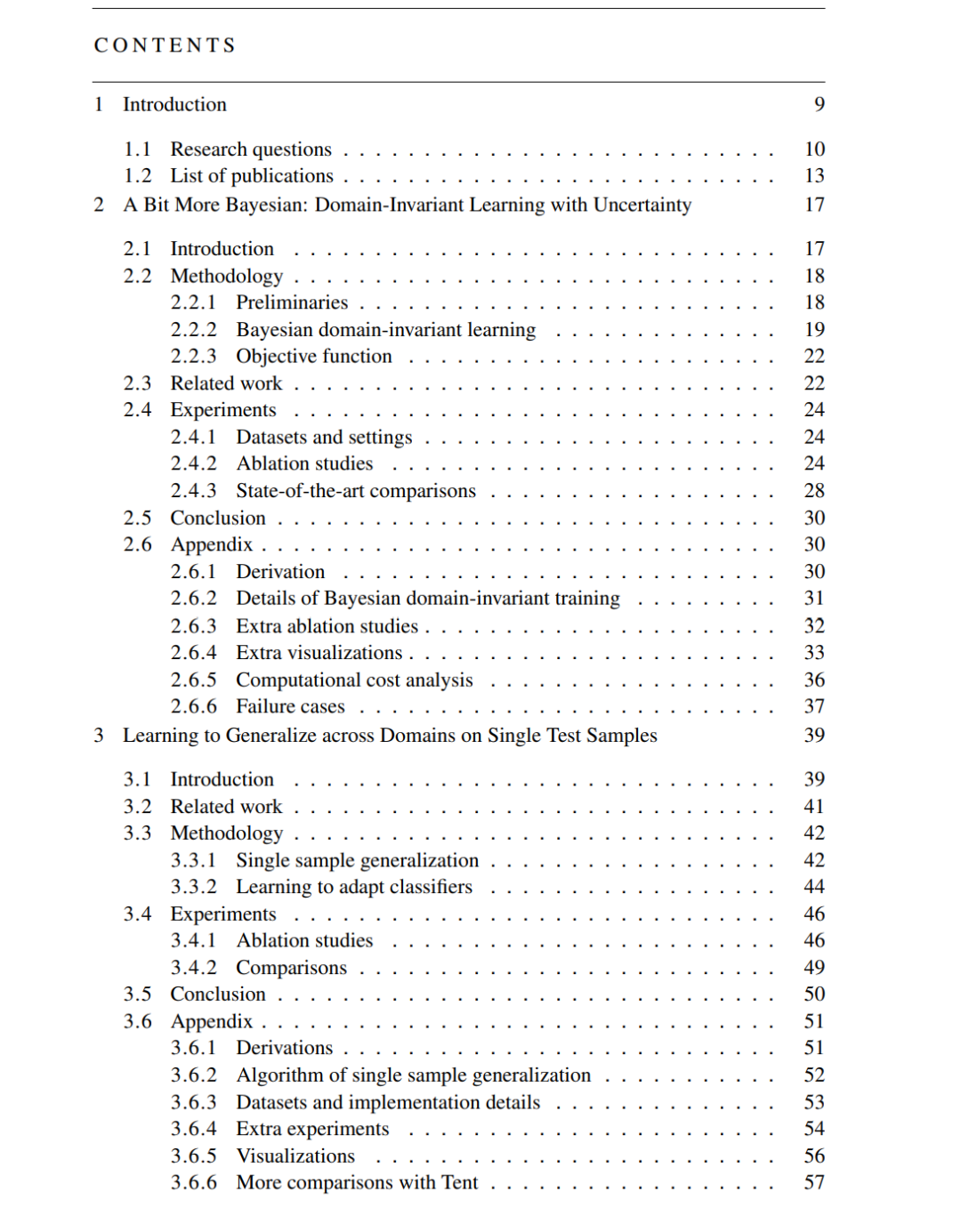

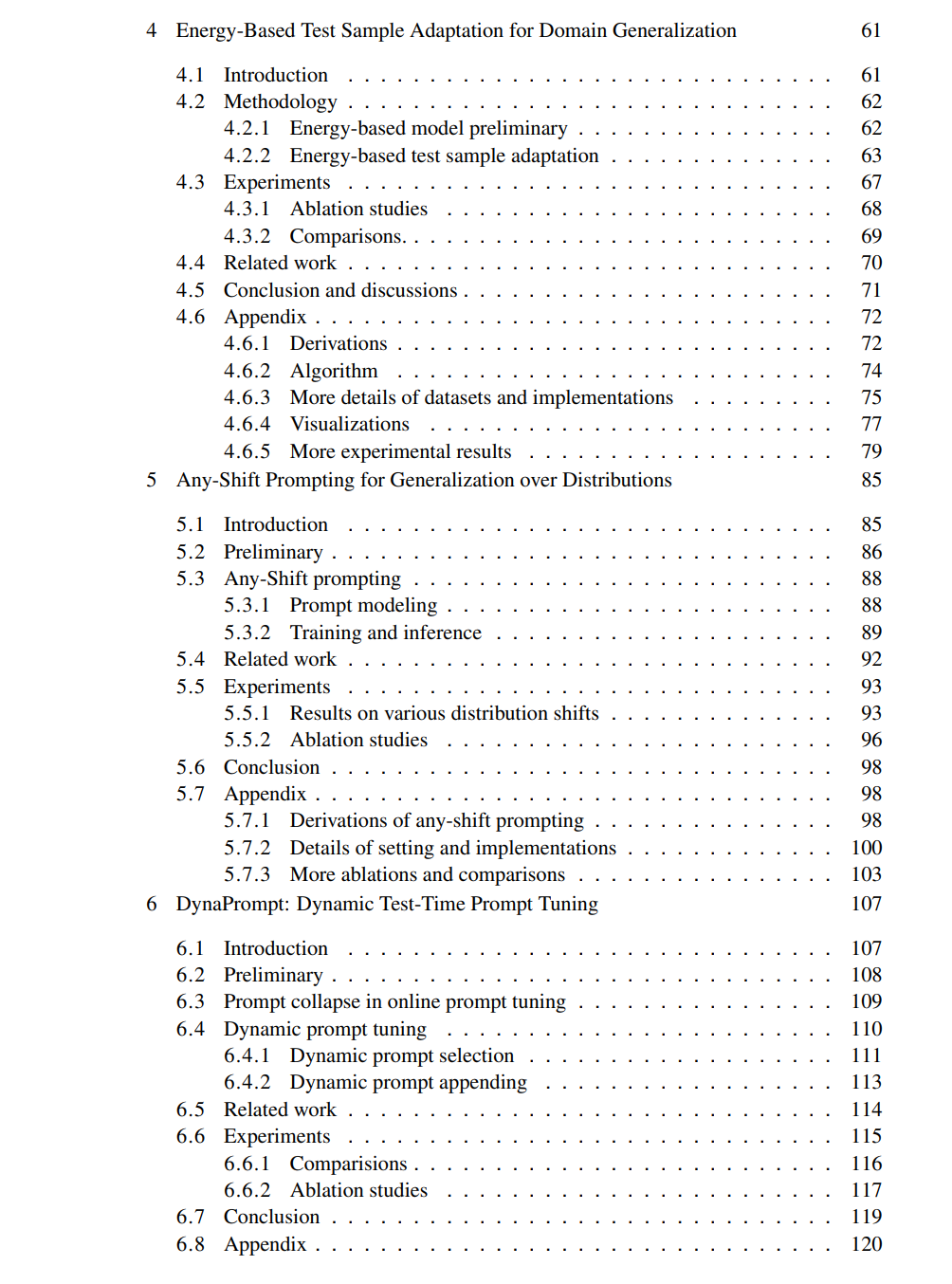

泛化能力是将已学到的知识从已见的上下文有效应用到不熟悉的情况中的能力,它是人类智能的标志,但对于当前的人工智能系统来说,仍然是一个重大挑战。机器学习算法通常依赖于训练数据和测试数据共享相同分布的假设。因此,当面对分布变化时,它们会表现出显著的性能下降。本论文解决了提升泛化能力的关键问题,特别是在测试时增强泛化能力,而在训练过程中无法访问测试数据。论文的结构如下:1) 通过贝叶斯神经网络的不可变学习,在训练时进行广义模型学习;2) 通过元学习和变分推理技术,在测试时直接调整模型以适应个别测试样本,而不依赖于标签和额外的测试信息;3) 通过能量基模型,将测试样本适应到训练分布,在测试时进行广义样本学习,避免模型调整和灾难性遗忘;4) 通过创新的提示学习框架,在测试时为多模态基础模型进行广义提示学习,包括在任何分布变化下生成特定测试任务的提示,并进行动态测试时提示调优,以实现在线提示更新。每一章都介绍了创新的方法,详细的理论和实验结果,提出了一种全面的方法来提高测试时的泛化能力。最后,我们进一步探讨了过去和未来的测试时泛化,并提供了一个关于测试时适应性的全面系统性回顾,总结了测试时泛化的进展,并展望未来的发展方向。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

213+阅读 · 2023年4月7日

Arxiv

81+阅读 · 2023年4月4日