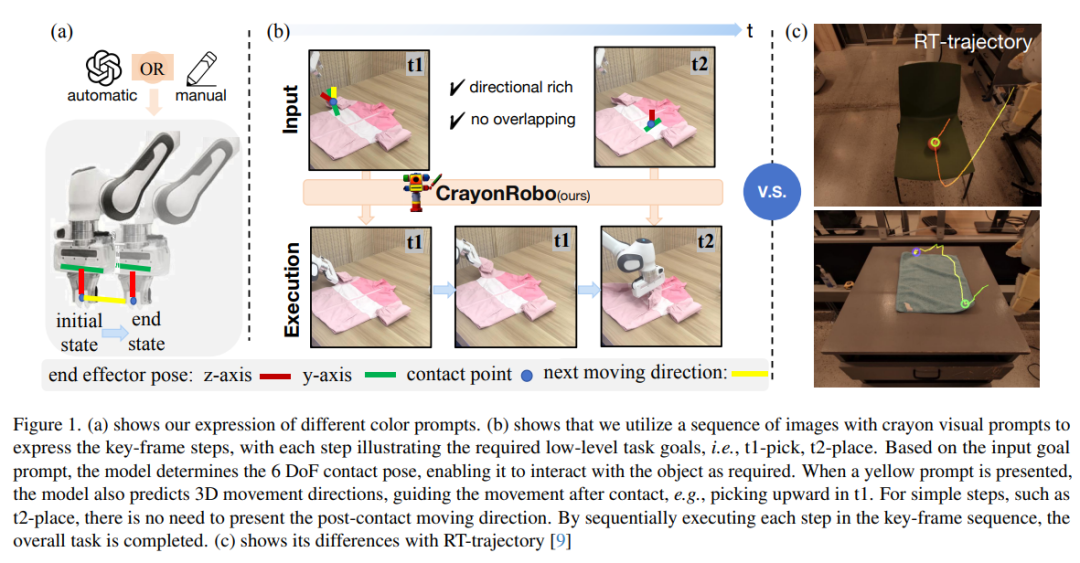

在机器人操作中,任务目标可以通过多种模态传达,例如自然语言、目标图像或目标视频。然而,自然语言往往存在歧义,而图像或视频则可能提供过于细节化的指令。为应对这些挑战,我们提出了 CrayonRobo ——一种以对象为中心、提示驱动的视觉-语言-动作模型,能够以简洁的方式明确表达低层级动作与高层级任务规划。 具体而言,对于任务序列中的每一个关键帧,我们的方法支持在 RGB 图像上手动或自动生成简单而富有表现力的二维视觉提示。这些提示代表了具体的任务目标,例如末端执行器的姿态以及接触后的期望移动方向。 我们还设计了一种训练策略,使模型能够理解这些视觉-语言提示,并在 SE(3) 空间中预测相应的接触姿态与移动方向。通过顺序执行所有关键帧步骤,模型能够完成长时间跨度的任务序列。该方法不仅使模型能够更清晰地理解任务目标,还通过提供可解释的提示显著提升了其在未知任务场景中的鲁棒性。 我们在模拟环境与现实机器人平台中对该方法进行了评估,结果表明其具备强大的操控能力与良好的泛化性能。

成为VIP会员查看完整内容

相关内容

Arxiv

38+阅读 · 2023年4月19日

Arxiv

206+阅读 · 2023年4月7日

Arxiv

141+阅读 · 2023年3月29日