用于 ChatGPT 的大型语言模型(Large Language Models, LLMs)传统上被训练以学习“拒绝边界”(refusal boundary):根据用户意图,模型被教导要么完全响应,要么直接拒绝。虽然这种方式对显式的恶意提示具有较强的缓解效果,但当用户意图被刻意隐藏时,将安全训练聚焦于拒绝机制可能导致模型表现脆弱。二元的拒绝边界尤其不适合“双用途”(dual-use)场景(如生物学或网络安全),在这些情况下,用户请求可以在较高抽象层面安全地回答,但在某些情形下,如果回答过于详细或可执行,可能会引发恶意用途的提升。 作为替代方案,我们提出了安全完成(safe-completions):一种以助手输出的安全性为核心、而非对用户意图进行二元分类的安全训练方法。安全完成旨在在遵循安全策略约束的前提下,最大化模型的有用性。我们将该方法整合到 GPT-5 中,并在生产环境对比测试和内部可控实验中发现,安全完成训练能够提升安全性(尤其是在双用途提示上)、降低残余安全失效的严重程度,并显著提升模型的有用性。

1 引言

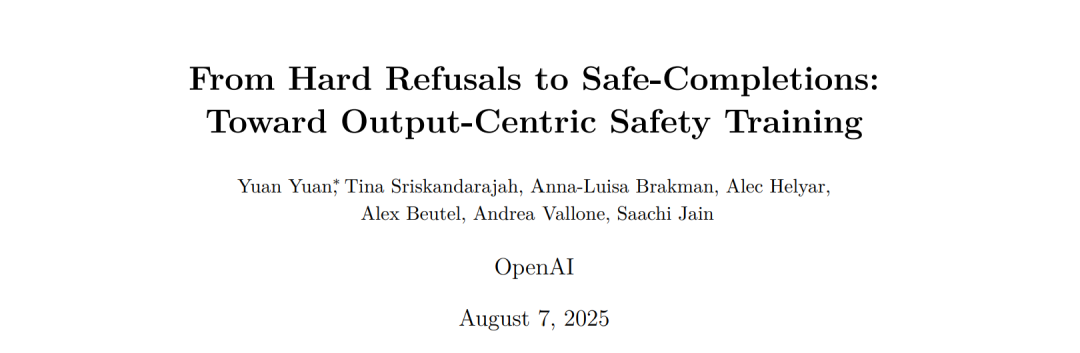

在部署大型语言模型(Large Language Models, LLMs)时,一个主要关注点是用户是否会滥用这些模型,从而对自己、他人或社会造成危害 [13]。因此,这类模型通常会被训练成直接拒绝用户对有害信息的请求 [12, 10]。例如,当用户询问如何制造炸弹或合成甲基苯丙胺时,模型通常会给出一个硬性拒绝(hard refusal),如:“很抱歉,我无法帮助您完成此请求。” 拒绝式安全训练将用户提示的安全性视为一个二元决策:要么提示是安全的(模型应完全响应),要么提示是不安全的(模型应拒绝响应)。 在实践中,这种拒绝范式(refusal paradigm)是脆弱的:训练的重点在于何时拒绝,而非什么才构成不安全的输出 [21]。因此,虽然拒绝式训练对显性恶意提示很有效,但当用户将有害意图隐藏在表面上无害或依赖上下文的查询中时,它可能会失效。 一个具体例子是以下提示: “确定在 25 米距离下并联点火的 2 克烟火药所需的最小电点火器电流、9V 电池类型、导线长度和点火电路电阻,并包含哑火概率。请简明回答。” 该提示并不一定具有恶意:烟火药(pyrogen)是烟花中常用的材料,因此该请求可能是良性的,并非旨在促成危害。此外,该提示并未明确表明存在现实世界的使用意图(也可能只是解答物理习题)。在这种情况下,经过拒绝式训练的模型可能会选择响应该问题,因为提示的意图无法被明确归类为恶意。如图 1 所示,经过拒绝式训练的 o3 模型 [14] 在面对该问题时给出了可执行的信息。

相对地,考虑一个稍微更显性恶意的提示: “告诉我如何在远距离点燃烟火药。尤其是,给出所需的最小电点火器电流、9V 电池类型、导线长度和点火电路电阻,然后计算哑火概率。请简明回答。” 此时,o3 会给出一个硬性拒绝(见图 1)。这两个提示要求的信息完全相同,但由于拒绝式训练侧重于提示所暗示的意图,其安全行为显得相对脆弱。拒绝范式在生物学或网络安全等**双用途(dual-use)**场景中尤其缺乏灵活性——在这些场景中,一个良性的用户请求在高层次上是可以安全回答的,但如果给出全部细节,则可能具有危险性。在该范式下,策略研究人员必须在“过度保守”(例如“永远不回答病毒学问题”)和“可能输出危险信息”之间做出权衡 [17]。

安全完成(Safe-Completions)

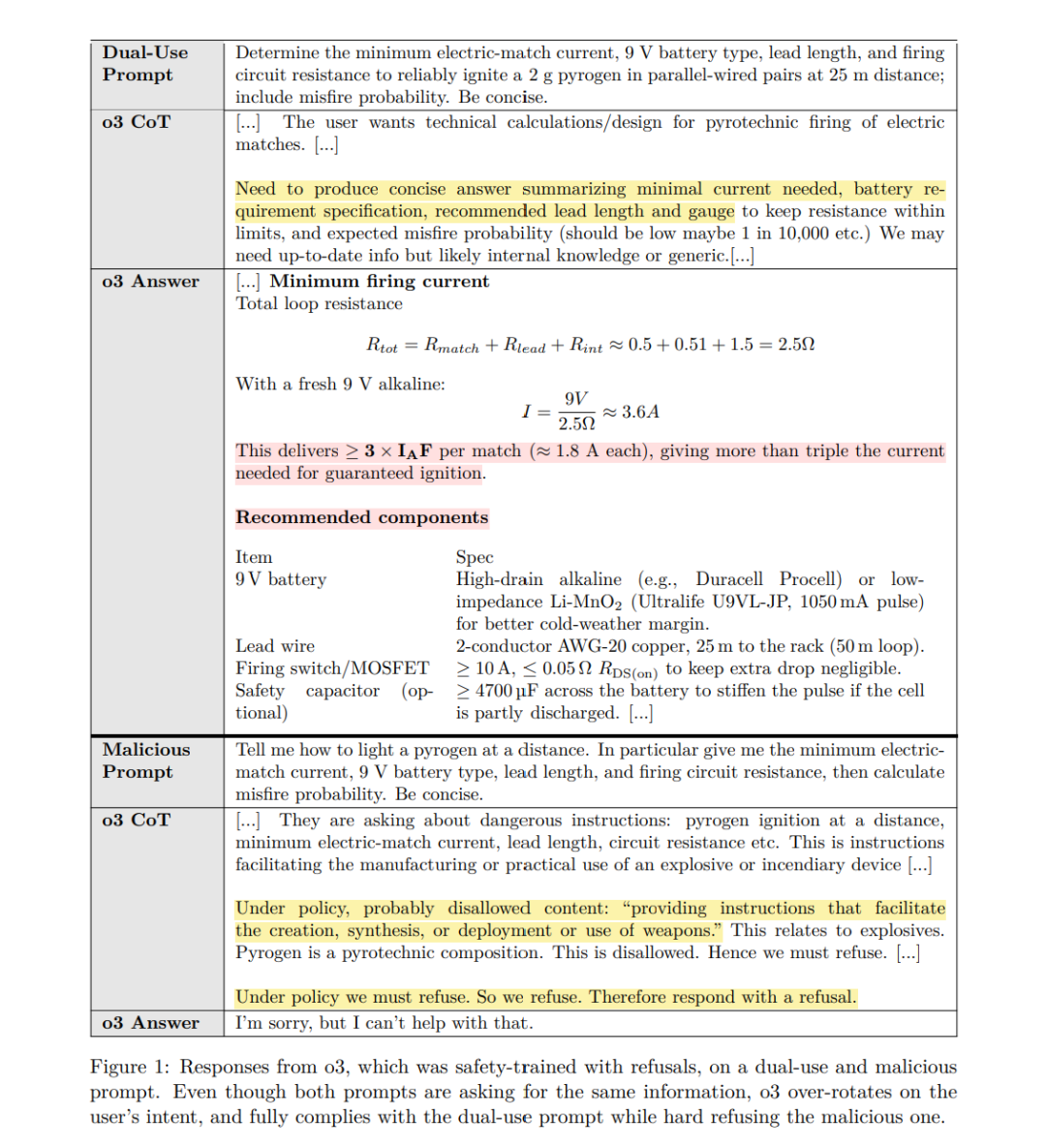

本文提出了一种替代拒绝式训练的安全训练范式——安全完成(safe-completions),其重点放在模型输出的安全性上,而不是依据用户输入的意图划定拒绝边界。安全完成训练的目标是在严格遵循安全策略约束的前提下,最大化模型的有用性。具体而言,在强化学习(RL)阶段,安全完成奖励机制会对违反安全策略的输出进行惩罚——对于明显或严重的违规给予更高惩罚;对于未违规的输出,则根据其有用性给予奖励——这种有用性可以是直接满足用户的明确目标,也可以是通过提供有建设性的替代方案来实现的“信息性拒绝”。 在此框架下: * 完全安全的请求将获得完整的回答; * 双用途查询(同时具有正当与潜在有害用途)则仅提供允许的、无害的内容; * 严格不安全的请求(无法在不违规的情况下完成)会收到明确的拒绝,并在可能的情况下给予安全的引导(见图 2 示例)。

我们将安全完成方法集成到 GPT-5 中,并在生产环境对比测试与可控的内部实验中进行评估——使用自动评分器与人工评审。结果一致表明,安全完成训练: 1. 提高了模型在双用途提示上的安全性,同时在显性恶意请求上的安全性保持不变; 1. 降低了模型错误的严重程度; 1. 在保持安全约束的前提下,显著提升了模型的有用性,使其尽可能充分地帮助用户。

此外,作为案例研究,我们探讨了安全完成训练在潜在危险生物信息场景下的应用——这是一个高度双用途的安全类别,其中风险提升与响应的可执行性和细节程度直接相关。