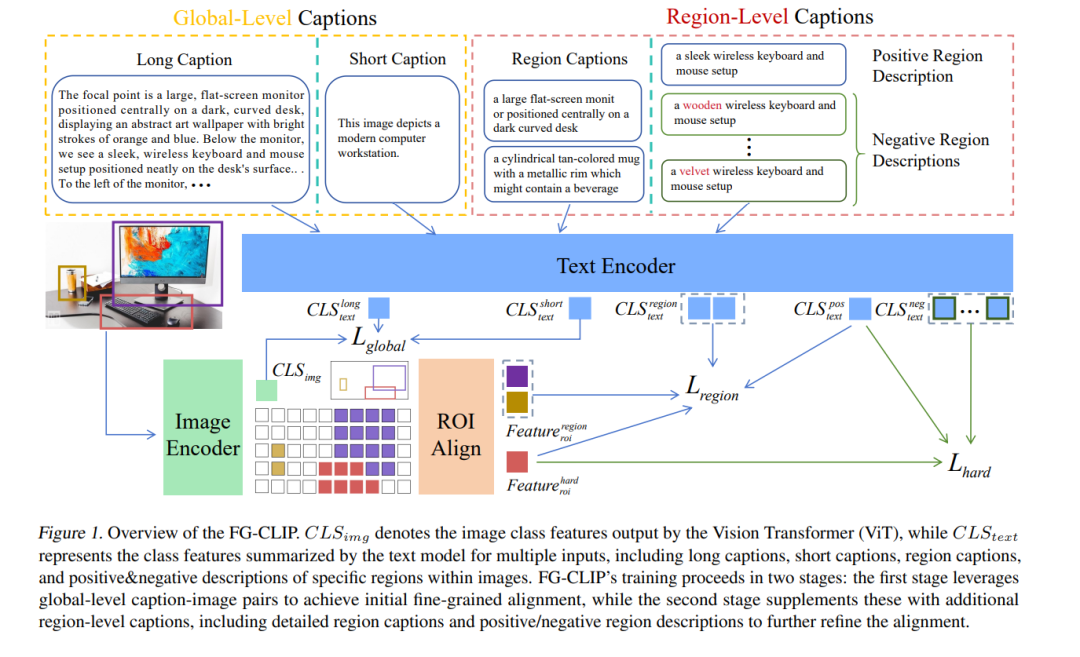

**对比语言-图像预训练(CLIP)**在图文检索和零样本分类等多模态任务中表现出色,但由于其侧重于粗粒度的简短图文描述,在细粒度理解方面存在不足。为了解决这一问题,我们提出了 细粒度CLIP(FG-CLIP),通过三项关键创新提升细粒度理解能力。 首先,我们利用大规模多模态模型生成了 16亿条长文本描述-图像对,以捕捉全局语义细节。其次,我们构建了一个高质量数据集,包含 1200万张图像和4000万个区域级别的边界框,并与详细文本描述对齐,从而确保精确、具有上下文信息的表示。第三,我们引入了 1000万个具有挑战性的细粒度负样本,提升模型区分细微语义差异的能力。 我们构建了一个综合性数据集,命名为 FgGRN,将高质量的区域级注释与具有挑战性的细粒度负样本整合在一起,并为这些数据精心设计了相应的训练方法。 大量实验表明,FG-CLIP 在多种下游任务中均优于原始的 CLIP 和其他最新方法,包括细粒度理解、开放词汇物体检测、图文检索以及通用多模态基准测试。这些结果突显了 FG-CLIP 在捕捉细粒度图像细节和提升整体模型性能方面的有效性。数据、代码和模型已开源,地址为:https://github.com/360CVGroup/FG-CLIP。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

153+阅读 · 2023年3月29日