国际知识发现与数据挖掘大会 (ACM SIGKDD Conference on Knowledge Discovery and Data Mining,简称KDD) 是数据挖掘领域的顶级会议。第28届SIGKDD会议将于8月14日至18日在华盛顿举行。据统计,今年共有1695篇有效投稿,其中254篇论文被接收,接收率为14.98%,Applied Data Science Track录用率为25.90%。

鲁棒时间序列分析及其工业应用

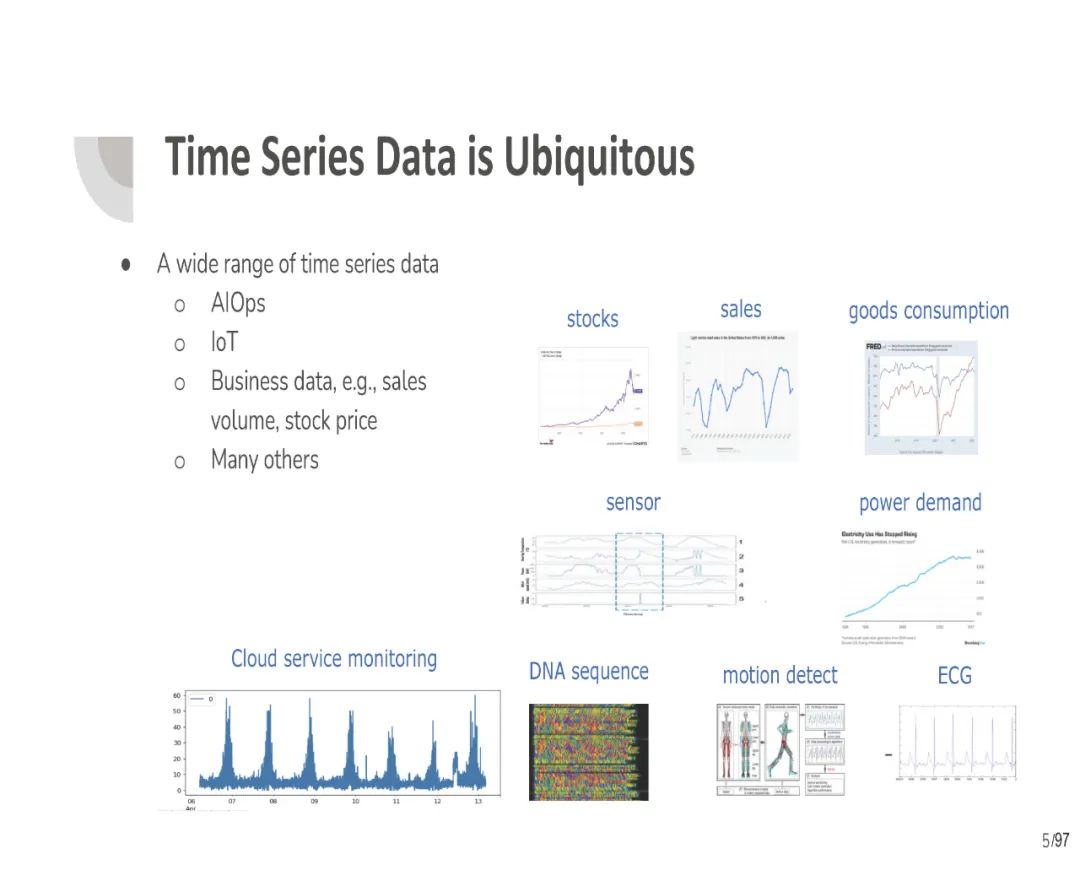

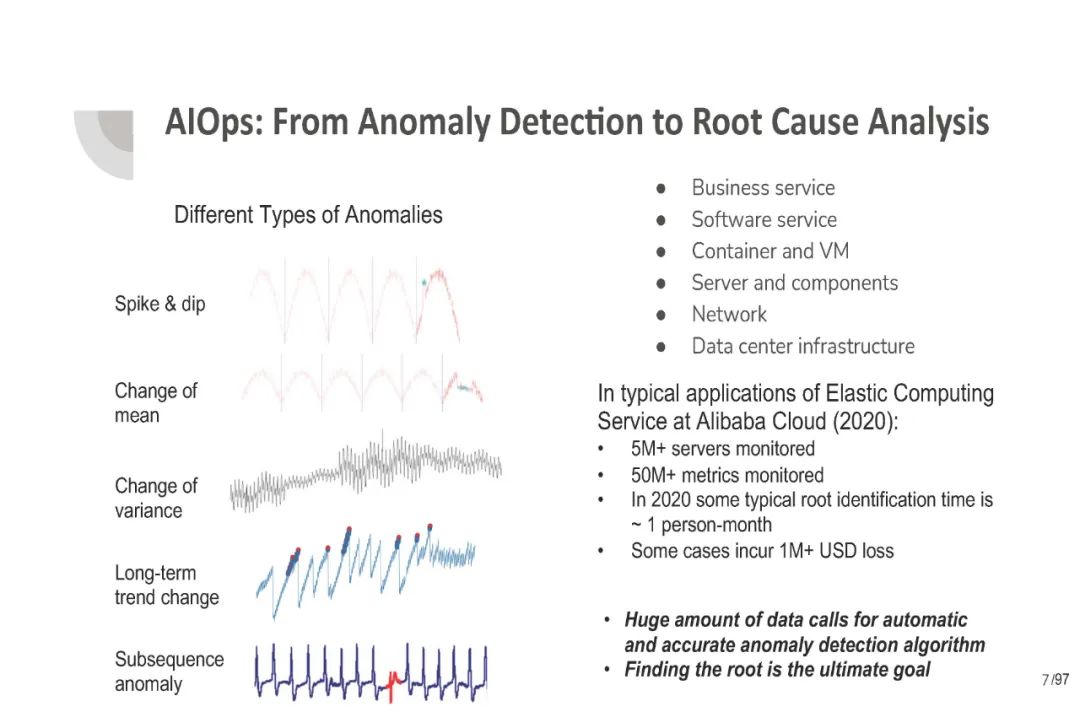

时间序列分析在各个领域都非常普遍和重要,例如云计算中的IT运营人工智能(AI - Intelligence for IT Operations, AIOps)、电子商务中的人工智能(AI-powered Business Intelligence, AI -power Business Intelligence)、物联网人工智能(AI- Intelligence of Things, AIoT)等。在现实世界中,时间序列数据往往呈现出具有趋势、季节性、异常值和噪声的复杂模式。此外,随着越来越多的时间序列数据被收集和存储,如何有效地处理大量的数据在许多应用中是至关重要的。我们注意到,这些重大挑战存在于各种任务中,如预测、异常检测和故障原因定位。因此,如何针对不同的任务设计有效、高效的时间序列模型,使其具有鲁棒性,能够解决上述实际场景中的挑战模式和噪声,具有很大的理论和实践意义。

在本教程中,我们提供了在鲁棒时间序列分析的最先进算法的全面和有组织的教程,从传统的统计方法到最新的基于深度学习的方法。我们不仅将介绍时间序列算法的原理,而且还将提供如何将它们有效地应用于实际的真实工业应用的见解。具体来说,我们将本教程组织在一个自底向上的框架中。我们首先介绍了不同学科的初步成果,包括鲁棒统计、信号处理、优化和深度学习。然后,我们识别并讨论了鲁棒时间序列分析中最常用的处理块,包括周期检测、趋势滤波、季节趋势分解和时间序列相似性。最后,我们讨论了多个时间序列任务的最新进展,包括预测、异常检测、故障原因定位和自动扩展,以及大规模时间序列应用的实际经验教训,从工业的角度。

https://qingsongedu.github.io/timeseries-tutorial-kdd-2022/

目录内容:

- 初始介绍 Preliminaries

- Real-world Challenges and Needs for Robustness

- Robust Statistics: Robust Regression, M-estimators

- Signal Processing: Fourier, Wavelet

- Optimization Algorithms: Alternating Direction Method of Multipliers (ADMM), Majorize-Minimization (MM)

- Deep Learning: RNN, CNN, GNN, Transformer, Data Augmentation for Time Series

- 鲁棒时序处理 Robust Time Series Processing Blocks

- Time Series Periodicity Detection

- Time Series Trend Filtering

- Time Series Seasonal-Trend Decomposition

- Time Series Similarity

- 鲁棒时序应用与实践 Robust Time Series Applications and Practices

- Forecasting: Tree Model, Deep Ensemble, Transformer, and Case Studies

- Autoscaling: Query Modeling, Scaling Decision, and Case Studies

- Anomaly Detection: Decomposition Model, Deep State Space Model, Transformer, and Case Studies

- Fault Cause Localization: Rule Set Learning, Root Cause Analysis, and Case Studies

Further Reading:

- AI for Time Series (AI4TS) Papers, Tutorials, and Surveys [GitHub link]

时间序列Transformer建模综述

Transformers在自然语言处理和计算机视觉的许多任务中都取得了卓越的性能,这也引起了时间序列社区的极大兴趣。在Transformer的众多优点中,捕获长期依赖关系和交互的能力对时间序列建模特别有吸引力,这使得各种时间序列应用取得了令人兴奋的进展。**在本文中,我们系统地回顾了用于时间序列建模的Transformer方案,通过一个新的分类,从两个角度总结了现有的时间序列Transformer,突出了它们的优势和局限性。**从网络改造的角度,总结了时间序列Transformers的模块级适应性和体系结构级适应性。从应用的角度出发,我们根据预测、异常检测和分类等常用任务对时间序列Transformer进行分类。根据经验,我们执行稳健分析、模型规模分析和季节性趋势分解分析,以研究《Transformers》在时间序列中的表现。最后,我们讨论并提出未来的研究方向,以提供有用的研究指导。

https://www.zhuanzhi.ai/paper/8f0056e334c5add24b42ee4e57763f50

由于Transformer在自然语言处理(NLP) [Kenton and Toutanova, 2019]、计算机视觉(CV) [Dosovitskiy et al., 2021]、语音处理[Dong et al., 2018]和其他学科[Chen et al., 2021b]方面的出色表现,其在深度学习方面的创新[Vaswani et al., 2017]最近引起了极大的兴趣。**在过去的几年中,许多Transformer的变种被提出,以大大提高各种任务的最先进的性能。**不同方面的文献综述较多,如NLP应用方面的文献[Qiu et al., 2020;Han et al., 2021], CV applications [Han et al., 2020;Khan等人,2021年;Selva等人,2022年)、高效Transformer [Tay et al., 2020]和注意力模型[Chaudhari et al., 2021; Galassi et al., 2020]。

在时序数据的长距离依赖和交互中,transformer表现出了很强的建模能力,因此在时间序列建模中很有吸引力。由于时间序列数据和时间序列任务的特殊特性,许多Transformer的变体被提出以适应各种时间序列任务中的时间序列数据,如预测[Li et al., 2019; Zhou et al., 2021; Zhou et al., 2022],异常检测[Xu et al., 2022; Tuli et al., 2022],分类[Zerveas et al., 2021; Yang et al., 2021],等等。例如,季节性或周期性是时间序列的一个重要特征[Wen等人,2021a],如何有效地建模长期和短期的时间相关性,并同时捕获季节性仍然是一个挑战[Wu et al., 2021; Zhou et al., 2022]。由于Transformer for time series是深度学习领域的一个新兴领域,对Transformer for time series进行系统、全面的研究将对时间序列学界大有裨益。我们注意到,存在一些关于时间序列深度学习的综述,包括预测[Lim和Zohren, 2021;Benidis等人,2020年;Torres et al., 2021],分类[Ismail Fawaz et al., 2019], anomaly detection [Choi et al., 2021; Blazquez-Garc ´ ´ıa et al., 2021]和数据增强[Wen et al., 2021b],但很少或没有对时间序列的Transformers 进行深入分析。

**在本文中,我们旨在通过总结现有的时间序列Transformers来填补上述空白。**具体来说,我们首先简要介绍了普通的Transformer,然后从网络修改和应用领域的角度提出了一种新的时间序列Transformer分类。对于网络修改,我们考虑了针对时间序列数据优化的transformer的低层模块调整和高层架构改进。在应用方面,我们总结和分析了用于流行时间序列任务的transformer,包括预测、异常检测和分类。对于每个时间系列的《Transformers》,我们都分析了它的见解、优势以及局限性。为了提供如何在时间序列中使用transformer的实用指南,我们进一步对时间序列transformer进行了一些实证研究,包括稳健性分析、模型规模分析和季节趋势分解分析。最后,我们提出并讨论未来可能的发展方向,包括时间序列Transformers的归纳偏差,时间序列Transformers和GNN,时间序列Transformers的预训练,以及时间序列Transformers和NAS。据我们所知,本文是第一次全面系统地总结了Transformers在时间序列数据建模方面的最新进展。我们希望这个综述将点燃对时间系列Transformers的进一步研究兴趣。

参考文献:

[IJCAI’21] Qingsong Wen, Liang Sun, Fan Yang, Xiaomin Song, Jingkun Gao, Xue Wang, Huan Xu, “Time Series Data Augmentation for Deep Learning: A Survey,” in the 30th International Joint Conference on Artificial Intelligence (IJCAI 2021), Montreal, Canada, Aug. 2021. [arXiv]. Note: Selected by Paper Digest into Most Influential IJCAI Papers (Version: 2022-02), Rank 1st (1 out of 15 out of 600+ IJCAI’21 papers) [link] * [ICASSP’22] Chaoli Zhang*, Zhiqiang Zhou*, Yingying Zhang*, Linxiao Yang*, Kai He*, Qingsong Wen*, Liang Sun* (*Equally Contributed), “NetRCA: An Effective Network Fault Cause Localization Algorithm,” in Proc. IEEE 47th International Conference on Acoustics, Speech, and Signal Processing (ICASSP 2022), Singapore, May 2022. [arXiv]. Note: ICASSP‘22 AIOps Challenge, First Place (1/382, Team Name: MindOps) [link] * [ICML’22] Tian Zhou, Ziqing Ma, Qingsong Wen, Xue Wang, Liang Sun, Rong Jin, “FEDformer: Frequency Enhanced Decomposed Transformer for Long-term Series Forecasting,” in Proc. 39th International Conference on Machine Learning (ICML 2022), Baltimore, Maryland, July 17-23, 2022. [arXiv] [code] * [KDD’22] Weiqi Chen, Wenwei Wang, Bingqing Peng, Qingsong Wen, Tian Zhou, Liang Sun, “Learning to Rotate: Quaternion Transformer for Complicated Periodical Time Series Forecasting”, in Proc. 28th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (KDD 2022), Washington DC, Aug. 2022.[come soon] * [arXiv’22] Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing Ma, Junchi Yan, Liang Sun, “Transformers in Time Series: A Survey,” in arXiv preprint arXiv:2202.07125, 2022 [arXiv] [Github] * [ICDE’22] Huajie Qian, Qingsong Wen, Liang Sun, Jing Gu, Qiulin Niu, Zhimin Tang, “RobustScaler: QoS-Aware Autoscaling for Complex Workloads,” in Proc. IEEE 38th International Conference on Data Engineering (ICDE 2022), Kuala Lumpur, Malaysia, May 2022. [arXiv], Media Coverage: [Mo4Tech] [Alicloudnative] Zhihu [1024sou] * [SIGMOD’21] Qingsong Wen, Kai He, Liang Sun, Yingying Zhang, Min Ke, Huan Xu, “RobustPeriod: Time-Frequency Mining for Robust Multiple Periodicity Detection,” in Proc. ACM SIGMOD International Conference on Management of Data (SIGMOD 2021), Xi’an, China, Jun. 2021. [arXiv] * [KDD’20] Qingsong Wen, Zhe Zhang, Yan Li, Liang Sun, “Fast RobustSTL: Efficient and Robust Seasonal-Trend Decomposition for Time Series with Complex Patterns,” in Proc. 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (KDD 2020), San Diego, CA, Aug. 2020. [paper] * [AAAI’19] Qingsong Wen, Jingkun Gao, Xiaomin Song, Liang Sun, Huan Xu, Shenghuo Zhu, “RobustSTL: A Robust Seasonal-Trend Decomposition Algorithm for Long Time Series,” in Proc. 33th AAAI Conference on Artificial Intelligence (AAAI 2019), Honolulu, Hawaii, Jan. 2019. [paper], Media Coverage: [Alibaba Tech]