11.3 偏导数

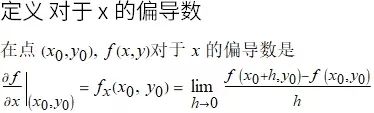

对于多元函数, 当我们把一个自变量固定, 对另一个变量求导, 这样就是求偏导. 现在来看下偏导数的定义以及如何计算.

二元函数的偏导数

如果 (x0,y0)

(

x

0

,

y

0

)

是函数 f(x,y) 定义域中的一点, 固定平面 y=y0

y=

y

0

割曲面 z=f(x,y) 得到曲线 z=f(x,y0)

z=f(x,

y

0

)

(如下图红色曲线所示).

![]()

![]()

在点 (x0,y0)

(

x

0

,

y

0

)

对于 y 的偏导数定义类似 f 对于 x 的偏导数. 现在只是把 x 固定在 x0

x

0

的值, 而取计算 f(x0,y)

f(

x

0

,y)

在 y0

y

0

对 y 的普通导数. 请看下面的动画:

![]()

多于二元的函数

更多元的函数偏导数类似二元函数定义, 只是对某一个变量求导, 而其余自变量为常数.

偏导数和连续性

一元函数导数即意味着连续, 但二元函数 f(x,y) 不同, 在一个点不连续, 但对 x 和 y 可以求偏导.

![]()

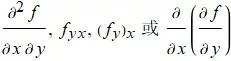

二阶偏导数

二阶导数就是对函数求导两次, 但注意求导次序如果是先对y 求偏导, 再对 x 求偏导应该这样的写法:

![]()

混合求导

在计算二阶混合导数时候, 可以按任意次序微分.

可微性 Differentiability

如果 fx(x0,y0)

f

x

(

x

0

,

y

0

)

和 fy(x0,y0)

f

y

(

x

0

,

y

0

)

存在, 并且[EmptyUpTriangle]z 满足下面的等式:

![]()

其中当 (Δx,Δy)→(0,0)

(

Δ

x,

Δ

y)

→

(0,0)

时 (ϵ1,ϵ2)→(0,0)

(

ϵ

1

,

ϵ

2

)

→

(0,0)

, 则函数 z=f(x,y) 是在 (x0,y0)

(

x

0

,

y

0

)

点可微的.

如果它在定义域内的每个点都是可微的, 则说 f 是可微的.

多元函数偏导存在且连续推出函数可微, 但反之不成立, 这点与一元函数不同.(完)

「予人玫瑰, 手留余香」

转发既是支持, 我们会努力走得更远!