收录160+篇文章!清华唐杰团队详解自监督学习

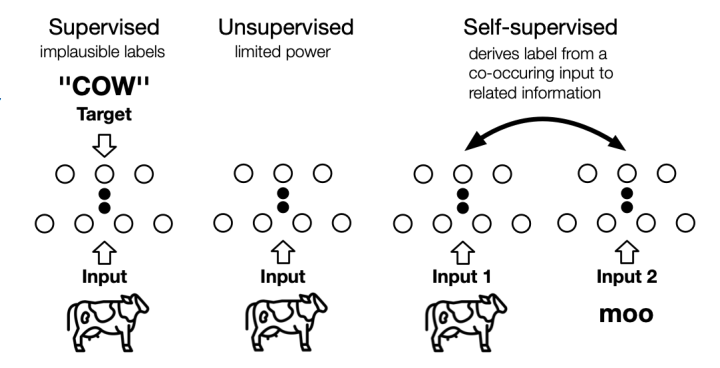

通过“半自动”过程从数据本身获取“标签”。

从其他部分预测部分数据。

提供了自监督学习最新、最详细的概述,介绍了背景知识、变量模型和重要的框架,人们可以很容易地掌握自我监督学习的前沿思想。

将自我监督的学习模型分为生成型,对比型和生成对比型(对抗性),每种都包含特定的类型。展示了每种分类的利弊,并讨论了最近从生成转向对比的转变。深度

研究了自我监督学习方法的理论合理性,并说明了它如何有益于下游监督学习任务。

确定了该领域中的几个未解决的问题,分析了其局限性和边界,并讨论了自监督表示学习的未来方向。

登录查看更多

相关内容

专知会员服务

87+阅读 · 2020年3月1日

Arxiv

5+阅读 · 2019年8月24日

Arxiv

5+阅读 · 2018年4月3日