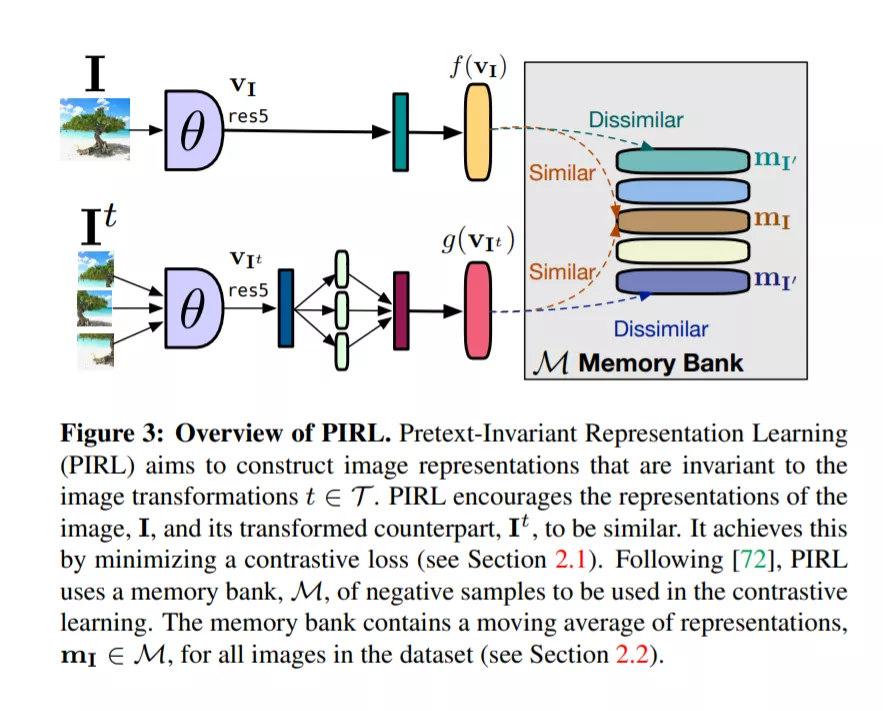

从图像中进行自监督学习的目标是通过不需要对大量训练图像进行语义注释的前置任务来构造语义上有意义的图像表示。许多前置任务导致与图像变换协变的表示。相反,我们认为语义表示在这种转换下应该是不变的。具体来说,我们开发了前置不变表示学习(PIRL,发音为“pearl”),该学习基于前置任务的不变表示。我们将PIRL与一个常用的前置任务一起使用,该任务涉及解决拼图游戏。我们发现,PIRL极大地提高了学习图像表示的语义质量。我们的方法设置了一个新的艺术的自监督学习从图像上几个流行的基准自我监督学习。尽管是无监督的,但PIRL在学习图像表示和目标检测方面的表现优于有监督的前训练。总之,我们的结果证明了具有良好不变性的图像表示的自监督学习的潜力。

成为VIP会员查看完整内容

相关内容

CVPR is the premier annual computer vision event comprising the main conference and several co-located workshops and short courses. With its high quality and low cost, it provides an exceptional value for students, academics and industry researchers.

CVPR 2020 will take place at The Washington State Convention Center in Seattle, WA, from June 16 to June 20, 2020.

http://cvpr2020.thecvf.com/

专知会员服务

39+阅读 · 2020年3月19日

Arxiv

15+阅读 · 2020年3月31日