【ICML2020-浙江大学】对抗性互信息的文本生成

Adversarial Mutual Information for Text Generation

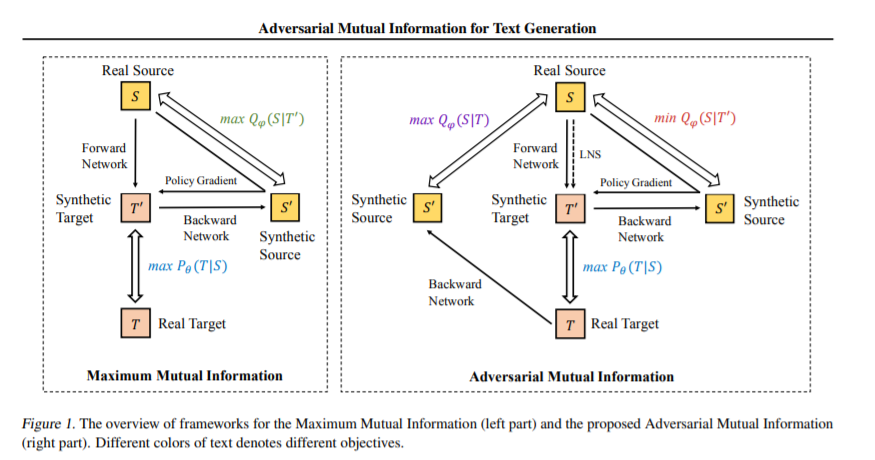

在最大化源与目标之间的互信息方面的最新进展已经证明了它在文本生成方面的有效性。然而,以往的工作对MI(即MI)的后向网络建模关注较少。这对于变分信息最大化下界的紧密性至关重要。在本文中,我们提出了一个对抗互信息(AMI):一个文本生成框架,它是一个新的鞍点(min-max)优化,旨在识别源与目标之间的联合交互。在这个框架中,通过比较真实和合成的数据分布,前向网络和后向网络能够迭代地提升或降级彼此生成的实例。我们还开发了一个潜在噪声采样策略,利用高级语义空间的随机变化来增强生成过程中的长期依赖性。基于不同文本生成任务的大量实验表明,所提出的AMI框架能够显著优于多个强基线,我们还表明,AMI有可能为变分信息最大化问题带来更紧密的互信息上限。

https://www.zhuanzhi.ai/paper/ccd8403755c153d155bec032656f8c49

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“AMITG” 可以获取《【ICML2020-浙江大学】对抗性互信息的文本生成》专知下载链接索引

登录查看更多

相关内容

Arxiv

9+阅读 · 2018年10月29日