【微软雷德蒙研究院】对抗机器学习工业视角,Adversarial Machine Learning

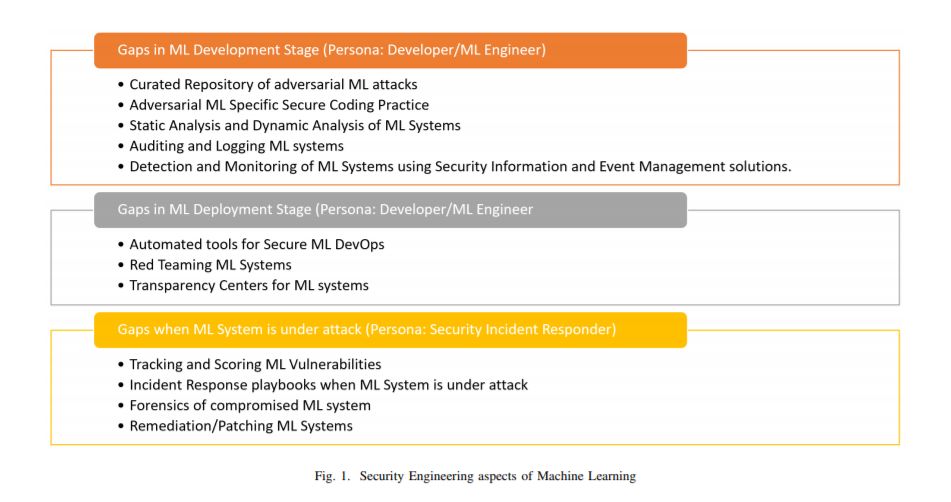

基于对28个组织的采访,我们发现行业从业者没有配备战术和战略工具来保护、检测和响应对他们的机器学习(ML)系统的攻击。我们利用了访谈中的见解,并列举了在传统软件安全开发环境下保护机器学习系统的视角上的差距。我们从两个角色的角度撰写本文:开发人员/ML工程师和安全事件响应人员,他们的任务是在设计、开发和部署ML系统时保护ML系统。本文的研究目的是为了使研究者们能够在激烈竞争的ML时代对工业级软件的安全开发生命周期进行修订和修正。

地址:

https://arxiv.org/abs/2002.05646

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“AMLI” 就可以获取《对抗机器学习工业视角》专知下载链接

登录查看更多

相关内容

专知会员服务

29+阅读 · 2019年11月18日

Arxiv

23+阅读 · 2020年3月7日

Arxiv

15+阅读 · 2018年5月24日

Arxiv

10+阅读 · 2018年4月11日

Arxiv

6+阅读 · 2018年3月24日