题目

对抗机器学习工业视角,Adversarial Machine Learning - Industry Perspectives

关键字

对抗机器学习,机器学习系统保护,机器学习调查,机器学习独特思考,人工智能

简介

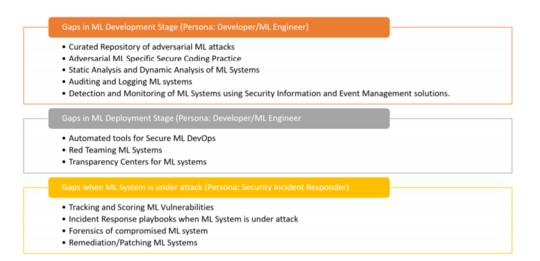

根据对28个组织的采访,我们发现行业从业人员没有配备战术,战略工具来保护,检测和响应对其机器学习(ML)系统的攻击。 我们利用访谈中的见解,并列举了从传统软件安全性开发的角度来看在保护机器学习系统方面存在的差距。 我们从两个角色的角度撰写本文:开发人员/机器学习工程师和安全事件响应者,他们负责在设计,开发和部署机器学习系统时保护机器学习系统。 本文的目的是吸引研究人员修改和修正对抗性ML时代的工业级软件的安全开发生命周期。

作者

Ram Shankar Siva Kumar, Magnus Nyström, John Lambert, Andrew Marshall, Mario Goertzel, Andi Comissoneru, Matt Swann, Sharon Xia

成为VIP会员查看完整内容

相关内容

专知会员服务

46+阅读 · 2020年1月25日

专知会员服务

29+阅读 · 2019年11月18日

Arxiv

9+阅读 · 2018年10月29日

Arxiv

15+阅读 · 2018年5月24日

Arxiv

10+阅读 · 2018年3月27日

Arxiv

5+阅读 · 2018年1月15日