KDD 2022 | 判别式自监督学习的个性化推荐

今天给大家介绍一篇香港大学黄超老师实验室发表的一篇关于自监督推荐系统的文章。在该文章中,作者通过设计基于判别式自监督的模型在基于 GNN 的协同过滤架构上引入了额外自监督任务对用户交互数据的可靠性进行预测,来实现有效的数据增强,从而实现对数据噪音和稀疏性问题的缓解。所提出的自监督框架基于 Graph Transformer 的架构,学习用户及商品间全局关联性,从而为所设计的自监督模型提供有效的信息。模型在多个公开数据集上取得了较好的实验结果。该模型已经开源。

论文来源:

论文链接:

文章关键字:

代码链接:

港大数据智能实验室(指导老师: 黄超)

研究背景

推荐系统能够帮助用户缓解信息过载问题,近年来在线上购物、流视频网站、地点推荐等各类网络应用中发挥了越来越重要的作用。为了更准确地对用户偏好进行建模,协同过滤(Collaborative Filtering)方法将用户、商品嵌入语义空间,使用表征向量压缩观测到的用户、商品交互数据。

早期的协同过滤模型通过矩阵分解方法来学习和恢复用户、商品的交互信息。由于深度学习架构的强大表征能力,近年的协同过滤工作采用各种各样的人工神经网络模型来学习用户、商品的低维表征,例如多层感知机、自编码器网络、注意力机制。图神经网络因其强大的图结构数据表征学习能力,在协同过滤领域受到了广泛关注,该类模型沿着观测到的用户、商品交互边进行迭代的信息传播和聚合,以改善用户、商品表征。

尽管基于图神经网络的协同过滤在各个指标上都展现出了优越的性能,但现有工作仍然存在一些关键问题亟待解决,具体来说,本文试图解决以下两个问题:

(a)首先,由于各种原因,噪音数据在各类推荐场景下无处不在。例如,用户可能由于平台过多的曝光而点击了他不感兴趣的流行商品。在这种情况中,用户、商品交互图中可能包含和用户偏好无关的连接关系,直接从所有交互边中聚合信息会损害用户表征的准确性。更糟的是,迭代的图编码模式会在多跳邻居之间进行信息传播,从而将这种噪音进一步放大,对基于图神经网络的推荐系统造成更严重的负面影响。

(b)第二,数据噪声和倾斜分布(skewed distribution)问题阻碍模型进行有效的用户、商品交互建模,导致现有基于图的协同过滤模型偏向于预测流行商品,并在面对交互数据稀缺的用户时会出现严重的效果退化。尽管最近已有一些推荐模型采用自监督学习范式来提升用户表征,这些方法主要通过随机掩码的方式产生额外监督信号,这种数据增强方法可能会在图数据中保留噪声交互,或丢失重要的训练信号,因此不能达到最好的效果。

模型介绍

考虑到前文所述的挑战,本文提出一种基于判别式自监督学习的 Self-Supervised Hypergraph Transformer (SHT) 模型,能够增强图神经协同过滤模型的鲁棒性和泛化能力。具体来说,我们将超图神经网络与拓扑感知的 Transformer 模型进行结合,以增强 SHT 模型的全局协同关系学习能力。基于局部图卷积网络,我们首先编码得到包含用户、商品邻域拓扑结构信息的用户表征,并将其注入 Transformer 建模过程,从而在整个用户、商品表征空间进行更好的超图信息传播。

此外,我们将局部协同关系编码和全局超图关系学习统一在了一个生成式的自监督学习框架下。本文提出的 SHT 模型通过对图拓扑结构进行去噪的方式,蒸馏得到额外监督信号,以增强模型训练。其中,我们提出了一种基于图的元学习变换网络层,以将基于超图的全局表征映射到基于图的局部交互建模中去。

SHT 中的生成式去噪自监督方法是一种模型无关的方法,可以作为插件应用于现在基于图神经网络的推荐系统模型中去。具体来说,SHT 中的自监督方法使得局部和全局交互关系的协同学习成为可能,能够帮助基于图神经网络的协同过滤模型面对噪声和稀疏用户交互数据,学得更高质量的用户表征。

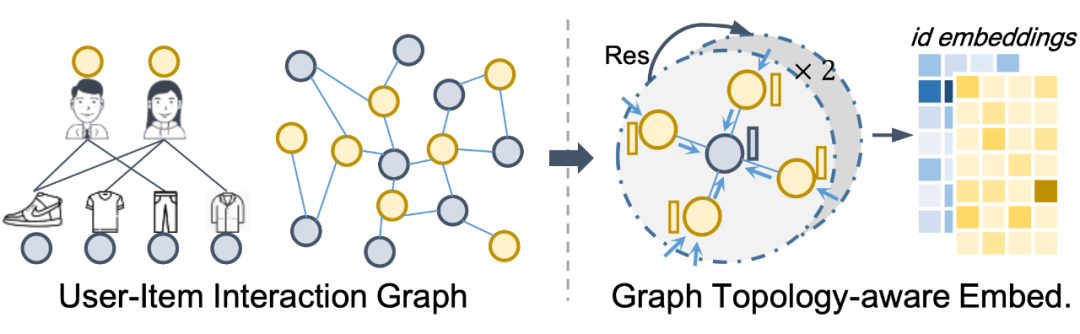

2.1 基于图结构的用户商品表征学习

为了对用户、商品的交互特征进行建模,首先,SHT 将用户和商品映射到一个d维的隐语义空间,对应的低维表征向量用于编码用户、商品的交互模式。用户、商品交互数据被组织为用户-商品交互图,以更好地表现用户、商品间的高阶交互关系。基于图卷积神经网络在捕捉节点邻域结构信息上的优势,SHT 使用迭代的图卷积编码器对每个节点进行 L 阶子图编码。

这一基于图卷积网络的节点表征包含了邻域子图的拓扑结构信息,在 SHT 中被称为拓扑感知表征向量,在后续的图 Transformer 模块中作为 positional embedding,用于标注节点在观测交互图中的拓扑结构信息。

2.2 基于超图Transformer的全局协同关系建模

虽然现有的图神经网络方法在学习用户、商品关系数据上取得了一定的效果,但推荐数据本身的噪声和倾斜分布问题仍然限制着用户、商品表征学习的效果。

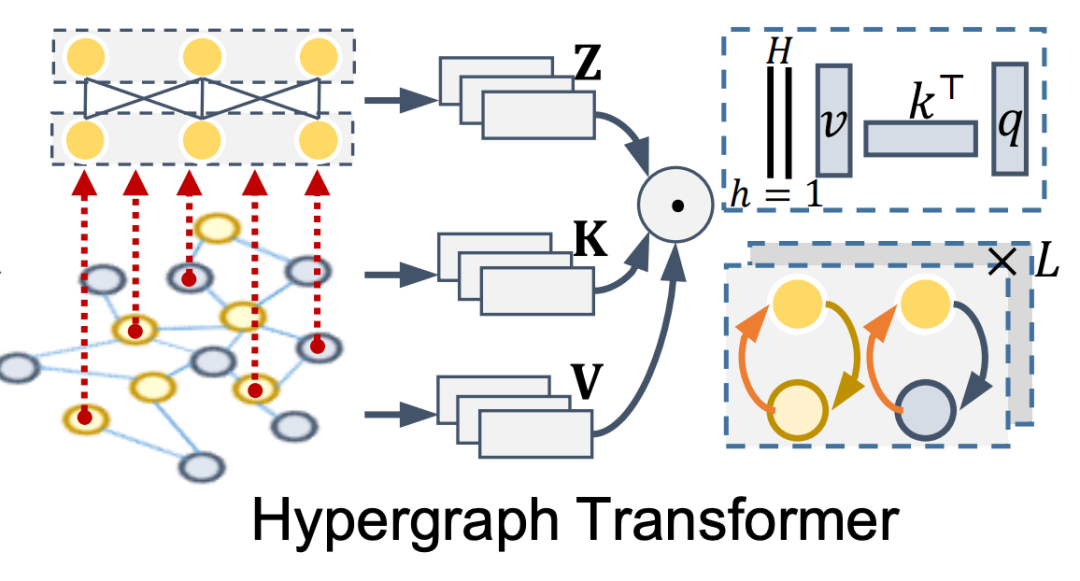

为了解决这一问题,SHT 提出采用一种超图 Transformer 架构,从以下两个角度解决上述问题:首先,通过进行自适应的超图关系学习,可以得到更好的节点间关系结构,从而减轻观测数据中噪声对协同过滤建模的影响;其次,超图网络不再依赖于原始观测交互图,而采用全局信息传播模式,这样做有助于从交互稠密的用户、商品向交互数据稀疏的节点传递信息,从而缓解交互数据在不同用户、商品节点间倾斜分布的问题。

具体来说,SHT 模型采用了一种 Transformer 形式的注意力计算机制,用于进行超图结构学习。在这一过程中,图卷积网络得到的拓扑感知表征被注入到节点表征中,以保留交互图中节点的局部拓扑结构,以及在整体交互图中的全局位置信息。同时,Transformer 的多通道注意力计算方式,进一步扩展了 SHT 的表征空间,提升结构学习的效果。

在使用节点的 id 表征以及拓扑感知表征进行用户、商品表征初始化后,SHT 通过图 Transformer 的方式,将用户、商品节点信息,通过 Transformer attention 学得的超图结构,传播到超边节点之上。具体来说,每个超边节点都有对应的 query 表征,而用户、商品节点,则通过可学习的 Key 变换和 Value 变换,得到 key 表征和 value 表征,query 和 key 表征在多头注意力空间中计算 attention 权重,即得到所有用户、商品节点同超边节点之间的连接网络结构。

根据这一超边网络,各个注意力头的用户、商品节点表征被传播到超边节点当中。通过这一过程,SHT 进行了超边结构学习,同时从全局角度提取了用户、商品信息。为了进一步提取超边之间可能存在的复杂非线性特征关系,SHT 增加了更多的超边层,不同超边层之间的连接关系由可学习的映射权重进行捕捉。

接下来,SHT 将经过深层提取的超边特征,通过相似的 Transformer 注意力机制传递回用户、商品节点,以在用户、商品表征中注入全局关系学习的结果。在这一过程中,之前普通节点侧的 key 表征作为新的 query 表征,之前超边节点侧的 query 表征作为新的 key 表征,使用这两者进行超边到节点的信息传播。超边节点的表征向量通过同样的 Value 变换,得到 value 向量。

经过用户、商品节点到超边节点,以及超边节点到用户、商品节点到来回信息传播,SHT 即完成了一次超图神经网络的编码过程,对用户、商品表征进行了改善。基于这一过程,SHT 迭代地进行多次信息传播,并将每次的节点表征进行累和,即得到了超图 Transformer 最终的用户、商品表征,用于交互预测以及局部-全局的自监督学习任务。

2.3 基于判别式的自监督推荐范式

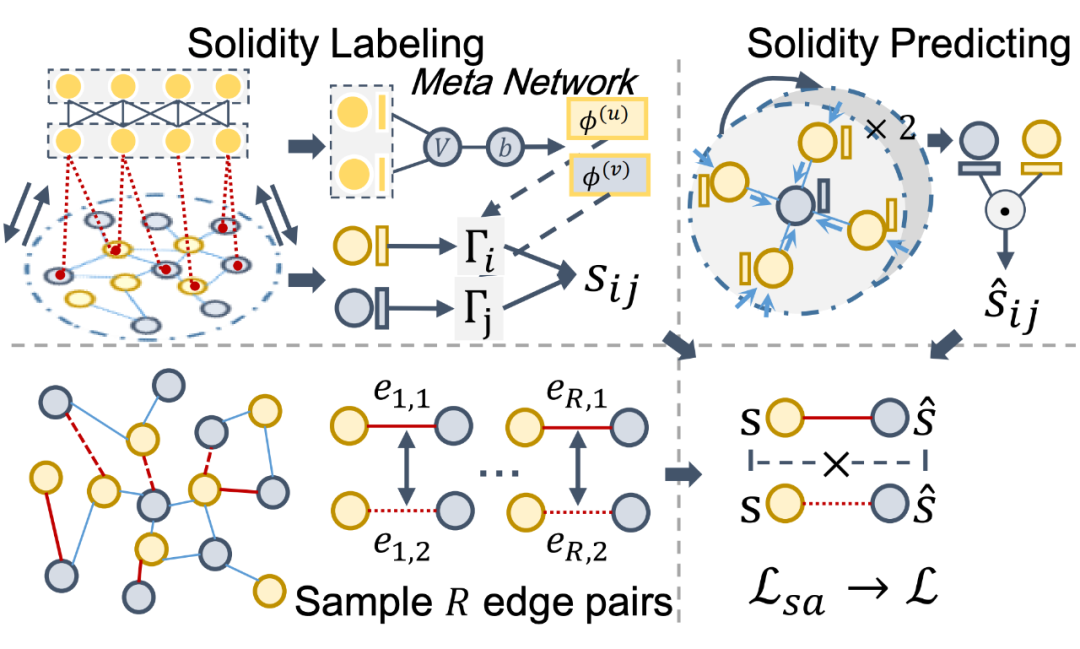

SHT 中的超图 Transformer 通过进行自适应的超图结构学习和信息传播,缓解了推荐场景下的数据稀疏和倾斜分布问题。然而,用于捕捉局部交互关系的拓扑感知表征仍然可能受到交互数据中噪声的影响。为了解决这一挑战,SHT 通过在局部表征学习和全局表征学习之间增加一个额外的自监督任务,使用全局关系学习的结果来修正局部观测数据中的噪声。

具体来说,SHT 的自监督任务使用局部拓扑感知表征来预测原始观测图中边的可靠性(solidity)。此处可靠性指一条边不是噪声的概率,它的标签数据来自超图 Transformer 网络。通过这种方式,SHT 将超图 Transformer 得到的高级、去噪特征,转移到了拓扑感知表征中的低级、含噪表征。这样做能够修正局部关系建模使用的原始观测图结构,提升模型鲁棒性。

为了进行这一自监督任务,SHT 首先利用超图学习的结果,对采样边的可靠性进行标注生成。具体来说,考虑到超图 Transformer 中用户、商品 key 向量包含了丰富的关系学习信息,SHT 复用用户、商品 key 向量进行交互边的可靠性分数估计。

此外,为了进一步考虑用户、商品表征域的全局特点,SHT 使用元学习网络捕捉高级超边表征中的全局信息,并据此生成针对用户域和商品域的表征迁移网络。表征迁移网络用于注入超图 Transformer 习得的全局信息,并尝试通过表征变换弥补超图关系学习和可靠性预测任务之间的差异。具体来说,元学习网络输入经过 mean-pooling 的超边表征,通过全连接层生成迁移网络的变换和偏置参数。迁移网络输入用户、商品的 key 表征,并通过带有 sigmoid 激活的 MLP 网络得到可靠性预测结果。

接着,SHT 使用局部用户、商品建模的拓扑感知表征,通过内积进行局部表征的可靠性预测。在进行自监督任务训练时,SHT 采样得到多对用户、商品交互边,全局模型和局部模型同时对每对边进行预测,并计算两条边的可靠性差值。自监督任务通过hinge loss拉近两个模型差值的距离,以对齐他们对观测边可靠性的预测,从而拓扑感知表征受到数据噪声的影响。

实验结果

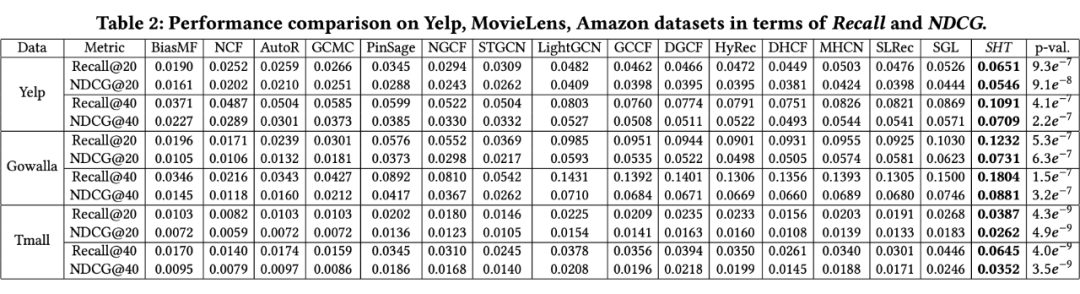

本文在 Yelp、Gowalla、Tmall 三个公开数据集上进行实验验证,数据集统计信息见下表。采用全排列方式进行评测,即对每个用户,预测他对训练正例之外所有商品的偏好程度并进行排序,通过计算测试正例在排序结果中是否靠前来衡量模型推荐效果。衡量指标采用 Recall@N 和 NDCG@N。SHT 与属于 7 个不同研究路线的 15 个基线方法进行了对比。

3.1 对比实验

首先,本文实验将 SHT 模型与所有基线方法进行推荐效果对比,实验验证指标如下图所示。

从中可以得出三个基本结论:首先,SHT 相对所有基线方法展现出了优越的推荐排序效果,这验证了 SHT 模型所进行的自适应超图信息传播,以及可靠性预测的去噪自监督学习方法整体上具备的优越性能;其次,基于超图神经网络架构的基线方法展现出了显著优于其他类别方法的优势,这一结果说明了传统图神经网络架构在应对稀疏且倾斜的推荐交互数据时可能存在的效果退化;最后,从实验结果中可以观察到自监督学习给不同类别的协同过滤方法都带来了显著的效果提升,这验证了使用自监督学习方法对推荐任务进行增强以改善模型训练的有效性。

而将基线方法中的自监督模式与 SHT 相比,我们可以发现几个主要的模型设计优势:SHT 通过元学习网络和超图的全局学习,可以将全局信息注入自监督学习任务中,同时能更好地进行自监督任务和主任务之间的域适应(domain adaption);现有自监督方法往往基于随机过程进行数据增强,这种做法可能保留噪声或丢失重要信息,而 SHT 的数据增强方式通过另一种表征学习范式进行,既可以避免上述随机方法的问题,也可以引入全局关系学习的视角,达到更好的效果。

3.2 模型消融实验

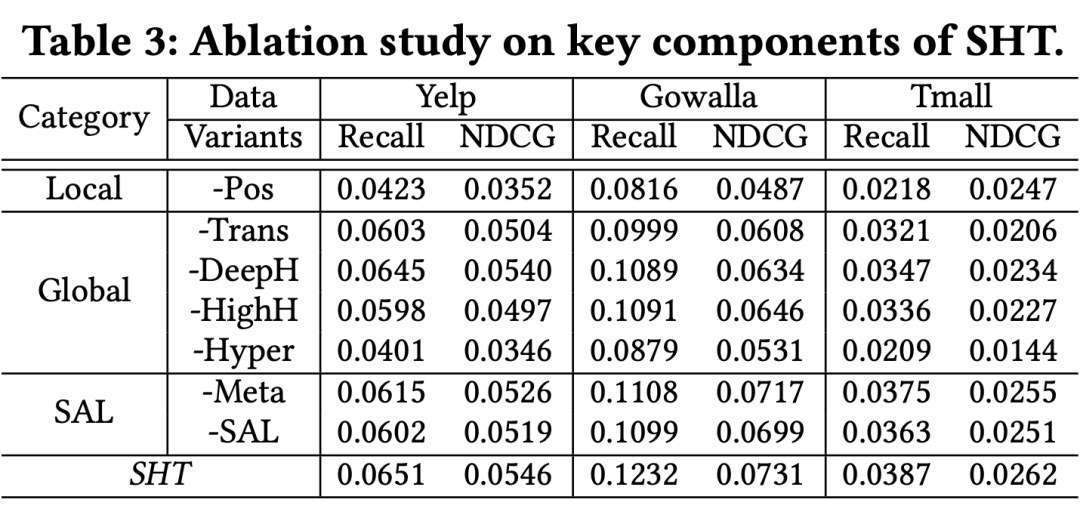

接下来,我们从局部建模、全局建模和自监督学习三个方面移除 SHT 中的重要模块以验证模型设计的有效性,包括:拓扑感知表征(Pos)、Transformer 形式的超图结构学习(Trans)、多层超边建模(DeepH)、高阶超图学习(HighH)、超图 Transformer 整体(Hyper)、元学习网络(Meta)、以及自监督学习任务整体(SAL)。去除各个模块均引起了模型效果的退化,这验证了 SHT 中不同模型模块的有效性。

3.3 模型鲁棒性测试

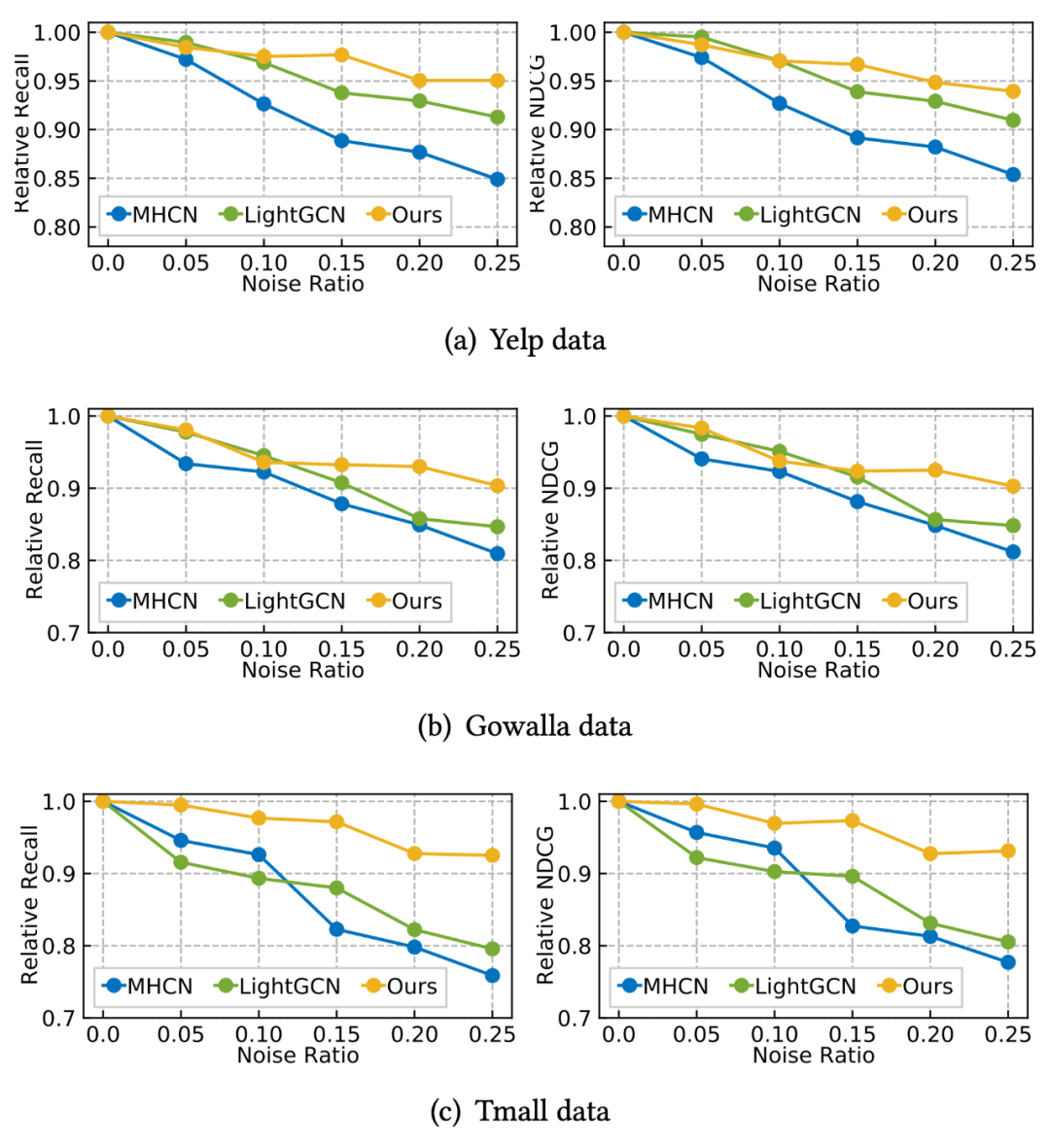

本文测试了 SHT 应对噪声和稀疏度两个方面的模型鲁棒性。针对噪声扰动,我们将交互图中不同比例的边进行随机替换,检测 MHCN、LightGCN 和 SHT 三个模型在不同噪声比例下的效果变化。抗噪音实验结果如下图所示,整体而言,在噪声比例较大时,SHT 能够相对保持较小的模型退化,这一结果验证了 SHT 模型对抗噪音的鲁棒性。

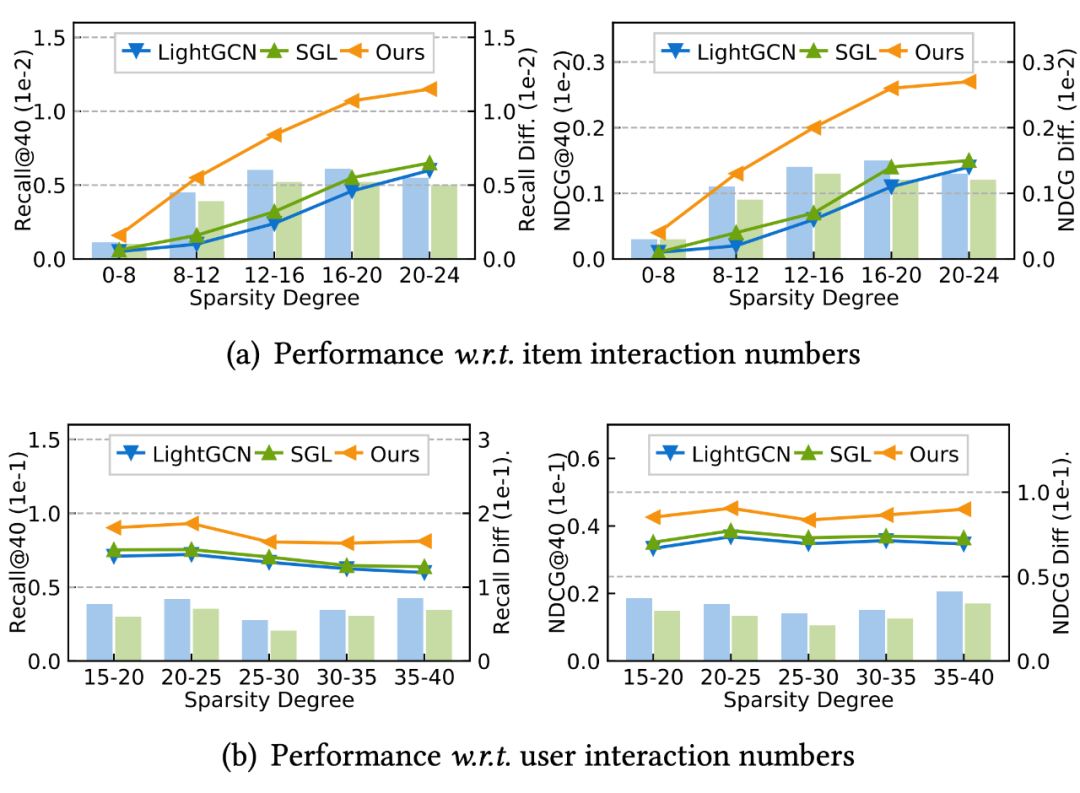

接着,我们将用户和商品根据交互稀疏度的数量划分为不同的集合,每次只测试特定交互数量范围内的用户或商品推荐效果。结果如下图所示,折线表示方法效果,柱表示 SHT 方法相对不同基线方法的效果提升。

从中可以观测得到以下结论:首先,SHT 在各个稀疏度的数据上都表现出了更加好的推荐效果;其次,商品的交互稀疏度对模型预测效果的影响显著更大;第三,在商品稀疏度实验中,SHT 在中间稀疏度上的效果提升幅度明显大于在最稠密数据集上的提升,这验证了 SHT 相对基线方法更强的抗稀疏能力。

3.4 样例学习

最后,本文选取了三个具体样例,针对以下两个角度对 SHT 的超图 Transformer 和自监督学习方式进行深入探究:SHT 的超图关系学习能否学得有用的节点间关系,特别是在训练过程中没有利用的潜在关系?SHT 的自监督学习框架是否能正确地对交互可靠性进行预测?

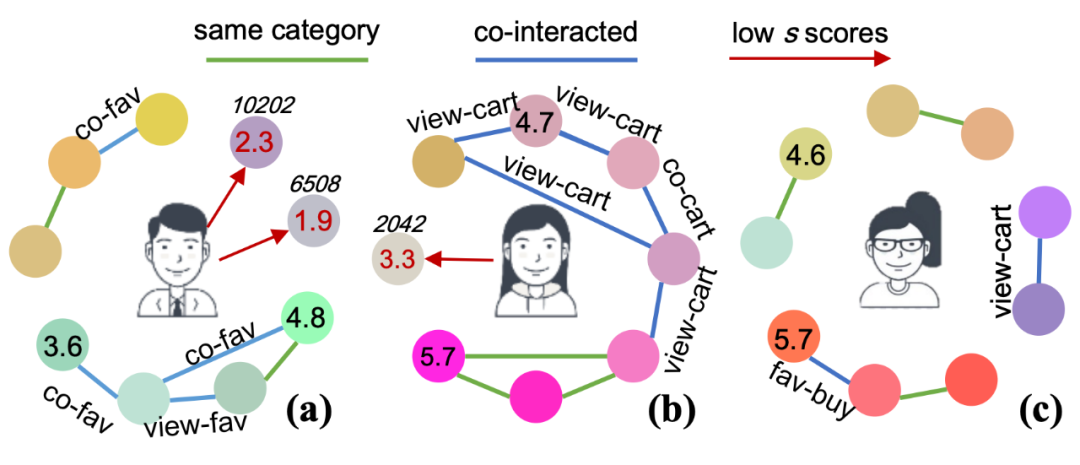

下图展示了样例学习的结果,其中圆圈代表中心用户交互的商品,其颜色反映经过压缩映射商品表征,颜色越相近代表商品的表征向量越相近。从中我们可以得到以下两方面的结论:

a. 隐式关系学习。即使图中列出的商品都是被中心用户交互的商品,但根据其颜色反映的商品表征,也可以将其分为多个小组。可以看到,颜色相近的商品之间往往存在一些未被模型训练利用的潜在关系,例如两个商品属于同一个类别、两个商品都被用户以收藏、加购物车等额外交互行为的方式交互过。这种潜在关系与相似商品表征的对应关系,验证了 SHT 通过表征学习挖掘商品间潜在关系的能力。这主要归功于 hypergraph transformer 的全局表征学习能力,可以根据商品语义信息进行任意两个商品的关系学习。

b. 噪声判别。下图在代表商品的圆圈上同样展示了 SHT 对该交互的可靠性预测分数,图中省略了大部分节点的分数数值,而选出正常节点中的最高值和最低值用黑色数字显示。红色数字则为明显低于其他数值的交互商品,也就是被模型认为属于噪声交互的商品。可以从下面的样例发现,噪声商品和其他商品不具有潜在关系,同时学得的表征也异于其他商品,与之对应,模型对其赋予了较低的可靠性分数,以进行图交互数据的去噪。

这一工作探索了使用超图 Transformer 网络架构和自监督学习方法来加强协同过滤推荐系统。本文提出的 SHT 方法通过超图结构学习和超图信息传播缓解数据中的噪声和倾斜分布问题。为了进一步去除交互噪声的影响,SHT 还利用了一种新颖的可靠性预测自监督任务,扩展模型训练方法,并提升模型对抗噪音和稀疏的鲁棒性。在真实大规模交互数据集上的实验充分验证了 SHT 方法的效果。在未来的工作中,可以将 SHT 架构拓展到更多的推荐场景。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编