词向量, BERT, ALBERT, XLNet全面解析(ALBERT第一作者亲自讲解)

现在是国家的非常时期,由于疫情各地陆续延迟复工,以及各大院校延期开学。作为一家AI教育领域的创业公司,我们希望在这个非常时期做点有价值的事情,并携手共渡难关。在疫情期间,我们决定联合国内外顶尖AI专家一起筹划”共同战疫,贪心在行动“的计划,提供重磅级NLP专题系列直播课程,共五次课程,为期两周时间,供大家在线学习,全程免费。

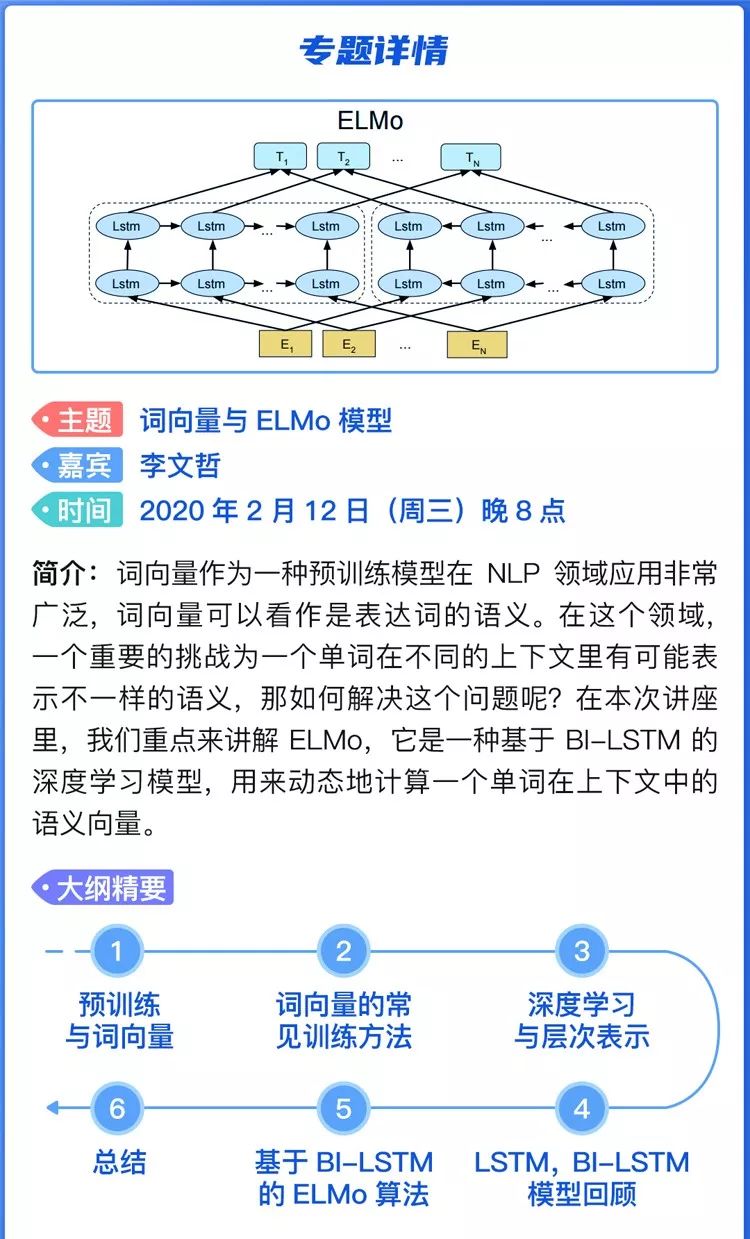

这次的专题我们选择了近几年NLP领域最火的,你不得不了解的话题 - ”预训练模型“。从简单的Word2Vec,ELMo,GPT,BERT,XLNet到ALBERT, 这几乎是NLP过去10年最为颠覆性的成果。作为一名AI从业者,或者未来想步入AI领域的人士,这是一门必修课。在本次专题活动,我们会由浅入深地按照知识点的学习路径来给大家讲解每个技术背后的原理、细节以及应用。

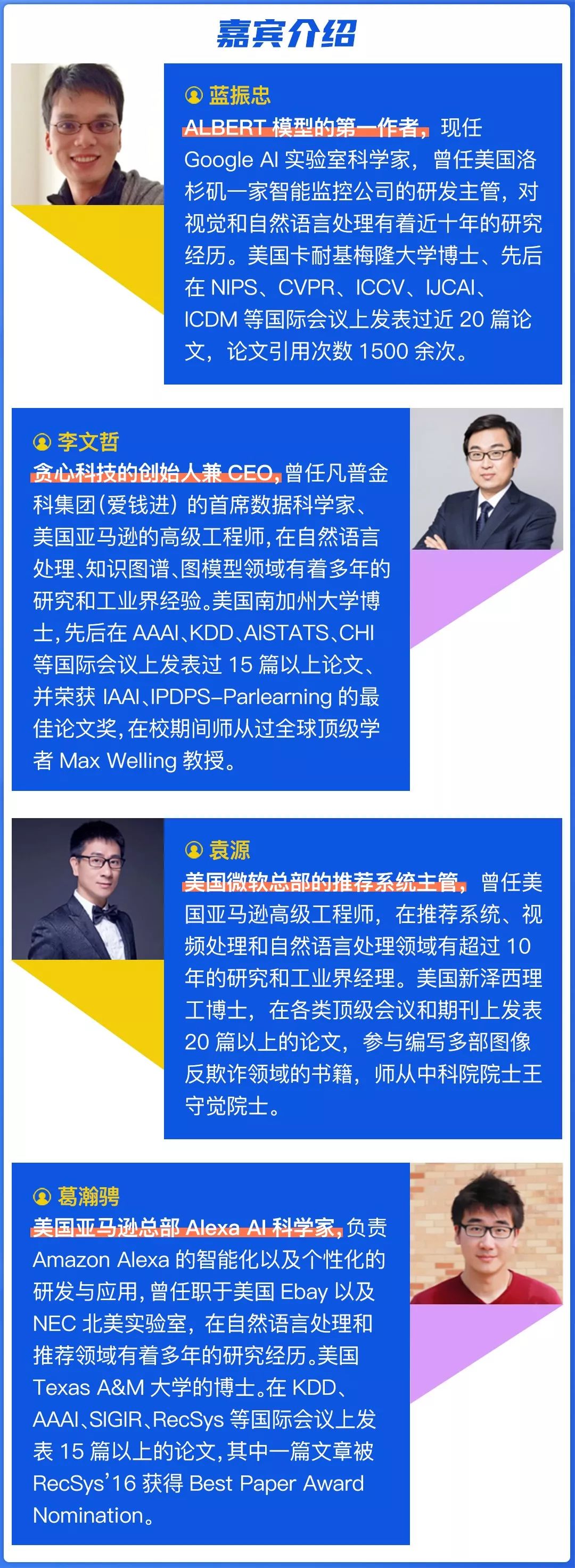

本次的专题课程,我们也有幸邀请到了多位国内外NLP领域的专家,其中蓝振忠博士作为ALBERT模型的第一作者,会亲自讲述当初对这份工作背后的思考以及技术细节。 希望通过本次活动,给大家带来一些认知上的收获,在疫情期间也可以充实自我,武汉加油,中国加油!

本次专题活动除了贪心科技的创始人,我们还联合了国内外多位NLP领域专家,包括蓝振忠(ALBERT模型第一作者,Google Lab科学家,卡耐基梅隆大学博士),葛瀚骋(Amazon Alexa部门科学家,Texas A&M大学博士), 袁源(美国微软推荐系统主管,新泽西理工博士)。

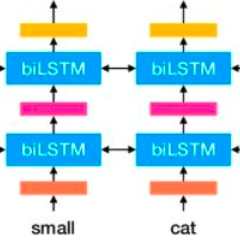

对于本次的专题内容,会从词向量,LSTM,Seq2Seq,注意力机制开始逐步讲解到ELMo,Transformer,BERT,XLNET,ALBERT。这是一次体系化的专题课程,区别于常见的公开课,希望通过两周的时间让听众对这个领域有直观的认知。

🔥 前方高能 🔥

史上最干干货!来咯!

本次直播分5大主题,为期两周时间