跟Kaggle大神17枚金牌得主学NLP实战

新智元推荐

新智元推荐

来源:图灵TOPIA

作者:Dean Sublett

编译:安然

整理编辑:元子

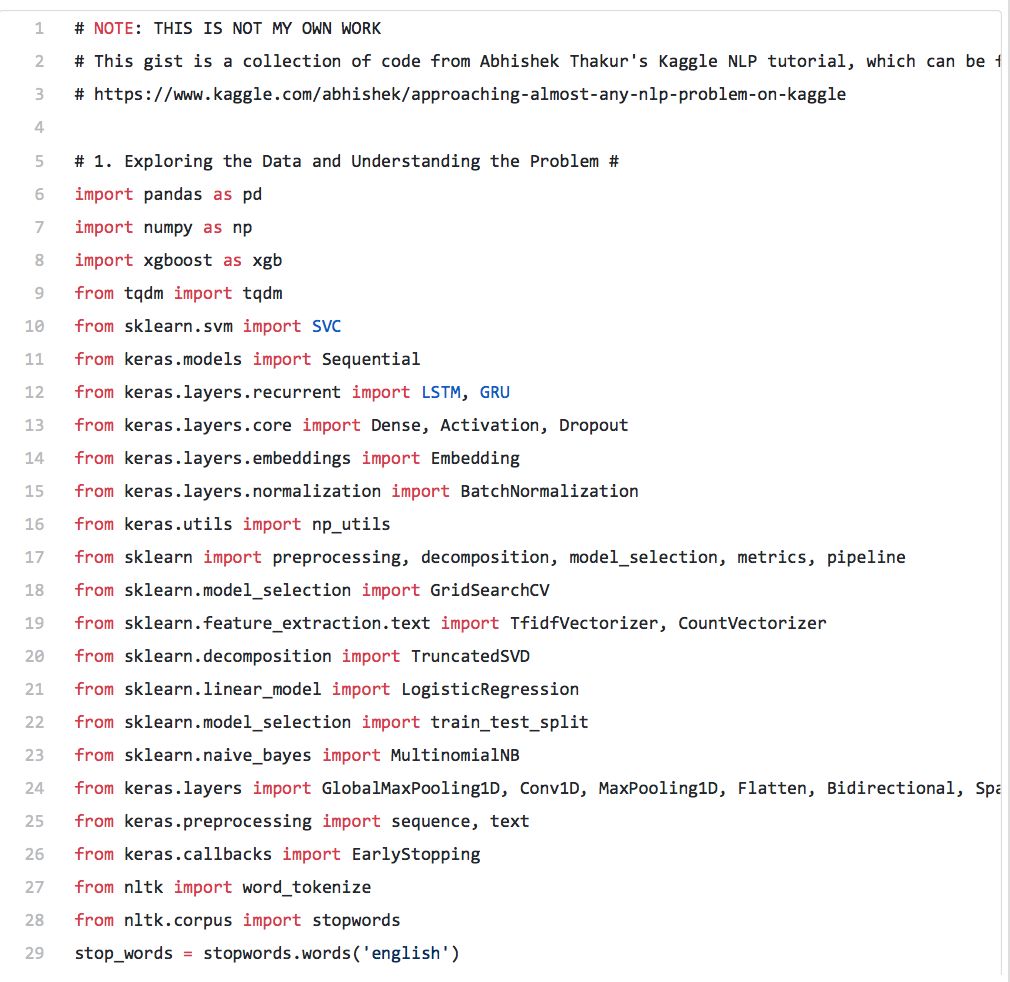

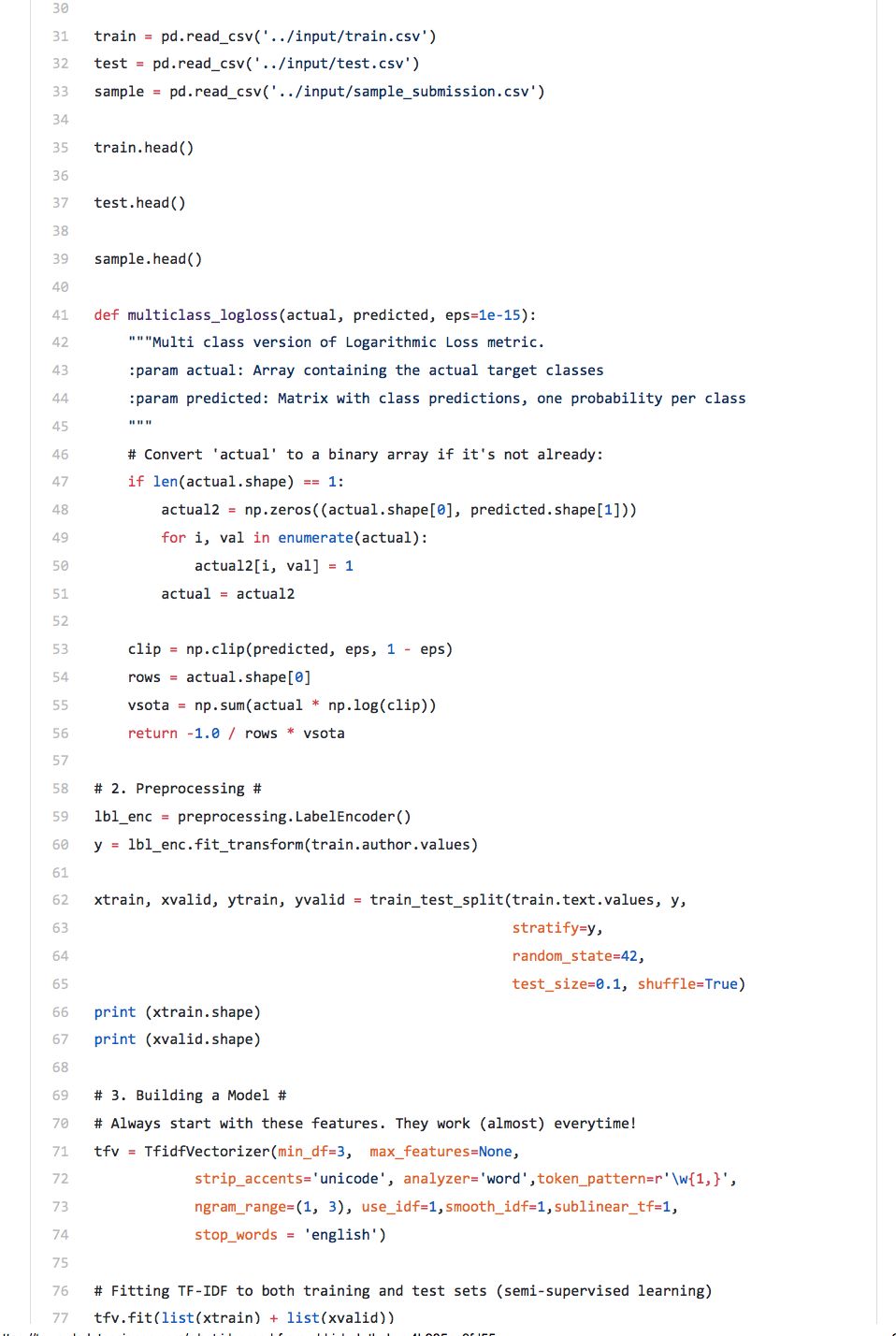

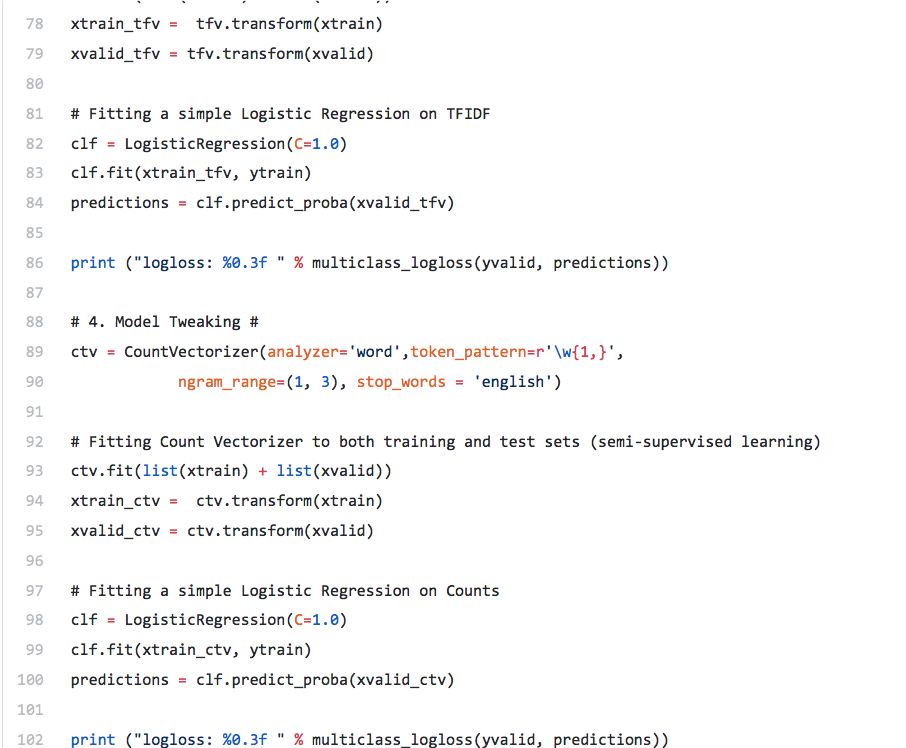

【新智元导读】本文作者Dean Sublett是Kaggle大神Abhishek Thakur的迷弟,通过学习Abhishek的相关教程受益良多,因此,近期他在medium上撰文对相关自然语言处理的知识做了梳理总结。

本文作者Dean Sublett是Kaggle大神Abhishek Thakur的迷弟,通过学习Abhishek的相关教程受益良多,因此,近期他在medium上撰文对相关自然语言处理的知识做了梳理总结。

提起Abhishek Thakur,很多kaggler对他都非常熟悉,2017年,他在 Linkedin 发表了一篇名为Approaching (Almost) Any Machine Learning Problem的文章,介绍他建立的一个自动的机器学习框架,几乎可以解决任何机器学习问题,这篇文章曾火遍 Kaggle。

Abhishek在Kaggle上的成就:

-

Competitions Grandmaster(17枚金牌,世界排名第3) -

Kernels Expert (Kagglers排名前1%) -

Discussion Grandmaster(65枚金牌,世界排名第2)

登录查看更多

相关内容

Arxiv

5+阅读 · 2019年8月27日