SuperGAT,如何自适应的设计图注意力方案:同质性和平均度数

本文核心:提出SuperGAT模型,通过对图网络中存在的边对节点表示学习进行调整,主要是将图网络中的边是否存在这个点以损失形式加入到loss函数中,并探讨了影响图注意力机制的两个重要因素: homophily和average degre.

下载地址:https://openreview.net/forum?id=Wi5KUNlqWty

GITHUB:https://github.com/dongkwan-kim/SuperGAT

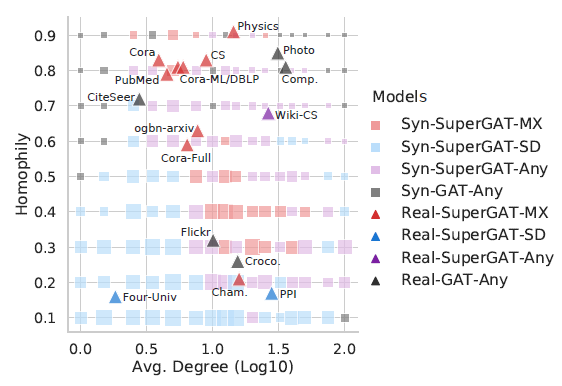

注意力机制在图神经网络中十分重要,通过计算邻居节点对中心节点影响的权重大小来更好的进行图表示学习。但是,当图中含有大量噪音信息时,如何来设计更优的注意力方案,本文提出了SuperGAT模型a self-supervised graph attention network。SuperGAT模型通过自监督任务来预测边是否存在来解决GAT存在的问题,通过对edge进行编码,SuperGAT在区分错误连接的邻居时学习到了更合适的注意力权重,这点类似于自监督学习中通过改变网络节点的连接关系来进行网络数据去噪的方法。同时本文发现图神经网络中影响注意力机制效果的两个重要因素: 图的homophily和average degree,探索了什么样的图神经网络应该选择何种注意力方案。

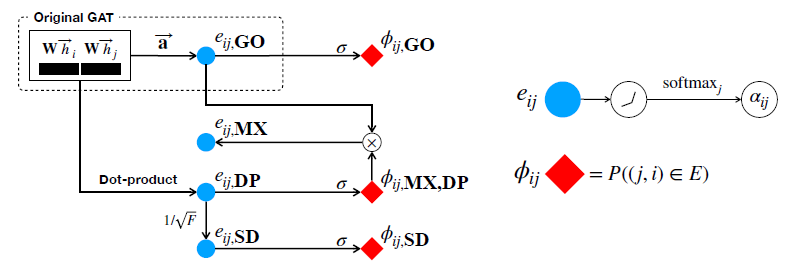

文中通过结合原始GAT模型提出了四种注意力的设计方案,分别是: GO、DP、SD和MX

DP方案指的是将两个节点特征向量相乘

由三部分构成,其中第一项是分类损失函数,最后一项是正则项,中间一项则是来控制两个节点之间的边是否存在,如果两个节点在网络中不存在边,则经过计算后中间一项损失会很大,相当于是能够通过图网络中的已知边的关系来调整节点表征的学习。

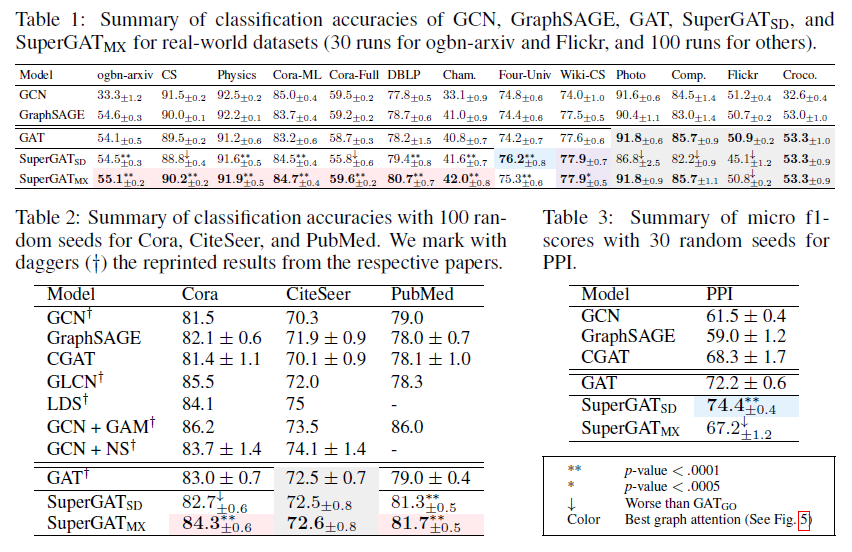

本文的实验部分挺多,首先是提出了四个问题并进行了解答,分别是

RQ1. 注意力机制能否学习到节点标签的一致性;

RQ2. 注意力机制能够预测边的存在;

RQ3. 如何自适应的设计图注意力方案;

RQ4. 基于RQ3的设计选择是否适用于真实世界的数据集。