【干货教程】从零开始学习Transformer,手把手写代码带你搞会,11页pdf细致笔记

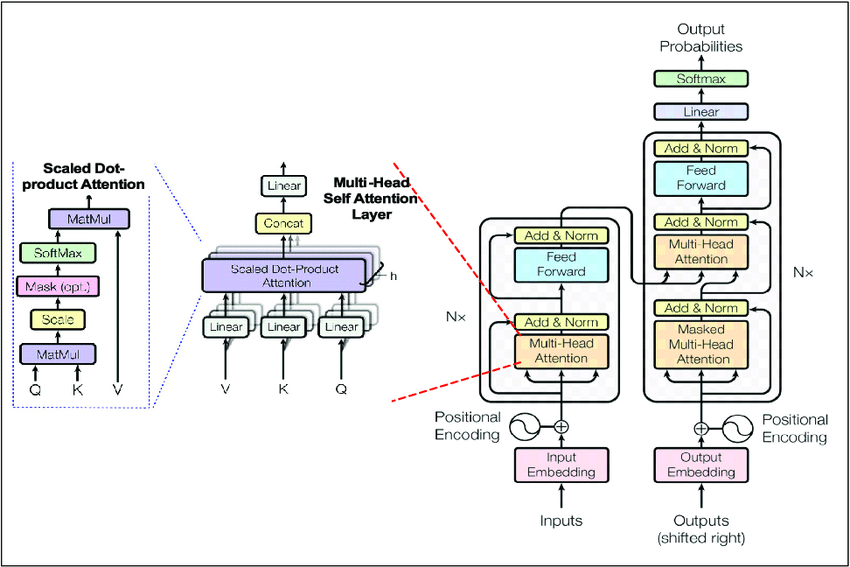

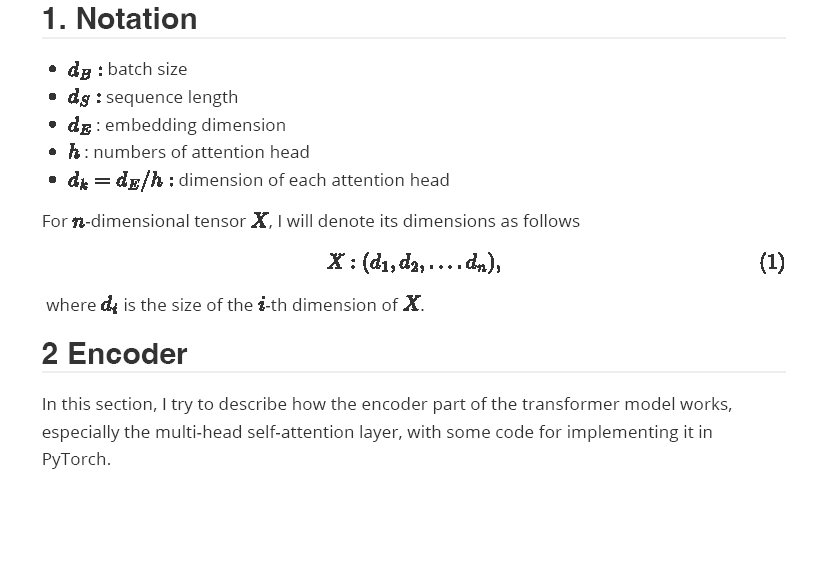

本文包含transformer模型的一些细节,当我第一次尝试从头实现它时,我发现这些细节有点令人困惑。本文并不是对transformer 模型的完整解释,因为在网上已经可以找到大量有用的材料。下面是一些为各种任务实现transformer 模型的示例。

https://github.com/hbchen-one/Transformer-Models-from-Scratch

用于文本分类的仅编码器transformer 模型:

经过训练的只有解码器transformer 模型(GPT-like)进行n位数加法

全transformer模型(编码器+解码器)机器翻译

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“T11” 就可以获取《【干货教程】从零开始学习Transformer,手把手写代码带你搞会,11页pdf细致笔记》专知下载链接

登录查看更多

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

Arxiv

27+阅读 · 2021年6月16日