北大、哈佛等NeurIPS新作:基于公理系统解释集成模型的决策过程

本文是NeurIPS 2020入选论文“Explainable Voting”的解读,该项研究由北京大学、普渡大学、哈佛大学联合完成。

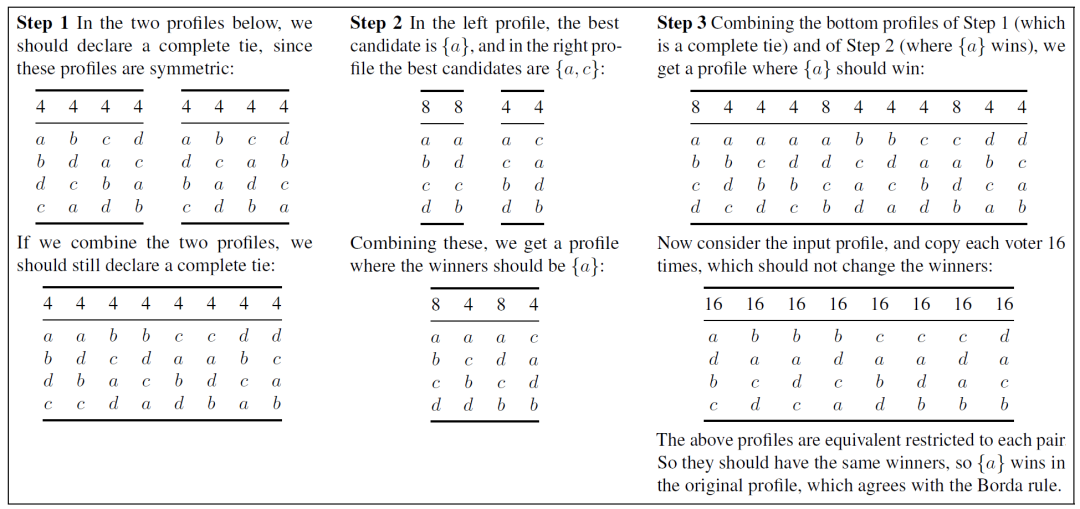

将输入给分解成若干子输入。

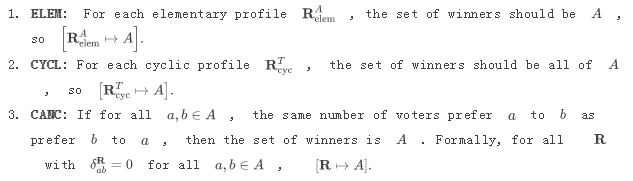

对于每个子输入,使用其于对称性和有效性的公理来得到相应的胜者。例如对于 (a, b, c); (b, a, c),由于在这个输入中 a, b 的位置是对称的,且严格优于 c,因此可以得到这个子输入的胜者应该是 {a, b}。

最后将所有子输入的胜者给合并起来,这里合并的途径是利用相容性公理。例如对于 (a, b, c) 和 (a, b, c); (b, a, c) 这两个子输入,由于前者的胜者是 {a},后者的胜者是 {a, b}。我们可以得到 (a, b, c); (a, b, c); (b, a, c) 的胜者一定是 {a}({a}和{a,b} 的交集)。

长度的解释,其中

长度的解释,其中

是候选人的个数。

是候选人的个数。

维空间,并且公理能被上述4个元公理所刻画,那么是不可能找到比

维空间,并且公理能被上述4个元公理所刻画,那么是不可能找到比

更短的解释的。

利用这个定理,我们得到了几个推论:

更短的解释的。

利用这个定理,我们得到了几个推论:

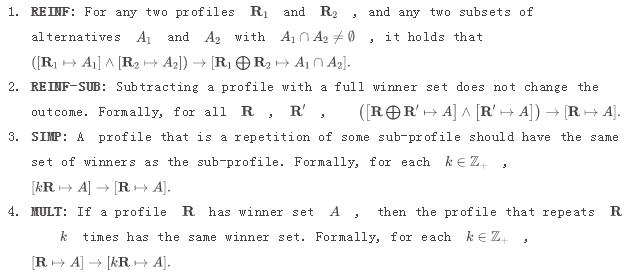

Borda 不能在

步数内被解释,结合上界,我们得到了 Borda 在7个公理下的解释长度为

。

Plurality 不能在

步数内被解释。

Approval 不能在

步数内被解释。

最后,值得一提的是我们下界不仅在最坏的情况下成立,它对于几乎所有的输入都成立。

的解释步数是完全可以接受的,相反,在 ensemble learning 和 virtual d

emocracy 的例子中,候选方法可能非常非常多,因此一个

的解释步数是完全可以接受的,相反,在 ensemble learning 和 virtual d

emocracy 的例子中,候选方法可能非常非常多,因此一个  的解释可能是无法接受的。

在这样的场景中,我们要下界就能帮助识别哪些是好的,可用的,哪些是不可用的投票与解释。

的解释可能是无法接受的。

在这样的场景中,我们要下界就能帮助识别哪些是好的,可用的,哪些是不可用的投票与解释。

“CCF-NLP走进高校”是由中国计算机学会自然语言处理专业委员会(CCF-NLP)发起,联合AI研习社及各个知名高校开展的一系列高校NLP研究分享活动。

“CCF-NLP走进高校”第四期将走进“新疆大学”,一起聆听新疆大学NLP的前沿研究分享。本次活动邀请的嘉宾有哈尔滨工业大学(深圳)教授徐睿峰、清华大学计算机系长聘副教授黄民烈、天津大学教授熊德意、复旦大学教授黄萱菁、新疆大学教授汪烈军、西湖大学特聘研究员张岳。敬请期待!

点击阅读原文,直达直播页面