AAAI 2019 | 基于不同颗粒度语言联合训练的表示学习

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

作者丨姜松浩

学校丨中国科学院计算技术研究所硕士生

研究方向丨机器学习、数据挖掘

语言的表示是自然语言处理中的基础问题也是重要问题,常见的分布式词向量 Word2Vector、Glove 等方法令很多 NLP 研究者和从业人员都受用无穷。然而现有的方法同样存在这诸多问题,本文通过不同颗粒度的有监督语言联合训练方式,实现端到端的语言表示来完成自然语言处理中的常见任务,这种方式具有更强的鲁棒性。

本文是剑桥大学和哥本哈根大学发表于 AAAI 2019 的工作,该方法采用分层次、分阶段获取重要特征的结构来实现不同颗粒度的语言表示学习的方法,并通过规定一些合理有效的目标函数来实现有监督联合训练的目的。

模型介绍

论文作者将其发表于 NAACL 2018 的论文模型 Zero-shot sequence labeling: Transferring knowledge from sentences to tokens [1] 进行改进的最新研究成果。

模型结构

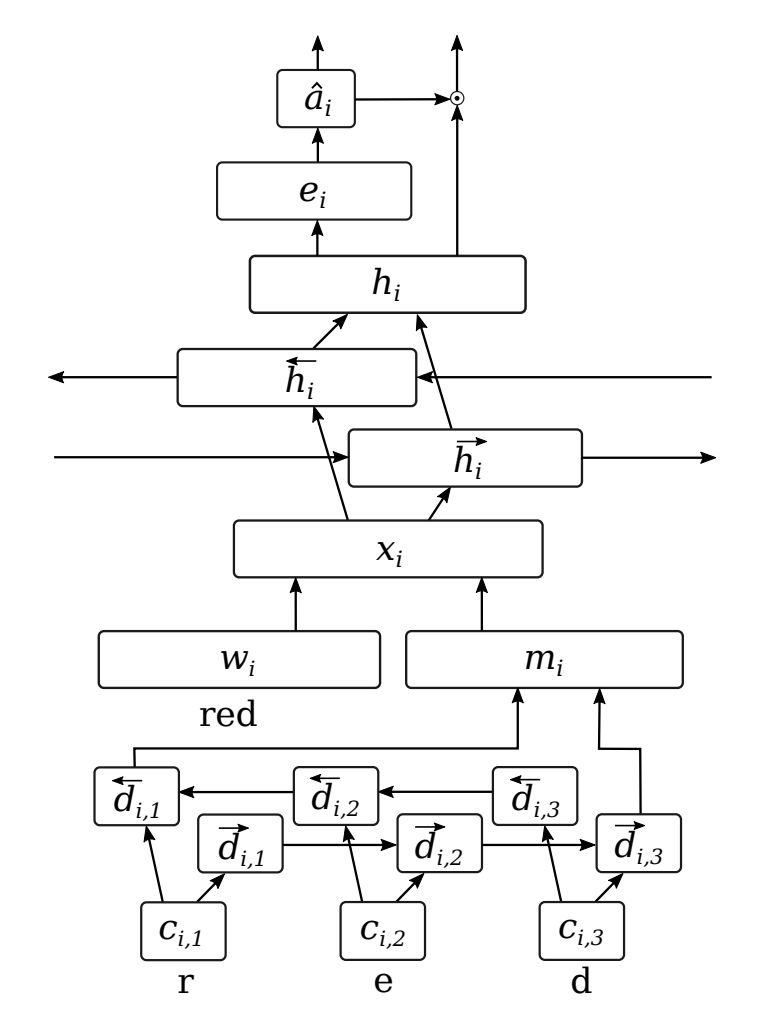

该模型如下所示,其将作者发表于 NAACL 2018 的模型 [1] 由单层结构改为多层结构,从模型结构来看与文本分类模型 HAN [2] 有一定的相似度,但在细节上却有不同的变化。

从整体看可以将模型为两个部分。首先,将词汇转化为字符级利用双向 LSTM 模型得到相应的词向量特征 m,然后将特征 m 与预训练(pre-train)词向量 w 进行矩阵的拼接处理得到更具鲁棒性和适应性的词向量 x;然后再将上一阶段得到的词向量 x 同样再次利用双向 LSTM 获得向量 h;最后再利用 self-attention 的方式获得词汇权重。

其方法上与 HAN [2] 如出一辙,该方法目的在于为针对不同任务具有不同重要性的单位词汇分配不同权重,再通过不同权重的词向量组合得到相应的句向量表示结果 s。

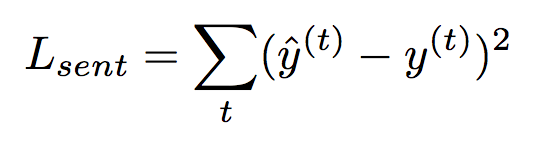

该文章的亮点在于提出了几种有特点的目标函数(损失函数)来实现有监督联合训练方式。其中一个就是如下所示的函数,被作者定义为语句级别的目的函数。

该目的函数采用平方损失函数,其中上标 y 表示句向量 s 的带 Sigmoid 激活函数的全连接计算预测结果,而 y 表示为有标注的实际结果。作者选用 Sigmoid 激活函数的目的是进行语句二分类,当然对于不同的多分类任务,也可以将激活函数拓展为其他。

有监督的注意力机制

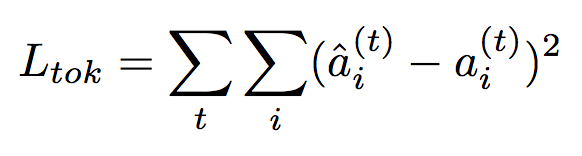

与以往的端到端联合训练的注意力机制不同,作者为得到更好的词汇注意力权重,提出了有监督的注意力方式,该方式利用词汇标注,其函数表示如下所示。

该函数同样采用平方损失,其中上标 a 表示为模型预测的注意力权重,而 a 表示为标注的注意力权重即 1 或者 0。作者将其定义为词汇级别的损失函数。

语言模型的目标函数

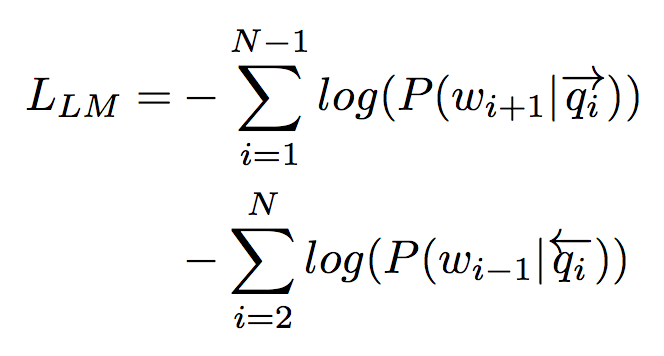

作者为实现模型对自然语言处理的其他任务的特征表示的鲁棒性,加入了语言模型的目的函数,其函数如下所示。

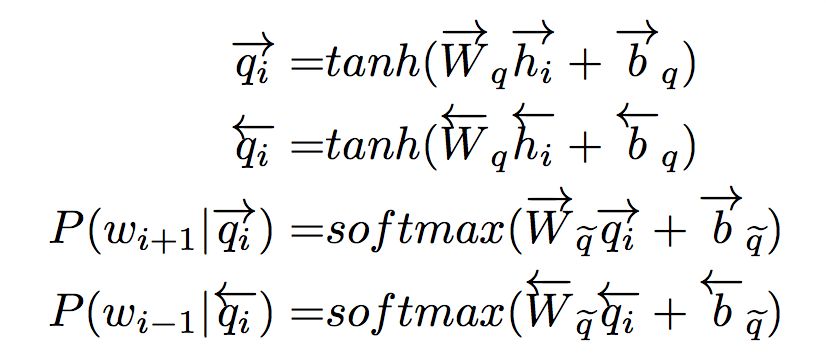

目标函数中,定义了 LSTM 中第 i 个词汇的前向向量 q 对于第 i+1 词的条件概率的 log 损失,以及第 i 个词汇的前向向量 q 对于第 i-1 词的条件概率的 log 损失。对于词汇的条件概率计算过程如下公式所示。

字符级语言模型的目标函数

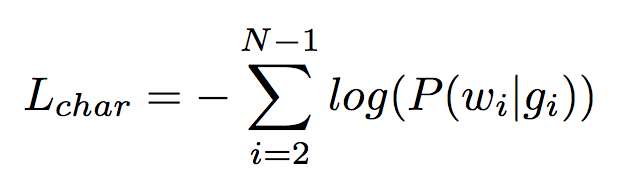

字符级的语言模型目标函数如下所示,该函数与上述语言模型目标函数的总体目的是一致的,但在词汇预测的条件概率计算方式上略有不同。

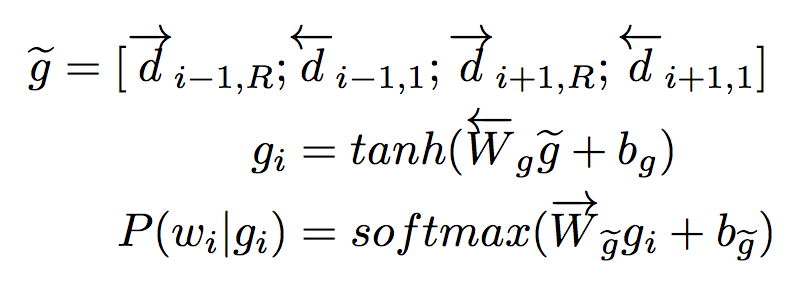

字符级语言模型,利用第 i-1 词中的字符基于 LSTM 得到的前向与后向向量,以及第 i+1 词中的字符前向后向向量构成的预测向量 g 来预测第 i 个词汇。其计算过程如下所示。

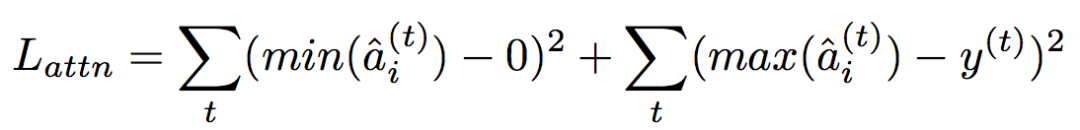

控制注意力权重表示范围的目标函数

该目标函数目的在于实现注意力权重的合理分配,该方法的提出基于两种假设:

1. 一句话中只有部分词汇(token)具有积极作用;

2. 对于有积极作用的词汇而言,是在整句的全局作用中具有全局作用。

因此基于上述两种假设,作者提出了控制注意力权重表示范围的目标函数,函数如下所示。

该函数的目的是将无效词汇的注意力权重逐渐趋近于 0,而重要词汇的权重则趋近于 1。

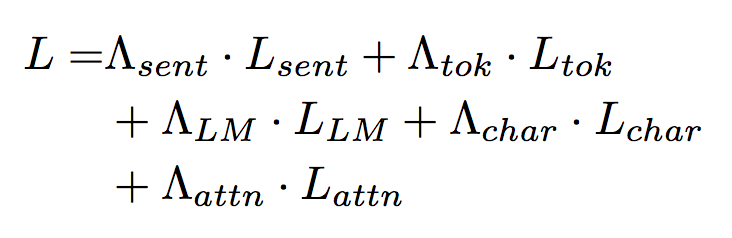

模型联合训练的目标函数定义

为实现不同颗粒度语言特征的端到端表示的联合训练,将目标函数定义如下。

该函数定义了超参数,其作用是对于自然语言处理中的不同任务分配不同的目标权重来更好地完成任务。例如将语句的损失函数参数定义为 1 其他为 0 时可用于语句分类。

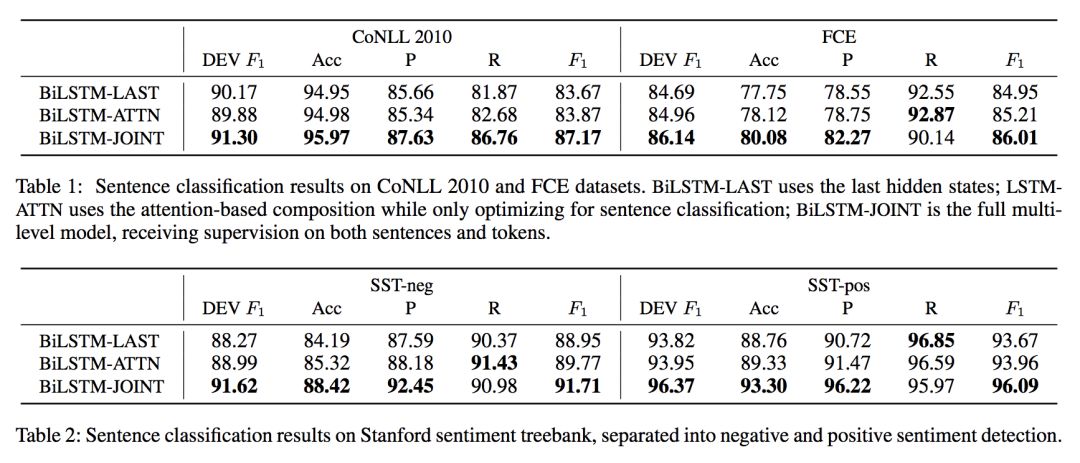

模型实验效果

作者通过对文本分类和情感分析等经典数据集的实验结果测试得出结论,该文中提出的联合方法效果最佳。实验结果如下所示,其中 BiLSTM-LAST [3-4] 是常见的双向 LSTM 的方法,BiLSTM-ATTN 即为 HAN [2]。

此外由于词汇标注的人工成本极高,为达到良好效果,文章中实验发现仅需 20% 的词汇标注就能远超没有标注过的样本训练结果。同时发现当超过 20% 样本的词汇标注时,其变化与 20% 左右的样本词汇标注效果差距并不明显。

论文评价

这篇论文的模型结构无大创新,但其在定义目标函数上有极强的创造性。本文作者对模型中的每个细节理解到位,并且为了模型发挥到极致,将其与有监督的目标函数相结合,这种做法值得学习。

然而文中提到的部分目标函数与人工标注相关联,尽管作者通过实验认为 20% 的标注就能达到很好的效果,但这同样增加了人工成本。

参考文献

[1] Rei, M., and Søgaard, A. 2018. Zero-shot sequence labeling: Transferring knowledge from sentences to tokens. NAACL-HLT.

[2] Yang, Z.; Yang, D.; Dyer, C.; He, X.; Smola, A.; and Hovy, E. 2016. Hierarchical Attention Networks for Document Classification. AACL:HLT.

[3] Tang, D.; Qin, B.; and Liu, T. 2015. Document modeling with gated recurrent neural network for sentiment classification. EMNLP.

[4] Neelakantan, A.; Le, Q. V.; and Sutskever, I. 2016. Neural programmer: Inducing latent programs with gradient descent. ICLR.

本文由 AI 学术社区 PaperWeekly 精选推荐,社区目前已覆盖自然语言处理、计算机视觉、人工智能、机器学习、数据挖掘和信息检索等研究方向,点击「阅读原文」即刻加入社区!

点击标题查看更多论文解读:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢? 答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码