AAAI'22 | "简单"的无监督图表示学习

1 引文

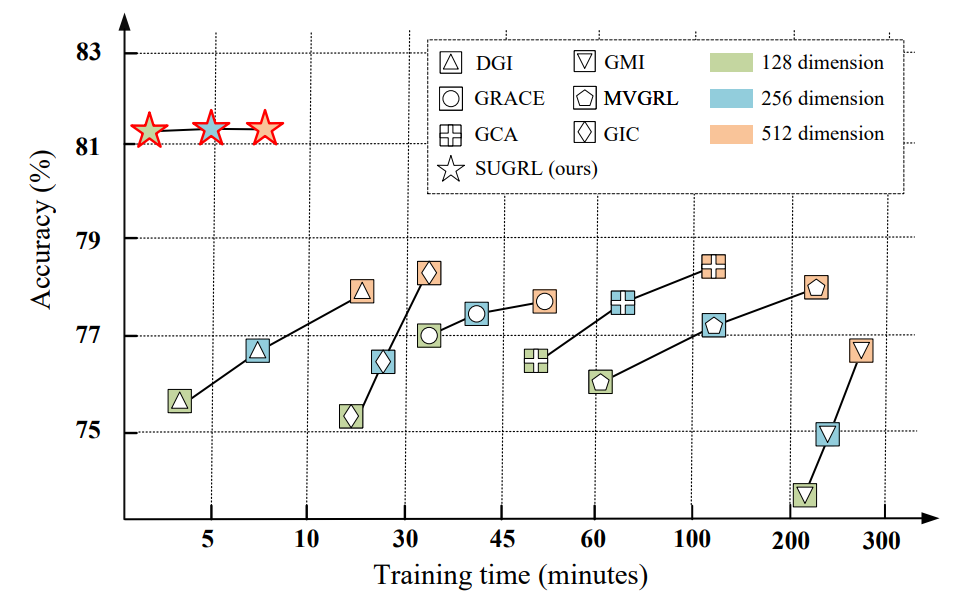

由于图神经网络的广泛应用,无监督图表示学习(Unsupervised Graph Representation Learning,UGRL)最近也得到了广泛关注,它不需要大量标记节点进行训练。UGRL能够通过同时学习表示并保持样本的局部结构来输出有区别的表示,区别表示确保下游任务输出有效的模型,使UGRL在实际应用中表现出显著的性能,对比学习作为UGRL的代表方法之一,被提出以最大限度地提高输入内容与其相关内容之间的互信息。图对比学习方法的主要区别在于输入内容及其相关内容的定义,通过各种数据增强,例如属性掩蔽或边缘扰动,最大化每个节点两视图之间的MI。虽然之前的方法在表示学习的许多任务中都是有效的,但它们通常依靠数据增强来生成输入内容及其相关内容,以实现MI最大化,这导致了训练过程的昂贵计算成本。因此,以往的方法通常都是低效的,特别是对于大规模的数据集,如图1所示,以往的方法随着样本数量或嵌入维数的增加,计算成本会急剧增加。

2 模型框架

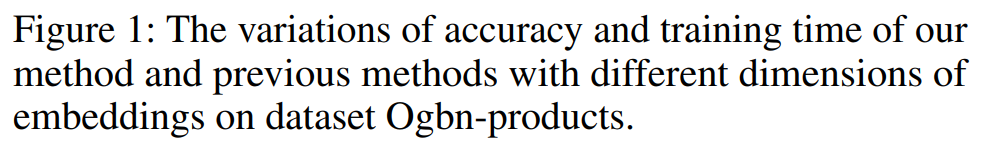

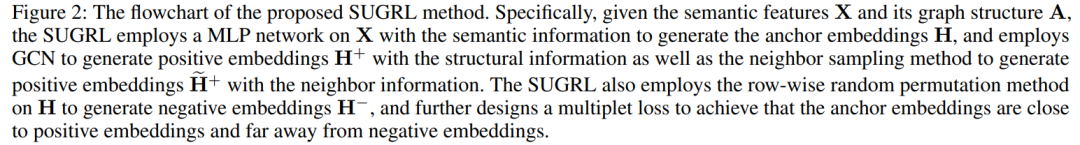

本文提出了一种新的对比学习方法,即简单无监督图表示学习(Simple Unsupervised Graph Representation learning, SUGRL),以实现表示学习的有效性和可扩展性,如图2所示。具体而言,作者首先在具有语义信息的输入表示上采用多层感知器(MLP)生成锚点嵌入,然后分别采用图卷积网络(GCN) 和邻居采样方法生成两种不同类型的正嵌入,然后对锚杆嵌入采用逐行随机排列方法生成负嵌入。作者进一步设计了一种新的多重值损失来强制锚点嵌入接近正嵌入而远离负嵌入,在缩小类内变异的同时扩大内间变异。模型框架如下所示:

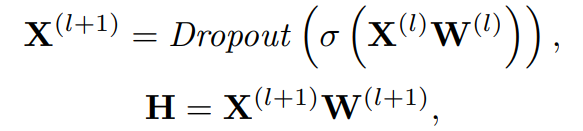

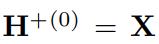

2.1 锚点嵌入和负嵌入生成

,

,

是激活函数,

是激活函数,

是第l层的权重矩阵,对于负嵌入的生成,常用的方法是从原始图中得到一个损坏的图,然后对其用GCN进行处理。相比之下,作者直接对锚点嵌入行洗打乱,得到负嵌入,进一步减少了训练时间。

是第l层的权重矩阵,对于负嵌入的生成,常用的方法是从原始图中得到一个损坏的图,然后对其用GCN进行处理。相比之下,作者直接对锚点嵌入行洗打乱,得到负嵌入,进一步减少了训练时间。

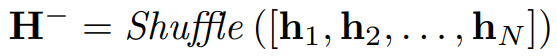

2.2 正嵌入生成

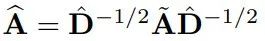

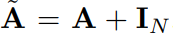

2.2.1 结构信息

,

,

代表第l层的特征。

代表第l层的特征。

是标准化的邻接矩阵,

是标准化的邻接矩阵,

是

是

的度矩阵,

的度矩阵,

是单位矩阵,作者这里的权重矩阵

是单位矩阵,作者这里的权重矩阵

和上文MLP中的是同一个,以此来降低时间成本。

和上文MLP中的是同一个,以此来降低时间成本。

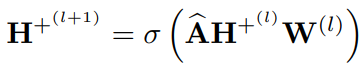

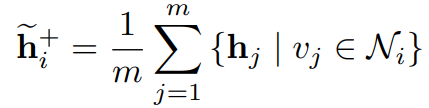

其中m为采样邻居的个数,Ni表示节点vi的一阶邻居集合。

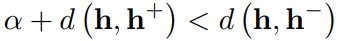

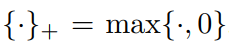

考虑到锚点嵌入、正嵌入和负嵌入,对比学习的目的是使正对(即锚点和正嵌入)紧密结合,而使负对(即锚点和负嵌入)远离。许多对比学习方法都设计了一个鉴别器(如双线性层)来区分正对和负对,但这个鉴别器非常耗时。此外,减小泛化误差对UGRL来说也很重要,因为在训练过程中如果泛化误差小,可能会提高对比学习的泛化能力,而减小类内变异或扩大类间变异已被证明是降低泛化误差的有效方法。

是相似度测量方法,

是相似度测量方法,

是一个非负值来确保正负样本之间的安全距离。通过对所有负样本求和,上式能扩展为:

是一个非负值来确保正负样本之间的安全距离。通过对所有负样本求和,上式能扩展为:

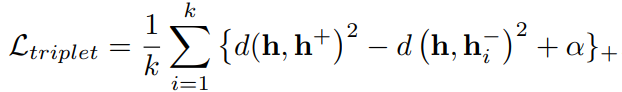

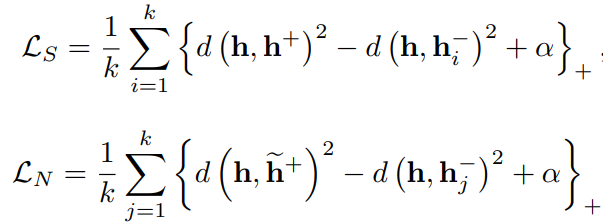

,k是负样本的个数。为了增加类间差异,作者拉大正负样本之间的距离。为了达到以上目的,作者在两个不同类别的正样本上执行以下操作:

,k是负样本的个数。为了增加类间差异,作者拉大正负样本之间的距离。为了达到以上目的,作者在两个不同类别的正样本上执行以下操作:

和

和

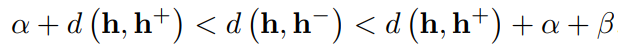

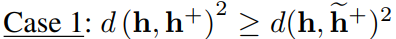

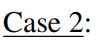

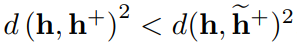

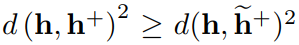

,如果

,如果

,

,

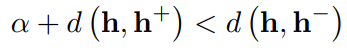

在上面第二个式子中可能为零,而在第一个式子中依旧不为0,从而可以进一步优化,使类间距离变大,同样,第二种情况也可以继续使类间距离变大。根据以上分析,Case 1或Case 2都可以放大类间变异。特别是如果其中一种无效,另一种仍将有效,进一步扩大类间的差异。上式表明

在上面第二个式子中可能为零,而在第一个式子中依旧不为0,从而可以进一步优化,使类间距离变大,同样,第二种情况也可以继续使类间距离变大。根据以上分析,Case 1或Case 2都可以放大类间变异。特别是如果其中一种无效,另一种仍将有效,进一步扩大类间的差异。上式表明

和

和

之间的距离应该要比

之间的距离应该要比

大,但它忽略了锚点和正嵌入之间的距离。如果锚点与正嵌入之间的距离较大,上述两个式子的值依旧可以非零,这种情况下,节点间的内部差异就很大,不利于模型的整体优化。为了解决这个问题,作者通过以下目标函数研究了负对和正对的上界(即α + β):

大,但它忽略了锚点和正嵌入之间的距离。如果锚点与正嵌入之间的距离较大,上述两个式子的值依旧可以非零,这种情况下,节点间的内部差异就很大,不利于模型的整体优化。为了解决这个问题,作者通过以下目标函数研究了负对和正对的上界(即α + β):

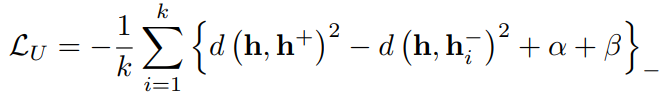

可知。因此,类内间的差异减少了。上式在累加负样本的损失之后,可以写为:

可知。因此,类内间的差异减少了。上式在累加负样本的损失之后,可以写为:

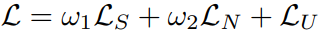

。最后,将上述损失整合,可以表示为:

。最后,将上述损失整合,可以表示为:

其中ω1和ω2分别是LS和LN的权值。

3 实验

3.1 数据集

在实验中,作者使用了8个常用的基准数据集,包括3个引文网络数据集(即Cora, Citeseer和Pubmed) , 2个亚马逊销售数据集(即照片和计算机),3个大型数据集(即Ogbn-arxiv、Ogbn-mag和Ogbn-products) 。

3.2 对比方法

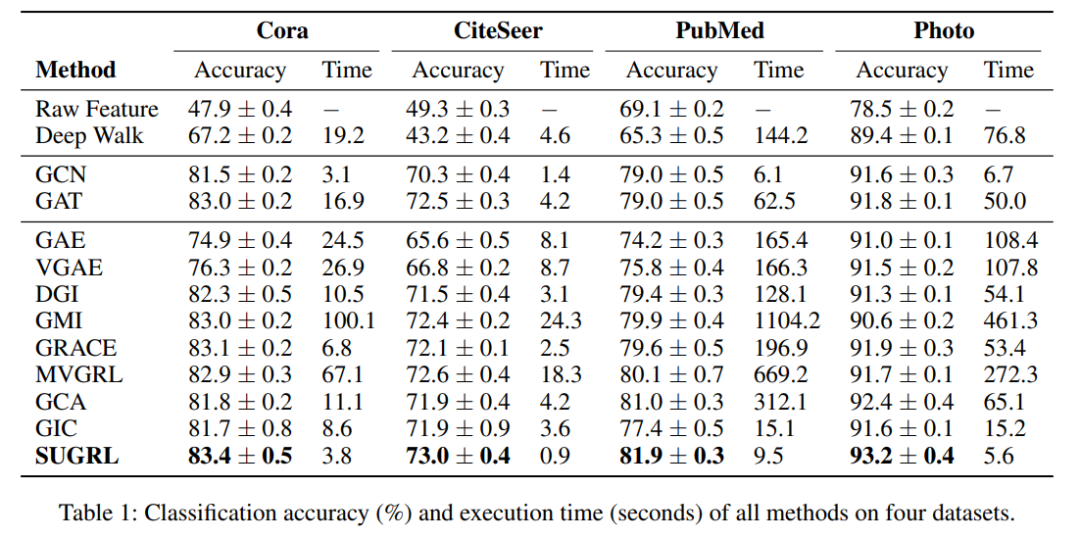

对比方法包括1种传统算法(即DeepWalk ), 2种半监督学习算法(即GCN 和GAT ),以及8种非监督学习算法(即Graph Auto-Encoders (GAE) ,变分图自动编码器(VGAE)、DGI 、GRACE 、GMI 、MVGRL和GCA 、GIC 。

3.3 实验结果

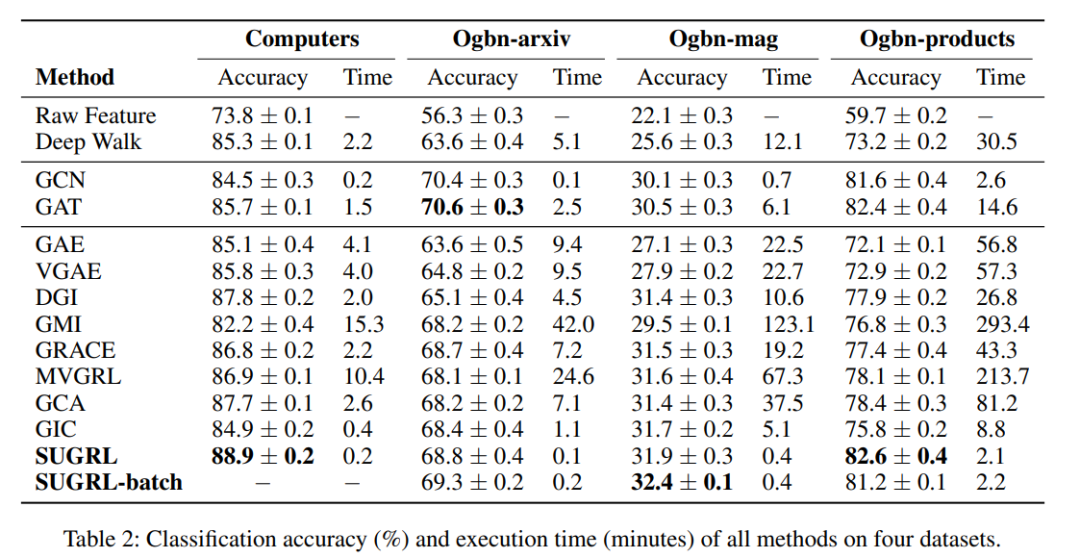

表1和表2总结了所有方法在8个实际图结构数据集上的分类精度和执行时间。

3.4 消融实验

SUGRL考虑三种信息,即语义信息、结构信息和邻居信息,生成两种具有对应对比损失的正对(LS和LN)。为了验证框架中各成分的有效性,作者分别研究了结构信息、邻居信息和上界的有效性,以及对比损失中各成分的有效性。

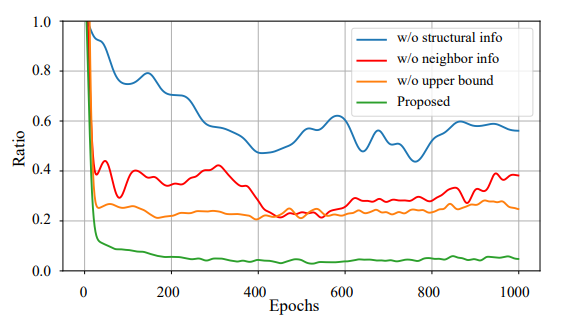

类内和类间差异之比的有效性。考虑到类内和类间变化的大小不同,将比率归一化为[0,1],在图3的数据集Photo上报告类内与类间变化的比率。首先,与本文方法相比,没有结构或邻居信息的方法通常输出更大的比率(即更小的类间变异)。二是无上界的方法,与作者的方法相比,还会输出更大的比率(即更大的类内变量)。这样就可以验证结构信息、邻居信息或上界信息的有效性。

4 结论

参考文献:

https://www.aaai.org/AAAI22Papers/AAAI-3999.MoY.pdf