![]()

©PaperWeekly 原创 · 作者 | 王馨月

单位 | 四川大学

研究方向 | 自然语言处理

![]()

![]()

Frequency-Aware Contrastive Learning for Neural Machine Translation

论文链接:

https://arxiv.org/abs/2112.14484

低频词预测在现代神经机器翻译(neural machine translation, NMT)系统中仍然是一个挑战。最近的自适应训练方法通过强调它们在整体训练目标中的权重来促进不常用词的输出。尽管低频词的召回率有所提高,但它们的预测精度却意外地受到自适应目标的阻碍。

这篇文章的作者提出了一种频率感知 token 级对比学习方法(Frequency-aware token-level Contrastive Learning method , FCL),其中每个解码步骤的隐藏状态都以基于相应词频的软对比方式推离其他目标词的对应物。作者在 NIST 中英和 WMT14 英德实证结果表明,本文提出的方法不仅可以显著提高翻译质量,还可以增强词汇多样性并优化单词表示空间。进一步的研究表明,与相关的自适应训练策略相比,本文的低频词预测方法的优势在于在不牺牲精度的情况下跨不同频率的 token 级召回的鲁棒性。

![]()

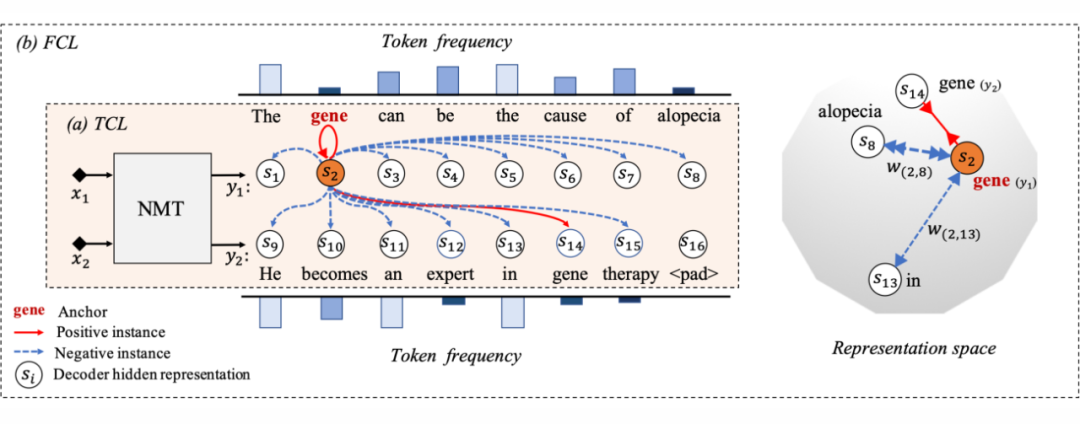

上图是令牌级对比学习(Token-level Contrastive Learning, TCL)和频率感知对比学习(Frequency-aware Learning, FCL)的示例。(a)TCL 对比批量目标标记的标记级隐藏表示

。对于第一个句子

中的锚点“gene”,它的正值有两个来源,即它的具有 dropout 噪声的对应物(由红色箭头表示)和

中的“gene”。(b)FCL 进一步利用 token 频率信息来应用频率感知软权重

进行对比。因此,相对不常见的标记(例如,“gene”和“alopecia”)之间的对比效果被放大,并且它们可以在表示空间中被进一步拉开。

![]()

![]()

![]()

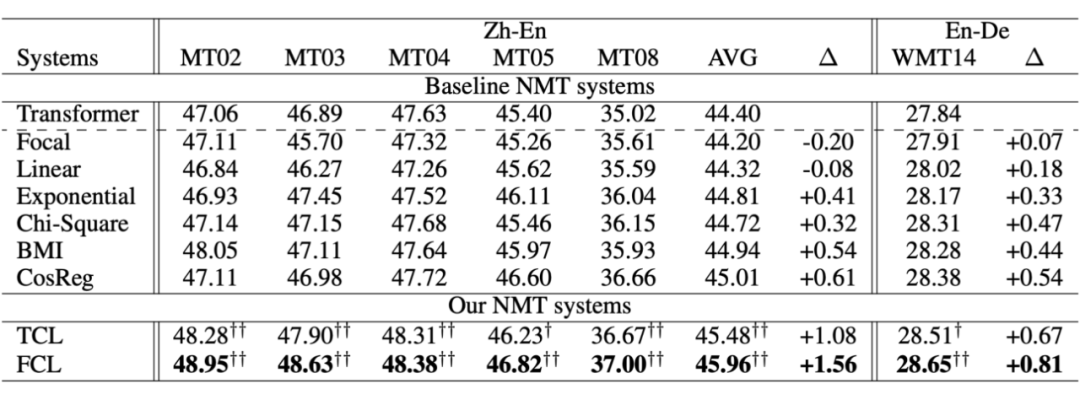

上图是作者在 NIST Zh-En 和 WMT14 En-De 实验的主要结果。可以看出使用 TCL 和 FCL 都在各方面上有了显著提升。作者在原文中还对低频 token 的翻译质量、词汇多样性等方面的影响做了实验和探讨。

![]()

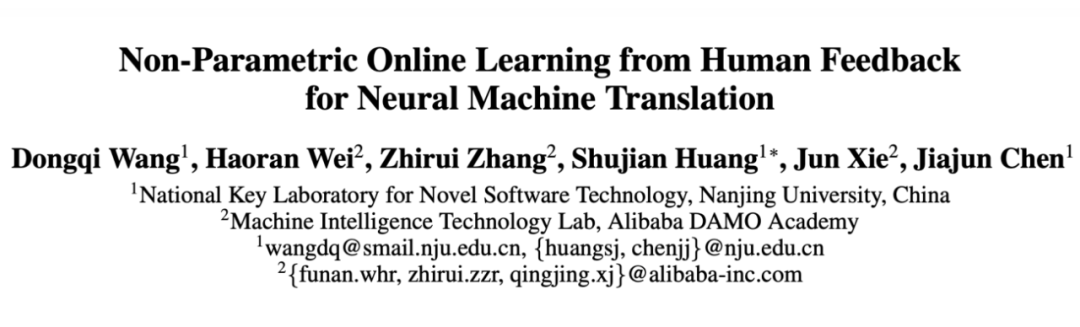

Non-Parametric Online Learning from Human Feedback for Neural Machine Translation

论文链接:

https://arxiv.org/abs/2109.11136

代码链接:

https://github.com/wangqi1996/KoK

这篇文章的作者针对机器翻译(NMT)任务提出了一种新的无需改变模型结构的非参数在线学习方法。该方法引入了两个 k-nearest-neighbor(KNN)模块:一个模块记忆人工反馈,即人工翻译提供的正确句子,另一个模块自适应地平衡历史人工反馈和原始 NMT 模型的使用。在 EMEA 和 JRC-Acquis 基准上进行的实验表明,作者提出的方法在翻译准确度上取得了显著提高,并以更少的重复人工校正操作实现了更好的适应性能。

![]()

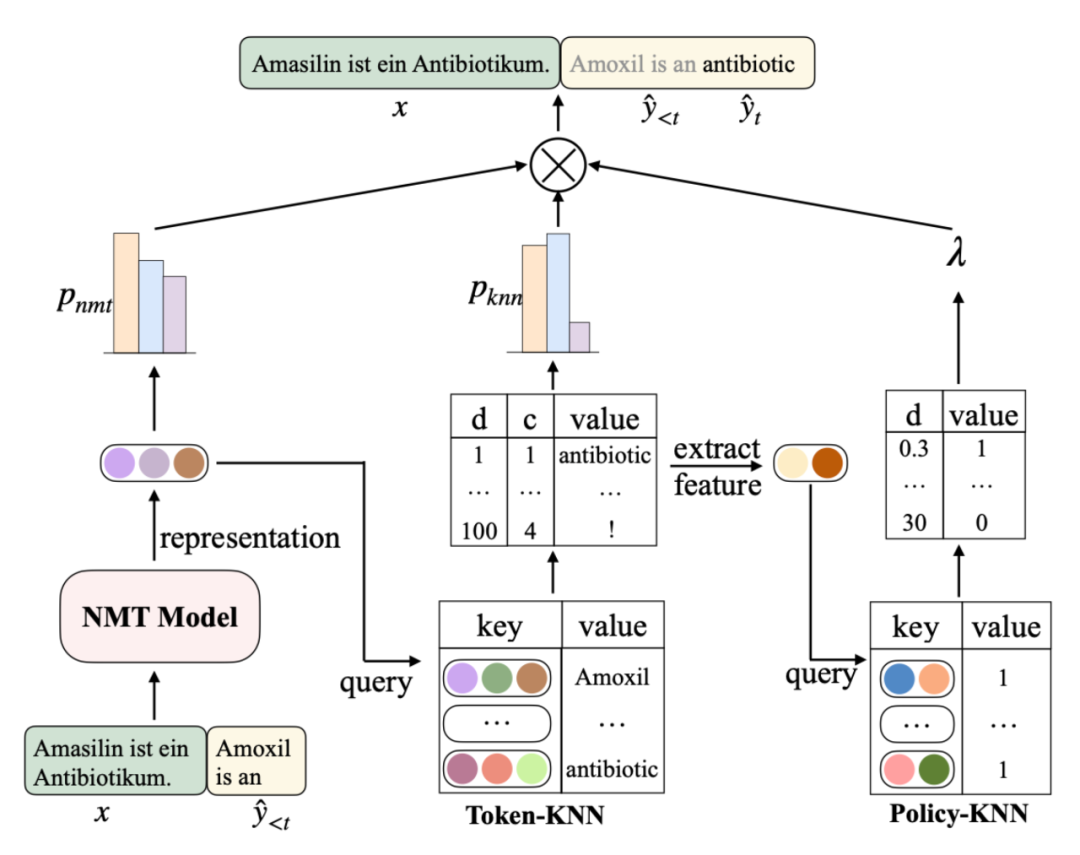

上图是本文提出的 KNN-over-KNN(KoK)模型的整体架构,除了预训练的 NMT 模型外,它还使用两个 KNN 模块对最终翻译概率进行参数化。

![]()

在一个句子的翻译过程中,对于每个解码步骤 t,Token-KNN 将隐藏表示

作为查询,并从其数据存储中检索以生成翻译概率 pKNN。然后从Token-KNN 的检索结果中提取的特征作为 Policy-KNN 的查询来计算

值。最终的平移概率被计算为 pKNN 和 pNMT 与

之间的插值。

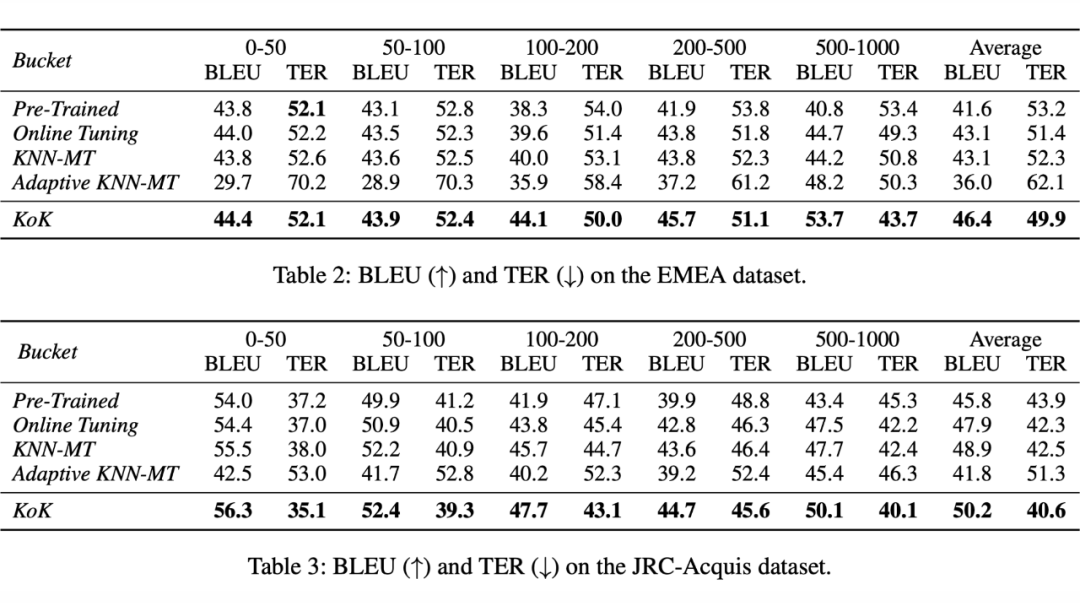

![]()

作者在 EMEA 和 JRC-Acquis 数据集上的实验结果如上图所示,可以看出 KoK 在多个方面都取得了不错的性能。作者在原文中还做了进一步的消融学习,值得进一步阅读。

![]()

![]()

Braid: Weaving Symbolic and Neural Knowledge into Coherent Logical Explanations

论文链接:

https://arxiv.org/abs/2011.13354

这篇文章的作者提出了一种称为 Braid 的新型逻辑推理器,它支持概率规则,并使用自定义统一函数和动态规则生成的概念来克服传统推理器中普遍存在的脆弱匹配和知识差距问题。

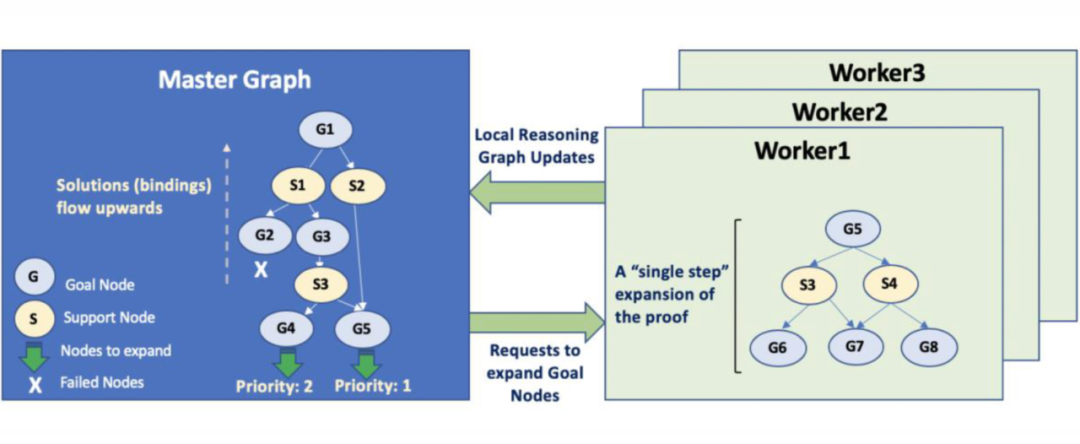

![]()

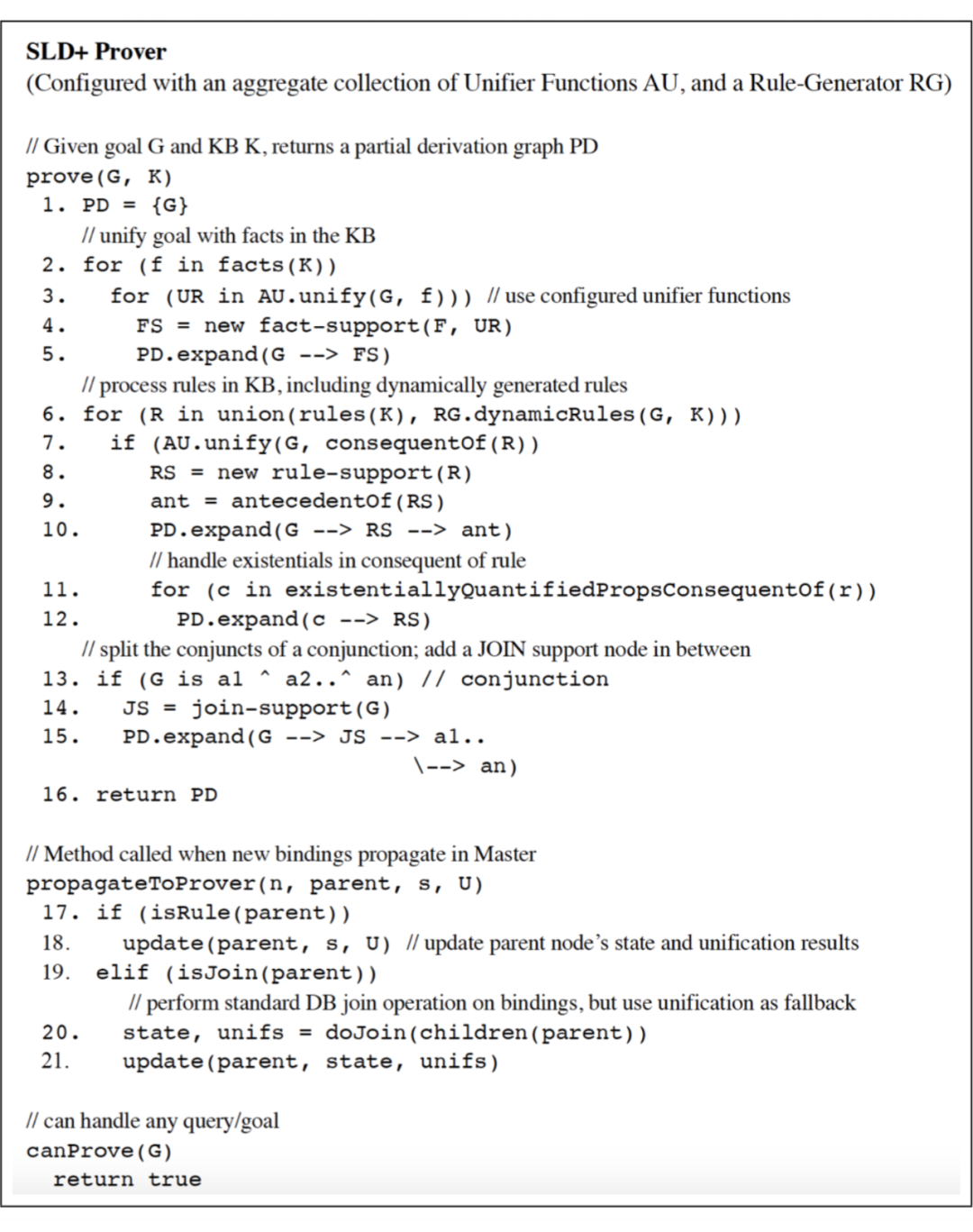

如上图所示,Braid 使用基于任务的框架,其中中央“Master”任务通过与一组“Worker”任务通信来构建输入目标的整个证明图,每个“Worker”任务都使用 Provers 执行基于本地图的推理。

Provers 中使用的推理算法有:一个扩展 SLD 并可用于解释任何查询的默认推理器,以及一个用于解释代理为何在给定故事中执行某些操作的专用推理器。

![]()

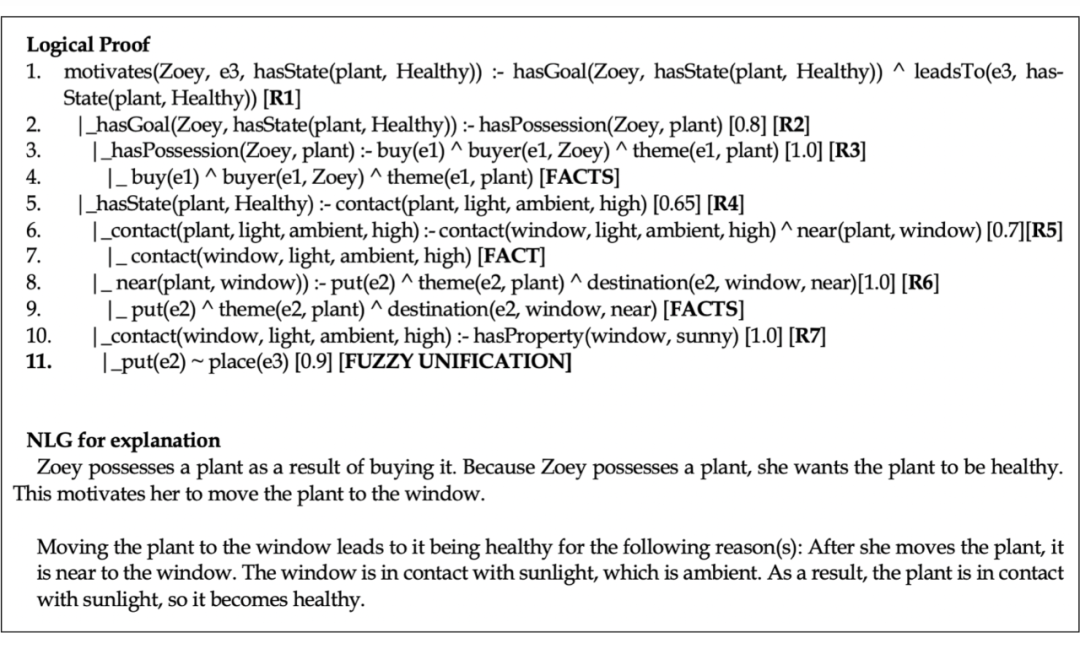

![]()

Braid 通过生成上图所示的证明树来解决激励示例。它首先使用 Agentful Action Prover(AAP)反向链接规则 R1,该规则首先查找 Zoey 的目标,然后检查 Zoey 执行的“put”操作(e3)是否可以导致她的目标之一(第1行)。子证明使用规则来推断 Zoey 希望她的植物健康(R2),并且植物与光接触会使其变得健康(R4)。请注意,R2、R4 和 R5 是由基于 GLUCOSE 的 DRG 动态生成的,而 R3、R6 和 R7 分别来自 Hector 本体中手动定义的“buy”、“put”和“sunny”的语义。最后,使用模糊统一函数来实现在此上下文中“put”和“place”是相似的动作。

![]()

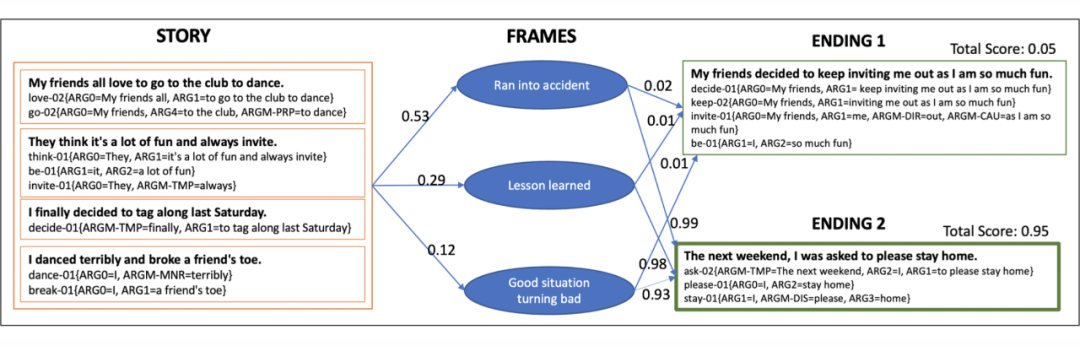

上图显示了 Braid 使用神经分类器找到的推理路径(用于检测给定故事的帧,以及结束给定的帧+故事),以及相 应的规则分数。

![]()

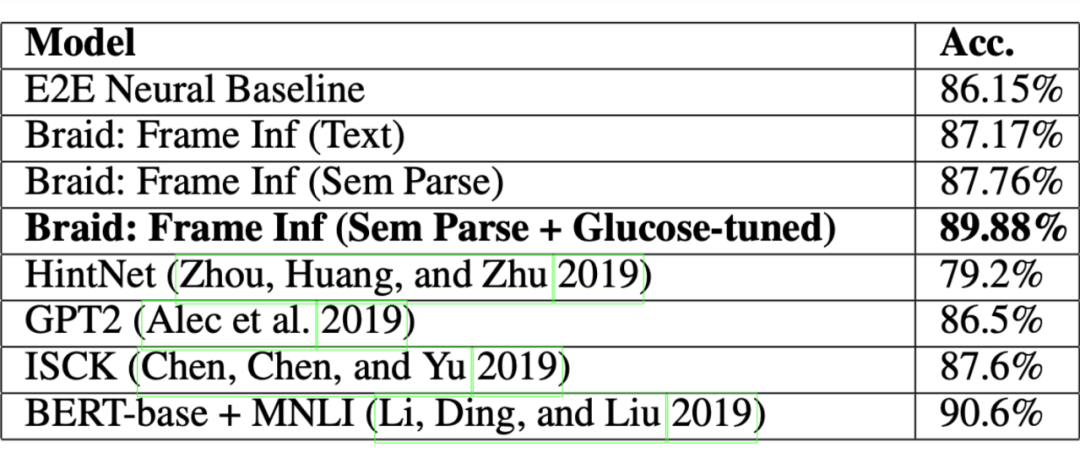

上图是作者在 ROC Story Cloze(Spring 2016)上的实验结果,可以看出 Braid 可以实现非常好的性能。

![]()

Automatic Product Copywriting for E-Commerce

论文链接:

https://arxiv.org/abs/2112.11915

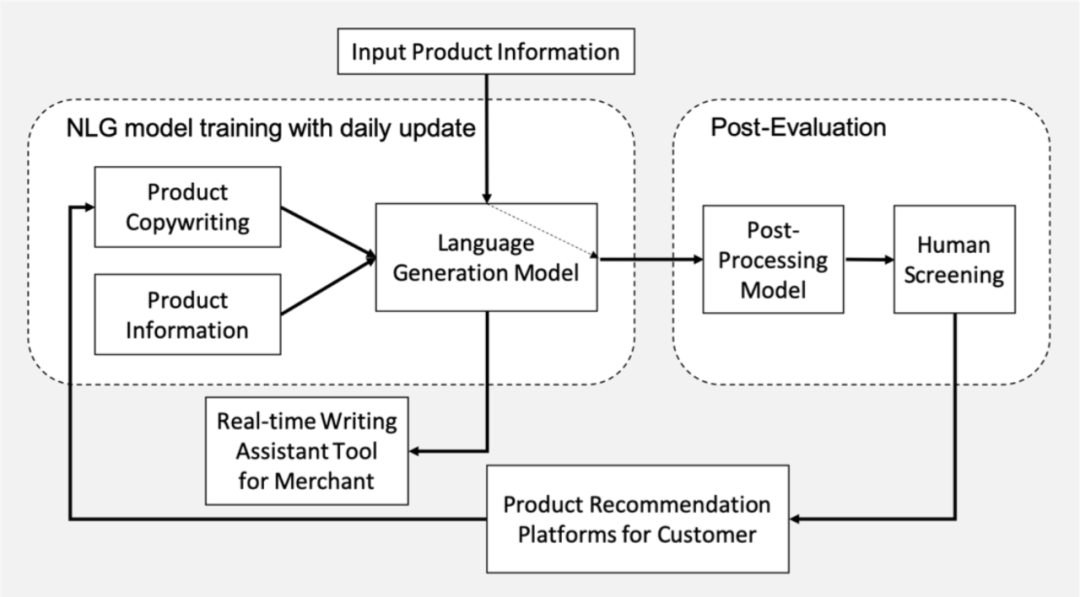

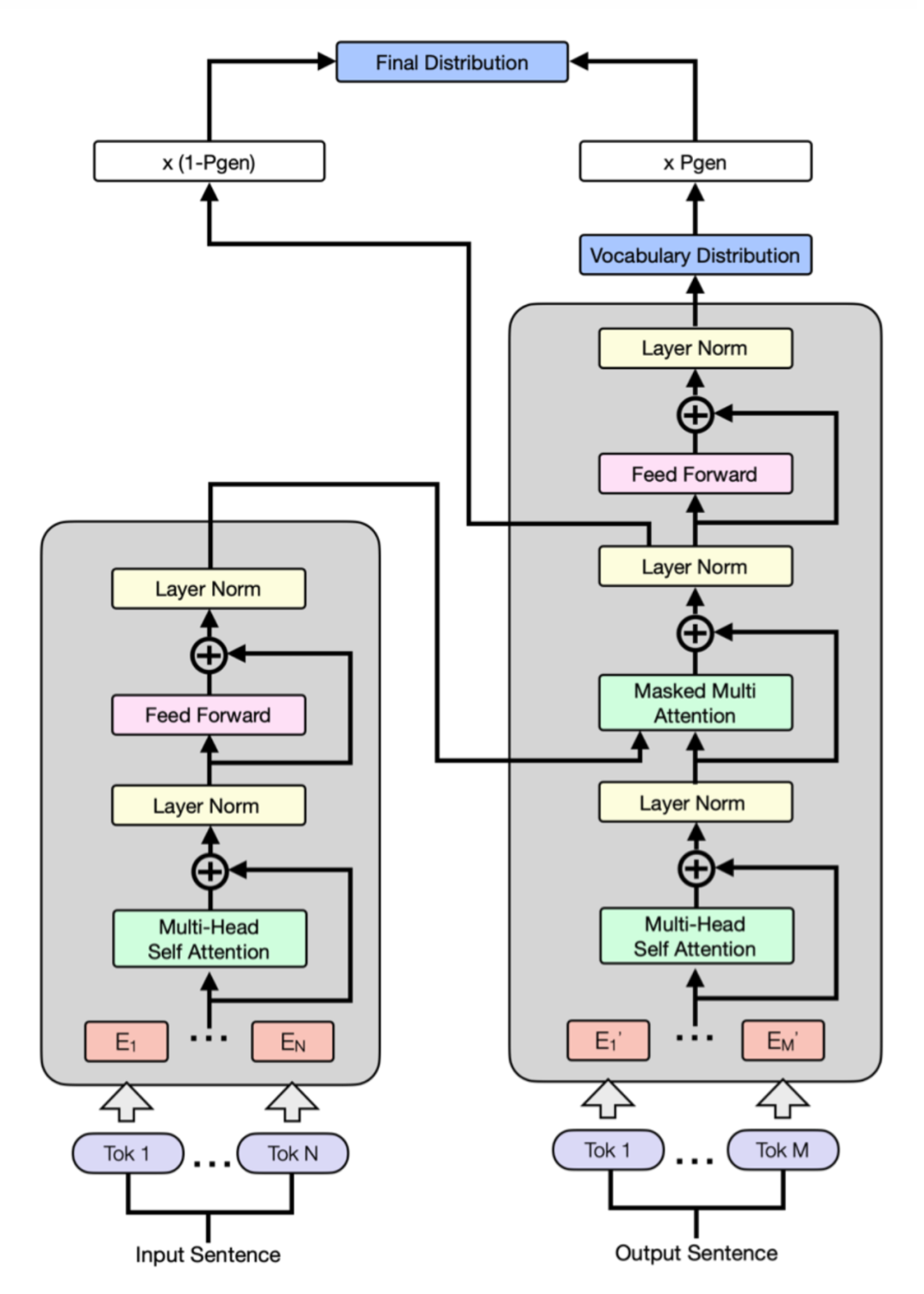

这篇文章是京东的一篇关于自动产品文案生产的文章,作者报告了将提议的自动产品文案生成(Automatic Product Copywriting Generation, APCG)系统部署到京东电子商务产品推荐平台的经验。它由两个主要部分组成:1)自然语言生成,它是由一个转换器指针网络和一个基于内部平台的数百万训练数据的预训练序列到序列模型构建的;2)文案质量控制,基于自动评估和人工筛选。对于选定的领域,模型每天都会使用更新的训练数据进行训练和更新。

此外,该模型还在京东的直播平台上用作实时写作辅助工具。APCG 系统自 2021 年 2 月开始在京东部署。截至 2021 年 9 月,它已生成 253 万条产品描述,将整体平均点击率(CTR)和转化率(CVR)提高了 5 倍。与基线相比,同比分别增长 4.22% 和 3.61%。与 2021 年 2 月相比,系统的累计总商品交易量(GMV)提高了 213.42%。

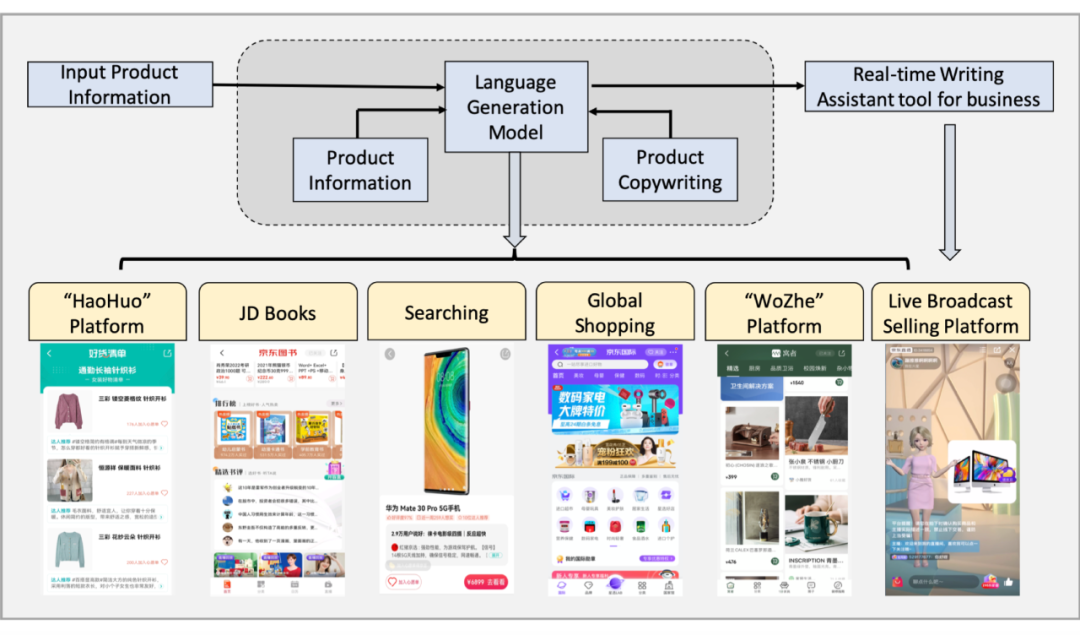

![]()

如上图所示,APCG 系统旨在服务于京东电子商务平台中的各种应用,包括“好货”产品推荐平台、京东图书、搜索、 全球购物、“窝者”平台和直播销售平台等。

![]()

1. NLG 模型训练:收集数据,包括产品信息和描述,用于训练 NLG 模型。根据不同的场景选择不同的模型。在这 个阶段应用了 transformer-pointer 网络和预训练的语言模型。transformer-pointer 网络的结构如下图所示:

![]()

2. 后评价供客户直接使用:这里采用后处理模型来过滤掉不符合要求的内容。在基于模型的过滤之后进行人工筛选。此处生成的内容直接供京东客户的产品推荐平台使用。

3. 卖家实时写作助手工具:除了基于提议的产品广告生成和过滤内容外,还为京东卖家开发了基于 APCG 的实时写作助手工具。通过这个工具,京东卖家可以输入他们想要的产品,它会自动生成产品描述。然后卖家可以编辑生成的内容,并将它们展示给客户。

4. 每日更新的自动程序:每天训练 APCG,以满足基于最新更新数据的最新写作偏好。

作者在原文中还进一步介绍了评估 APCG 系统的一些指标以及维护系统的成本,值得进一步阅读。

![]()

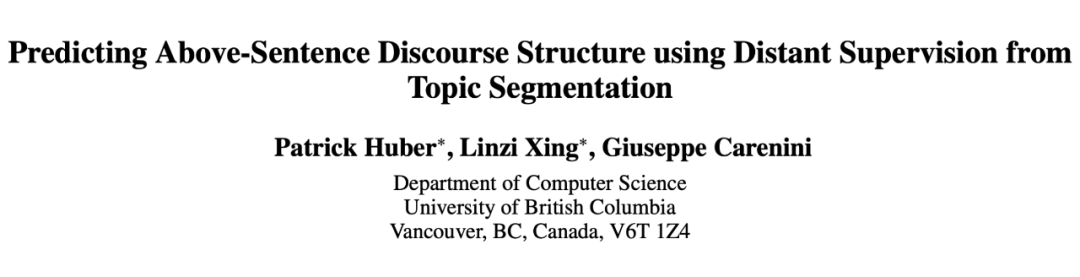

Predicting Above-Sentence Discourse Structure using Distant Supervision from Topic Segmentation

论文链接:

https://arxiv.org/abs/2112.06196

RST(Rhetorical Structure Theory, 修辞结构理论)风格的话语解析在许多 NLP 任务中发挥着至关重要的作用,揭示了潜在复杂和多样化文档的潜在语义/语用结构。尽管它很重要,但现代话语解析中最普遍的限制之一是缺乏大规模数据集。为了克服数据稀疏性问题,最近提出了来自情绪分析和总结等任务的远程监督方法。

这篇文字的作者通过利用来自主题分割的远程监督来扩展这一研究方向,这可以为高级话语结构提供强大且互补的信号。在两个人工注释的话语树库上的实验证实,本文的提议在句子和段落级别上生成了准确的树结构,在句子到文档的任务上始终优于以前的远程监督模型,并且偶尔在句子到文档的任务上达到更高的分数。

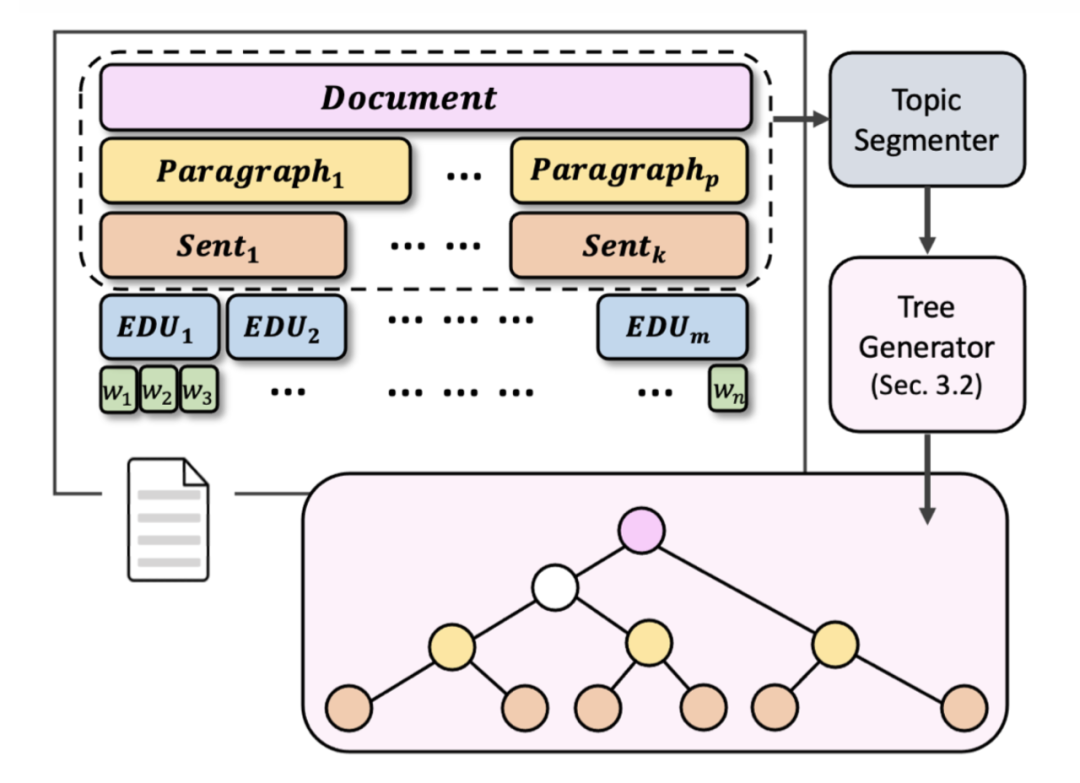

![]()

上图是本文提出的从远程主题分割监督生成句子到文档级别的高级话语结构的方法示意图。在顶部,我们可视化了一个自然组织的文档,其中单词被聚合成从句(或 EDU),这些子句又被连接成句子。然后将句子进一步组合成段落,形成完整的文档。在这里,我们将句子聚合为原子单元以获得高级话语树。作者使用自上而下的贪婪方法来生成树。

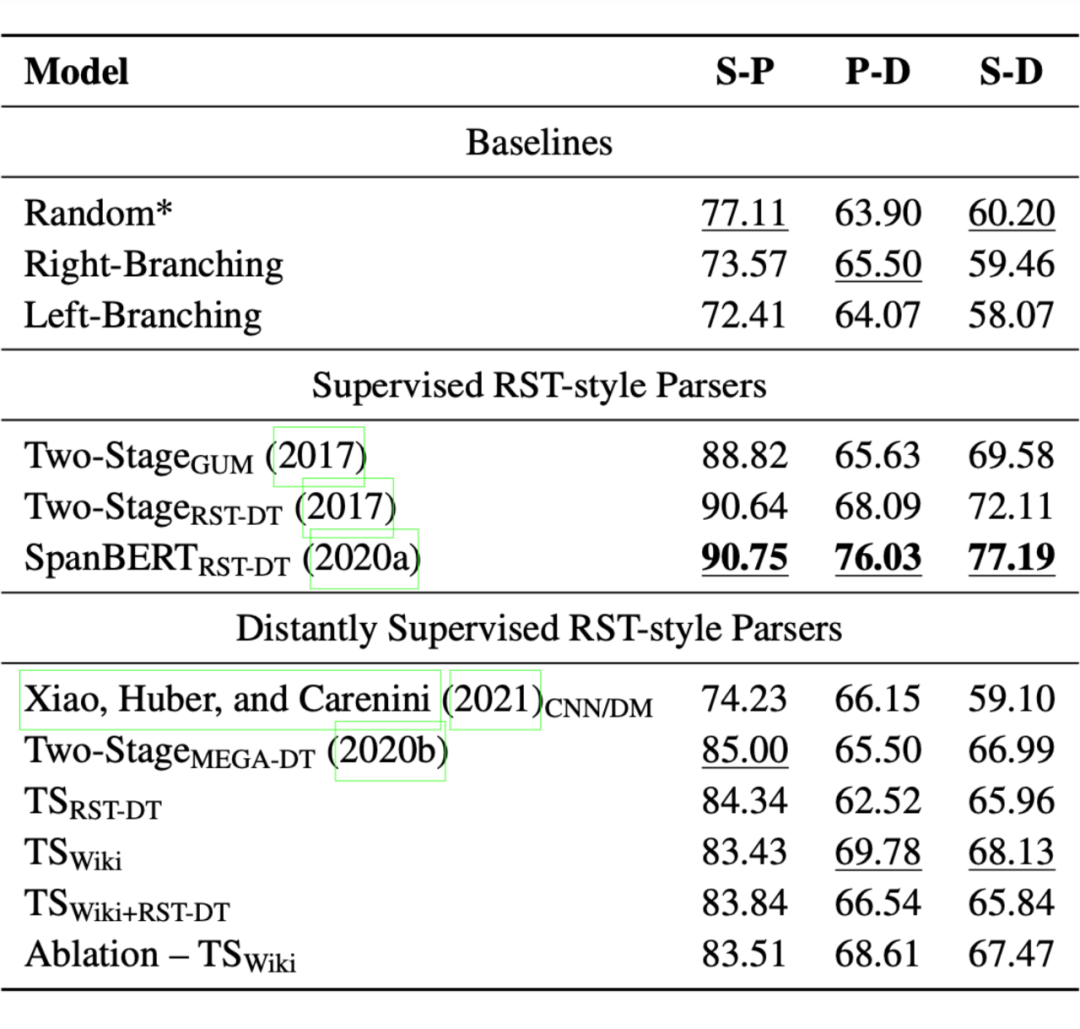

![]()

上图是实验结果,可以看出,使用监督的 RST 风格 parser 取得了较好的结果。

![]()

Towards Fine-Grained Reasoning for Fake News Detection

论文链接:

https://arxiv.org/abs/2110.15064

在这篇文章中,作者通过遵循人类的信息处理模型提出了一个细粒度的推理框架,引入了一种基于相互强化的方法来整合人类关于哪些证据更重要的知识,并设计了一个先验感知的双通道核图网络对证据之间的细微差异进行建模。大量实验表明,本文的模型优于最先进的方法,作者还证明了方法的可解释性。

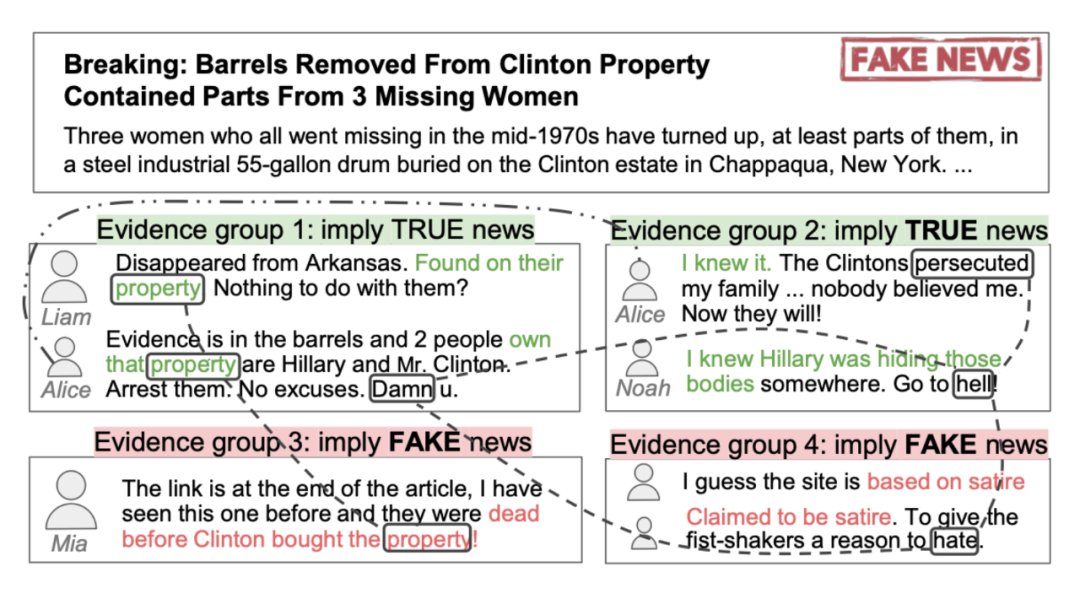

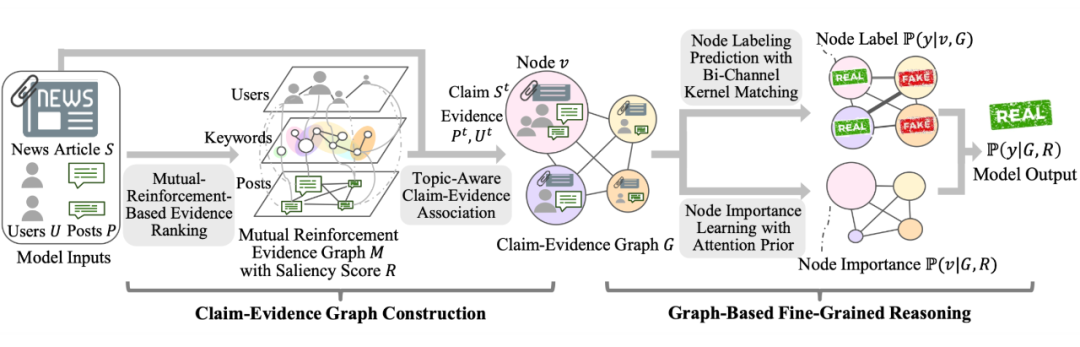

![]()

当人类对一篇新闻文章的真实性进行推理时,他们有能力进行细粒度分析以识别细微的线索,并且可以将不同类型的线索联系起来得出结论。如上图所示,尽管四组证据在语义上不同,但人类可以根据“property”一词等微妙线索在逻辑上将它们联系起来,从而得出更自信的结论。现有方法缺乏这种细粒度推理的能力:它们要么不对不同类型证据之间的交互进行建模,要么在粗粒度(例如,句子或帖子)级别对它们进行建模。

![]()

作者提出了一个用于假新闻检测的细粒度推理框架(Fine-grained reasoning framework for Fake news detection, FinerFact)。如上图所示,框架由两个主要模块组成:

第一个模块,断言证据图

构建,对应于人类信息处理模型的存储子过程。在这个过程中,人们选择最重要的信息片段并建立它们之间的关联以将它们存储在内存中。至于假新闻检测,它对应于人们搜索关键信息的过程,例如主要观点、意见领袖和最重要的帖子,这使他们能够了解关键主张及其作为——相关证据(例如,支持的帖子和用户)。这一步对于过滤噪声、组织事实和加速后期的细粒度推理过程至关重要。它还使我们能够整合关于哪些信息很重要的人类知识。

第二个模块,基于图的细粒度推理,对应于人类信息处理模型的检索子过程,其中人们根据他们的关联重新激活特定的信息以进行决策。在假新闻检测中,该模块通过考虑细微的线索来实现证据关系的细粒度建模。

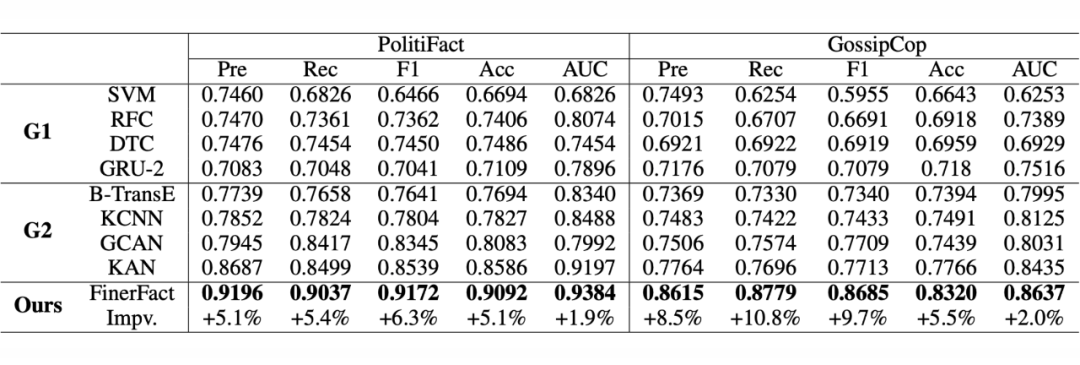

![]()

实验结果如上图所示,可以看出,FinerFact 在各方面都实现了较好的性能。

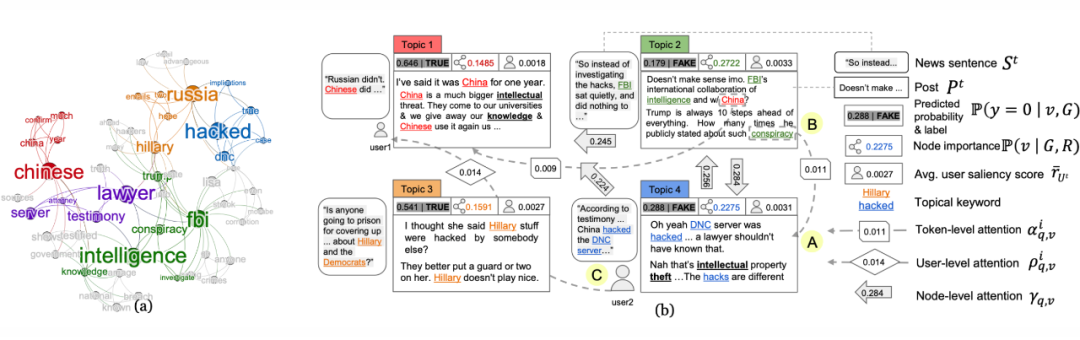

![]()

上图是用 FinerFact 推理的示意图。(a)互强化图 M 的关键词层,显著性 R 由字体大小表示;(b)对断言证据图 G 的细粒度推理。每种颜色编码一个主题。

2.5 Twitter User Representation

![]()

Twitter User Representation using Weakly Supervised Graph Embedding

论文链接:

https://arxiv.org/abs/2108.08988

这篇文章的作者提出了一种基于弱监督图嵌入的框架来理解用户类型。作者评估使用对来自 Twitter 的健康相关推文的弱监督学习的用户嵌入,重点是“瑜伽”、“生酮饮食”。在真实世界数据集上的实验表明,所提出的框架在检测用户类型方面优于 baseline。最后,作者从数据集中说明了对不同类型用户(例如,从业者与促销者)的数据分析,便于本文的方法推广到其他领域。

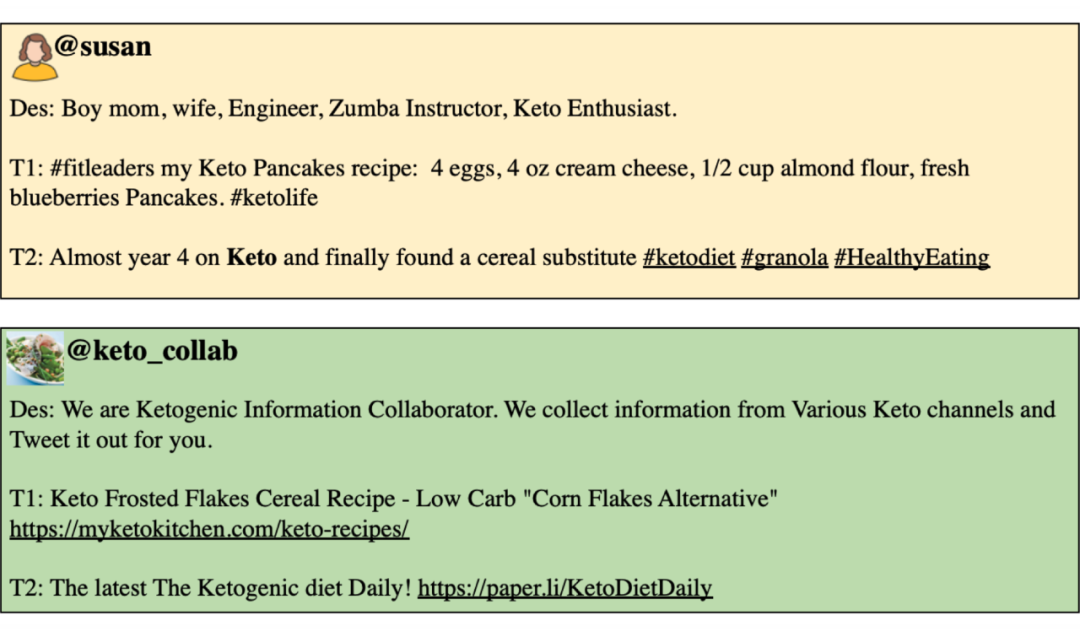

![]()

上图显示了两个不同的 Twitter 用户的个人资料描述和关注酮饮食的推文。尽管用户 susan 和 keto collab 都发布了关于生酮饮食的推文,但他们有不同的意图。用户 susan 是一位“keto 爱好者”,而 keto collab 专注于从各种酮渠道收集信息,并每天推广酮食谱和生酮饮食。除了推文的内容外,苏珊的个人资料描述表明她是一名从业者。另一方面,keto collab 的个人资料描述和推文表明它是一个促销帐户。我们的目

标是从相关的推文中自动分类用户类型并分析他们的文本内容。

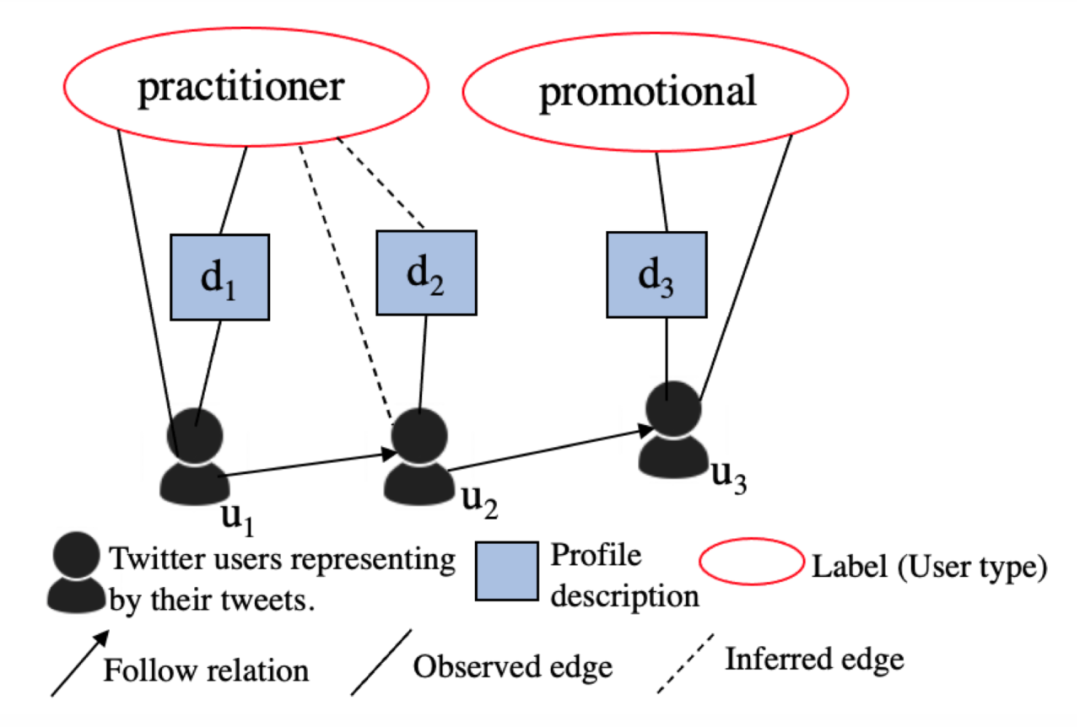

![]()

上图表示用户、描述、用户类型之间的关系。为了通过信息图捕获更多表征用户类型的隐藏关系,作者建议迭代应用推理函数。用户 u1 和 u3 具有弱标签,分别通过使用特定关键字的标签映射从他们的个人资料描述 d1 和 d3 中获得。u2 的配置文件描述最初没有标签。推理函数推断用户 u2 和 u2 的描述标签,d2 为“从业者”,因为 u1 和 u2 具有相似的推文。

从技术角度来看,我们将用户类型检测定义为信息图上的推理问题,该问题创建由图结构上下文化的节点的分布式表示,允许我们将信息从观察到的节点传输到未知节点。我们使用基于学习图嵌入定义的相似性度量的推理函数来增加连接两种节点类型的边数。我们建议使用期望最大化(EM)方法来完成这两个步骤。

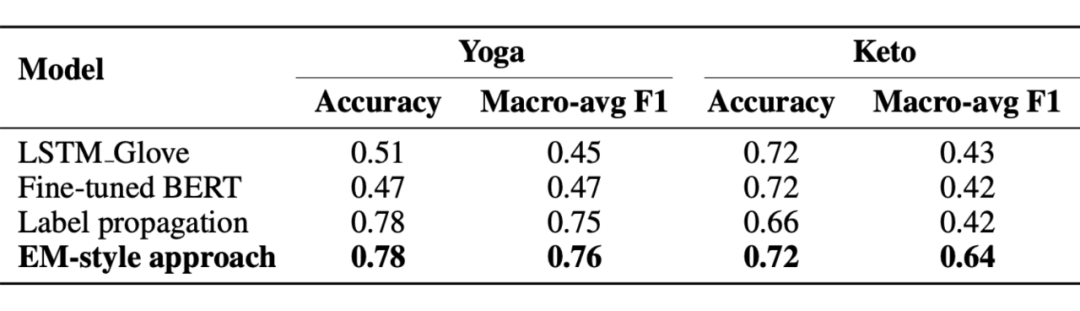

![]()

上图是实验结果。作者构建用户信息图的方法值得参考。

![]()

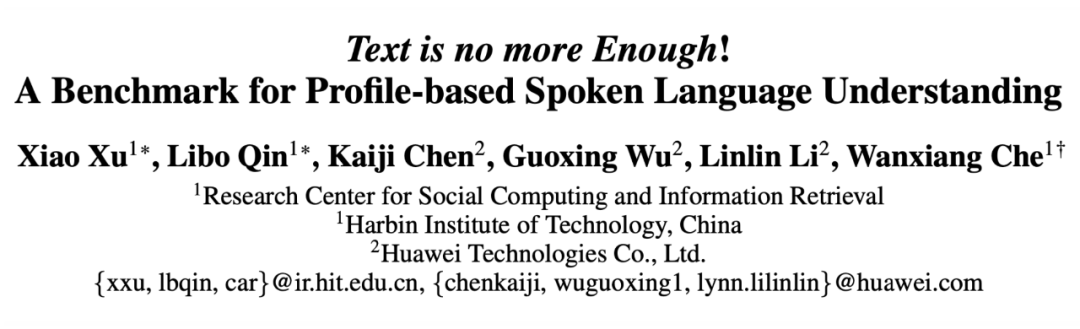

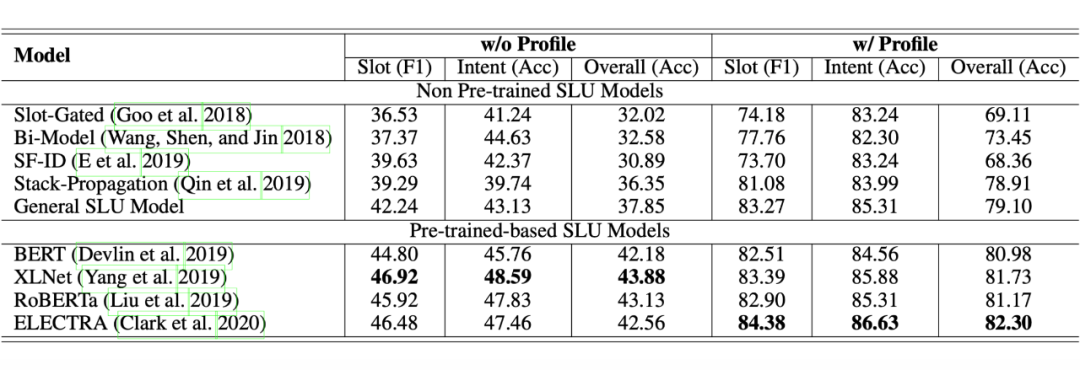

Text is no more Enough! A Benchmark for Profile-based Spoken Language Understanding

https://arxiv.org/abs/2112.11953

https://github.com/LooperXX/ProSLU

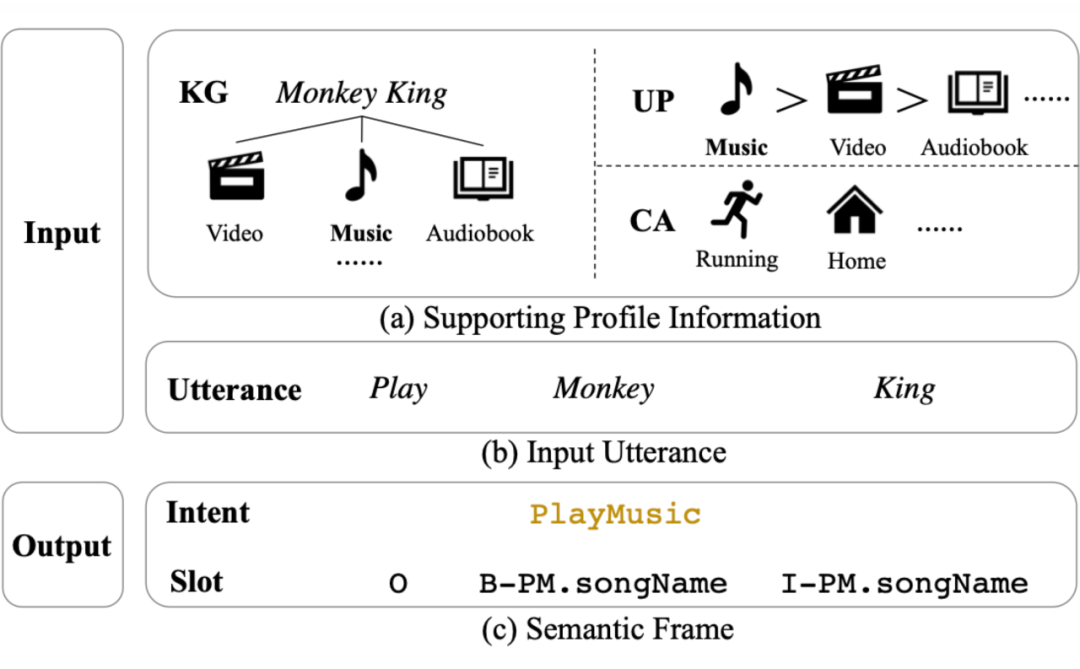

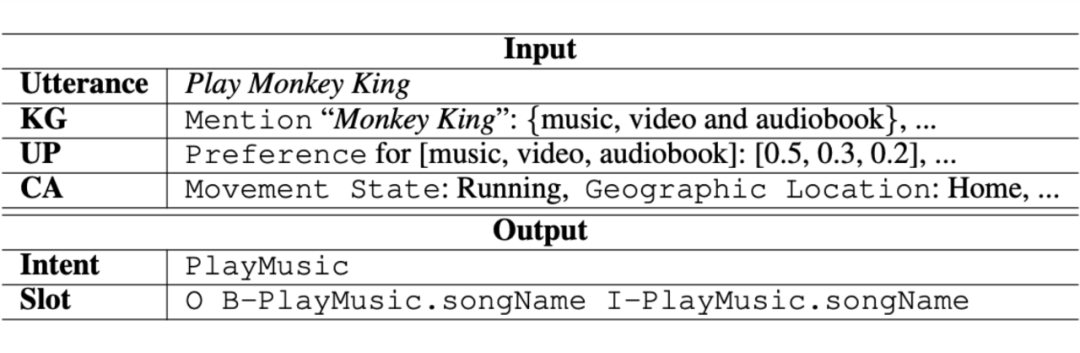

当前对又语理解(spoken language understanding, SLU)的研究局限于一个简单的设置:基于纯文本的 SLU,它将用户话语作为输入并生成其相应的语义框架(例如意图和槽)。不幸的是,当话语在语义上模棱两可时,这种简单 的设置可能无法在复杂的现实世界场景中工作,而基于文本的 SLU 模型无法实现这一点。

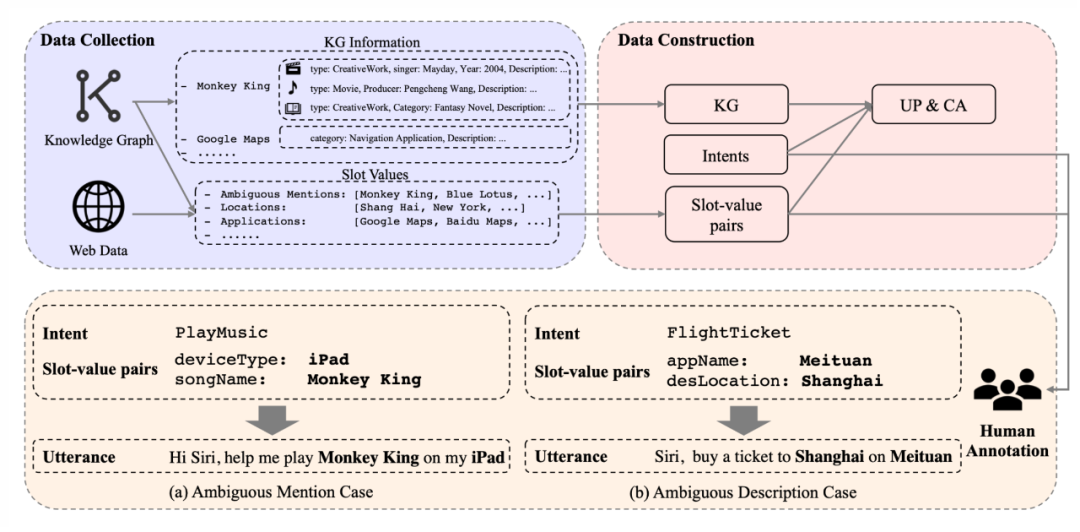

这篇文章来自车万翔老师的团队,作者首先介绍了一项新的重要任务,即基于配置文件的又语理解(Profile-based Spoken Language Understanding, PROSLU),它要求模型不仅依赖纯文本,还需要支持配置文件信息来预测正确的意图和槽。为此,作者进一步引入了一个具有超过 5K 话语的大规模人工注释中文数据集及其相应的支持配置文件信息(知识图(Knowledge Graph, KG)、用户配置文件(User Profile, UP)、上下文感知(Context Awareness, CA))。

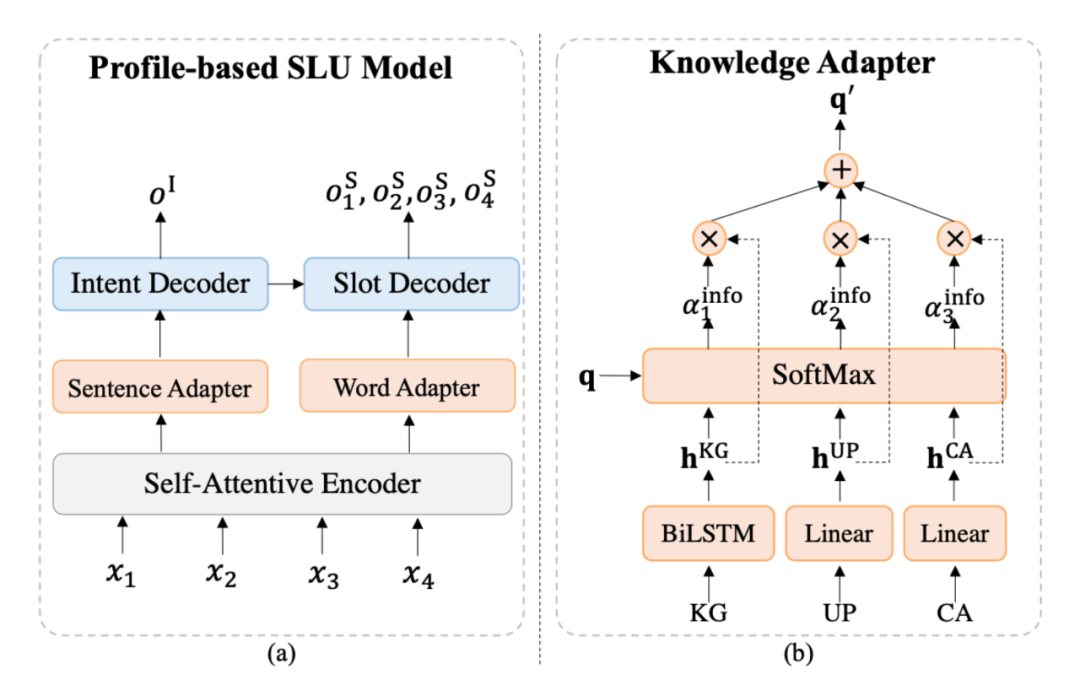

此外,作者评估了几个最先进的 baseline 模型,并探索了一个多层次的知识适配器,以有效地整合个人资料信息。实验结果表明,当话语在语义上不明确时,所有现有的基于文本的 SLU 模型都无法工作,作者提出的框架可以有效地融合句子级意图检测和 token 级槽填充的支持信息。

![]()

![]()

![]()

![]()

上图是通用 SLU 模型和多级知识适配器的示意图,可分别用于句子级意图检测和单词级槽填充。

![]()

上图是作者在 PROSLU 数据集上意图检测和槽填充的实验结果。

作者在附录中还详细介绍了通用 SLU 模型的细节以及消融实验的结果,值得进一步阅读。

![]()

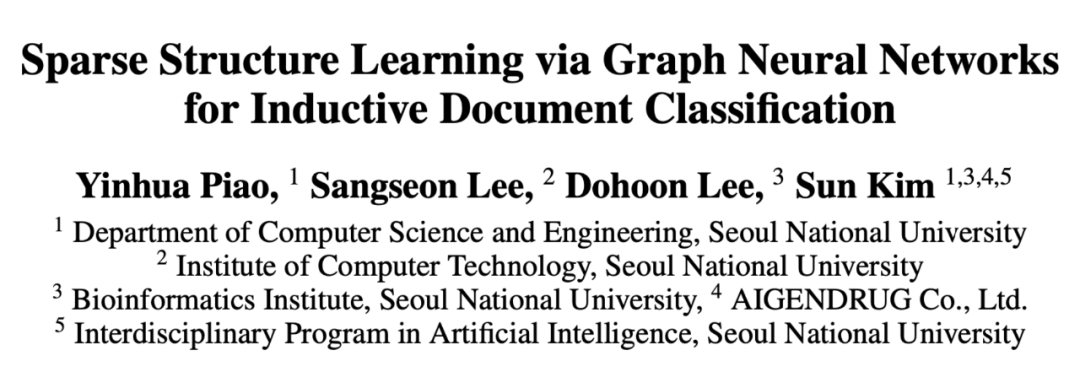

Sparse Structure Learning via Graph Neural Networks for Inductive Document Classification

https://arxiv.org/abs/2112.06386

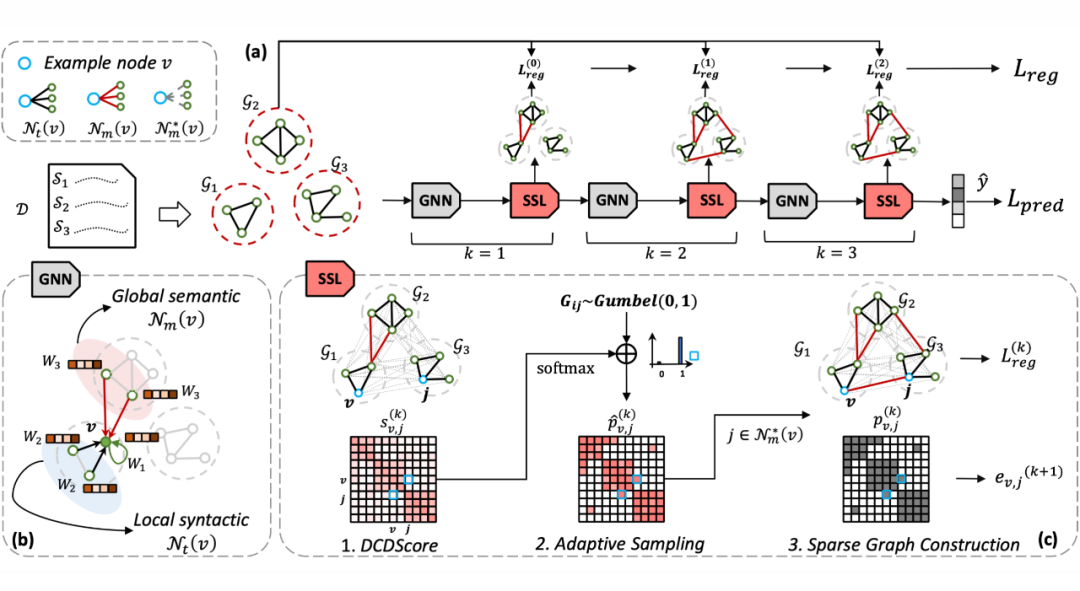

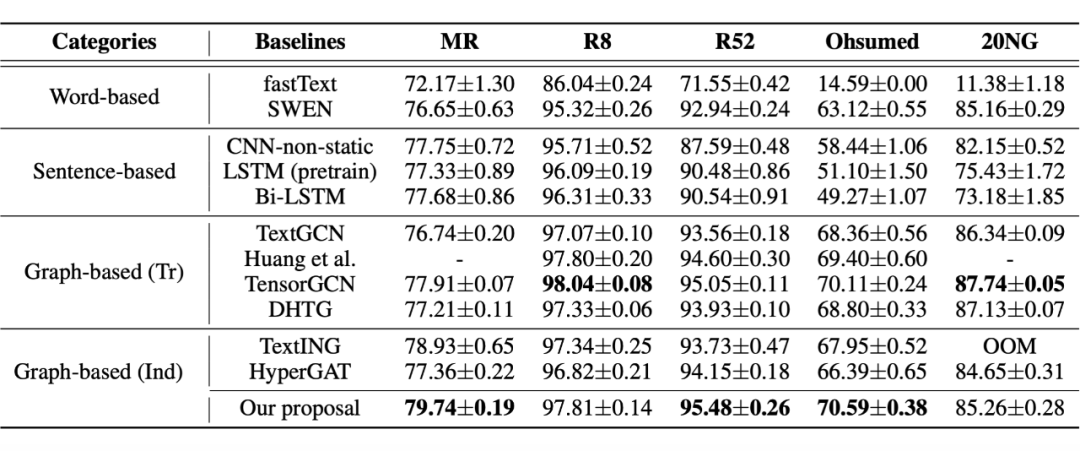

这篇文章的作者提出了一种基于 GNN 的稀疏结构学习模型,用于归纳文档分类。具体来说,文档级图最初是由句子级单词共现图的不相交并集生成的。模型收集了一组连接句子之间不相交单词的可训练边,并采用结构学习来稀疏地选择具有动态上下文依赖关系的边。具有稀疏结构的图可以通过 GNN 共同利用文档中的局部和全局上下文信息。对于归纳学习,将细化的文档图进一步输入通用读出函数,以端到端的方式进行图级分类和优化。实验表明,作者提出的模型优于大多数最先进的结果,并揭示了为每个文档学习稀疏结构的必要性。

![]()

上图是模型的概览:(a)模型框架(b)GNN:局部和全局联合消息传递。(c) SSL:稀疏结构学习包含(c.1)动态上下文依赖分数,(c.2)稀疏结构的自适应采样,和(c.3)重构稀疏图。

模型由三个主要部分组成。我们首先构建句子图,其中节点嵌入是通过局部和全局消息传递操作来学习的。基于节点嵌入,我们提出了一种用于图结构细化的稀疏结构学习。最后,我们正则化图结构以保持原始句法信息的一致性。

![]()

上图是在五个基准数据集上测试各种模型的准确性。可以看出,本文提出的模型在多个方面取得了不错的性能。

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()