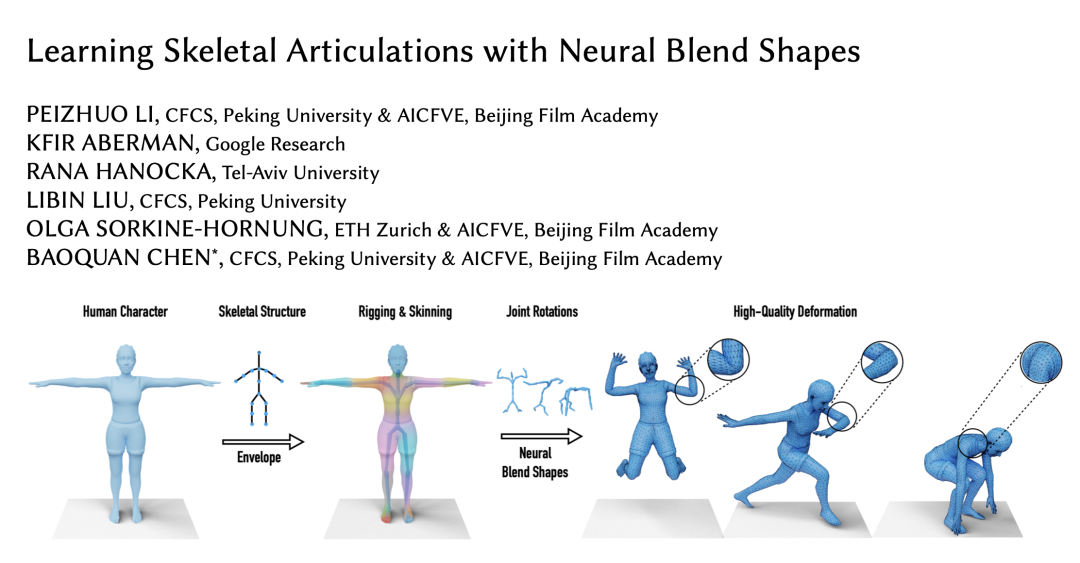

本文是对发表于计算机图形学顶级会议 SIGGRAPH 2021 的论文 Learning Skeletal Articulations with Neural Blend Shapes 的解读。

该论文由北京大学陈宝权教授研究团队、北京电影学院未来影像高精尖创新中心、Google Research、特拉维夫大学以及苏黎世联邦理工学院合作,针对骨骼驱动的模型动画的高质量自动化生成进行改进,提出了神经融合形状技术。实验证明,该方法显著减少了已有方法中需要的人工干预,大大提升了生成动画的质量。

项目主页:https://peizhuoli.github.io/neural-blend-shapes/

GitHub代码仓库:https://github.com/PeizhuoLi/neural-blend-shapes

论文链接:https://peizhuoli.github.io/neural-blend-shapes/papers/neural-blend-shapes-camera-ready.pdf

骨骼驱动的三维人物动画在游戏、影视等应用场景中随处可见。

然而,使用骨骼驱动三维人物网格模型(mesh)进行变形并得到动画,通常需要经历繁琐的骨骼搭建(rigging)以及蒙皮权重绑定(skinning)。

这些处理技术复杂而艰深,动画师通常需要数年的时间来尝试掌握。

此外,一些常见的特定动作,例如弯曲肘部、蹲下,由于常用的蒙皮技术(线性融合蒙皮,Linear Blend Skinning)的局限性,关节区域的变形并不理想。

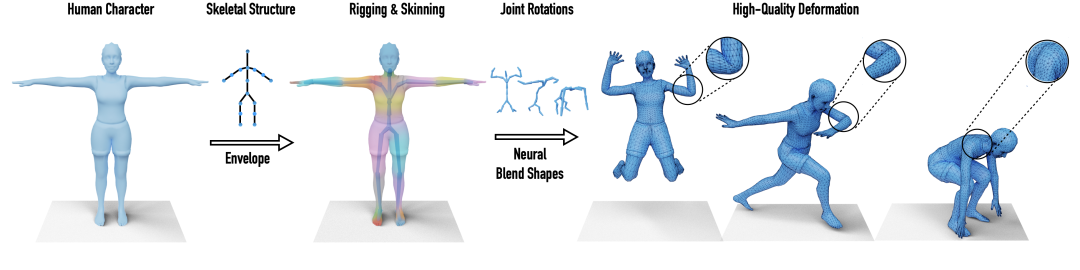

左:现有技术在关节区域的问题;右:本文技术生成的高质量且细节丰富的动画

为了简化骨骼搭建和蒙皮权重绑定的过程、高效利用动作捕捉数据以及生成高质量的动画,我们开发了一套能生成具有指定结构的骨骼以及精准绑定权重的神经网络。加以我们提出的神经融合形状(neural blend shapes)技术,我们实现了实时高质量三维人物模型动画的端到端自动生成。

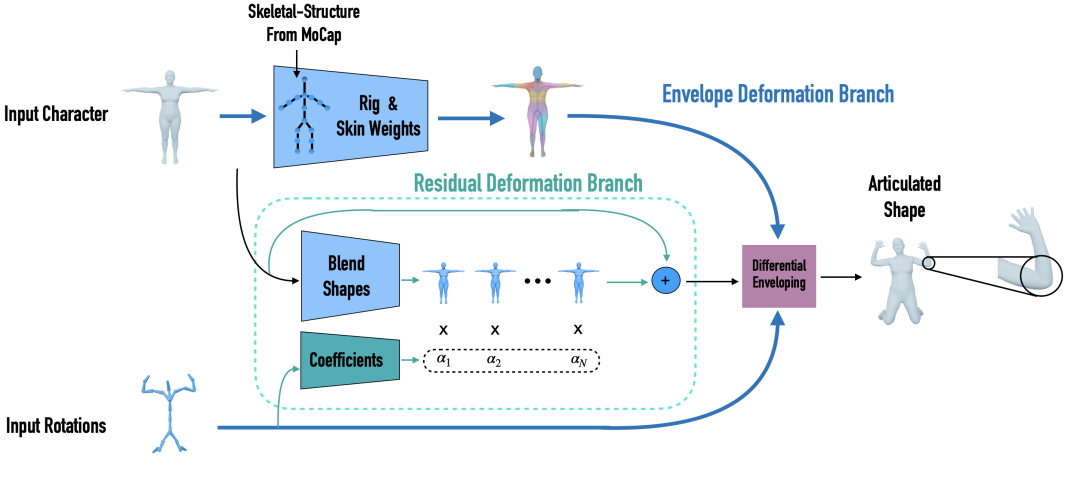

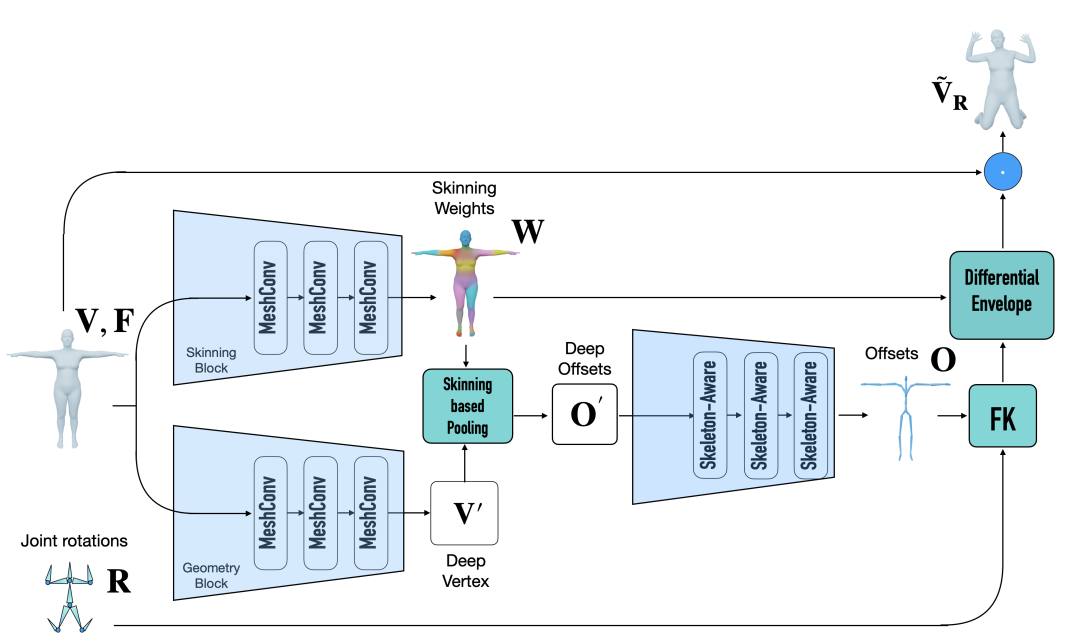

从处于 T 姿态的人物模型以及在给定的骨骼结构上的关节旋转开始,我们的包裹变形分支(envelope deformation branch)学习并预测出相应的骨骼以及蒙皮权重。

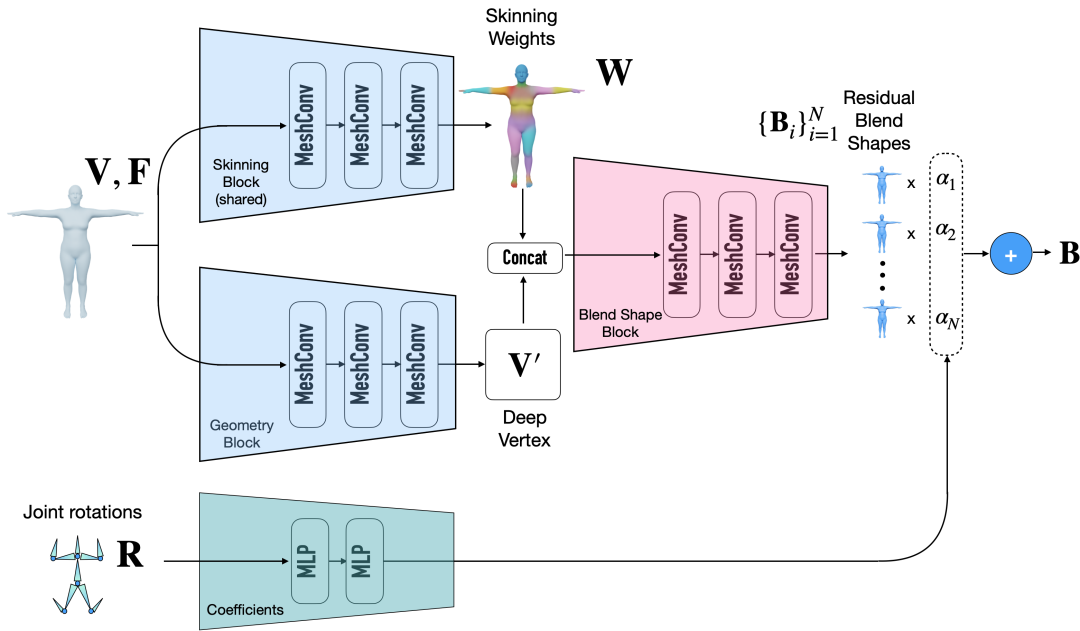

与此同时,补偿变形分支(residual deformation branch)预测出对应的融合形状(blend shapes)并使用输入的关节旋转预测对应的融合系数,然后基于此插值得到补偿变形。

综合以上中间结果,可微分包裹变形模块将生成最终的变形结果。

这一设计使得我们的神经网络能够通过仅观察变形后的人物模型进行间接学习,而不需要对训练数据集的变形方法有任何限制,极大增广了该方法的适用范围。

我们的神经网络使用了网格卷积[1]和骨骼卷积[2]搭建各个模块。基于这些最前沿技术的基本算子,我们的网络可以在具有任意网格连通性的人物模型上生成高质量的结果。下图展示了我们的网络的具体架构:

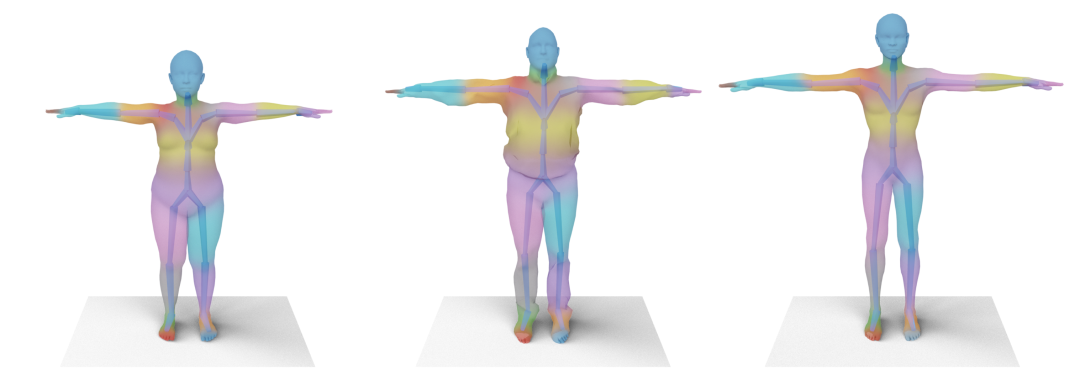

我们的方法能准确的预测出与人物模型高度匹配的骨骼以及绑定权重:

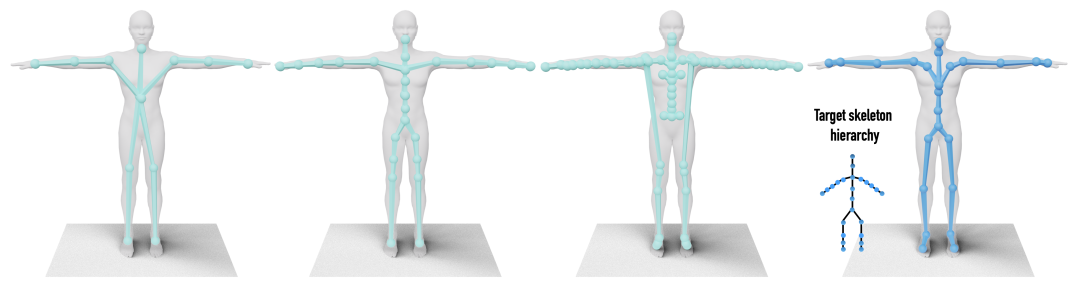

特别的,我们的方法能生成符合预先指定结构的骨骼,这一点在使用动作捕捉数据时尤为关键。而 RigNet[3]只提供了十分有限的用户操纵参数,生成的骨骼结构难以控制:

从左至右分别为:RigNet(12), RigNet(25), RigNet(50), Ours

由于我们的神经网络直接在高质量变形模型上训练,仅使用包裹变形分支就已经超过了基准的线性融合蒙皮技术。再加上我们的神经融合形状技术,关节区域的变形结果便是更上一层楼:

[1] Hanocka et al., 2019, MeshCNN: A Network with an Edge

[2] Aberman et al., 2020, Skeleton-Aware Networks for Deep Motion Retargeting

[3] Xu et al., 2020, RigNet: Neural Rigging for Articulated Characters

亚马逊云科技线上黑客松2021

这是一场志同道合的磨练,这是一场高手云集的组团竞技。秀脑洞、玩创意,3月26日至5月31日,实战的舞台为你开启,「亚马逊云科技线上黑客松2021」等你来战!

为了鼓励开发者的参与和创新,本次大赛为参赛者准备了丰厚的奖品,在一、二、三等奖之外,还特设prActIcal奖、creAtIve奖、锦鲤极客奖、阳光普照奖,成功提交作品的团队均可获赠奖品。

识别二维码,立即报名参赛。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com