【IJCAI-2020】华为诺亚方舟实验室多项强化学习研究成果被录用

深度强化学习实验室报道

来源:转载自诺亚方舟

编辑:DeepRL

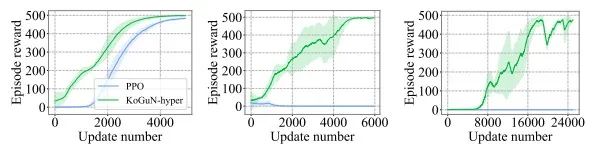

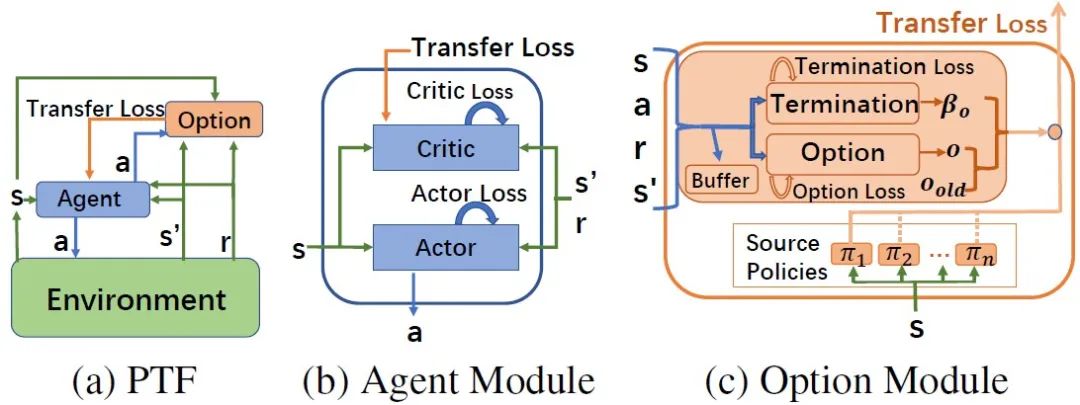

Efficient Deep Reinforcement Learning via Adaptive Policy Transfer

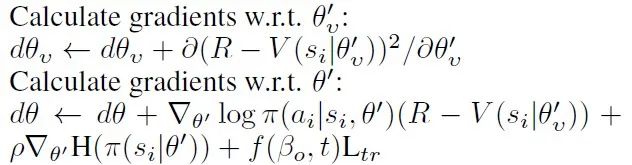

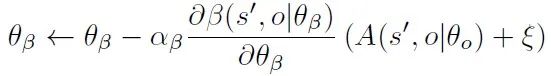

深度强化学习解决很多复杂问题的能力已经有目共睹,然而,如何提升其学习效率是目前面临的主要问题之一。现有的很多方法已验证迁移学习可利用相关任务中获得的先验知识来加快强化学习任务的学习效率。然而,这些方法需要明确计算任务之间的相似度,或者只能选择一个适合的源策略,并利用它提供针对目标任务的指导性探索。目前仍缺少如何不显式的计算策略间相似性,自适应的利用源策略中的先验知识的方法。本文提出了一种通用的策略迁移框架(PTF),利用上述思想实现高效的强化学习。PTF通过将多策略迁移过程建模为选项(option)学习,option判断何时和哪种源策略最适合重用,何时终止该策略的重用。如图1所示,PTF分为两个子模块,智能体(agent)模块和option模块。Agent模块负责与环境交互,并根据环境的经验和option的指导进行策略更新。以PTF-A3C为例,agent模块的策略更新公式如下:

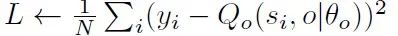

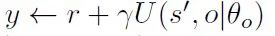

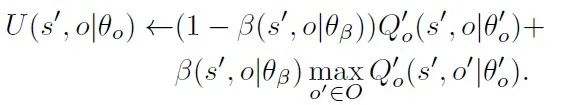

其中,agent模块对源策略的利用通过添加一个额外的损失函数,该损失函数计算agent策略与源策略之间的差异。根据option的终止函数,我们提出了一种自适应调整策略重用的机制,为损失函数设计了启发式的权重系数,避免负迁移的出现。Option模块负责option的值网络和终止网络的学习,option的值函数更新参考DQN的更新方式,最小化损失函数

Option模块通过计算以下梯度更新终止网络的参数

Triple-GAIL: A Multi-Modal Imitation Learning Framework with Generative Adversarial Nets

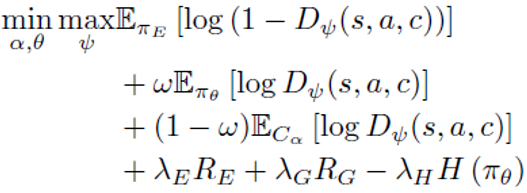

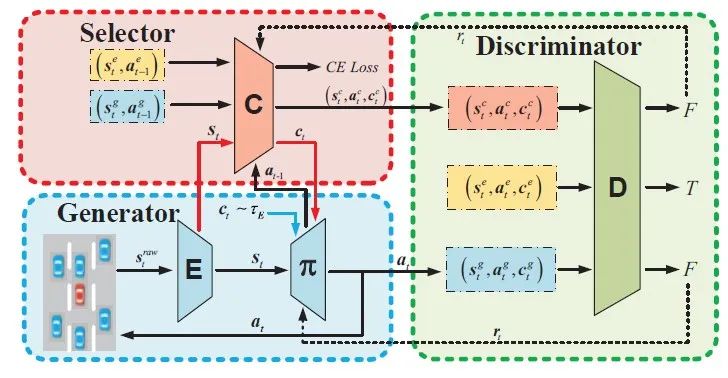

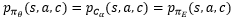

模仿学习是一种基于专家示教重建期望策略的方法,一直是AI领域的研究热点。为了提升模仿学习的通用性和在实际工程中的应用,相关的研究方向吸引了大量学术和工业界人士,其中利用多模态模仿学习提升模仿学习效果是重要的方向之一。例如,应用于自动驾驶中的驾驶行为学习,真实驾驶员示教数据由于驾驶技能和行为习惯的多样性呈现多种模态并服从不同的分布,如果直接利用行为克隆(Behavioral Cloning,BC)或逆向强化学习(Inverse Reinforcement Learning,IRL)容易导致模态坍塌问题(mode collapse problem),因缺乏发现和区分示教数据中的模态变化的能力。为了针对多模态示教数据进行有效的模仿,我们提出了一种基于生成对抗模仿学习(Generative Adversarial Imitation Learning,GAIL)的多模态模仿学习算法框架(图3),称为Triple-GAIL,通过对模态选择和行为模仿联合学习并利用模态选择器增量式生成数据促进模态区分优化模仿效果。Triple-GAIL在GAIL的基础上增加了一个模态选择器(Selector)用于区分多个模态,并和生成器(Generator)一起持续生成状态-动作-模态数据序列,达到数据增广的目的,而判别器(Discriminator)用于区分状态-动作-模态数据序列是否来自于专家示教数据。与已有多模态模仿学习方法相比,Triple-GAIL既可以直接通过指定模态生成行为轨迹,也可以直接利用模态选择器基于历史数据判断模态。

根据上述目标函数,我们从理论上证明了当且仅当

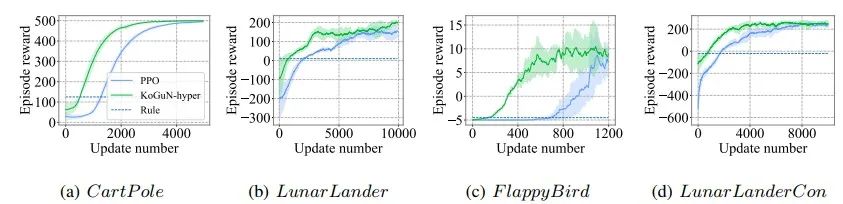

KoGuN: Accelerating Deep Reinforcement Learning via Integrating Human Suboptimal Knowledge

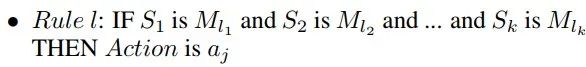

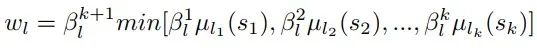

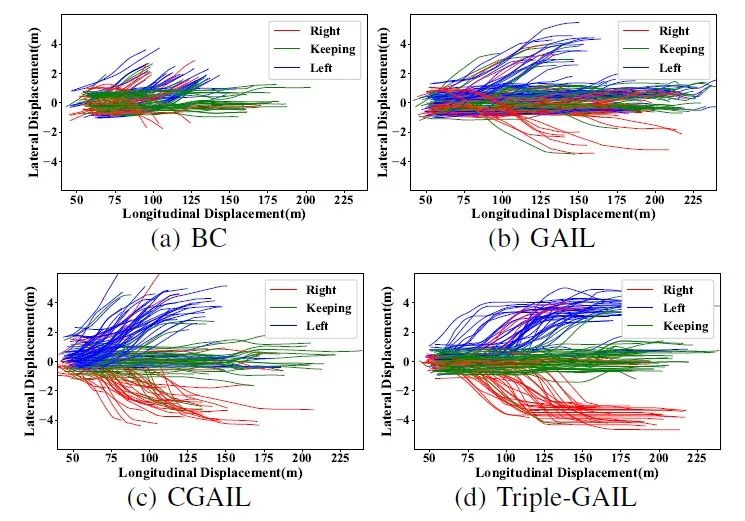

人类在面对新任务时,能够自然地利用从之前任务中获得的先验知识指导其之后的学习过程。这样的先验知识未必是与当前任务完全匹配的,很可能是次优的、模糊的,但是仍然能够大大加速人类的学习过程。因此,在强化学习过程中利用人类提供的先验知识直观上能够加速其学习过程。在序列决策问题中,利用人类知识的一系列重要工作是模仿学习,模仿学习需要利用专家的示教数据重建期望策略。而示教数据作为人类知识在某个任务下的具体体现,是low level的知识,我们期望能够利用high level的知识,例如人类的常识知识,在未见过的任务中且没有示教数据可供使用的情况下指导智能体的学习。受此启发,我们提出了一种新颖的知识引导策略网络(Knowledge Guide Policy Network,KoGuN),将人类的先验知识结合到深度强化学习的学习过程中,其框架如图5所示。我们引入了可学习的知识控制器(Knowledge Controller)编码人类知识,其中包含若干条模糊规则。模糊规则适用于基于不确定的、不精确的知识进行推理,这与人类提供的具有非精确性的先验知识相契合。我们使用的模糊规则的形式如下:

其推理过程可用下式表示:

同时,我们设计了知识精化模块(Refine Module)对次优先验进行修正。我们提出的知识引导策略网络能够与现有的基于策略的强化学习算法结合,进行端到端的训练。实验结果显示,我们的方法在离散和连续动作空间任务中均能够提高智能体的学习效率:

在收益信号非常稀疏的情况下,我们的方法优势更加明显,如下:

文章链接:https://arxiv.org/abs/2002.07418

总结3: 《强化学习导论》代码/习题答案大全

总结6: 万字总结 || 强化学习之路

完

第65篇:DQN系列(3): Prioritized Experience Replay

第64篇:UC Berkeley开源RAD来改进强化学习算法

第61篇:David Sliver 亲自讲解AlphaGo、Zero

第59篇:Agent57在所有经典Atari 游戏中吊打人类

第58篇:清华开源「天授」强化学习平台

第57篇:Google发布"强化学习"框架"SEED RL"

第53篇:TRPO/PPO提出者John Schulman谈科研

第52篇:《强化学习》可复现性和稳健性,如何解决?

第51篇:强化学习和最优控制的《十个关键点》

第50篇:微软全球深度强化学习开源项目开放申请

第49篇:DeepMind发布强化学习库 RLax

第48篇:AlphaStar过程详解笔记

第47篇:Exploration-Exploitation难题解决方法

第45篇:DQN系列(1): Double Q-learning

第44篇:科研界最全工具汇总

第42篇:深度强化学习入门到精通资料综述

第41篇:顶会征稿 || ICAPS2020: DeepRL

第40篇:实习生招聘 || 华为诺亚方舟实验室

第39篇:滴滴实习生|| 深度强化学习方向

第37篇:Call For Papers# IJCNN2020-DeepRL

第36篇:复现"深度强化学习"论文的经验之谈

第35篇:α-Rank算法之DeepMind及Huawei改进

第34篇:从Paper到Coding, DRL挑战34类游戏

第31篇:强化学习,路在何方?

第30篇:强化学习的三种范例

第29篇:框架ES-MAML:进化策略的元学习方法

第28篇:138页“策略优化”PPT--Pieter Abbeel

第27篇:迁移学习在强化学习中的应用及最新进展

第26篇:深入理解Hindsight Experience Replay

第25篇:10项【深度强化学习】赛事汇总

第24篇:DRL实验中到底需要多少个随机种子?

第23篇:142页"ICML会议"强化学习笔记

第22篇:通过深度强化学习实现通用量子控制

第21篇:《深度强化学习》面试题汇总

第20篇:《深度强化学习》招聘汇总(13家企业)

第19篇:解决反馈稀疏问题之HER原理与代码实现

第17篇:AI Paper | 几个实用工具推荐

第16篇:AI领域:如何做优秀研究并写高水平论文?

第14期论文: 2020-02-10(8篇)

第13期论文:2020-1-21(共7篇)

第12期论文:2020-1-10(Pieter Abbeel一篇,共6篇)

第11期论文:2019-12-19(3篇,一篇OpennAI)

第10期论文:2019-12-13(8篇)

第9期论文:2019-12-3(3篇)

第8期论文:2019-11-18(5篇)

第7期论文:2019-11-15(6篇)

第6期论文:2019-11-08(2篇)

第5期论文:2019-11-07(5篇,一篇DeepMind发表)

第4期论文:2019-11-05(4篇)

第3期论文:2019-11-04(6篇)

第2期论文:2019-11-03(3篇)

第1期论文:2019-11-02(5篇)