题目: A Game Theoretic Framework for Model Based Reinforcement Learning

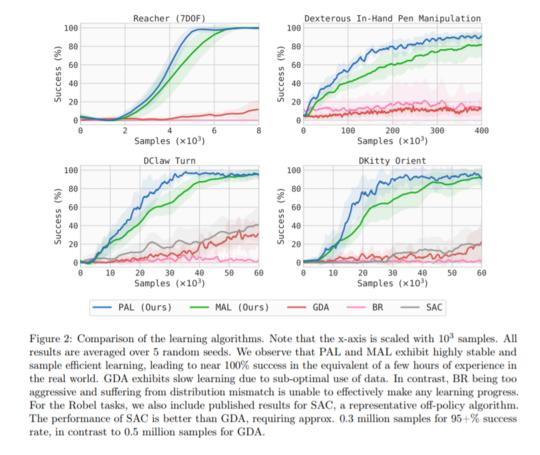

摘要: 基于模型的强化学习(MBRL)最近获得了极大的兴趣,因为它具有潜在的样本效率和合并非策略数据的能力。然而,使用富函数逼近器设计稳定、高效的MBRL算法仍然具有挑战性。为了从抽象的角度揭示MBRL的实际挑战并简化算法设计,我们开发了一个新的框架,将MBRL描述为:(1)一个策略参与者,它试图在学习模型下最大化回报;(2)一个模型player,它试图与策略player收集的真实数据相匹配。在算法开发方面,我们构造了一个双方参与的Stackelberg博弈,并证明了它可以用近似的双层优化来解决。这就产生了两种自然的MBRL算法,基于这两种算法,玩家被选择为Stackelberg游戏的领导者。它们一起封装、统一和泛化了许多以前的MBRL算法。此外,我们的框架是一致的,并提供了一个明确的基础启发式已知是重要的实践,从以往的工作。最后,通过实验验证了所提出的算法具有较高的样本效率,匹配无模型策略梯度的渐近性能,并能扩展到灵巧手操作等高维任务。

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

专知会员服务

34+阅读 · 2019年3月21日

Arxiv

11+阅读 · 2018年7月12日