机器学习大拿253页新书:可解释机器学习方法的局限籍(附下载)

新智元推荐

新智元推荐

来源:专知

编辑:元子

【新智元导读】机器学习大拿Christoph Molnar推出新书可解释机器学习的局限性,阐述了可解释机器学习的概念、方法等,以及重要的是适用的边界,即可解释机器学习的局限,知道能与不能方能用好IML。本书共14章,是Christoph Molnar课题组最新成果,值得参阅。现在戳右边链接上新智元小程序 了解更多!

地址:https://compstat-lmu.github.io/iml_methods_limitations/

本书解释了当前可解释机器学习方法的局限性。这些方法包括部分相关图(PDP)、累积局部效应(ALE)、排列特征重要性、单因素协变量缺失(LOCO)和局部可解释模型无关解释(LIME)。所有这些方法都可以用来解释训练过的机器学习模型的行为和预测。但在以下情况下,这些解释方法可能并不适用:

-

如果模型对交互进行建模(例如,当使用随机森林时) -

如果特征之间有很强的相关性 -

如果模型没有正确地建立因果关系模型 -

解释方法参数设置不正确的

-

算法透明度-算法如何创建模型? -

全局模型可解释性-如何训练的模型作出预测? -

模块级别上的全局模型可解释性——模型的各个部分如何影响预测? -

单个预测的局部可解释性——为什么模型会对一个实例做出某种预测? -

一组预测的局部可解释性——为什么模型会对一组实例做出特定的预测?

-

前言 Chapter 1 Introduction

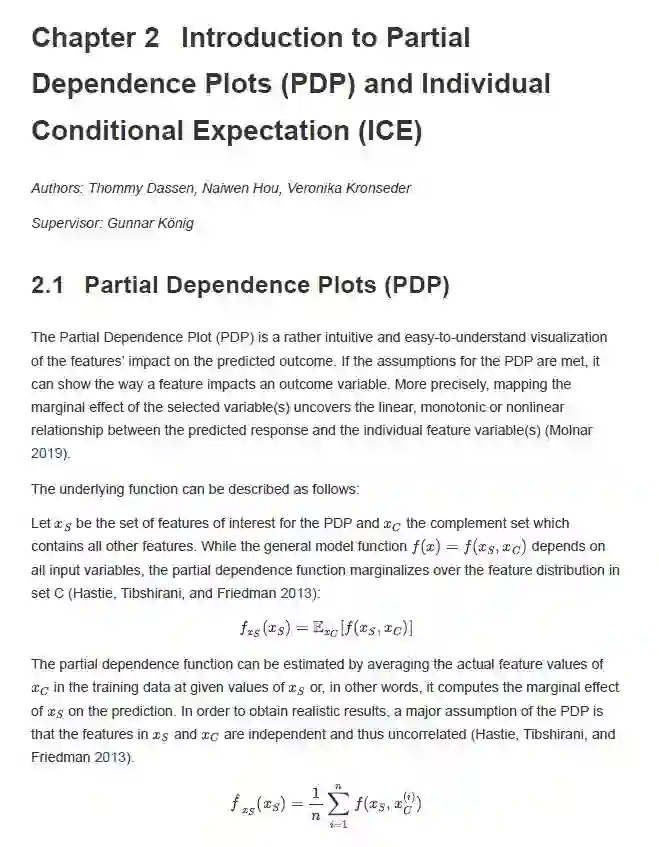

Chapter 2 Introduction to Partial Dependence Plots (PDP) and Individual Conditional Expectation (ICE)

Chapter 3 PDP and Correlated Features

Chapter 4 PDP and Causal Interpretation

Chapter 5 Introduction to Accumulated Local Effects (ALE)

Chapter 6 Comparison of ALE and PDP

Chapter 7 ALE Intervals, Piece-Wise Constant Models and Categorical Features

Chapter 8 Introduction to Feature Importance

Chapter 9 PFI, LOCO and Correlated Features

Chapter 10 Partial and Individual Permutation Feature Importance

Chapter 11 PFI: Training vs. Test Data

Chapter 12 Introduction to Local Interpretable Model-Agnostic Explanations (LIME)

Chapter 13 LIME and Neighbourhood

Chapter 14 LIME and Sampling

References

本文授权转载自公众号:专知

登录查看更多

相关内容

Arxiv

14+阅读 · 2019年1月17日

Arxiv

21+阅读 · 2018年12月25日