简介: 机器学习可解释性的新方法以惊人的速度发布。与所有这些保持最新将是疯狂的,根本不可能。这就是为什么您不会在本书中找到最新颖,最有光泽的方法,而是找到机器学习可解释性的基本概念的原因。这些基础知识将为您做好使机器学习模型易于理解的准备。

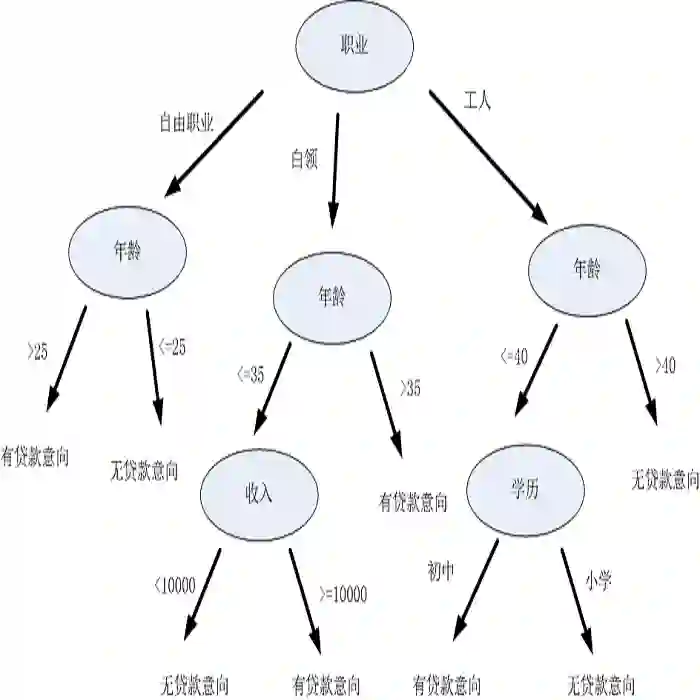

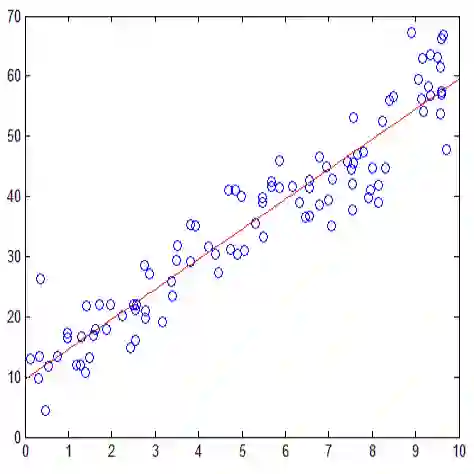

可解释的是使用可解释的模型,例如线性模型或决策树。另一个选择是与模型无关的解释工具,该工具可以应用于任何监督的机器学习模型。与模型不可知的章节涵盖了诸如部分依赖图和置换特征重要性之类的方法。与模型无关的方法通过更改机器学习的输入来起作用建模并测量输出中的变化。

本书将教您如何使(监督的)机器学习模型可解释。这些章节包含一些数学公式,但是即使没有数学知识,您也应该能够理解这些方法背后的思想。本书不适用于尝试从头开始学习机器学习的人。如果您不熟悉机器学习,则有大量书籍和其他资源可用于学习基础知识。我推荐Hastie,Tibshirani和Friedman(2009)撰写的《统计学习的要素》一书和Andrewra Ng在Coursera³上开设的“机器学习”在线课程,着手进行机器学习。这本书和课程都是免费的!在本书的最后,对可解释机器学习的未来前景持乐观态度。

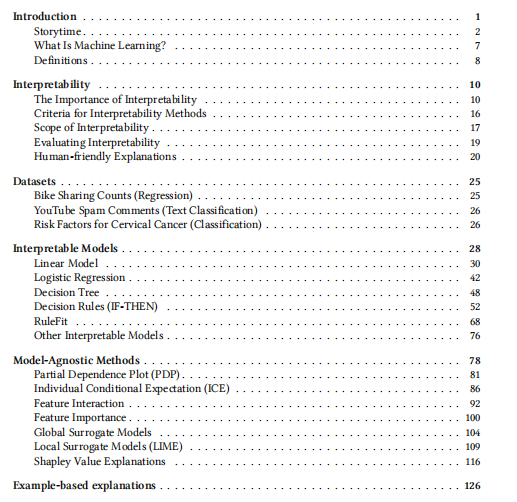

目录:

- 前言

- 第一章 引言

- 第二章 解释性

- 第三章 数据集

- 第四章 解释模型

- 第五章 模型不可知论方法

- 第六章 基于实例的解释

- 第七章 神经网络解释

- 第八章 水晶球

- 第九章 贡献

- 第十章 引用本书

成为VIP会员查看完整内容