TensorFlow 2.0 分布式训练

文 / 李锡涵,Google Developers Expert

本文节选自《简单粗暴TensorFlow 2.0》,合集回复 “手册”

上一篇文章中,我们介绍了模型部署的重要组件 TensorFlow Serving,本篇文章将介绍 TensorFlow 的另一关键特性:使用多GPU或集群进行分布式训练。

当我们拥有大量计算资源时,通过使用合适的分布式策略,我们可以充分利用这些计算资源,从而大幅压缩模型训练的时间。针对不同的使用场景,TensorFlow 在 tf.distribute.Strategy 中为我们提供了若干种分布式策略,使得我们能够更高效地训练模型。

单机多卡训练: MirroredStrategy

tf.distribute.MirroredStrategy 是一种简洁且高性能的,数据并行的同步式分布式策略,主要支持多个 GPU 在同一台主机上训练。使用这种策略时,我们只需实例化一个

MirroredStrategy 策略:

strategy = tf.distribute.MirroredStrategy()strategy.scope() 的上下文环境中:

with strategy.scope():

# 模型构建代码

小技巧

可以在参数中指定设备,如:

strategy = tf.distribute.MirroredStrategy(devices=["/gpu:0", "/gpu:1"])

即指定只使用第 0、1 号 GPU 参与分布式策略。

MirroredStrategy 策略,在 TensorFlow Datasets 中的部分图像数据集上使用 Keras 训练 MobileNetV2 的过程:

import tensorflow as tf

import tensorflow_datasets as tfds

num_epochs = 5

batch_size_per_replica = 64

learning_rate = 0.001

strategy = tf.distribute.MirroredStrategy()

print('Number of devices: %d' % strategy.num_replicas_in_sync) # 输出设备数量

batch_size = batch_size_per_replica * strategy.num_replicas_in_sync

# 载入数据集并预处理

def resize(image, label):

image = tf.image.resize(image, [224, 224]) / 255.0

return image, label

# 当as_supervised为True时,返回image和label两个键值

dataset = tfds.load("cats_vs_dogs", split=tfds.Split.TRAIN, as_supervised=True)

dataset = dataset.map(resize).shuffle(1024).batch(batch_size)

with strategy.scope():

model = tf.keras.applications.MobileNetV2()

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=learning_rate),

loss=tf.keras.losses.sparse_categorical_crossentropy,

metrics=[tf.keras.metrics.sparse_categorical_accuracy]

)

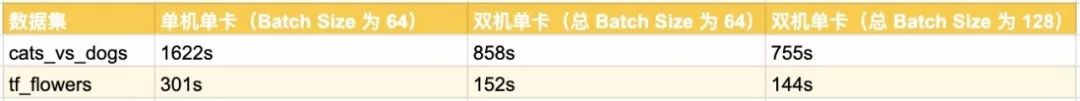

model.fit(dataset, epochs=num_epochs)在以下的测试中,我们使用同一台主机上的 4 块 NVIDIA GeForce GTX 1080 Ti 显卡进行单机多卡的模型训练。所有测试的 epoch 数均为 5。使用单机无分布式配置时,虽然机器依然具有 4 块显卡,但程序不使用分布式的设置,直接进行训练,Batch Size 设置为 64。使用单机四卡时,测试总 Batch Size 为 64(分发到单台机器的 Batch Size 为 16)和总 Batch Size 为 256(分发到单台机器的 Batch Size 为 64)两种情况。

可见,使用 MirroredStrategy 后,模型训练的速度有了大幅度的提高。在所有显卡性能接近的情况下,训练时长与显卡的数目接近于反比关系。

MirroredStrategy 过程简介

MirroredStrategy 的步骤如下:

训练开始前,该策略在所有 N 个计算设备上均各复制一份完整的模型;

每次训练传入一个批次的数据时,将数据分成 N 份,分别传入 N 个计算设备(即数据并行);N 个计算设备使用本地变量(镜像变量)分别计算自己所获得的部分数据的梯度;

使用分布式计算的 All-reduce 操作,在计算设备间高效交换梯度数据并进行求和,使得最终每个设备都有了所有设备的梯度之和;

使用梯度求和的结果更新本地变量(镜像变量);

当所有设备均更新本地变量后,进行下一轮训练(即该并行策略是同步的)。

默认情况下,TensorFlow 中的 MirroredStrategy 策略使用 NVIDIA NCCL 进行 All-reduce 操作。

多机训练:MultiWorkerMirroredStrategy

多机训练的方法和单机多卡类似,将 MirroredStrategy 更换为适合多机训练的 MultiWorkerMirroredStrategy 即可。不过,由于涉及到多台计算机之间的通讯,还需要进行一些额外的设置。具体而言,需要设置环境变量 TF_CONFIG ,示例如下:

os.environ['TF_CONFIG'] = json.dumps({

'cluster': {

'worker': ["localhost:20000", "localhost:20001"]

},

'task': {'type': 'worker', 'index': 0}

})

TF_CONFIG 由

cluster 和

task 两部分组成:

-

cluster说明了整个多机集群的结构和每台机器的网络地址(IP + 端口号)。对于每一台机器,cluster的值都是相同的; task说明了当前机器的角色。例如,{'type': 'worker', 'index': 0}说明当前机器是cluster中的第 0 个 worker(即localhost:20000)。每一台机器的task值都需要针对当前主机进行分别的设置。

以上内容设置完成后,在所有的机器上逐个运行训练代码即可。先运行的代码在尚未与其他主机连接时会进入监听状态,待整个集群的连接建立完毕后,所有的机器即会同时开始训练。

提示

请在各台机器上均注意防火墙的设置,尤其是需要开放与其他主机通信的端口。如上例的 0 号 worker 需要开放 20000 端口,1 号 worker 需要开放 20001 端口。

task 部分,第一台机器设置为

{'type': 'worker', 'index': 0},第二台机器设置为

{'type': 'worker', 'index': 1} 。接下来,在两台机器上依次运行程序,待通讯成功后,即会自动开始训练流程。

import tensorflow as tf

import tensorflow_datasets as tfds

import os

import json

num_epochs = 5

batch_size_per_replica = 64

learning_rate = 0.001

num_workers = 2

os.environ['TF_CONFIG'] = json.dumps({

'cluster': {

'worker': ["localhost:20000", "localhost:20001"]

},

'task': {'type': 'worker', 'index': 0}

})

strategy = tf.distribute.experimental.MultiWorkerMirroredStrategy()

batch_size = batch_size_per_replica * num_workers

def resize(image, label):

image = tf.image.resize(image, [224, 224]) / 255.0

return image, label

dataset = tfds.load("cats_vs_dogs", split=tfds.Split.TRAIN, as_supervised=True)

dataset = dataset.map(resize).shuffle(1024).batch(batch_size)

with strategy.scope():

model = tf.keras.applications.MobileNetV2()

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=learning_rate),

loss=tf.keras.losses.sparse_categorical_crossentropy,

metrics=[tf.keras.metrics.sparse_categorical_accuracy]

)

model.fit(dataset, epochs=num_epochs)

后文介绍

https://tf.wiki/en/appendix/cloud.html#gcp

福利 | 问答环节

我们知道在入门一项新的技术时有许多挑战与困难需要克服。如果您有关于 TensorFlow 的相关问题,可在本文后留言,我们的工程师和 GDE 将挑选其中具有代表性的问题在下一期进行回答,本期代表性问题回答如下:

A:现在可以使用 SavedModel,keras 模型或者 concrete functions。具体细节请参考:

https://tensorflow.google.cn/lite/convert/python_api

A:可以。Hexagon Delegate 不依赖 NNAPI,高通芯片支持列表请参考:

https://tensorflow.google.cn/lite/performance/hexagon_delegate#faq

《简单粗暴 TensorFlow 2.0 》目录

TensorFlow 2.0 分布式训练(本文)

有趣的人都在看