【Google】大迁移:通用视觉表示学习,General Visual Representation Learning

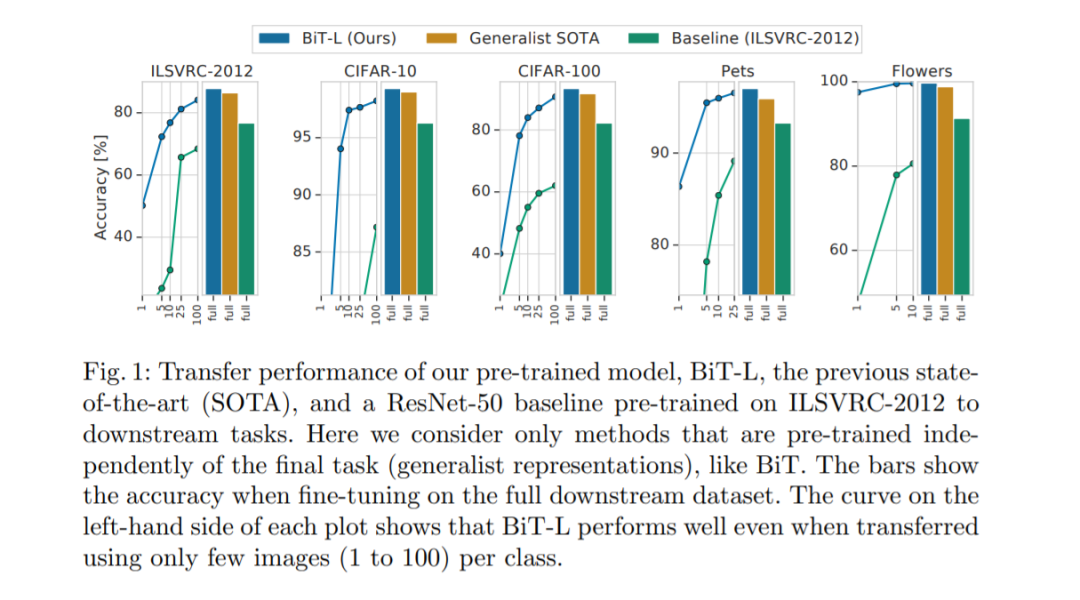

在为视觉训练深度神经网络时,预训练表示的迁移提高了样本效率并简化了超参数调整。我们回顾了在大型监督数据集上进行预训练和在目标任务上对模型进行微调的范例。我们扩大了预训练的规模,并提出了一个简单的方法,我们称之为大迁移(BiT)。通过组合一些精心选择的组件,并使用一个简单的启发式传输,我们在20多个数据集上实现了强大的性能。BiT在非常广泛的数据范围内执行得非常好——从每个类1个示例到总共100万个示例。BiT在ILSVRC-2012上达到87.5%的top-1准确率,在CIFAR-10上达到99.4%,在19个任务的视觉任务适应基准(VTAB)上达到76.3%。在小型数据集上,在ILSVRC-2012上BiT达到了76.8%,每个类有10个例子,在CIFAR-10上达到了97.0%,每个类有10个例子。我们对导致高迁移性能的主要部件进行了详细的分析。

https://arxiv.org/abs/1912.11370

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BIT” 可以获取《大迁移:通用视觉表示学习,General Visual Representation Learning》专知下载链接索引

登录查看更多

相关内容

专知会员服务

27+阅读 · 2020年4月5日

专知会员服务

12+阅读 · 2020年1月7日

Arxiv

7+阅读 · 2018年1月28日