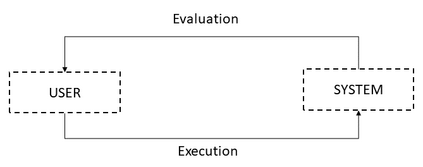

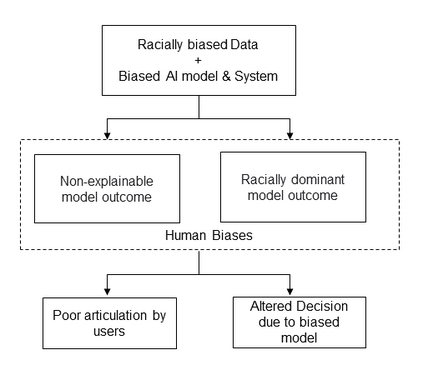

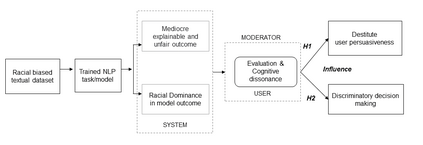

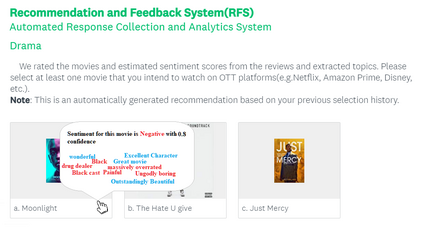

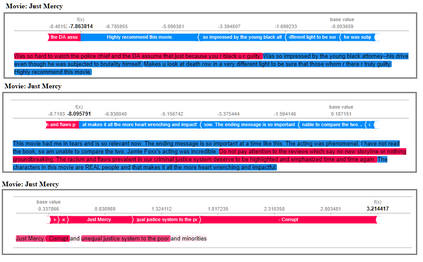

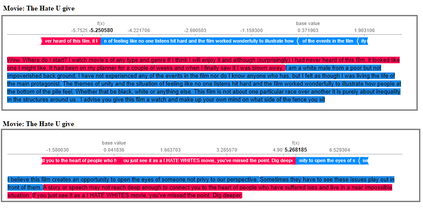

Language data and models demonstrate various types of bias, be it ethnic, religious, gender, or socioeconomic. AI/NLP models, when trained on the racially biased dataset, AI/NLP models instigate poor model explainability, influence user experience during decision making and thus further magnifies societal biases, raising profound ethical implications for society. The motivation of the study is to investigate how AI systems imbibe bias from data and produce unexplainable discriminatory outcomes and influence an individual's articulateness of system outcome due to the presence of racial bias features in datasets. The design of the experiment involves studying the counterfactual impact of racial bias features present in language datasets and its associated effect on the model outcome. A mixed research methodology is adopted to investigate the cross implication of biased model outcome on user experience, effect on decision-making through controlled lab experimentation. The findings provide foundation support for correlating the implication of carry-over an artificial intelligence model solving NLP task due to biased concept presented in the dataset. Further, the research outcomes justify the negative influence on users' persuasiveness that leads to alter the decision-making quotient of an individual when trying to rely on the model outcome to act. The paper bridges the gap across the harm caused in establishing poor customer trustworthiness due to an inequitable system design and provides strong support for researchers, policymakers, and data scientists to build responsible AI frameworks within organizations.

翻译:语言数据和模型显示了各种类型的偏见,无论是种族、宗教、性别还是社会经济的偏见。AI/NLP模型,如果在种族偏见数据集方面受过培训,AI/NLP模型就会导致模型解释不善,影响用户在决策过程中的经验,从而进一步扩大社会偏见,从而产生深刻的社会道德影响。研究的动机是调查AI系统如何从数据中产生偏见,产生无法解释的歧视结果,并影响个人对系统结果的清晰度,因为数据集中存在种族偏见特征。实验的设计涉及研究语言数据集中存在的种族偏见特征的反现实影响及其对模型结果的相关影响。采用了一种混合的研究方法,以调查偏见模型结果对用户经验的交叉影响,从而通过受控制的实验室实验实验对决策产生影响。研究结果为将人工智能模型用于解决NLP任务的含义联系起来提供了基础支持,因为数据集中存在偏差概念。此外,研究结果证明用户的说服力对用户的负面影响导致改变个人在语言数据集中对模型及相关对模型结果的影响。在试图建立稳健的客户设计框架时,为建立稳健的判断力的决策者行为提供了基础。